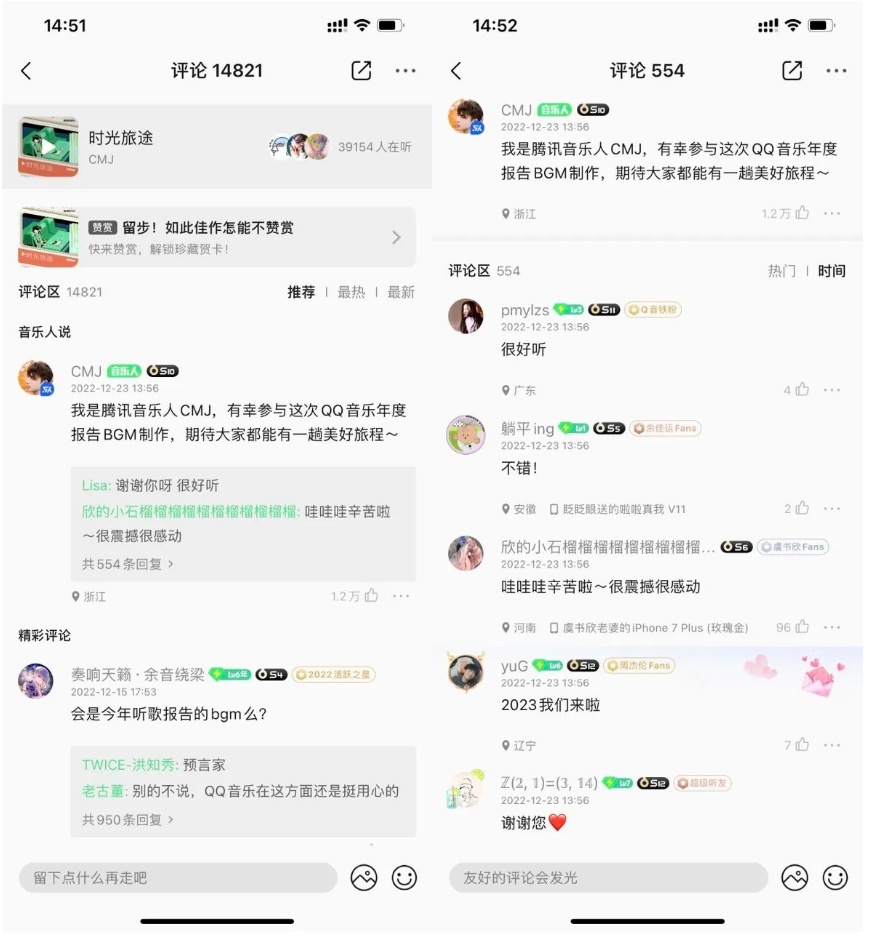

空降流量危機?QQ音樂升級架構應對高并發(fā)

# 關注并星標騰訊云開發(fā)者

# 每周3 | 談談我在騰訊的架構設計經驗

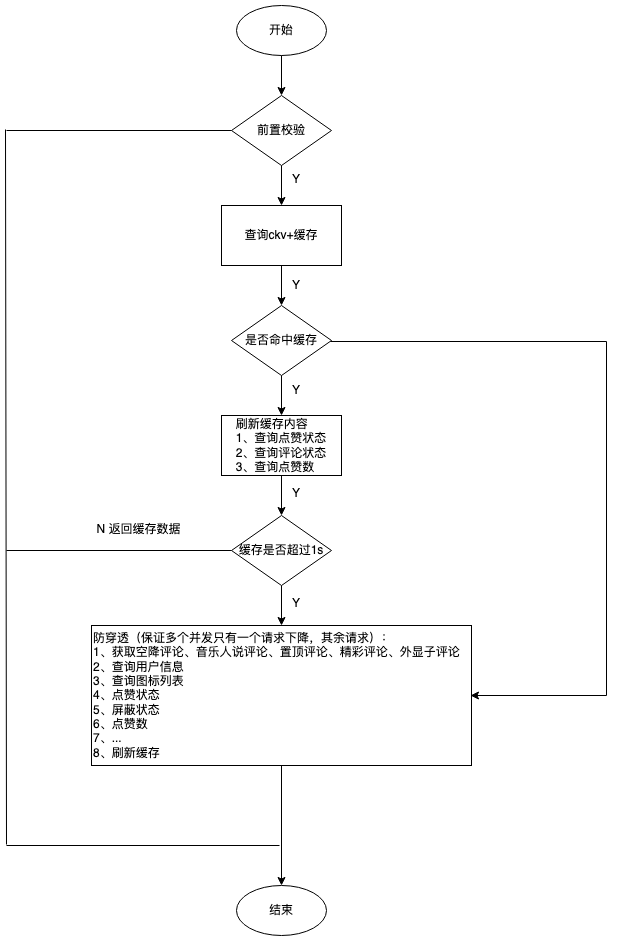

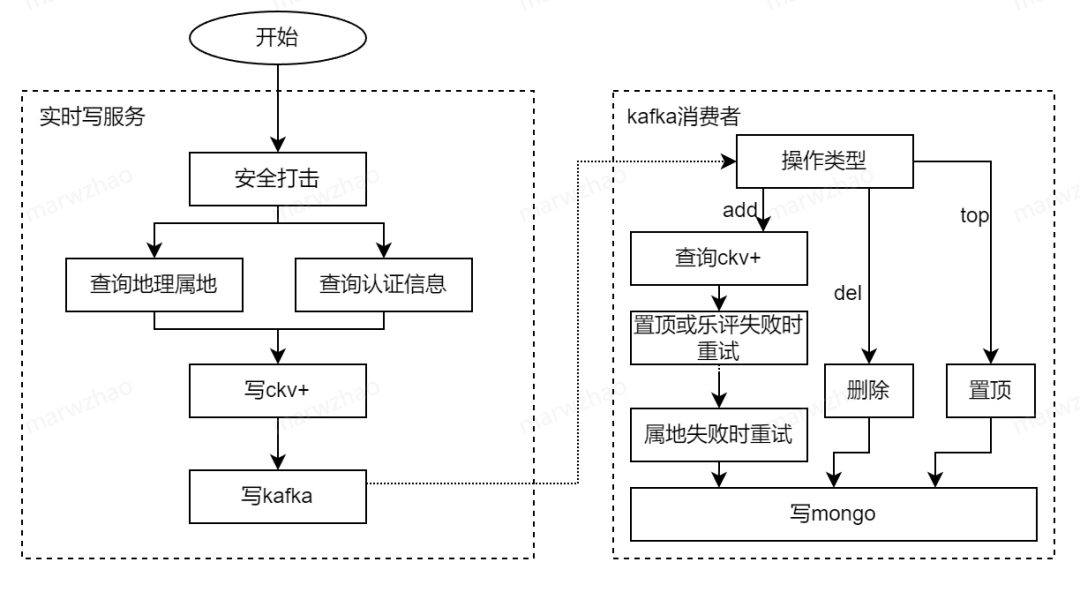

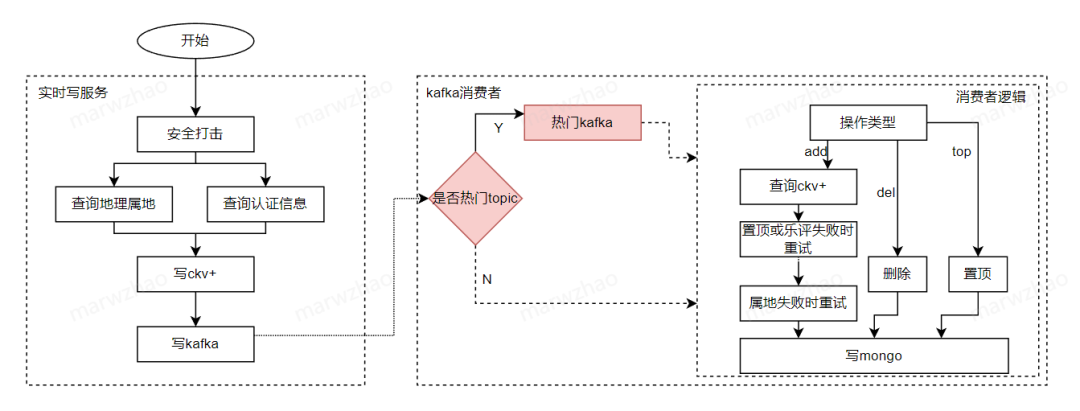

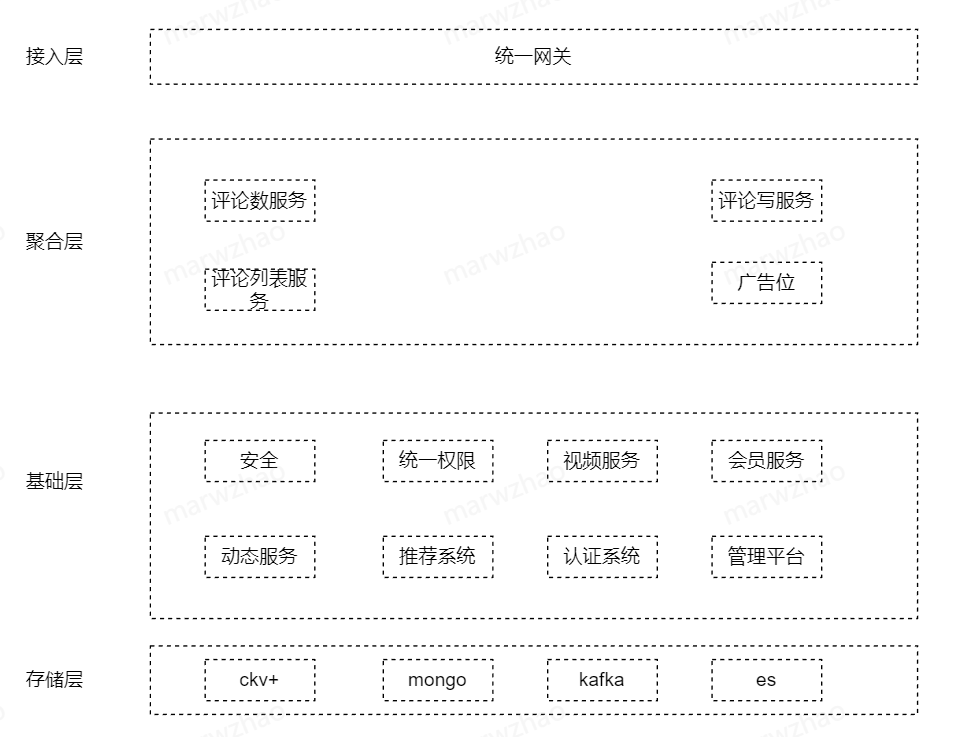

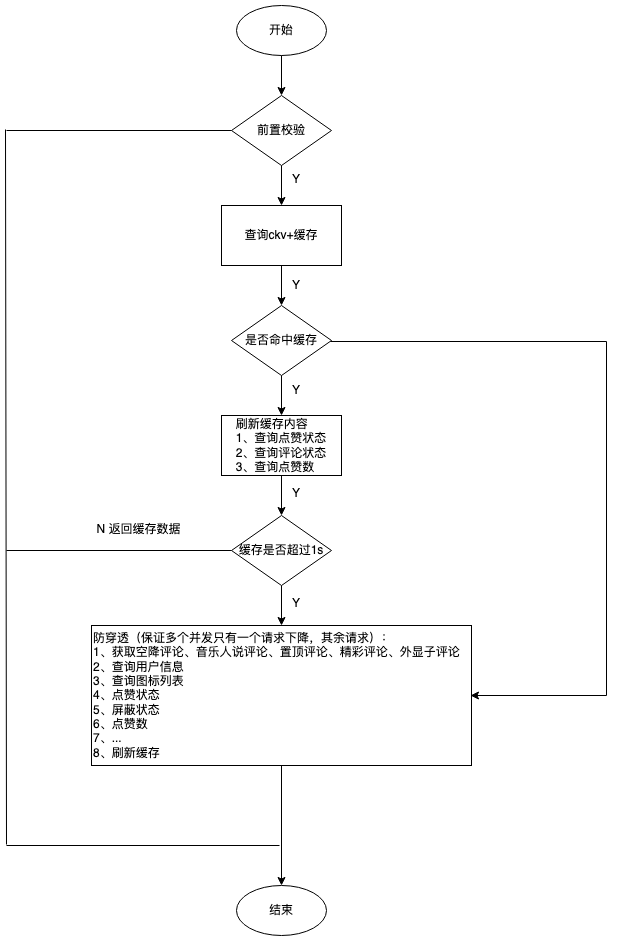

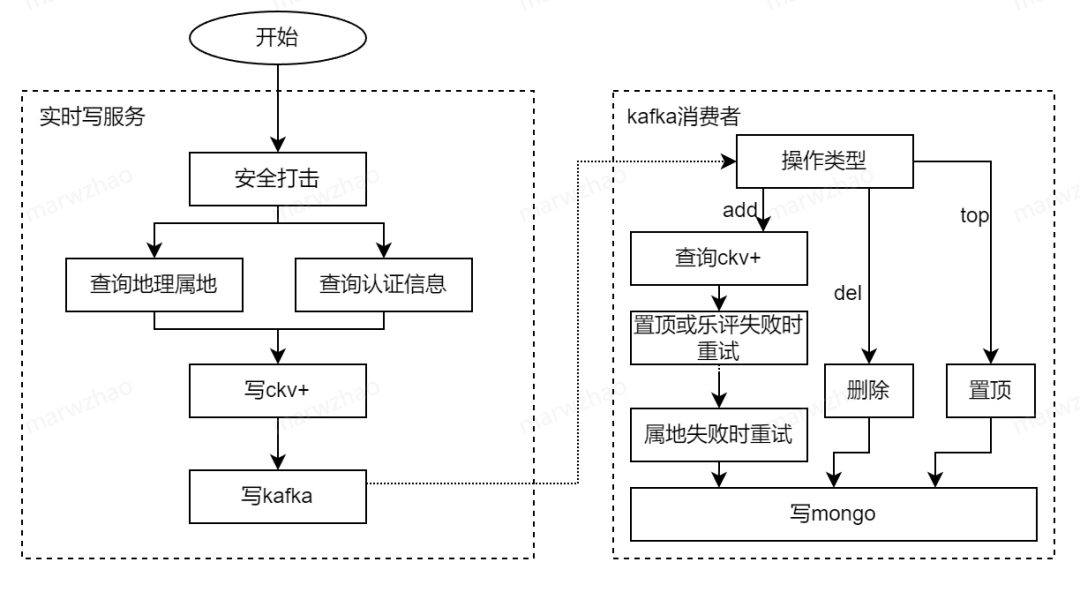

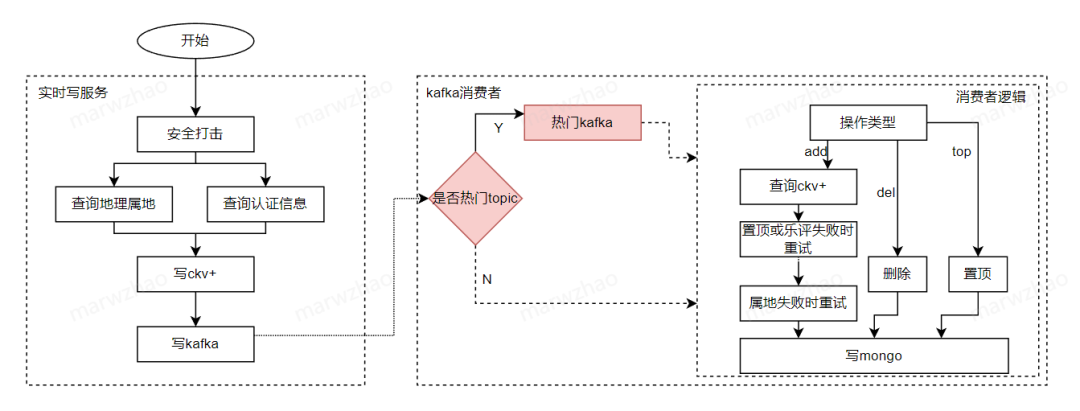

# 第2期 | 趙威:QQ音樂評論系統(tǒng)如何實現(xiàn)高可用?

第一時間看鵝廠架構設計經驗

評論

圖片

表情

<b id="afajh"><abbr id="afajh"></abbr></b>

下載APP

下載APP

# 關注并星標騰訊云開發(fā)者

# 每周3 | 談談我在騰訊的架構設計經驗

# 第2期 | 趙威:QQ音樂評論系統(tǒng)如何實現(xiàn)高可用?

第一時間看鵝廠架構設計經驗

<b id="afajh"><abbr id="afajh"></abbr></b>