利用OpenCV 基于Inception模型圖像分類

點擊上方“小白學視覺”,選擇加"星標"或“置頂”

重磅干貨,第一時間送達

本文轉自:opencv學堂

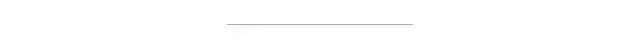

要介紹Inception網絡結構首先應該介紹一下NIN(Network in Network)網絡模型,2014年新加坡國立大學發(fā)表了一篇關于計算機視覺圖像分類的論文,提到采用了一種新的網絡結構NIN實現圖像分類,該論文的第二作者顏水成畢業(yè)于北京大學數學系,現任360人工智能研究院院長與首席科學家。NIN主要思想是認為CNN網絡中卷積濾波是基于線性濾波器實現的,抽象能力不夠,所以一般是用一大堆filter把所有特征都找出來,但是這樣就導致網絡參數過大,論文作者提出通過MLP(多個權重階層組成+一個非線性激活函數)對輸入區(qū)域通過MLP產生一個輸出feature map,然后繼續(xù)滑動MLP窗口,對比如下:

這樣做有兩個好處,

MLP可以共享參數,減少參數總數

對每個局部感受野神經元實現更加復雜計算,提升能力

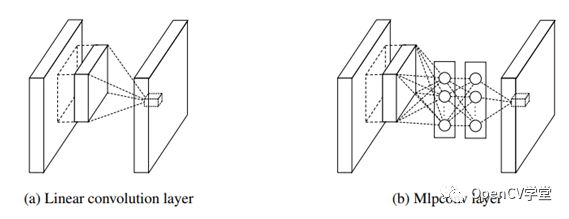

論文中提到NIN網絡完整結構如下:

包含了三個MLP卷積層與一個全局池化層。

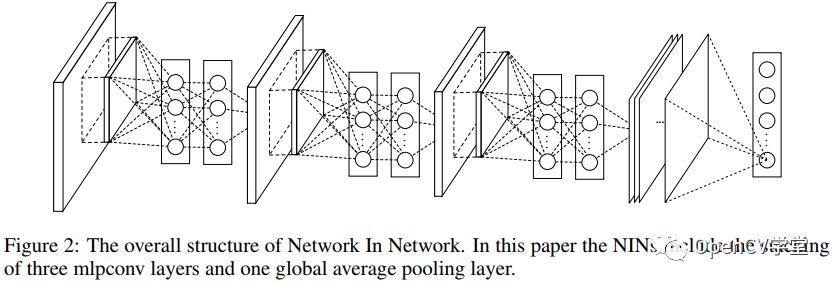

受到這篇文章的影響與啟發(fā),谷歌在2014也提出一個新的網絡模型結構Inception網絡也就是大家熟知v1網絡,其主要貢獻在于實現了NIN網絡層數的增加,并且在訓練各個網絡時候為了提高收斂,考慮中間層的輸出與最終分類錯誤。只是中間層不同,最初inception網絡的中間層為:

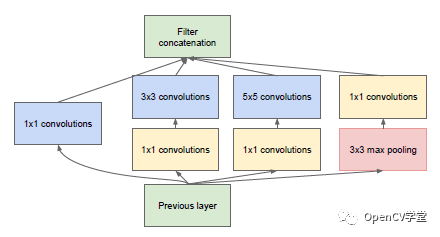

后來發(fā)現3x3與5x5的卷積計算耗時很長,而且輸出導致卷積厚度增加,如果層數過度將導致卷積網絡不可控制,于是就在3x3與5x5的卷積之前分別加上1x1的卷積做降維,修改后的結構如下:

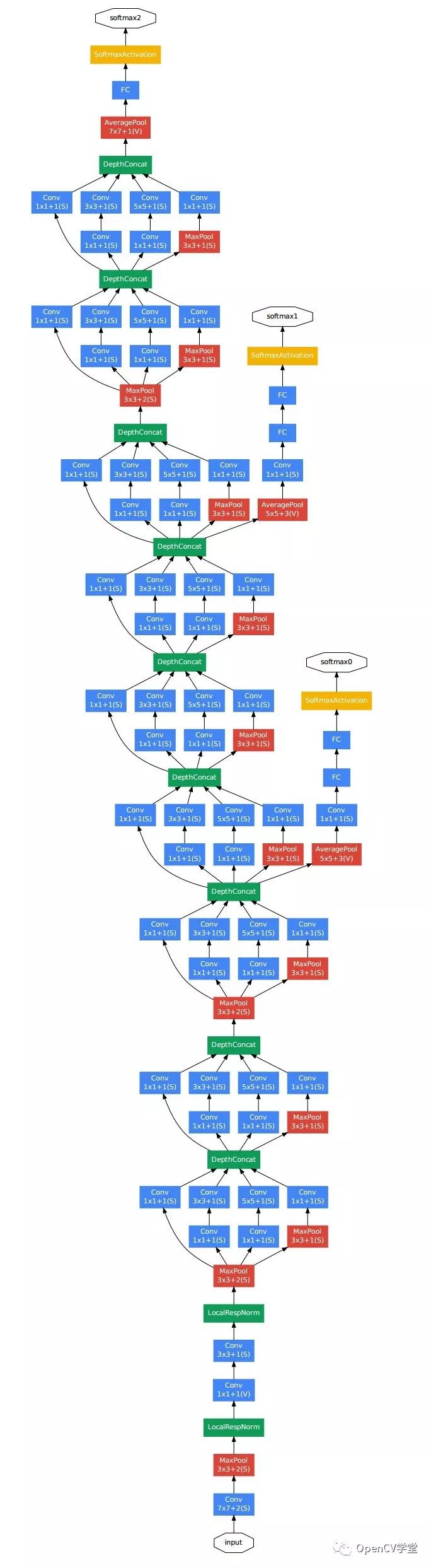

最終得到v1版本的網絡結構如下:

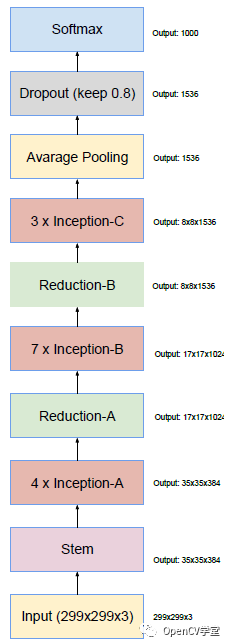

于是在v1的基礎上作者繼續(xù)工作,加入了BN層,對大于3x3的卷積用一系列小的卷積進行替代,比如7x7可以被1x7與7x1替代兩個小卷積核,5x5可以被1x5與5x1兩個小卷積核替代,這樣就得到Inception v2的版本。于是作者繼續(xù)對此網絡結構各種優(yōu)化調整,最終又得到了Inception v3版本

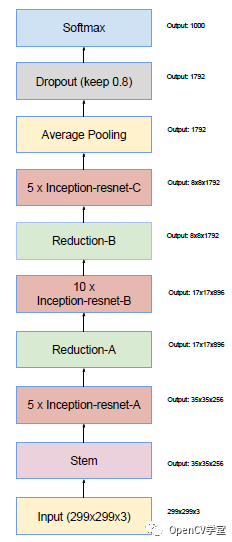

Inception v4一個最大的改動就是引入了殘差網絡結構,對原有的網絡結構進行優(yōu)化,得到v1與v2的殘差版本網絡結構,最終得到一個更加優(yōu)化的v4模型,完整的v4結構:

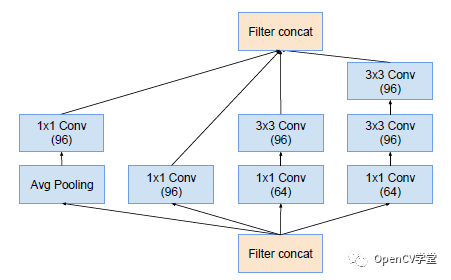

對應的Block A、B、C結構如下:Inception-A

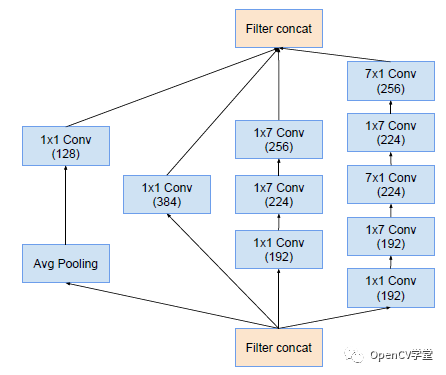

Inception-B

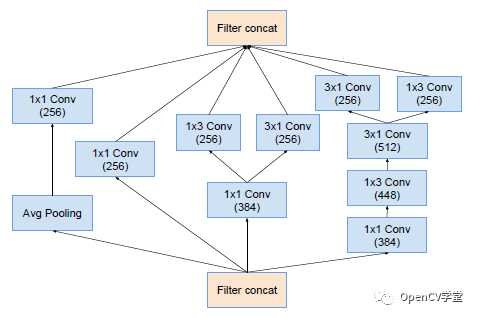

Inception-C

v1模型加殘差網絡結構

下載Inception預訓練網絡模型

使用OpenCV DNN模塊相關API加載模型

運行Inception網絡實現圖像分類 完整的代碼實現如下:

#include <opencv2/opencv.hpp>

#include <opencv2/dnn.hpp>

#include <iostream>

/******************************************************

*

* 作者:賈志剛

* QQ: 57558865

* OpenCV DNN 完整視頻教程:

* http://edu.51cto.com/course/11516.html

*

********************************************************/

using namespace cv;

using namespace cv::dnn;

using namespace std;

String labels_txt_file = "D:/android/opencv_tutorial/data/models/inception5h/imagenet_comp_graph_label_strings.txt";

String tf_pb_file = "D:/android/opencv_tutorial/data/models/inception5h/tensorflow_inception_graph.pb";

vector<String> readClassNames();

int main(int argc, char** argv) {

Mat src = imread("D:/vcprojects/images/twocat.png");

if (src.empty()) {

printf("could not load image...\n");

return -1;

}

namedWindow("input", CV_WINDOW_AUTOSIZE);

imshow("input", src);

vector<String> labels = readClassNames();

Mat rgb;

cvtColor(src, rgb, COLOR_BGR2RGB);

int w = 224;

int h = 224;

// 加載網絡

Net net = readNetFromTensorflow(tf_pb_file);

if (net.empty()) {

printf("read caffe model data failure...\n");

return -1;

}

Mat inputBlob = blobFromImage(src, 1.0f, Size(224, 224), Scalar(), true, false);

inputBlob -= 117.0; // 均值

// 執(zhí)行圖像分類

Mat prob;

net.setInput(inputBlob, "input");

prob = net.forward("softmax2");

// 得到最可能分類輸出

Mat probMat = prob.reshape(1, 1);

Point classNumber;

double classProb;

minMaxLoc(probMat, NULL, &classProb, NULL, &classNumber);

int classidx = classNumber.x;

printf("\n current image classification : %s, possible : %.2f", labels.at(classidx).c_str(), classProb);

// 顯示文本

putText(src, labels.at(classidx), Point(20, 20), FONT_HERSHEY_SIMPLEX, 1.0, Scalar(0, 0, 255), 2, 8);

imshow("Image Classification", src);

imwrite("D:/result.png", src);

waitKey(0);

return 0;

}

std::vector<String> readClassNames()

{

std::vector<String> classNames;

std::ifstream fp(labels_txt_file);

if (!fp.is_open())

{

printf("could not open file...\n");

exit(-1);

}

std::string name;

while (!fp.eof())

{

std::getline(fp, name);

if (name.length())

classNames.push_back(name);

}

fp.close();

return classNames;

}

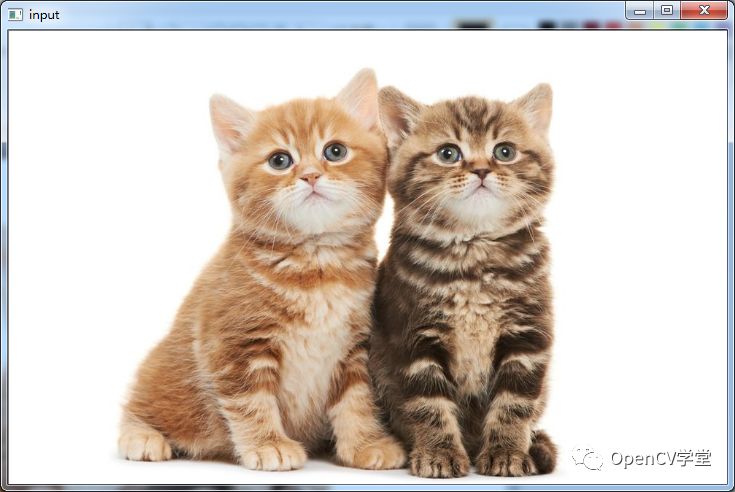

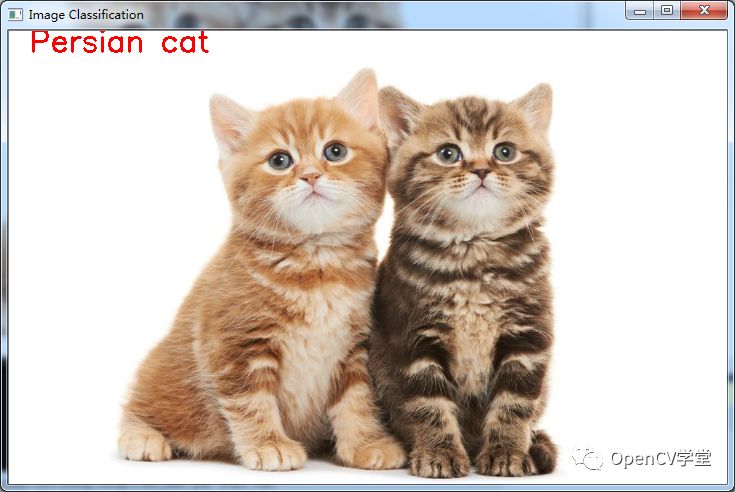

輸入原圖:

測試結果:

關鍵是速度很快,比VGG快N多,基本秒出結果!

交流群

歡迎加入公眾號讀者群一起和同行交流,目前有SLAM、三維視覺、傳感器、自動駕駛、計算攝影、檢測、分割、識別、醫(yī)學影像、GAN、算法競賽等微信群(以后會逐漸細分),請掃描下面微信號加群,備注:”昵稱+學校/公司+研究方向“,例如:”張三 + 上海交大 + 視覺SLAM“。請按照格式備注,否則不予通過。添加成功后會根據研究方向邀請進入相關微信群。請勿在群內發(fā)送廣告,否則會請出群,謝謝理解~