【行業(yè)資訊】破解人工智能系統(tǒng)的四種攻擊方法!

正文共:4940-9圖

預計閱讀時間:13分鐘

人工智能在日常生活中無處不在,戰(zhàn)爭也不例外。報道甚至表明,2020 年 11 月對伊朗頂級核科學家的暗殺是由一種自主的、人工智能增強的步槍執(zhí)行的,該步槍每分鐘可發(fā)射 600 發(fā)子彈。俄羅斯和中國正在迅速發(fā)展,并在某些情況下部署支持人工智能的非正規(guī)戰(zhàn)爭能力,而為我們的日常生活提供動力的人工智能系統(tǒng)開始出現(xiàn)同樣的裂痕、偏見和不良后果只是時間問題出現(xiàn)在用于發(fā)動戰(zhàn)爭并旨在殺戮的人工智能系統(tǒng)中。

對抗方法

訓練投毒

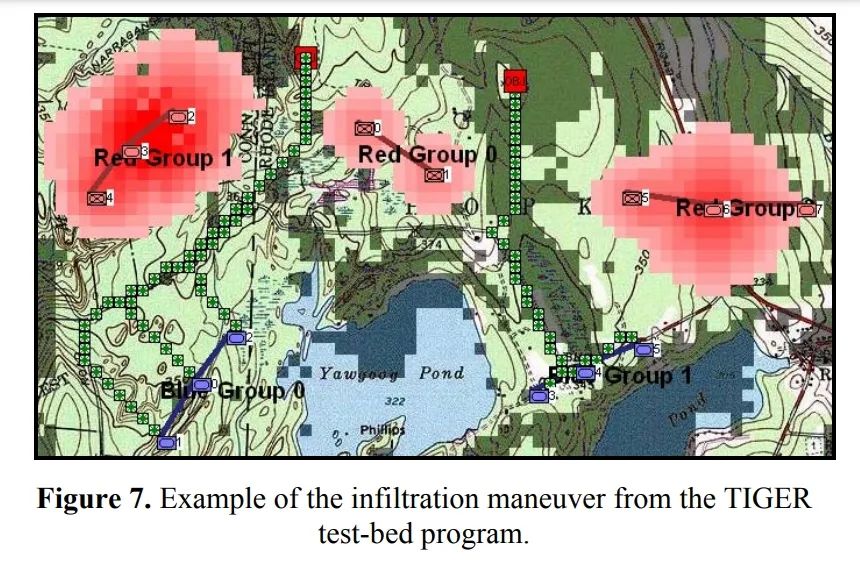

規(guī)避攻擊

逆向工程

推理攻擊

對大國競爭的啟示

數(shù)據(jù)不對稱

開發(fā)能力

人工智能只是一種工具

THE??END

來源?| 未來科技前沿

版權(quán)聲明:本號內(nèi)容部分來自互聯(lián)網(wǎng),轉(zhuǎn)載請注明原文鏈接和作者,如有侵權(quán)或出處有誤請和我們聯(lián)系。

評論

圖片

表情