CVPR 二十年,影響力最大的 10 篇論文!

極市導(dǎo)讀

超過半數(shù)的論文都于近十年發(fā)表,來看看是不是你心中的TOP10。 >>加入極市CV技術(shù)交流群,走在計算機視覺的最前沿

此前,極市盤點了圖像分割在過去二十年中影響力最大的10篇論文,得到了許多開發(fā)者的支持。今天,我們將對計算機視覺領(lǐng)域三大頂會之一CVPR在近二十年來中產(chǎn)生的優(yōu)秀論文進行一個全面的盤點與總結(jié)。

CVPR是計算機視覺領(lǐng)域三大頂會中唯一一個年度學(xué)術(shù)會議。在快速更新迭代的計算機學(xué)科中,CVPR成為了計算機視覺領(lǐng)域的“頂級流量”。而在過去的這些年間,CVPR也有著許多的變化。在十多年前,CVPR不過1500人的參會規(guī)模,到了2019年參會人數(shù)已經(jīng)超過了6500人,投稿數(shù)量也年年增長。

雖然CVPR每年都會評選出最佳論文,但我們今天將從另一個角度來評選CVPR這二十年來的TOP10。即以Web of Science上顯示的論文的引用量作為論文影響力的參考,排列出近二十年來影響力最大的十篇論文。接下來我們將依次進行介紹。

TOP10

Rethinking the Inception Architecture for Computer Vision

CVPR 2016

作者:Christian Szegedy,Vincent Vanhoucke,Sergey Ioffe,Jon Shlens,Zbigniew Wojna

機構(gòu):Google,倫敦大學(xué)

被引頻次:4751

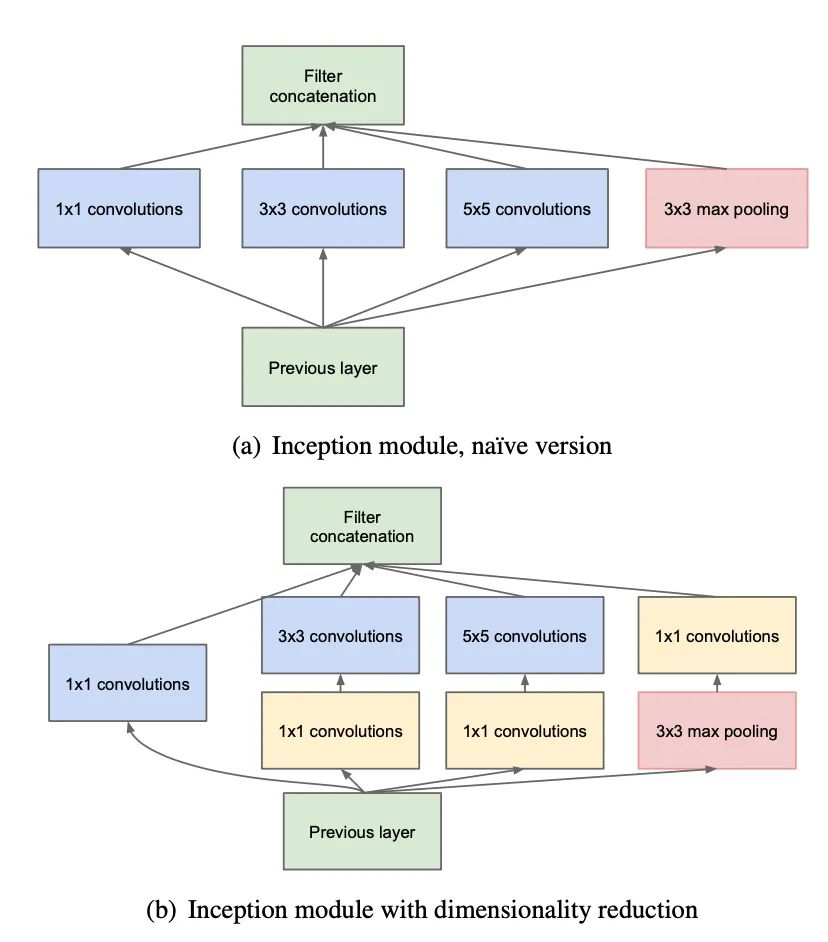

這篇論文又被稱為Inception-v3,是GoogLeNet(Inception-v1)的延伸。GoogLeNet首次出現(xiàn)于2014年ILSVRC 比賽,并在當(dāng)年的比賽中獲得了冠軍。Inception-v1的參數(shù)量遠小于同期VGGNet,而性能卻與之基本持平。相較于Inception-v1,Inception-v3做出的主要改進則是將卷積進行非對稱拆分,以顯著降低參數(shù)量,同時使得空間特征更為豐富。

TOP9

Densely Connected Convolutional Networks

CVPR 2017

作者:Gao Huang,Zhuang Liu,Laurens van der Maaten,Kilian Q. Weinberger

機構(gòu):康奈爾大學(xué),清華大學(xué),F(xiàn)acebook AI Research

被引頻次:5181

DenseNet也是CVPR2017的最佳論文之一。在當(dāng)時的神經(jīng)網(wǎng)絡(luò)模型都遇到一個問題:隨著網(wǎng)路層數(shù)的加深,訓(xùn)練過程中的前傳信號和梯度信號在經(jīng)過很多層之后可能會逐漸消失。而DenseNet的核心思想解決了這一問題。它對前每一層都加一個單獨的 shortcut,使得任意兩層網(wǎng)絡(luò)都可以直接“溝通”。

而DenseNet的不足之處在于它的內(nèi)存占用十分龐大。但瑕不掩瑜,DenseNet以其極具創(chuàng)新性的思路,不僅顯著減輕了深層網(wǎng)絡(luò)在訓(xùn)練過程中梯度消散而難以優(yōu)化的問題,同時也取得了非常好的性能。

TOP8

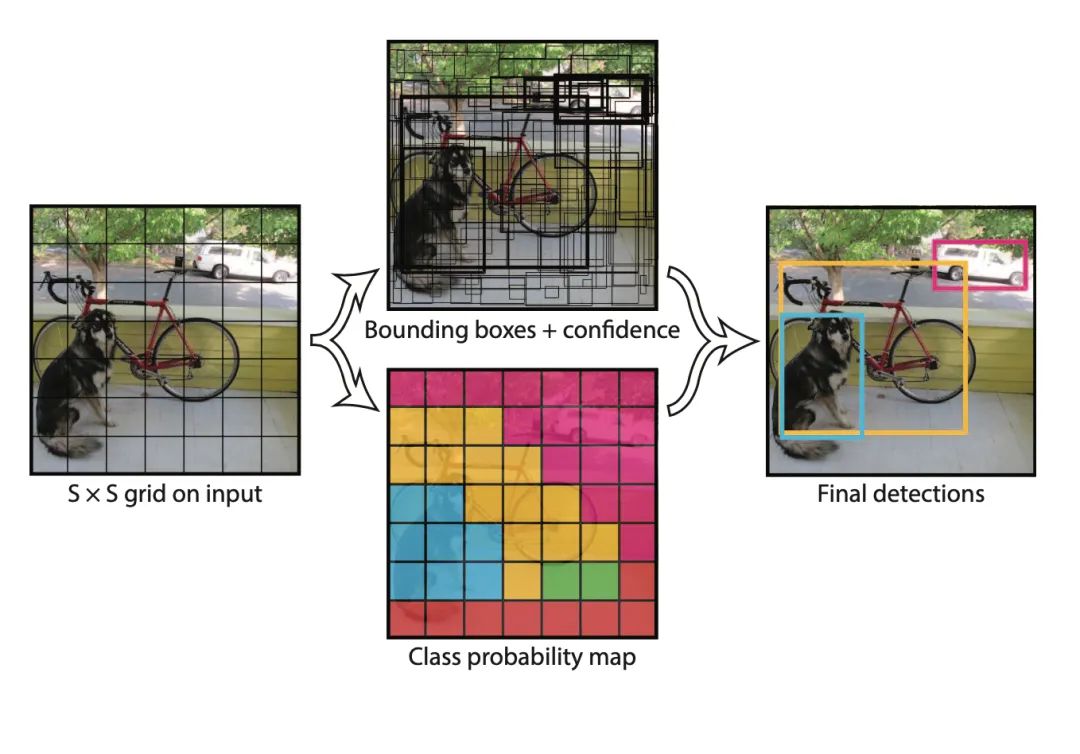

You Only Look Once: Unified, Real-Time Object Detection

CVPR 2016

作者:Joseph Redmon,Santosh Divvala,Ross Girshick,Ali Farhadiq

機構(gòu):華盛頓大學(xué),Allen Institute for AI,F(xiàn)acebook AI Research

被引頻次:5295

這一篇論文就是在目標(biāo)檢測領(lǐng)域大名鼎鼎的YOLO。其最新的版本已經(jīng)更新到了YOLOv5,且每一代的發(fā)布都能在行業(yè)內(nèi)卷齊新的熱潮。

用YOLO的英文直譯解釋這一方法,就是只需要瀏覽一次就能識別出圖中的物體的類別和位置。展開來說,YOLO的核心思想就是將目標(biāo)檢測轉(zhuǎn)化為回歸問題求解,并基于一個單獨的端到端網(wǎng)絡(luò),完成從原始圖像的輸入到物體位置和類別的輸出。這使得網(wǎng)絡(luò)結(jié)構(gòu)簡單,且極大提升了檢測速度。由于網(wǎng)絡(luò)沒有分支,所以訓(xùn)練也只需要一次即可完成。之后的很多檢測算法都借鑒了這一思路。

TOP7

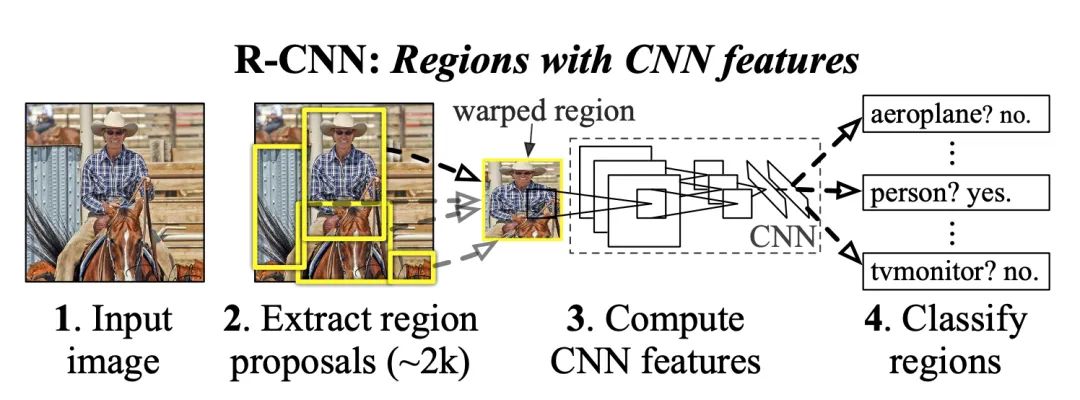

Rich feature hierarchies for accurate object detection and semantic segmentation

CVPR 2014

作者:Ross Girshick,Jeff Donahue,Trevor Darrell,Jitendra Malik

機構(gòu):加利福尼亞大學(xué)伯克利分校

被引頻次:6876

這篇文章的排名在YOLO之前,既合理又巧妙。因為在YOLO之前,目標(biāo)檢測領(lǐng)域可以說是RCNN的世界。RCNN是將CNN引入目標(biāo)檢測的開山之作,它改變了目標(biāo)檢測領(lǐng)域的主要研究思路。緊隨其后的系列文章,如Fast RCNN和Faster RCNN等,都代表了該領(lǐng)域當(dāng)時的最高水準(zhǔn)。

在RCNN前經(jīng)典的目標(biāo)檢測算法是使用滑動窗法依次判斷所有可能的區(qū)域,而RCNN則采用Selective Search方法預(yù)先提取一系列較可能是物體的候選區(qū)域,之后僅在這些候選區(qū)域上提取特征,這使得檢測的速度大大提升。

TOP6

Rapid object detection using a boosted cascade of simple features

CVPR 2001

作者:Paul Viola,Michael Jones

機構(gòu):三菱電氣實驗室 ,康柏劍橋研究實驗室

被引頻次:7033

這篇論文是本次盤點中最先發(fā)表的一篇,比其他九篇文章都早了十年左右,它在傳統(tǒng)人臉檢測中具有里程碑意義,因而本文提出的思想聚焦于傳統(tǒng)的目標(biāo)檢測。

這篇論文主要解決了三個問題:一是減少了計算特征的時間,二是構(gòu)建了簡單又很有效的單分支決策樹分類器,最后是從簡單到復(fù)雜把多個分類器級聯(lián),對可能包含人臉的區(qū)域進行重點檢測,從而顯著提升了檢測速度。

TOP5

Going Deeper with Convolutions

CVPR 2015

作者:Christian Szegedy,Dragomir Anguelov, Dumitru Erhan,Vincent Vanhoucke,Yangqing Jia,Pierre Sermanet,Wei Liu,Scott Reed,Andrew Rabinovich

機構(gòu):Google,北卡羅來納大學(xué),密歇根大學(xué)

發(fā)布時間:2015年

被引頻次:7269

可能大家已經(jīng)發(fā)現(xiàn)了亮點,這篇論文的系列工作在前面就出現(xiàn)過。這篇論文就是開辟Inception家族,并在CNN分類器發(fā)展史上留下濃墨重彩的一筆的GoogLeNet。

在 Inception 出現(xiàn)之前,大部分流行 CNN 是將卷積層不斷堆疊,讓網(wǎng)絡(luò)越來越深來得到更好的性能。而GoogLeNet 最大的特點就是使用 Inception 模塊,并設(shè)計一種具有優(yōu)良局部拓撲結(jié)構(gòu)的網(wǎng)絡(luò),對輸入圖像并行地執(zhí)行多個卷積運算或池化操作,將所有輸出結(jié)果拼接為一個非常深的特征圖。通過這種方式,GoogLeNet取得了非常驚艷的效果。

TOP4

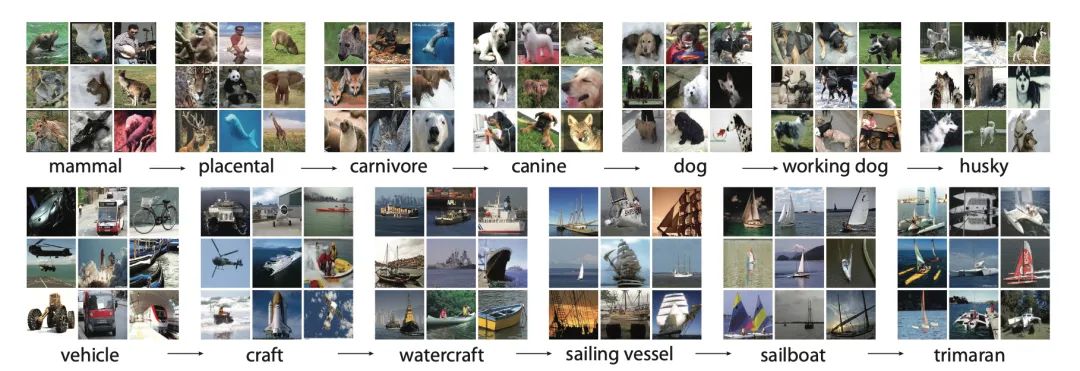

ImageNet: A Large-Scale Hierarchical Image Database

CVPR 2009

作者:Jia Deng,Wei Dong,Richard Socher,Li-Jia Li,Kai Li,Li Fei-Fei

機構(gòu):普林斯頓大學(xué)

發(fā)布時間:2009年

被引頻次:8222

ImageNet是AI女神李飛飛團隊構(gòu)建的計算機視覺領(lǐng)域非常著名的海量的帶標(biāo)注圖像數(shù)據(jù)集。它在圖像分類、目標(biāo)分割和目標(biāo)檢測中都有著無法撼動的地位。ImageNet從 2007 年開始到 2009 年完成,有超過 1500 萬張圖片。

可以毫不夸張的說,ImageNet 是圖像處理算法的試金石。另外,從 2010 年起,每年 ImageNet 官方會舉辦挑戰(zhàn)賽。Hinton團隊提出的AlexNet也是在2012年的ImageNet挑戰(zhàn)賽上一舉成名,自此深度學(xué)習(xí)的熱潮被點燃。

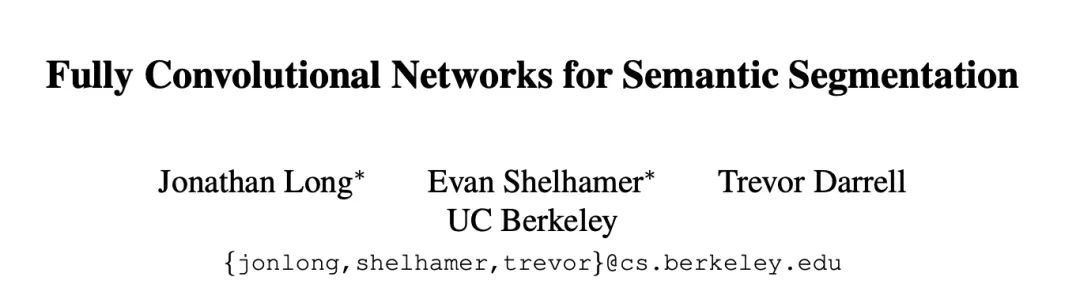

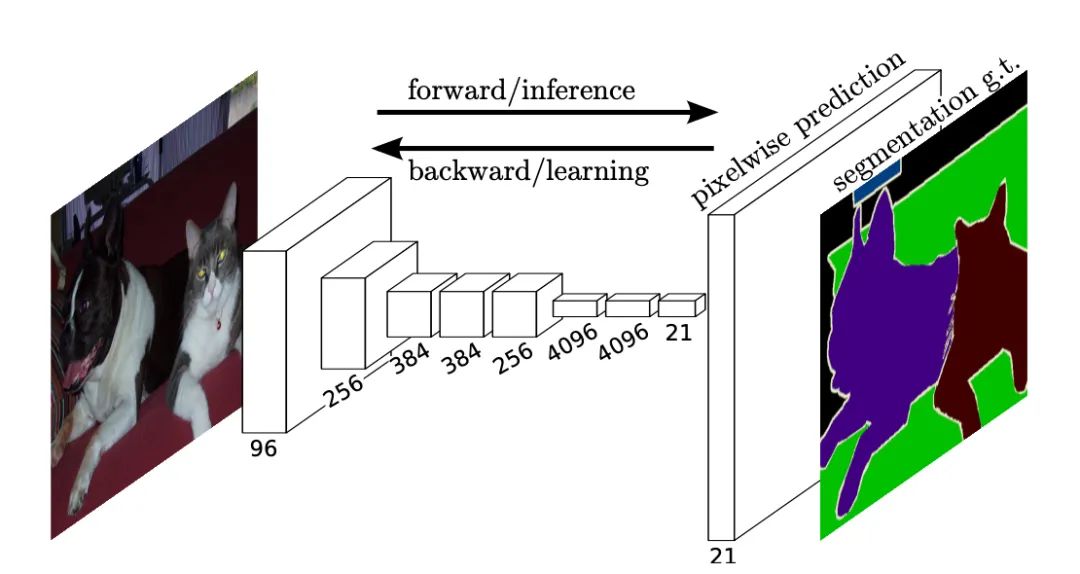

TOP3

Fully Convolutional Networks for Semantic Segmentation

CVPR 2015

作者:Jonathan Long,Evan Shelhamer,Trevor Darrell

發(fā)布時間:2015年

被引頻次:9027

FCN在我們之前盤點的圖像分割TOP10中就出現(xiàn)過,并高居第一位。作為語義分割的開山之作,無論是圖像分割TOP1,還是CVPRTOP3,F(xiàn)CN都是當(dāng)之無愧的。FCN所提出的全卷積網(wǎng)絡(luò)的概念,開創(chuàng)了用FCN做實例和像素級別理解系列方法的先河。后續(xù)非常多的方法都受到了FCN的思路啟發(fā)。FCN的提出為目標(biāo)識別、檢測與分割也都做出了巨大的貢獻。

TOP2

Histograms of oriented gradients for human detection

CVPR 2005

作者:Navneet Dalal,Bill Triggs

被引頻次:13389

這篇論文所提出的方法簡稱HOG,是一種是非常經(jīng)典的圖像特征提取方法,在行人識別領(lǐng)域被應(yīng)用得尤為多。雖然文章已經(jīng)發(fā)表了十五年,但仍然常常被人們用于最新工作的思路參考。HOG將圖像分成小的連通區(qū)域,將它稱為細胞單元,然后采集細胞單元中各像素點的梯度的或邊緣的方向直方圖,把這些直方圖組合起來就可以構(gòu)成特征描述器。

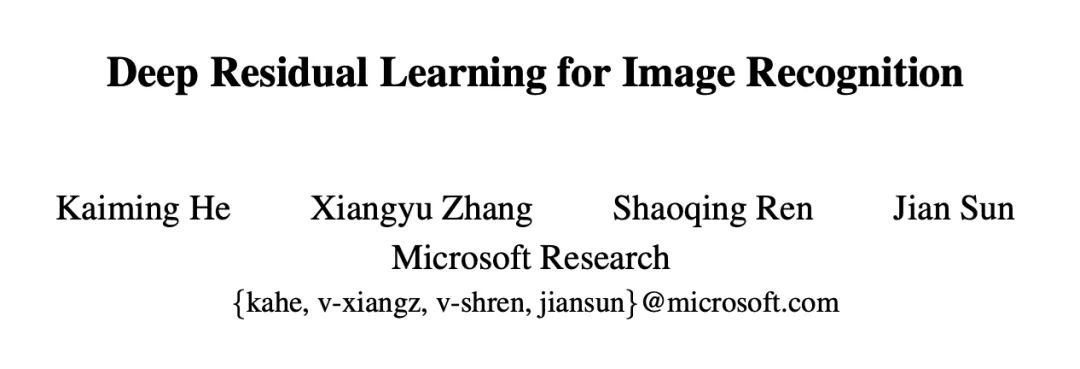

TOP1

Deep Residual Learning for Image Recognition

CVPR2016

作者:Kaiming He,Xiangyu Zhang,Shaoqing Ren,Jian Sun

被引頻次:32065

這篇論文作為第一名,的確是當(dāng)之無愧。作為CVPR2016的最佳論文,它所提出的ResNet不僅在計算機視覺領(lǐng)域,而是在深度學(xué)習(xí)領(lǐng)域中都帶來了顛覆式影響。

在當(dāng)年,ResNet橫掃 ImageNet 2015和COCO 榜單。也是從ResNet開始,神經(jīng)網(wǎng)絡(luò)在視覺分類任務(wù)上的性能第一次超越了人類。它也讓當(dāng)時第二次獲得CVPR Best Paper的何愷明正式踏上了大神之路。

最初 ResNet 的設(shè)計是用來處理深層 CNN 結(jié)構(gòu)中梯度消失和梯度爆炸的問題,它將輸入從卷積層的每個塊添加到輸出,讓每一層更容易學(xué)習(xí)恒等映射,并且還減少了梯度消失的問題。而如今,殘差模塊已經(jīng)成為幾乎所有 CNN 結(jié)構(gòu)中的基本構(gòu)造。

最后,我們來進行一下簡要地總結(jié)。雖然本次盤點的是20年內(nèi)CVPRTOP10,但是有超過半數(shù)的論文都是在近十年發(fā)表的,由此可以窺見深度學(xué)習(xí)在近年來的飛躍式發(fā)展。因此我們可以期待在未來的計算機視覺領(lǐng)域,一定會有更多更強的工作,為我們的科研與生活帶來更快更好的提升。

參考資料

[1] https://zhuanlan.zhihu.com/p/41691301

[2] https://www.zhihu.com/question/60109389/answer/203099761

[3] https://zhuanlan.zhihu.com/p/31427164

[4] https://zhuanlan.zhihu.com/p/23006190

[5] https://blog.csdn.net/weixin_37763809/article/details/88256828

[6] https://zhuanlan.zhihu.com/p/37505777

[7] https://zhuanlan.zhihu.com/p/77221549

[8] https://www.zhihu.com/question/433702668/answer/1617092684

[9] https://blog.csdn.net/zouxy09/article/details/7929348

[10] https://www.jiqizhixin.com/articles/2020-01-01

如果覺得有用,就請分享到朋友圈吧!

公眾號后臺回復(fù)“79”獲取CVPR 2021:TransT 直播鏈接~

# 極市原創(chuàng)作者激勵計劃 #