ICCV2021 注意力卷積新思路CRAN-上下文推理注意力圖像超分辨率網(wǎng)絡(luò)

論文:Context Reasoning Attention Network for Image Super-Resolution

鏈接:https://openaccess.thecvf.com/content/ICCV2021/papers/Zhang_Context_Reasoning_Attention_Network_for_Image_Super-Resolution_ICCV_2021_paper.pdf

1Abstract

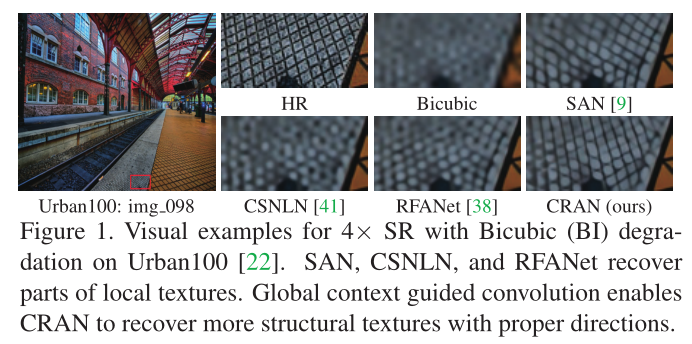

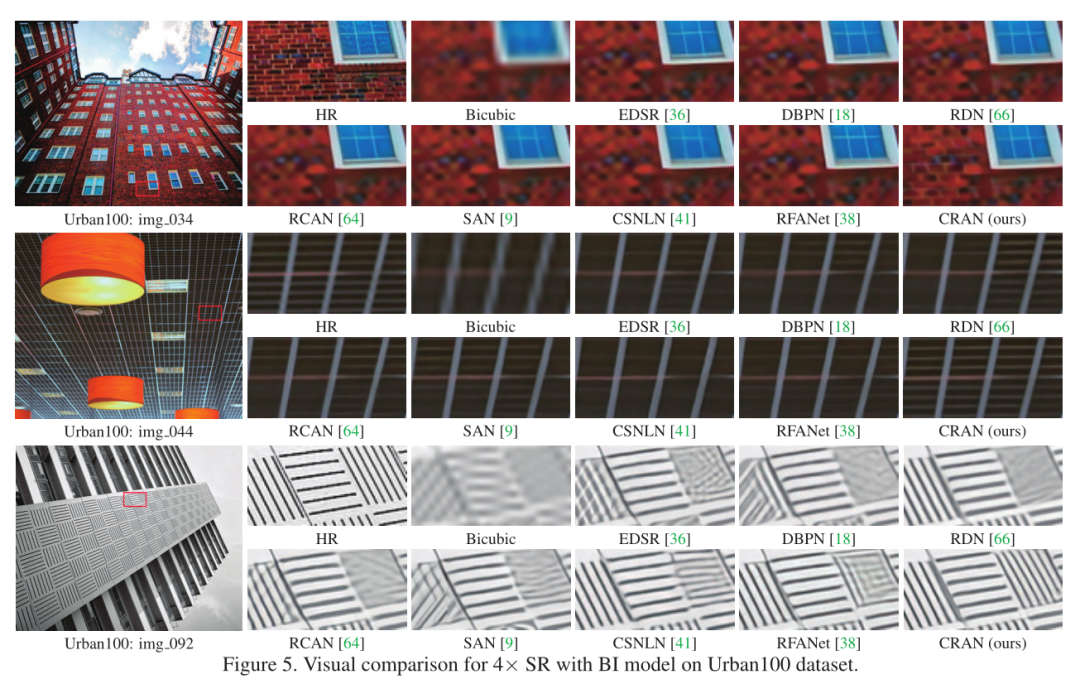

如圖1中SAN[9]和RFANet[38]所示,由于CNN中的基本卷積層大多用于提取局部特征,從而缺乏對全局上下文建模的能力,因此導致恢復(fù)出來的紋理細節(jié)都不正確。然而,利用全局上下文信息的CSNLN[41]方法都是通過將全局上下文合并到局部特征表示中進行全局特征交互而忽略了挖掘上下文信息之間的關(guān)系。 有神經(jīng)科學表明神經(jīng)元是根據(jù)上下文動態(tài)調(diào)節(jié)的,這一理論被大多數(shù)基于CNN的SR方法所忽略。作者基于這些觀察和分析,提出了上下文推理注意網(wǎng)絡(luò)(CRAN)來根據(jù)全局上下文自適應(yīng)調(diào)整卷積核。具體來說,作者是提取了全局上下文描述符,并通過語義推理進一步增強了這些描述符。然后引入通道和空間交互來生成上下文推理注意掩碼,并應(yīng)用上下文推理注意掩碼自適應(yīng)地修改卷積核。在這項工作中,作者的主要貢獻有:

有神經(jīng)科學表明神經(jīng)元是根據(jù)上下文動態(tài)調(diào)節(jié)的,這一理論被大多數(shù)基于CNN的SR方法所忽略。作者基于這些觀察和分析,提出了上下文推理注意網(wǎng)絡(luò)(CRAN)來根據(jù)全局上下文自適應(yīng)調(diào)整卷積核。具體來說,作者是提取了全局上下文描述符,并通過語義推理進一步增強了這些描述符。然后引入通道和空間交互來生成上下文推理注意掩碼,并應(yīng)用上下文推理注意掩碼自適應(yīng)地修改卷積核。在這項工作中,作者的主要貢獻有:

作者提出了一種用于精確圖像SR的上下文推理注意網(wǎng)絡(luò)。我們的CRAN可以根據(jù)語義推理增強的全局上下文自適應(yīng)地調(diào)整卷積核。 作者提出將上下文信息提取到潛在表示中,從而生成包含全局上下文描述符。作者進一步通過使用描述符與語義推理的關(guān)系來增強了描述符。 作者引入通道和空間交互來生成用于修改卷積核的上下文推理注意掩碼。最后,我們得到了上下文推理注意卷積,這進一步作為構(gòu)建圖像SR塊和網(wǎng)絡(luò)的基礎(chǔ)。

2Method

上下文推理注意力卷積

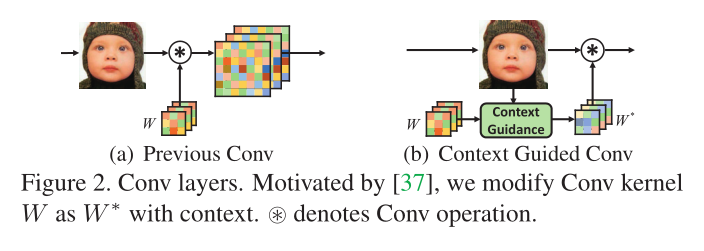

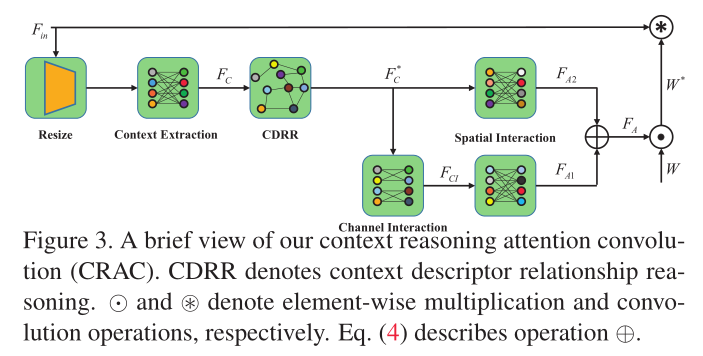

作者在設(shè)計自適應(yīng)修改濾波器的卷積借鑒了Context Guided Conv[37],在中間添加了對應(yīng)上下文的注意力關(guān)系以及對應(yīng)的通道交互和空間交互操作,具體如下圖:

上下文信息提取

為了提取上下文信息,作者首先通過使用池層將輸入特征的空間大小減小到,然后通過一個共享的線性層,其權(quán)重為將每個通道投影到大小為e的潛在向量。

按照之前Context Guided Conv的設(shè)計,我們將向量大小設(shè)為,從而獲得具有上下文信息的新特征,表示為。然后作者又將全局上下文信息寫成一組向量。

上下文關(guān)系推理描述符

基于之前的卷積推理工作,作者構(gòu)建了上下文描述符之間的關(guān)系推理模型。具體地說,通過權(quán)重參數(shù)將上下文描述符嵌入到兩個嵌入空間中。然后,正對的關(guān)系函數(shù)可以表達為:它獲取每兩個學習的上下文描述符和之間的關(guān)系,從而生成一個圖。

然后通過一個殘差學習將和原始輸入橋接得到最終的全局上下文關(guān)系:

上下文推理注意卷積

作者采用增強的全局上下文信息來更新卷積核,從而得到最終的注意力遮罩。為了盡可能減少空間復(fù)雜度,作者將這個卷積遮罩分解成和。然后分別利用空間交互和通道交互來得到和。

通道相互作用:其中通道相互作用采用了深度可分離卷積來減少計算量,通過一個權(quán)重為分組線性層進行投影。最后得到通道交互特征。

空間相互作用:然后,我們分別對和分別進行空間相互作用,得到相應(yīng)的張量和。具體來說就是利用兩個權(quán)重共享的線性層將這兩個特征和映射為和,記作和。

**上下文推理注意力卷積:**在進行通道和空間交互之后, 作者直接利用和通過擴張通道數(shù)為,然后再進行逐元素相加得到。

最后,我們可以應(yīng)用注意掩碼來調(diào)制卷積核權(quán)重,如下所示:

上下文推理注意力圖像超分辨率網(wǎng)絡(luò)

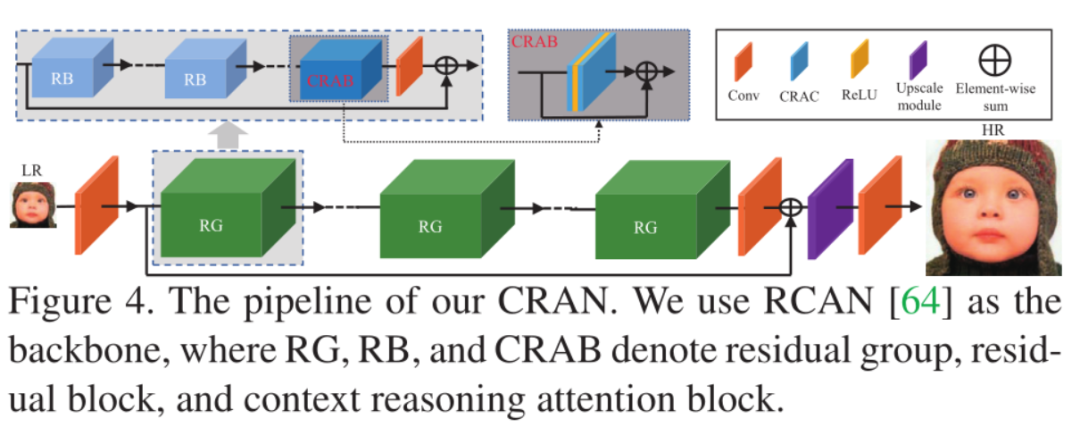

作者采用了RCAN的網(wǎng)絡(luò)結(jié)構(gòu),將原有的RCAN中的RCAB模塊替換成了CRAB模塊,其中CRAB就是利用了作者提出的上下文推理注意力卷積來進行構(gòu)建的。

采用了和RCAN中的參數(shù)設(shè)置,并且進行了一系列的消融實驗證明作者提出的模塊的有效性。

3Experiments

訓練選用了DIV2K和Flickr2K作為訓練數(shù)據(jù),

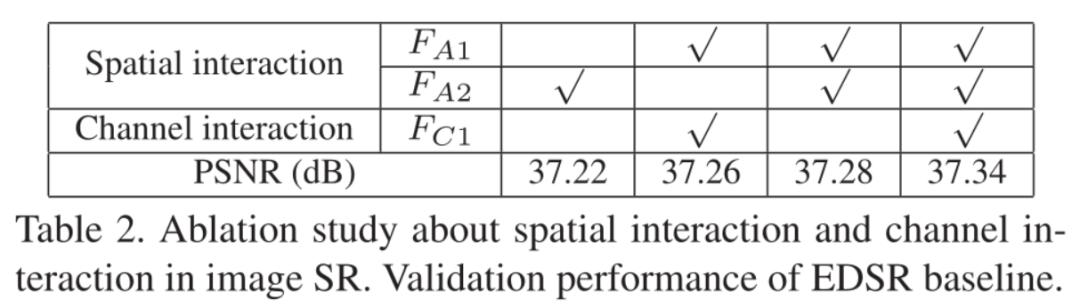

消融實驗

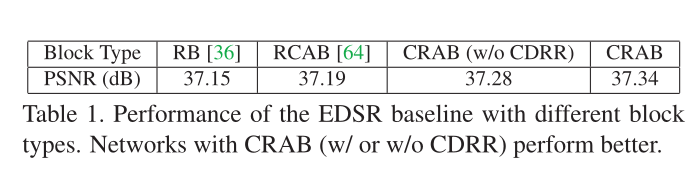

可以從表1中可以看出,包含注意力的模塊可以獲得比普通殘差快更高的性能。

作者提出的CRAB可以有效的考慮全局上下文的關(guān)系,從而獲得好的性能,然后作者的模塊通過CDRR,實現(xiàn)了進一步的性能提升,這證明了CDRR的有效性。

主要結(jié)果

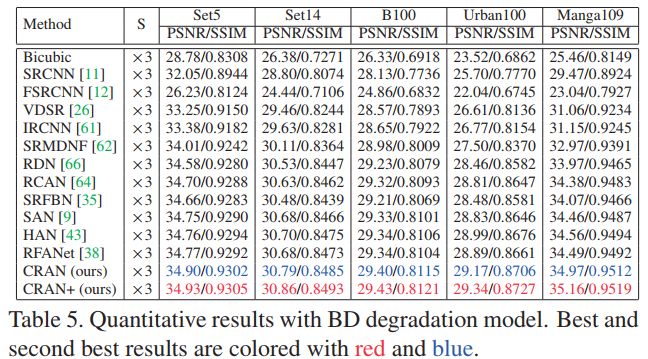

上表對比了不同注意力超分方案的性能,從中可以看到:

作者提出的方法在所有的數(shù)據(jù)集上可以獲得最佳的PSNR和SSIM。、 與RCAN相比,作者的方法通過修改其中的注意力模塊從而得到了卓越的性能,這進一步證明了作者提出的CRAN可以通過調(diào)整Conv層內(nèi)核和全局上下文推理注意來進一步提高性能。 作者提出的方法不僅在BI的降質(zhì)過程上取得好的效果,在BD的降質(zhì)表現(xiàn)上也取得了優(yōu)異的性能。

上圖對比了不同方法在紋理細節(jié)恢復(fù)上的效果對比,可以看到:通過作者提出的全局上下文推理注意力卷積可以有效的恢復(fù)出正確的紋理細節(jié)。

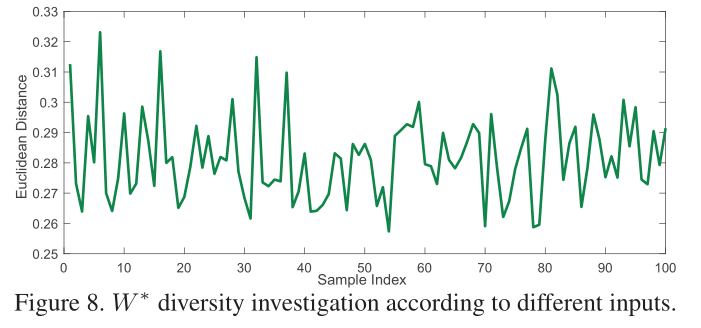

卷積核的多樣性

作者為了調(diào)查卷積核的多樣性,作者考慮計算和全為1的矩陣I的歐氏距離,作者將100張圖像隨機轉(zhuǎn)發(fā)到網(wǎng)絡(luò)中,并計算每個樣本的距離。如上圖所示,可以看出:作者提出的卷積是根據(jù)圖像進行自適應(yīng)調(diào)整的,因此整個圖像是波動的。

4Conclusion

作者借鑒了Context Guided Conv方法提出了一種全局上下文推理注意力卷積CRAC。 作者借鑒了其他推理網(wǎng)絡(luò)從而提出了上下文關(guān)系推理描述符(CDRR),從而進一步增強描述符的上下文關(guān)系。 將提出來的CRAC應(yīng)用到RCAN中獲得了卓越的超分辨率性能。

5Reference

[1] Tao Dai, Jianrui Cai, Y ongbing Zhang, Shu-Tao Xia, and Lei Zhang. Second-order attention network for single image super-resolution. In CVPR, 2019.

[2] Xudong Lin, Lin Ma, Wei Liu, and Shih-Fu Chang. Context-gated convolution. In ECCV, 2020.

[3] Jie Liu, Wenjie Zhang, Y uting Tang, Jie Tang, and Gangshan Wu. Residual feature aggregation network for image super-resolution. In CVPR, 2020.

[4] Yiqun Mei, Y uchen Fan, Y uqian Zhou, Lichao Huang, Thomas S Huang, and Humphrey Shi.

[5] Image super-resolution with cross-scale non-local attention and exhaustive self-exemplars mining. In CVPR, 2020.