圖像超分辨率網(wǎng)絡(luò)中的注意力機(jī)制

來源:DeepHub IMBA 本文約2100字,建議閱讀8分鐘

本文為你介紹的論文試圖量化和可視化靜態(tài)注意力機(jī)制,并表明并非所有的注意模塊都是有益的。

圖像超分辨率(SR)是一種低層次的計(jì)算機(jī)視覺問題,其目標(biāo)是從低分辨率觀測中恢復(fù)出高分辨率圖像。近年來,基于深度卷積神經(jīng)網(wǎng)絡(luò)(CNN)的SR方法取得了顯著的成功,CNN模型的性能不斷增長。近年來,一些方法開始將注意機(jī)制集成到SR模型中,如頻道注意和空間注意。注意力機(jī)制的引入通過增強(qiáng)靜態(tài)cnn的表示能力,極大地提高了這些網(wǎng)絡(luò)的性能。

動(dòng)機(jī)

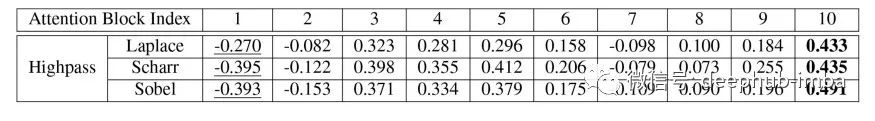

圖像的每個(gè)部分的注意力因素是高還是低? 注意力機(jī)制是否總是有利于SR模式?

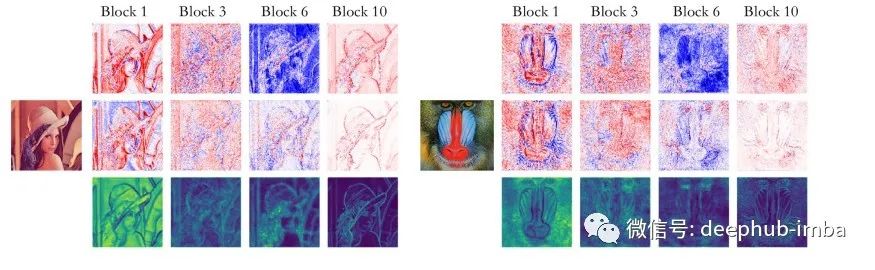

第一行:平均輸入特征圖。

第二行:平均輸出特征圖。

第三行:平均注意力地圖。

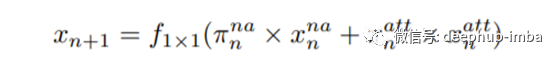

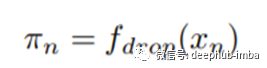

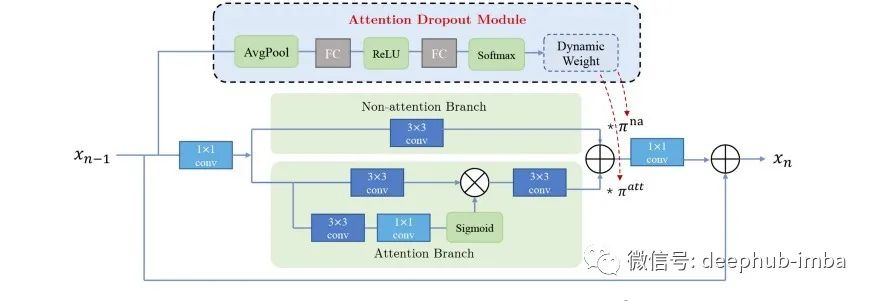

方法

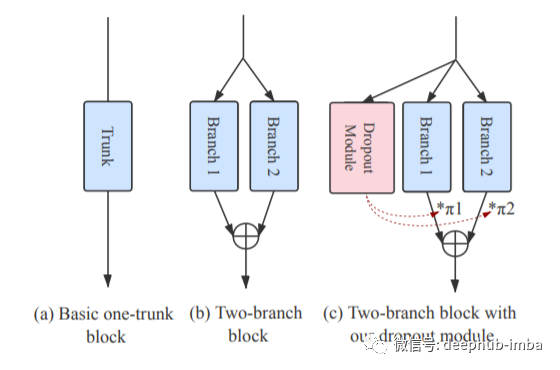

淺層的特征提取; 注意塊深度特征提取中的注意力; 圖像重建模塊。

結(jié)論

編輯:黃繼彥

校對(duì):林亦霖

評(píng)論

圖片

表情