?吳恩達(dá):AI的中心到底是模型還是數(shù)據(jù)?

點(diǎn)擊下方卡片,關(guān)注“CVer”公眾號(hào)

AI/CV重磅干貨,第一時(shí)間送達(dá)

作者:Dario Radecic,Medium 高質(zhì)技術(shù)博主

編譯:頌賢

圖源:Brandon Lopez (Unsplash)

一般的AI課程會(huì)介紹很多如何通過(guò)參數(shù)優(yōu)化來(lái)提高機(jī)器學(xué)習(xí)模型準(zhǔn)確性的方法,然而這些方法通常都存在一定的局限性。這是因?yàn)槲覀兂3:鲆暳爽F(xiàn)代機(jī)器學(xué)習(xí)一個(gè)非常重要的核心——數(shù)據(jù)。如果我們沒(méi)有處理好訓(xùn)練數(shù)據(jù)沒(méi),上百個(gè)小時(shí)的時(shí)間都會(huì)被浪費(fèi)在調(diào)整一個(gè)低質(zhì)量數(shù)據(jù)訓(xùn)練出來(lái)的模型上,模型的準(zhǔn)確度很容易就會(huì)低于預(yù)期,而這和模型調(diào)優(yōu)是沒(méi)有太大關(guān)系的。怎樣才能避免這樣的問(wèn)題呢?

粗略地看,其實(shí)每個(gè)AI項(xiàng)目都由兩部分組成:模型和數(shù)據(jù)。對(duì)于代碼這部分,我們總能使用第三方庫(kù)來(lái)盡可能地提高代碼質(zhì)量,但從來(lái)沒(méi)有人告訴我們?cè)撊绾纬浞痔嵘龜?shù)據(jù)的質(zhì)量。這就是本文想要介紹的新思路:以數(shù)據(jù)為中心的AI。究竟什么是以數(shù)據(jù)為中心的AI?數(shù)據(jù)的數(shù)量與質(zhì)量到底哪一個(gè)優(yōu)先級(jí)更高?哪里可以找到好的數(shù)據(jù)集?這些問(wèn)題本文都將帶大家探討。

什么是以數(shù)據(jù)為中心的AI?

既然AI由模型和數(shù)據(jù)兩部分組成,那么我們可以想到有兩種基本思路來(lái)指導(dǎo)我們的機(jī)器學(xué)習(xí):

以模型為中心: 通過(guò)改進(jìn)模型來(lái)提升表現(xiàn)

以數(shù)據(jù)為中心: 通過(guò)改進(jìn)數(shù)據(jù)來(lái)提升表現(xiàn)

其實(shí),以數(shù)據(jù)為中心的AI(data-centric AI)這一概念是吳恩達(dá)(Andrew Ng)的發(fā)明。吳恩達(dá)早前在油管上做了一次直播問(wèn)答,專門講解了什么是以數(shù)據(jù)為中心的AI。他提出,最近發(fā)表的學(xué)術(shù)論文中,99%都是在談?wù)撃P停挥?%是以數(shù)據(jù)為中心的。其中有一句話特別值得注意:“別再花太多心思在模型優(yōu)化上了”(your model architecture is good enough)。

吳恩達(dá)何出此言呢?ResNet, VGG, EfficientNet等學(xué)術(shù)界各路天才的種種智慧結(jié)晶,已經(jīng)讓我們現(xiàn)在能夠接觸到的模型架構(gòu)變得非常強(qiáng)大了。試圖再站在這些巨人的肩膀上改善她們的工作只能達(dá)到杯水車薪的效果。

不過(guò),以模型為中心的思路的確更適合那些喜歡鉆研理論的人,她們可以直接把手頭的知識(shí)應(yīng)用到具體場(chǎng)景中提升模型性能。而且,以數(shù)據(jù)為中心的思路聽起來(lái)并不討巧,誰(shuí)會(huì)喜歡每天樂(lè)此不疲地給數(shù)據(jù)做標(biāo)注呢?

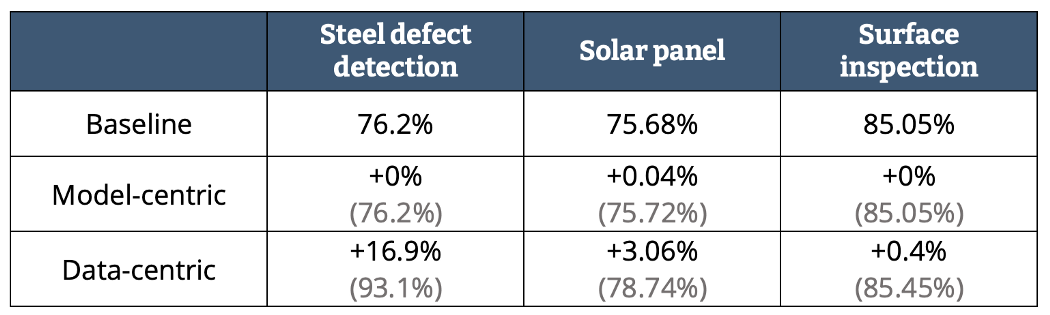

然而事實(shí)證明,我們能做到的大部分性能提升都是通過(guò)以數(shù)據(jù)為中心的方法實(shí)現(xiàn)的。吳恩達(dá)在他的演講中就展示了下面這組數(shù)據(jù):

圖1 — 基線、模型中心、數(shù)據(jù)中心性能比較(作者制圖)

即使我們對(duì)鋼鐵缺陷這些事情沒(méi)有什么了解,模型性能在數(shù)字上的顯著提升我們是看得見的。我們可以看到,以模型為中心的方法對(duì)基線的改進(jìn)不是零就是接近零,而且這種方法往往需要花費(fèi)從業(yè)者數(shù)百小時(shí)的時(shí)間。

總結(jié)而言,我們可以得出一個(gè)很重要的經(jīng)驗(yàn)教訓(xùn):不要試圖和一屋子的博士比智商。在想要改進(jìn)模型之前,我們要首先確保手頭上的數(shù)據(jù)質(zhì)量是一流的。

數(shù)據(jù)要先保質(zhì)還是保量?

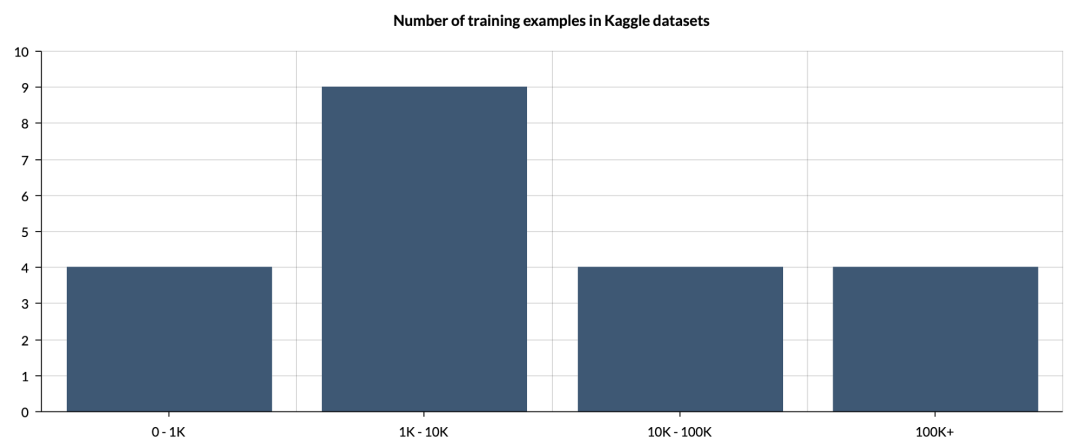

要想追求數(shù)據(jù)的數(shù)量,通常的做法就是收集盡可能多的數(shù)據(jù),并將其悉數(shù)扔給神經(jīng)網(wǎng)絡(luò)來(lái)學(xué)習(xí)映射關(guān)系。然而,一個(gè)數(shù)據(jù)集好用并不意味著它的數(shù)據(jù)量很大。我們可以參考數(shù)據(jù)集分享網(wǎng)站Kaggle上的數(shù)據(jù)集大小分布,圖示如下:

圖2 — Kaggle上的數(shù)據(jù)集大小分布 (圖源作者)

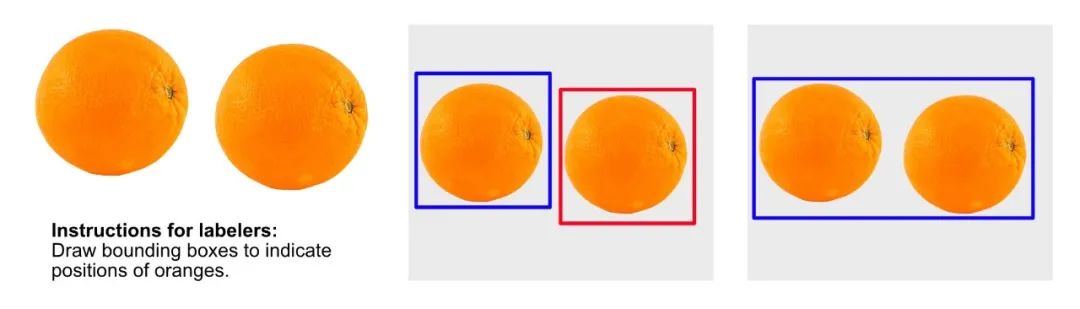

我們可以看到,大多數(shù)數(shù)據(jù)集并沒(méi)有太多的數(shù)據(jù)。在以數(shù)據(jù)為中心的方法中,數(shù)據(jù)集的大小并不重要。當(dāng)然,我們不可能用三張圖片去訓(xùn)練神經(jīng)網(wǎng)絡(luò),但我們的重點(diǎn)要放到質(zhì)量上,而不是數(shù)量。就算我們沒(méi)有成百上千的圖片也沒(méi)關(guān)系,已有的數(shù)據(jù)質(zhì)量和標(biāo)注準(zhǔn)確度是至關(guān)重要的。我們可以參考下面的例子,下圖是標(biāo)注人員為兩個(gè)橙子的位置做出的兩種不同的標(biāo)注方法。

圖3 — 為物體檢測(cè)任務(wù)標(biāo)注邊界的不同方法(圖源作者)

想要讓模型準(zhǔn)確度下降很簡(jiǎn)單,只要給它灌入標(biāo)注不一致的數(shù)據(jù)就可以了。如果要追求數(shù)據(jù)的質(zhì)量,我們就必須有嚴(yán)格而統(tǒng)一的標(biāo)注規(guī)則。項(xiàng)目同時(shí)有多家標(biāo)注商時(shí)情況就更是如此。

不過(guò),就算數(shù)據(jù)的質(zhì)量能夠保證,我們到底需要多少數(shù)據(jù)才算夠呢?這個(gè)問(wèn)題比你想象的要難回答。大多數(shù)算法在其文檔中會(huì)標(biāo)明一個(gè)最小的推薦數(shù)據(jù)量。例如,YOLOv5就建議每個(gè)類別至少有1500張圖片。我本人曾經(jīng)設(shè)法用比這更少的數(shù)據(jù)取得了很好的結(jié)果,但是如果有更多的訓(xùn)練樣本,模型的準(zhǔn)確性肯定會(huì)提高。

總結(jié)而言,擁有大量的數(shù)據(jù)能夠如虎添翼,但數(shù)據(jù)的量絕不是必需品。小數(shù)據(jù)集只要能有較高的數(shù)據(jù)質(zhì)量,我們就可以用較少的數(shù)據(jù)達(dá)到四兩撥千斤的效果。

高質(zhì)量數(shù)據(jù)集哪里找?

現(xiàn)在我們來(lái)看一下兩個(gè)能夠免費(fèi)獲取高質(zhì)量數(shù)據(jù)集的平臺(tái)。

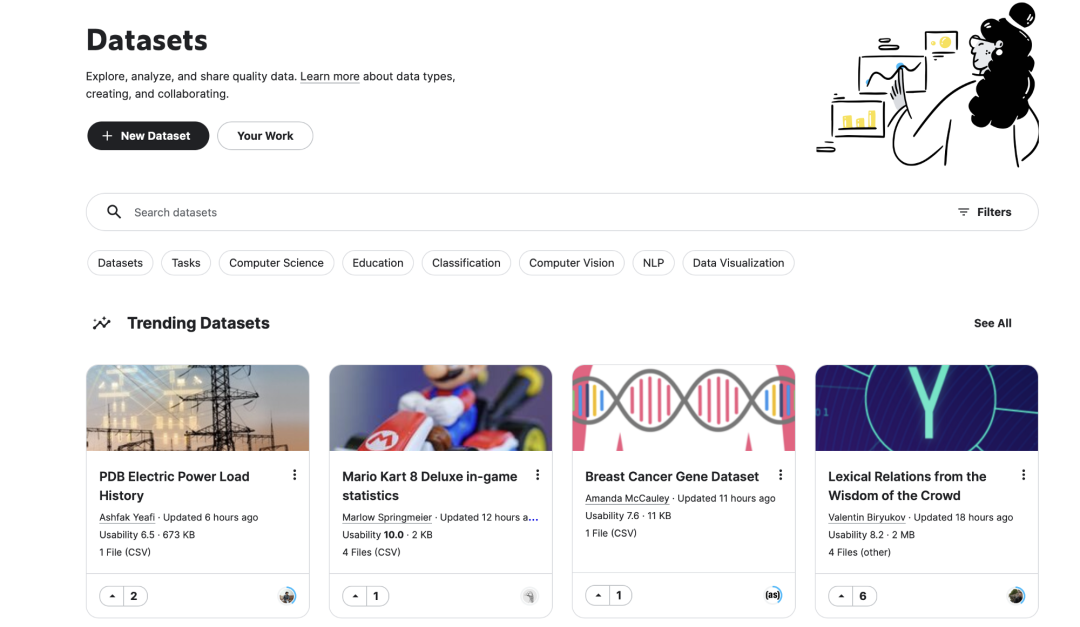

Kaggle

Kaggle擁有大量包括圖表和圖像在內(nèi)的數(shù)據(jù)集。同時(shí),Kaggle經(jīng)常會(huì)舉辦各種各樣的機(jī)器學(xué)習(xí)競(jìng)賽,其中不乏現(xiàn)金獎(jiǎng)勵(lì),非常適合那些想要展示自身技能的同學(xué)。不過(guò),盡管Kaggle已經(jīng)非常出名,它沒(méi)有針對(duì)國(guó)內(nèi)的網(wǎng)絡(luò)進(jìn)行優(yōu)化,下載數(shù)據(jù)集并非易事。

圖4 — Kaggle數(shù)據(jù)集主頁(yè)

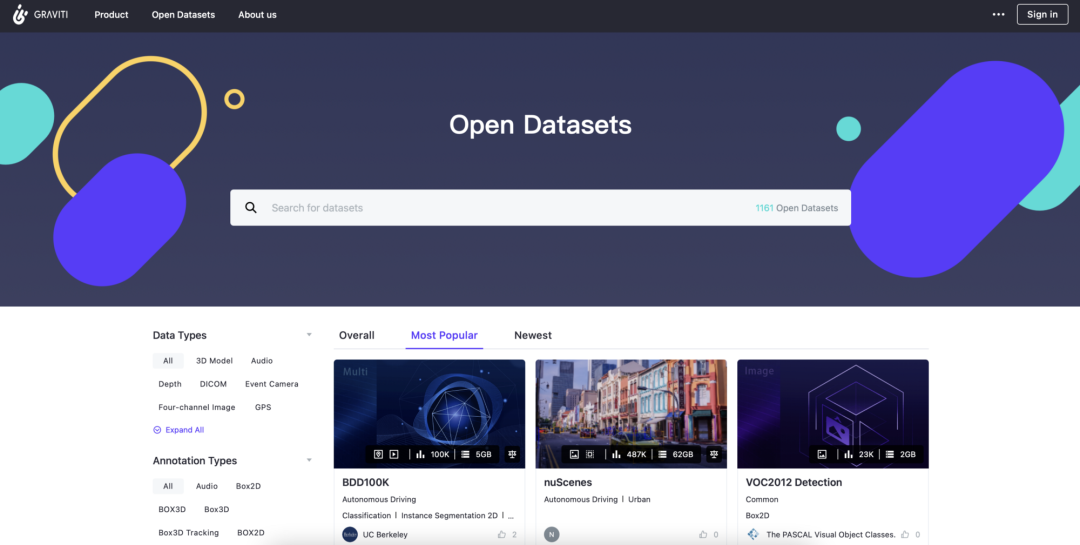

格物鈦公開數(shù)據(jù)集平臺(tái)

也許你沒(méi)有聽說(shuō)過(guò)這個(gè)平臺(tái),不過(guò)它的出現(xiàn)確實(shí)給算法開發(fā)者們帶來(lái)了極大的幫助,不論你身處國(guó)內(nèi)還是國(guó)外。

在格物鈦公開數(shù)據(jù)集平臺(tái)(gas.graviti.cn/open-datasets),用戶可以通過(guò)數(shù)據(jù)集的名稱聯(lián)想檢索、應(yīng)用場(chǎng)景篩選、標(biāo)注類型篩選、推薦、更新時(shí)間及熱度篩選,輕松找到所需數(shù)據(jù)集。同時(shí),用戶無(wú)需下載,即可在數(shù)據(jù)集詳情頁(yè)在線查看標(biāo)注情況及標(biāo)簽分布,掌握數(shù)據(jù)細(xì)節(jié)。

不過(guò),如果你想下載數(shù)據(jù)集至本地,格物鈦用戶提供高速穩(wěn)定的下載服務(wù)。將全球資源Host至國(guó)內(nèi)鏡像,無(wú)需VPN訪問(wèn),滿帶寬極速下載。與進(jìn)入海外官網(wǎng)下載相比,格物鈦至少提速100%。

簡(jiǎn)直是身處國(guó)內(nèi)AI開發(fā)者的福音!

圖5 — 格物鈦公開數(shù)據(jù)集主頁(yè)

事實(shí)上,格物鈦平臺(tái)上的數(shù)據(jù)集還在不斷增長(zhǎng)中,用戶可以自發(fā)的上傳一些開源數(shù)據(jù)集,其團(tuán)隊(duì)也會(huì)定期加入新的高質(zhì)量公開數(shù)據(jù)集。例如,知名的自動(dòng)駕駛數(shù)據(jù)集nuScenes就在平臺(tái)上有所收錄,并且有非常高效的在線可視化插件一鍵直觀查看數(shù)據(jù)集內(nèi)容:

圖6 — 格物鈦平臺(tái)上的nuScenes數(shù)據(jù)集

不僅如此,當(dāng)你需要某些未被上傳的特定數(shù)據(jù)集時(shí),你可以加入格物鈦社區(qū)(微信或Discord)。格物鈦提供了問(wèn)題與需求的反饋渠道,便于一對(duì)一針對(duì)性回應(yīng)、跟進(jìn)、解決用戶的需求。

結(jié)語(yǔ)

以上就是對(duì)以數(shù)據(jù)為中心的AI的基本介紹。簡(jiǎn)單來(lái)說(shuō),以數(shù)據(jù)為中心的AI就是要更關(guān)心數(shù)據(jù)的質(zhì)量而不是數(shù)量。然而,高質(zhì)量的數(shù)據(jù)集是很難找到的。如果你想建立優(yōu)質(zhì)的機(jī)器學(xué)習(xí)模型,你就一定需要優(yōu)質(zhì)的數(shù)據(jù)集。對(duì)于接觸數(shù)據(jù)集平臺(tái)而言,Kaggle是一個(gè)很好的開始。但如果你對(duì)計(jì)算機(jī)視覺(jué)等具體領(lǐng)域感興趣,并且想要以快捷高效的方式訪問(wèn)數(shù)據(jù)集,務(wù)必試試免費(fèi)好用的格物鈦公開數(shù)據(jù)集平臺(tái)。

Open Datasets ??

格物鈦|公開數(shù)據(jù)集

graviti.cn/open-datasets

訂閱號(hào):格物鈦 ??

微信號(hào)|Graviti_2019

微博|格物鈦

https://www.graviti.cn/

點(diǎn)擊閱讀原文 / 訪問(wèn)格物鈦官網(wǎng)