人人都能看懂的 LSTM

這是在看了臺大李宏毅教授的深度學(xué)習(xí)視頻之后的一點總結(jié)和感想。看完介紹的第一部分RNN尤其LSTM的介紹之后,整個人醍醐灌頂。本篇博客就是對視頻的一些記錄加上了一些個人的思考。

???0. 從RNN說起

循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Network,RNN)是一種用于處理序列數(shù)據(jù)的神經(jīng)網(wǎng)絡(luò)。相比一般的神經(jīng)網(wǎng)絡(luò)來說,他能夠處理序列變化的數(shù)據(jù)。比如某個單詞的意思會因為上文提到的內(nèi)容不同而有不同的含義,RNN就能夠很好地解決這類問題。

???1. 普通RNN

先簡單介紹一下一般的RNN。

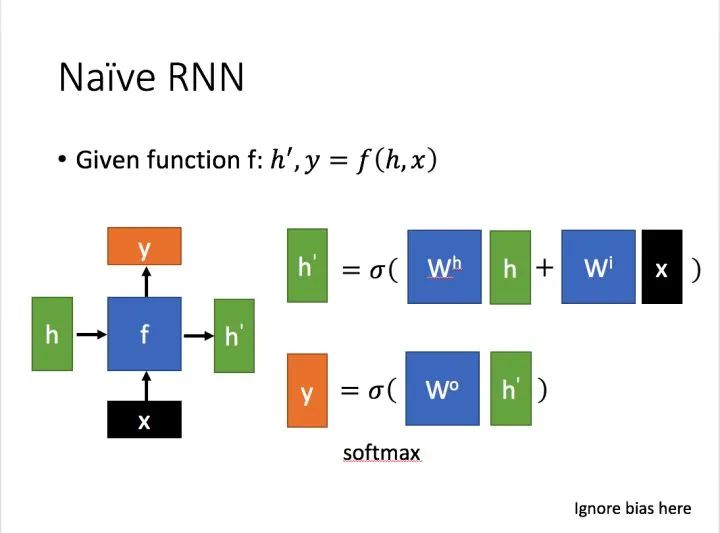

其主要形式如下圖所示(圖片均來自臺大李宏毅教授的PPT):

這里:

?為當前狀態(tài)下數(shù)據(jù)的輸入,?

?為當前狀態(tài)下數(shù)據(jù)的輸入,? ?表示接收到的上一個節(jié)點的輸入。

?表示接收到的上一個節(jié)點的輸入。

?為當前節(jié)點狀態(tài)下的輸出,而?

?為當前節(jié)點狀態(tài)下的輸出,而? ?為傳遞到下一個節(jié)點的輸出。

?為傳遞到下一個節(jié)點的輸出。

通過上圖的公式可以看到,輸出?h'?與?x?和?h?的值都相關(guān)。

而?y?則常常使用?h'?投入到一個線性層(主要是進行維度映射)然后使用softmax進行分類得到需要的數(shù)據(jù)。

對這里的y如何通過?h'?計算得到往往看具體模型的使用方式。

通過序列形式的輸入,我們能夠得到如下形式的RNN。

???2. LSTM

2.1 什么是LSTM

長短期記憶(Long short-term memory, LSTM)是一種特殊的RNN,主要是為了解決長序列訓(xùn)練過程中的梯度消失和梯度爆炸問題。簡單來說,就是相比普通的RNN,LSTM能夠在更長的序列中有更好的表現(xiàn)。

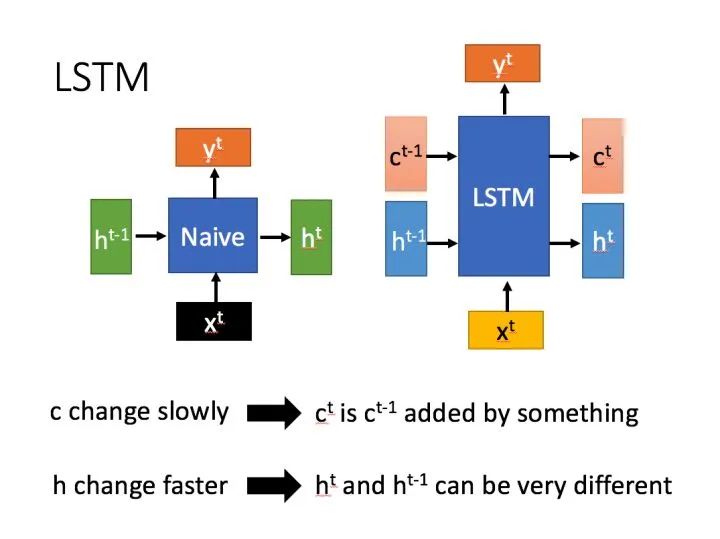

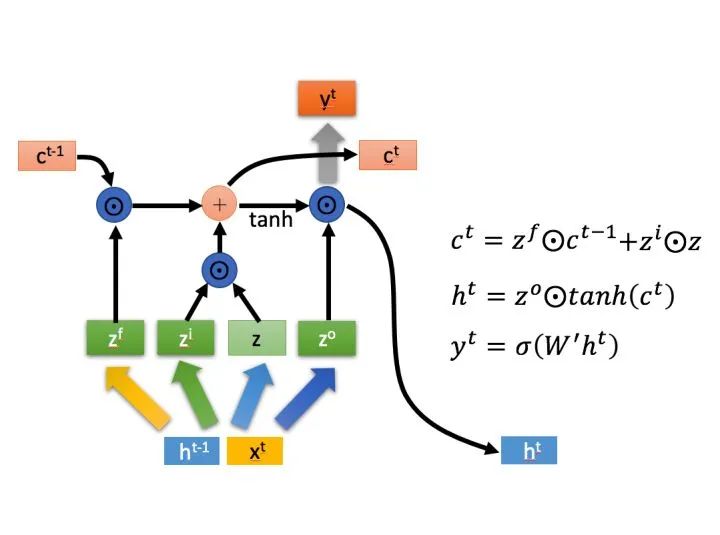

LSTM結(jié)構(gòu)(圖右)和普通RNN的主要輸入輸出區(qū)別如下所示。

相比RNN只有一個傳遞狀態(tài)? ?,LSTM有兩個傳輸狀態(tài),一個?

?,LSTM有兩個傳輸狀態(tài),一個? ?(cell state),和一個?

?(cell state),和一個? (hidden state)。(Tips:RNN中的?

(hidden state)。(Tips:RNN中的? ?對于LSTM中的?

?對于LSTM中的? ?)

?)

其中對于傳遞下去的? ?改變得很慢,通常輸出的?

?改變得很慢,通常輸出的? ?是上一個狀態(tài)傳過來的?

?是上一個狀態(tài)傳過來的? ?加上一些數(shù)值。

?加上一些數(shù)值。

而? ?則在不同節(jié)點下往往會有很大的區(qū)別。

?則在不同節(jié)點下往往會有很大的區(qū)別。

2.2 深入LSTM結(jié)構(gòu)

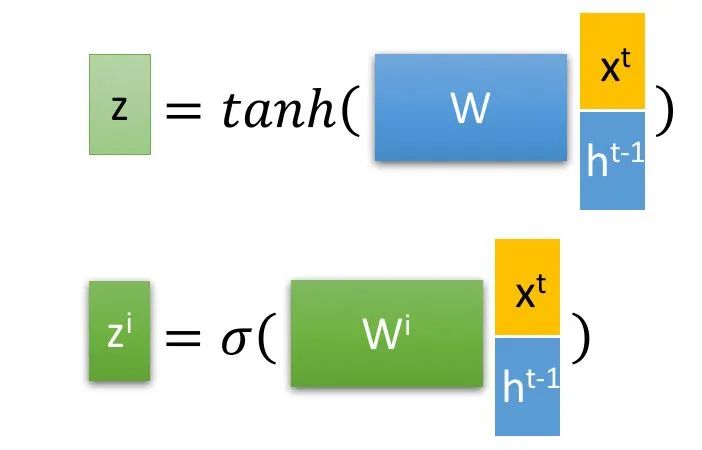

?和上一個狀態(tài)傳遞下來的?

?和上一個狀態(tài)傳遞下來的? ?拼接訓(xùn)練得到四個狀態(tài)。

?拼接訓(xùn)練得到四個狀態(tài)。

?,?

?,? ?,

?, ?是由拼接向量乘以權(quán)重矩陣之后,再通過一個?

?是由拼接向量乘以權(quán)重矩陣之后,再通過一個? ?激活函數(shù)轉(zhuǎn)換成0到1之間的數(shù)值,來作為一種門控狀態(tài)。而?

?激活函數(shù)轉(zhuǎn)換成0到1之間的數(shù)值,來作為一種門控狀態(tài)。而? ?則是將結(jié)果通過一個?

?則是將結(jié)果通過一個? ?激活函數(shù)將轉(zhuǎn)換成-1到1之間的值(這里使用?

?激活函數(shù)將轉(zhuǎn)換成-1到1之間的值(這里使用? ?是因為這里是將其做為輸入數(shù)據(jù),而不是門控信號)。

?是因為這里是將其做為輸入數(shù)據(jù),而不是門控信號)。

?是Hadamard Product,也就是操作矩陣中對應(yīng)的元素相乘,因此要求兩個相乘矩陣是同型的。?

?是Hadamard Product,也就是操作矩陣中對應(yīng)的元素相乘,因此要求兩個相乘矩陣是同型的。? ?則代表進行矩陣加法。

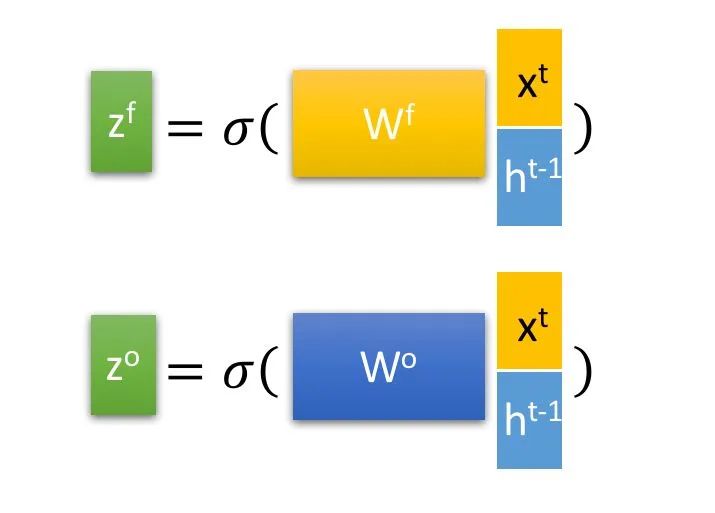

?則代表進行矩陣加法。 ?(f表示forget)來作為忘記門控,來控制上一個狀態(tài)的?

?(f表示forget)來作為忘記門控,來控制上一個狀態(tài)的? ?哪些需要留哪些需要忘。

?哪些需要留哪些需要忘。 ?進行選擇記憶。哪些重要則著重記錄下來,哪些不重要,則少記一些。當前的輸入內(nèi)容由前面計算得到的?

?進行選擇記憶。哪些重要則著重記錄下來,哪些不重要,則少記一些。當前的輸入內(nèi)容由前面計算得到的? ?表示。而選擇的門控信號則是由?

?表示。而選擇的門控信號則是由? ?(i代表information)來進行控制。

?(i代表information)來進行控制。將上面兩步得到的結(jié)果相加,即可得到傳輸給下一個狀態(tài)的??。也就是上圖中的第一個公式。

3. 輸出階段。這個階段將決定哪些將會被當成當前狀態(tài)的輸出。主要是通過? ?來進行控制的。并且還對上一階段得到的?

?來進行控制的。并且還對上一階段得到的? ?進行了放縮(通過一個tanh激活函數(shù)進行變化)。

?進行了放縮(通過一個tanh激活函數(shù)進行變化)。

與普通RNN類似,輸出? ?往往最終也是通過?

?往往最終也是通過? ?變化得到。

?變化得到。

???3. 總結(jié)

以上,就是LSTM的內(nèi)部結(jié)構(gòu)。通過門控狀態(tài)來控制傳輸狀態(tài),記住需要長時間記憶的,忘記不重要的信息;而不像普通的RNN那樣只能夠“呆萌”地僅有一種記憶疊加方式。對很多需要“長期記憶”的任務(wù)來說,尤其好用。

但也因為引入了很多內(nèi)容,導(dǎo)致參數(shù)變多,也使得訓(xùn)練難度加大了很多。因此很多時候我們往往會使用效果和LSTM相當?shù)珔?shù)更少的GRU來構(gòu)建大訓(xùn)練量的模型。

轉(zhuǎn)自:AI有道