Python爬蟲模擬登錄帶驗(yàn)證碼網(wǎng)站

爬取網(wǎng)站時(shí)經(jīng)常會(huì)遇到需要登錄的問題,這是就需要用到模擬登錄的相關(guān)方法。python提供了強(qiáng)大的url庫,想做到這個(gè)并不難。這里以登錄學(xué)校教務(wù)系統(tǒng)為例,做一個(gè)簡單的例子。

首先得明白cookie的作用,cookie是某些網(wǎng)站為了辨別用戶身份、進(jìn)行session跟蹤而儲(chǔ)存在用戶本地終端上的數(shù)據(jù)。因此我們需要用Cookielib模塊來保持網(wǎng)站的cookie。

這個(gè)是要登陸的地址 http://202.115.80.153/ 和驗(yàn)證碼地址 http://202.115.80.153/CheckCode.aspx

可以發(fā)現(xiàn)這個(gè)驗(yàn)證碼是動(dòng)態(tài)更新的每次打開都不一樣,一般這種驗(yàn)證碼和cookie是同步的。其次想識(shí)別驗(yàn)證碼肯定是吃力不討好的事,因此我們的思路是首先訪問驗(yàn)證碼頁面,保存驗(yàn)證碼、獲取cookie用于登錄,然后再直接向登錄地址post數(shù)據(jù)。

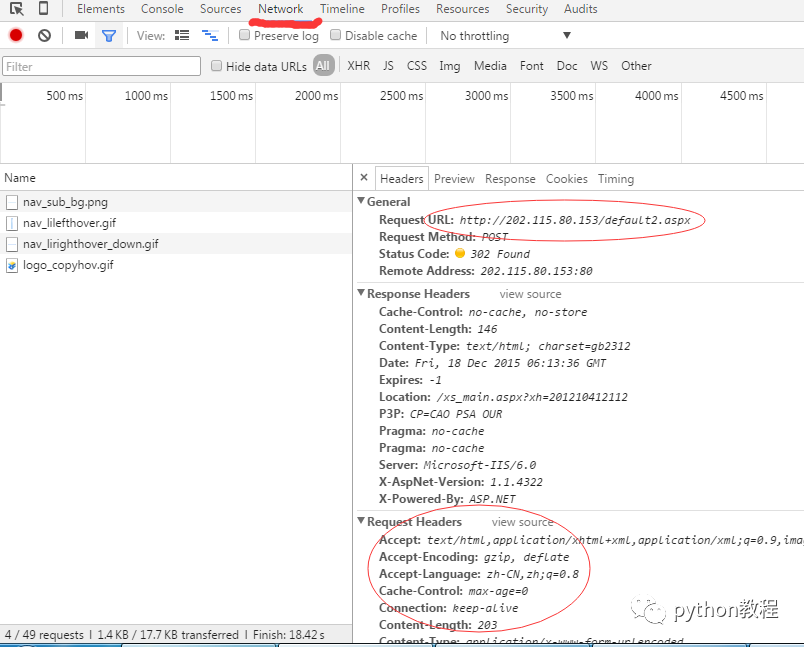

首先通過抓包工具或者火狐或者谷歌瀏覽器分析登錄頁面需要post的request和header信息。以谷歌瀏覽器為例。

從中可以看出需要post的url并不是訪問的頁面,而是http://202.115.80.153/default2.aspx,

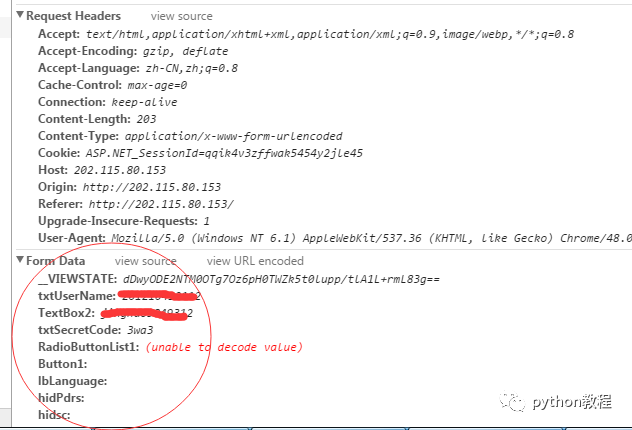

其中需要提交的表單數(shù)據(jù)中txtUserName和TextBox2分別用戶名和密碼。

現(xiàn)在直接到關(guān)鍵部分 上代碼!!

import urllib2import cookielibimport urllibimport reimport sys'''模擬登錄'''reload(sys)sys.setdefaultencoding("utf-8")# 防止中文報(bào)錯(cuò)CaptchaUrl = "http://202.115.80.153/CheckCode.aspx"PostUrl = "http://202.115.80.153/default2.aspx"# 驗(yàn)證碼地址和post地址cookie = cookielib.CookieJar()handler = urllib2.HTTPCookieProcessor(cookie)opener = urllib2.build_opener(handler)# 將cookies綁定到一個(gè)opener cookie由cookielib自動(dòng)管理username = 'username'password = 'password123'# 用戶名和密碼picture = opener.open(CaptchaUrl).read()# 用openr訪問驗(yàn)證碼地址,獲取cookielocal = open('e:/image.jpg', 'wb')local.write(picture)local.close()# 保存驗(yàn)證碼到本地SecretCode = raw_input('輸入驗(yàn)證碼:')# 打開保存的驗(yàn)證碼圖片 輸入postData = {'__VIEWSTATE': 'dDwyODE2NTM0OTg7Oz6pH0TWZk5t0lupp/tlA1L+rmL83g==','txtUserName': username,'TextBox2': password,'txtSecretCode': SecretCode,'RadioButtonList1': '學(xué)生','Button1': '','lbLanguage': '','hidPdrs': '','hidsc': '',}# 根據(jù)抓包信息 構(gòu)造表單headers = {'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8','Accept-Language': 'zh-CN,zh;q=0.8','Connection': 'keep-alive','Content-Type': 'application/x-www-form-urlencoded','User-Agent': 'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/46.0.2490.86 Safari/537.36',}# 根據(jù)抓包信息 構(gòu)造headersdata = urllib.urlencode(postData)# 生成post數(shù)據(jù) ?key1=value1&key2=value2的形式request = urllib2.Request(PostUrl, data, headers)# 構(gòu)造request請求try:response = opener.open(request)result = response.read().decode('gb2312')# 由于該網(wǎng)頁是gb2312的編碼,所以需要解碼print result# 打印登錄后的頁面except urllib2.HTTPError, e:print e.code# 利用之前存有cookie的opener登錄頁面

登錄成功后便可以利用該openr訪問其他需要登錄才能訪問的頁面。

搜索下方加老師微信

老師微信號(hào):XTUOL1988【切記備注:學(xué)習(xí)Python】

領(lǐng)取Python web開發(fā),Python爬蟲,Python數(shù)據(jù)分析,人工智能等精品學(xué)習(xí)課程。帶你從零基礎(chǔ)系統(tǒng)性的學(xué)好Python!

*聲明:本文于網(wǎng)絡(luò)整理,版權(quán)歸原作者所有,如來源信息有誤或侵犯權(quán)益,請聯(lián)系我們刪除或授權(quán)