2022年京東NLP實(shí)習(xí)面試題7道

公眾號(hào)福利

??回復(fù)【100題】領(lǐng)取《名企AI面試100題》PDF

??回復(fù)【干貨資料】領(lǐng)取NLP、CV、ML等AI方向干貨資料

??回復(fù)【往期招聘】查看往期重要招聘

問(wèn)題1:Beam Search生成的句子基本都一樣,是否有方法擴(kuò)展生成句子的多樣性。

解決方法:通過(guò)分組加入相似性懲罰,具體可以參考論文 Diverse beam search:https://arxiv.org/pdf/1610.02424.pdf。

具體方法:選擇Beam size為B,然后將其分為G組,每一組就有 B/G 個(gè)beam,每個(gè)單獨(dú)的組內(nèi)跟 beam search很像,不斷延展序列,同時(shí)引入一個(gè) dissimilarity項(xiàng)來(lái)保證組與組之間有差異。

組內(nèi)與 beam search 很像:從t-1到 t 時(shí)刻,不斷的減少搜索空間(如同beam search一樣)。

組間差異:對(duì)于t=4時(shí)刻,我們先對(duì)第一組輸出y(t=4),然后我們開(kāi)始對(duì)第二組輸出y(t=4),但是第二組y(t=4)的score不僅取決于第二組之前的y(t=3),也取決于其與第一組的相似程度。以此類推,在t=4時(shí)刻對(duì)于第三組的輸出,我們從上圖可以看到其score的打分標(biāo)準(zhǔn)。這兒對(duì)于其 dissimilarity 項(xiàng)的計(jì)算采用的辦法是 hamming diversity,這個(gè)理解起來(lái)很簡(jiǎn)單,比如這個(gè)時(shí)刻可能輸出的詞在上面的組出現(xiàn)過(guò),我們就對(duì)這個(gè)詞的分?jǐn)?shù)-1,如果這個(gè)時(shí)刻可能輸出的詞在上面組沒(méi)有出現(xiàn)過(guò),我們就對(duì)這個(gè)詞的分?jǐn)?shù)不懲罰。

問(wèn)題2:RLayer Normalization 和 Batch Normalization的區(qū)別,padding對(duì)這兩者有影響嗎,對(duì)哪一維有影響。

Batch Normalization 是對(duì)這批樣本的同一維度特征做歸一化, Layer Normalization 是對(duì)這單個(gè)樣本的所有維度特征做歸一化。

區(qū)別:LN中同層神經(jīng)元輸入擁有相同的均值和方差,不同的輸入樣本有不同的均值和方差;

BN中則針對(duì)不同神經(jīng)元輸入計(jì)算均值和方差,同一個(gè)batch中的輸入擁有相同的均值和方差。

所以,LN不依賴于batch的大小和輸入sequence的長(zhǎng)度,因此可以用于batchsize為1和RNN中sequence的normalize操作。

padding會(huì)對(duì)Batch Normalization的seq_len這個(gè)維度有影響,計(jì)算的時(shí)候會(huì)把padding也算進(jìn)去。

問(wèn)題3:pytorch.Dataloader 報(bào)錯(cuò)出現(xiàn)數(shù)據(jù)維度不一樣怎么解決。

在構(gòu)建dataset重寫(xiě)的__getitem__方法中要返回相同長(zhǎng)度的tensor。

可以使用向量補(bǔ)全的方法來(lái)解決這個(gè)問(wèn)題,把不同長(zhǎng)度的向量補(bǔ)全成等長(zhǎng)的。

問(wèn)題4:無(wú)序數(shù)組,找topK,要求比快排快。

解題思路:堆排序,復(fù)雜度 nlogk

1.取列表前k個(gè)元素建??個(gè)?根堆。堆頂就是?前第k?的數(shù)。

2. 依次向后遍歷原列表,對(duì)于列表中的元素,如果?于堆頂,則忽略該元素;如果?于堆頂,則將堆頂更換為該元素,并且對(duì)堆進(jìn)??次調(diào)整;

3.遍歷列表所有元素后,倒序彈出堆頂。

問(wèn)題5:Bert里面mask的用處。

預(yù)訓(xùn)練的時(shí)候在句子編碼的時(shí)候?qū)?/span>部分詞mask,這個(gè)主要作用是用被mask詞前后的詞來(lái)去猜測(cè)mask掉的詞是什么,因?yàn)槭侨藶閙ask掉的,所以計(jì)算機(jī)是知道m(xù)ask詞的正確值,所以也可以判斷模型猜的詞是否準(zhǔn)確。進(jìn)而更好地提升Bert詞向量的雙向編碼能力。

問(wèn)題6:對(duì)于兩個(gè)詞怎么算他們的相似度,用基于word embedding的方式。

歐氏距離、曼哈頓距離、馬氏距離、余弦距離、漢明距離等等。

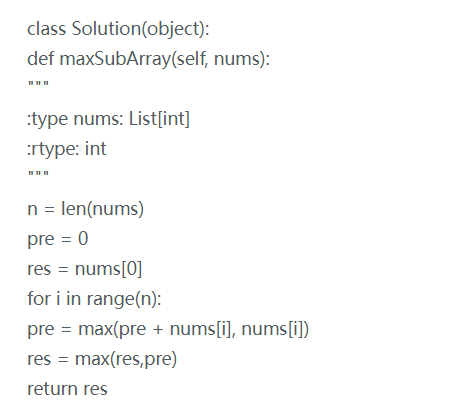

問(wèn)題7:Leetcode—最大子序列和。

— 推薦閱讀 — 最新大廠面試題

學(xué)員最新面經(jīng)分享

CV | 大齡非科班留學(xué)碼農(nóng):如何在美國(guó)當(dāng)?shù)啬玫紺V算法80萬(wàn)offer

NLP | 非科班出身4年數(shù)據(jù)分析崗:通過(guò)NLP6轉(zhuǎn)NLP最終拿到年薪50萬(wàn)+offer!

七月內(nèi)推崗位

AI開(kāi)源項(xiàng)目論文

NLP ( 自然語(yǔ)言處理 )

CV(計(jì)算機(jī)視覺(jué))

推薦