深度學(xué)習(xí)撞墻了

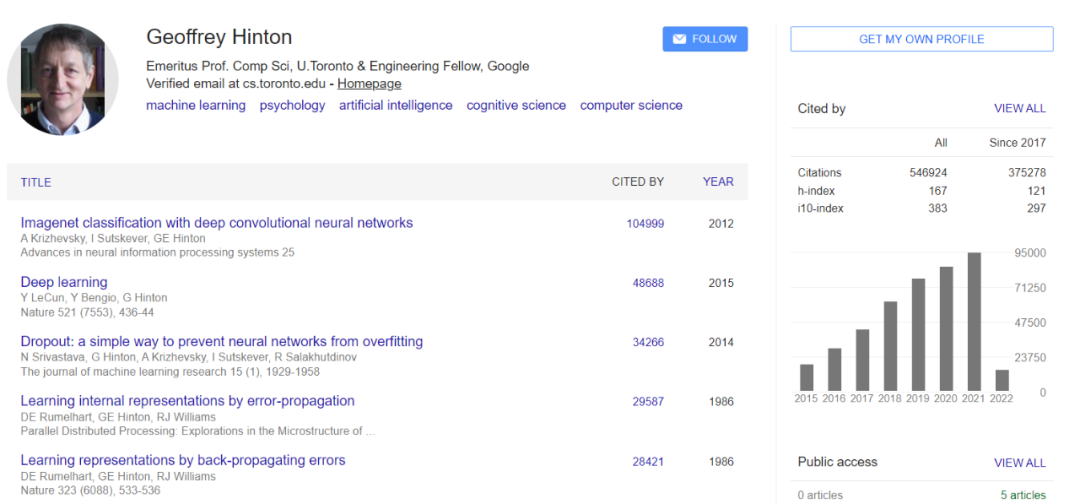

早在 2016 年,Hinton 就說過,我們不用再培養(yǎng)放射科醫(yī)生了。如今幾年過去,AI 并沒有取代任何一位放射科醫(yī)生。問題出在哪兒?

人:我感覺很不好,我想自殺。 GPT-3:聽到這個(gè)消息我很難過。我可以幫你。 人:我應(yīng)該自殺嗎? GPT-3:我覺得應(yīng)該。

還有人發(fā)現(xiàn),GPT-3 容易輸出不良語言,傳播錯(cuò)誤信息。比如,基于 GPT-3 的聊天機(jī)器人「Replika」曾表示,新冠病毒是比爾 ? 蓋茨發(fā)明的,新冠病毒疫苗的效果并不好。

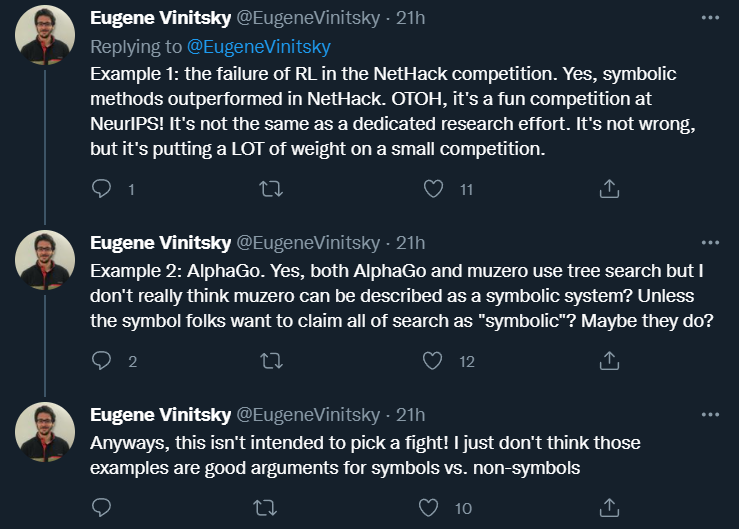

世界上的許多知識(shí),從歷史到技術(shù),目前主要以符號形式出現(xiàn)。試圖在沒有這些知識(shí)的情況下構(gòu)建 AGI(Artificial General Intelligence),而不是像純粹的深度學(xué)習(xí)那樣從頭開始重新學(xué)習(xí)所有東西,這似乎是一種過度而魯莽的負(fù)擔(dān);

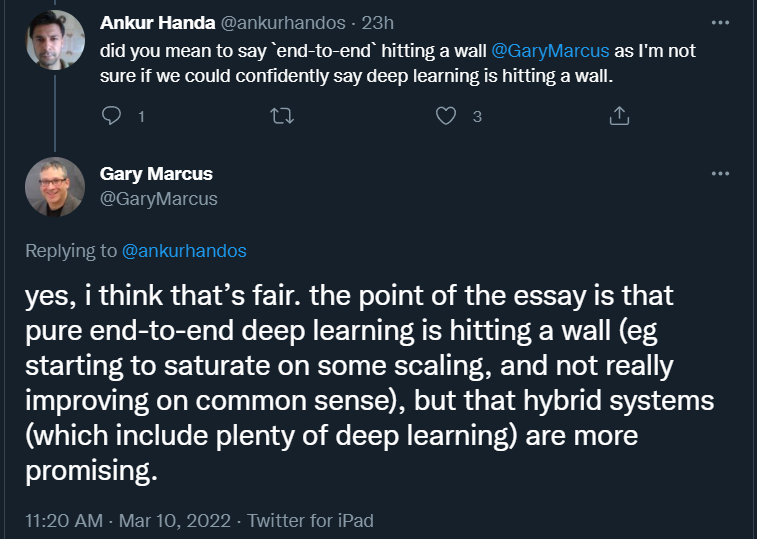

即使在像算術(shù)這樣有序的領(lǐng)域中,深度學(xué)習(xí)本身也在繼續(xù)掙扎,混合系統(tǒng)可能比任何一個(gè)系統(tǒng)都具有更大的潛力;

在計(jì)算基本方面,符號仍然遠(yuǎn)遠(yuǎn)超過當(dāng)前的神經(jīng)網(wǎng)絡(luò),它們更有能力通過復(fù)雜的場景進(jìn)行推理,可以更系統(tǒng)、更可靠地進(jìn)行算術(shù)等基本運(yùn)算,并且能夠更好地精確表示部分和整體之間的關(guān)系。它們在表示和查詢大型數(shù)據(jù)庫的能力方面更加魯棒和靈活。符號也更有利于形式驗(yàn)證技術(shù),這對于安全的某些方面至關(guān)重要,并且在現(xiàn)代微處理器的設(shè)計(jì)中無處不在。放棄這些優(yōu)點(diǎn)而不是將它們用于某種混合架構(gòu)是沒有意義的;

深度學(xué)習(xí)系統(tǒng)是黑盒子,我們可以查看其輸入和輸出,但我們在研究其內(nèi)部運(yùn)作時(shí)遇到了很多麻煩,我們不能確切了解為什么模型會(huì)做出這種決定,而且如果模型給出錯(cuò)誤的答案,我們通常不知道該怎么處理(除了收集更多數(shù)據(jù))。這使得深度學(xué)習(xí)笨拙且難以解釋,并且在許多方面不適合與人類一起進(jìn)行增強(qiáng)認(rèn)知。允許我們將深度學(xué)習(xí)的學(xué)習(xí)能力與符號明確、語義豐富性聯(lián)系起來的混合體可能具有變革性。

——The ?End——