PyTorch模型量化工具學(xué)習(xí)

極市導(dǎo)讀

?通過(guò)減少原始模型參數(shù)的數(shù)量或比特?cái)?shù),模型量化技術(shù)能降低深度學(xué)習(xí)對(duì)內(nèi)存和計(jì)算的需求。本文主要介紹了這種量化技術(shù)的方法、流程和工具,并預(yù)測(cè)了數(shù)個(gè)有潛力的研究方向。

應(yīng)用范圍

weight的8 bit量化 :data_type = qint8,數(shù)據(jù)范圍為[-128, 127] activation的8 bit量化:data_type = quint8,數(shù)據(jù)范圍為[0, 255]

具有 AVX2 支持或更高版本的 x86 CPU:fbgemm ARM CPU:qnnpack

q_backend = "qnnpack" # qnnpack or fbgemmtorch.backends.quantized.engine = q_backendqconfig = torch.quantization.get_default_qconfig(q_backend)

QConfig(activation=functools.partial(, reduce_range=False), weight=functools.partial(, dtype=torch.qint8, qscheme=torch.per_tensor_symmetric))

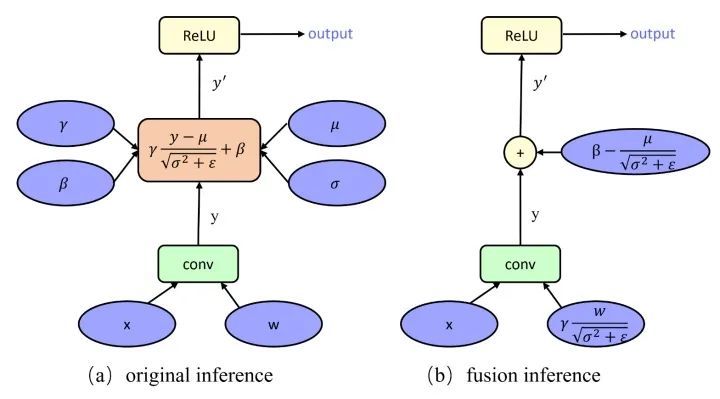

量化方法

量化流程

量化工具

Quantization-Aware Training相關(guān)模塊

總結(jié)

推薦閱讀

評(píng)論

圖片

表情