深度學(xué)習(xí)論文精讀[8]:ParseNet

U形的編解碼結(jié)構(gòu)奠定了深度學(xué)習(xí)語(yǔ)義分割的基礎(chǔ),隨著基線(xiàn)模型的表現(xiàn)越來(lái)越好,深度學(xué)習(xí)語(yǔ)義分割關(guān)注的焦點(diǎn)開(kāi)始由原先的編解碼架構(gòu)下上采樣如何更好的恢復(fù)圖像像素轉(zhuǎn)變?yōu)槿绾胃佑行У睦脠D像上下文信息和提取多尺度特征。因而催生出語(yǔ)義分割的第二個(gè)主流的結(jié)構(gòu)設(shè)計(jì):多尺度結(jié)構(gòu)。接下來(lái)的幾篇論文解讀將對(duì)重在關(guān)注圖像上下文信息和多尺度特征的結(jié)構(gòu)設(shè)計(jì)網(wǎng)絡(luò)進(jìn)行梳理,包括ParseNet、PSPNet、以空洞卷積為核心的Deeplab系列、HRNet以及其他代表性的多尺度設(shè)計(jì)。

自從全卷積網(wǎng)絡(luò)(Fully Convolutional Networks, FCN)和UNet提出以來(lái),主流的改進(jìn)思路是圍繞著編解碼結(jié)構(gòu)來(lái)進(jìn)行的。但又一些改進(jìn)在當(dāng)時(shí)看來(lái)卻不是那么“主流”,其中有一些是針對(duì)如何提升網(wǎng)絡(luò)的全局信息提取能力來(lái)進(jìn)行改進(jìn)的。FCN提出之后,一些學(xué)者認(rèn)為FCN忽略了圖像作為整張圖的全局信息,因而在一些應(yīng)用場(chǎng)景下不能有效利用圖像的語(yǔ)義上下文信息。圖像全局信息除了增加對(duì)圖像的整體理解之外,還有助于模型對(duì)局部圖像塊的判斷,此前一種主流的方法是將概率圖模型融入到CNN訓(xùn)練中,用于捕捉圖像像素的上下文信息,比如說(shuō)給模型加條件隨機(jī)場(chǎng)(Conditional Random Field,CRF),但這種方式會(huì)使得模型難以訓(xùn)練并且變得低效。

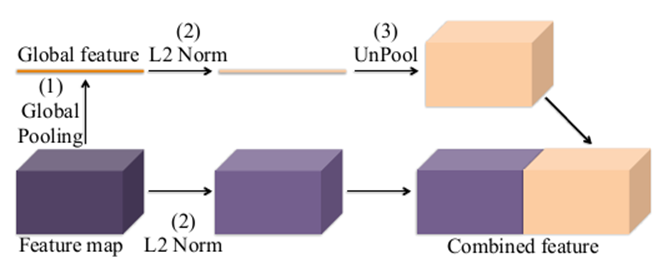

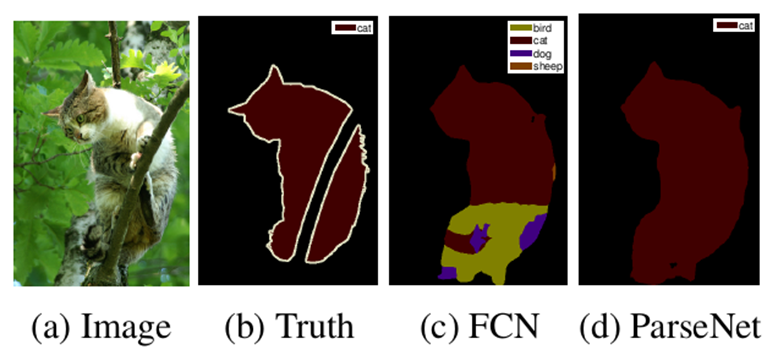

針對(duì)如何高效利用圖像的全局信息問(wèn)題,相關(guān)研究在FCN結(jié)構(gòu)的基礎(chǔ)上提出了ParseNet,一種高效的端到端的語(yǔ)義分割網(wǎng)絡(luò),旨在利用全局信息來(lái)指導(dǎo)局部信息判斷,并且引入太多的額外計(jì)算開(kāi)銷(xiāo)。提出ParseNet的論文為ParseNet: Looking Wider to See Better,發(fā)表于2015年,是在FCN基礎(chǔ)上基于上下文視角的一個(gè)改進(jìn)設(shè)計(jì)。在語(yǔ)義分割中,上下文信息對(duì)于提升模型表現(xiàn)非常關(guān)鍵,在僅有局部信息情況下,像素的分類(lèi)判斷有時(shí)候會(huì)變得模棱兩可。盡管理論上深層卷積層的會(huì)有非常大的感受野,但在實(shí)際中有效感受野卻小很多,不足以捕捉圖像的全局信息。ParseNet通過(guò)全局平均池化的方法在FCN基礎(chǔ)上直接獲取上下文信息,圖1為ParseNet的上下文提取模塊,具體地,使用全局平均池化對(duì)上下文特征圖進(jìn)行池化后得到全局特征,然后對(duì)全局特征進(jìn)行L2規(guī)范化處理,再對(duì)規(guī)范化后的特征圖反池化后與局部特征圖進(jìn)行融合,這樣的一個(gè)簡(jiǎn)單結(jié)構(gòu)對(duì)于語(yǔ)義分割質(zhì)量的提升的巨大的。如圖2所示,ParseNet能夠關(guān)注到圖像中的全局信息,保證圖像分割的完整性。

關(guān)于全局特征與局部特征的融合,ParseNet給出兩種融合方式:早期融合(early fusion)和晚期融合(late fusion)。早期融合就是圖6-1中所展現(xiàn)的融合方式,對(duì)全局特征反池化后直接與局部特征進(jìn)行融合,然后在進(jìn)行像素分類(lèi)。而晚期融合則是把全局特征和局部特征分別進(jìn)行像素分類(lèi)后再進(jìn)行某種融合,比如說(shuō)進(jìn)行加權(quán)。但無(wú)論是早期融合還是晚期融合,如果選取的歸一化方式合適,其效果是差不多的。

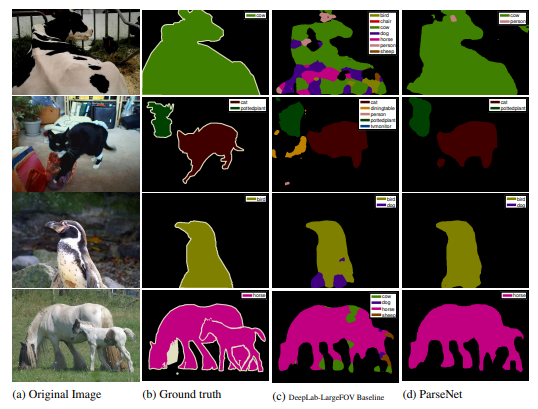

下圖是ParseNet在VOC 2012數(shù)據(jù)集上的分割效果,可以看到,ParseNet的分割能夠明顯關(guān)注到圖像全局信息。

ParseNet作者基于caffe的源碼可參考:

https://github.com/weiliu89/caffe

往期精彩:

深度學(xué)習(xí)論文精讀[5]:Attention UNet

深度學(xué)習(xí)論文精讀[4]:RefineNet

深度學(xué)習(xí)論文精讀[2]:UNet網(wǎng)絡(luò)

深度學(xué)習(xí)論文精讀[1]:FCN全卷積網(wǎng)絡(luò)

講解視頻來(lái)了!機(jī)器學(xué)習(xí) 公式推導(dǎo)與代碼實(shí)現(xiàn)開(kāi)錄!

完結(jié)!《機(jī)器學(xué)習(xí) 公式推導(dǎo)與代碼實(shí)現(xiàn)》全書(shū)1-26章PPT下載