深度學(xué)習(xí)領(lǐng)域,最驚艷的論文!

點(diǎn)擊關(guān)注公眾號(hào),干貨及時(shí)送達(dá)

提名一

ResNet和Transformer

提名二

DUT(視頻增穩(wěn))

作者:rainy

來(lái)分享一篇小眾方向(視頻增穩(wěn)/Video Stabilization)的論文,可能不是那種推動(dòng)領(lǐng)域進(jìn)步的爆炸性工作,這篇論文我認(rèn)為是一篇比較不錯(cuò)的把傳統(tǒng)方法deep化的工作。

DUT: Learning Video Stabilization by Simply Watching Unstable Videos

https://arxiv.org/pdf/2011.14574.pdf

看樣子應(yīng)該是投稿CVPR21,已開源。

https://github.com/Annbless/DUTCode

首先介紹一下視頻增穩(wěn)的定義,如名稱所示,視頻增穩(wěn)即為輸入一系列連續(xù)的,非平穩(wěn)(抖動(dòng)較大)的視頻幀,輸出一系列連續(xù)的,平穩(wěn)的視頻幀。

由于方向有點(diǎn)略微小眾,因此該領(lǐng)域之前的工作(基于深度學(xué)習(xí))可以簡(jiǎn)單分為基于GAN的直接生成,基于光流的warp,基于插幀(其實(shí)也是基于光流的warp)這么幾類。這些論文將視頻增穩(wěn)看做了“視頻幀生成問(wèn)題”,但是理想的視頻增穩(wěn)工作應(yīng)該看做“軌跡平滑”問(wèn)題更為合適。

而在深度學(xué)習(xí)之前劉帥成(http://www.liushuaicheng.org/)大神做了一系列的視頻增穩(wěn)的工作,其中work的即為meshflow。這里貼一個(gè)meshflow解讀的鏈接

https://www.yuque.com/u452427/ling/qs0inc

總結(jié)一下,meshflow主要的流程為“估計(jì)光流-->估計(jì)關(guān)鍵點(diǎn)并篩選出關(guān)鍵點(diǎn)的光流-->基于關(guān)鍵點(diǎn)光流得到mesh中每一個(gè)格點(diǎn)的motion/軌跡-->進(jìn)行軌跡平滑并得到平滑后的軌跡/每一個(gè)格點(diǎn)的motion-->基于motion得到滿足平滑軌跡的視頻幀”。

總結(jié)了meshflow之后,這篇DUT主要進(jìn)行的工作其實(shí)很簡(jiǎn)單,在meshflow的框架下,將其中所有的模塊都deep化:

LK光流---->PWCNet

SIFT關(guān)鍵點(diǎn)----->RFNet

基于Median Filters的軌跡平滑------>可學(xué)習(xí)的1D卷積

除此之外,由于原始的meshflow是基于優(yōu)化的方法,因此DUT在替換了模塊之后依舊保留了原始的約束項(xiàng),并且可以使用無(wú)監(jiān)督的方式完成訓(xùn)練,效果也好于一票supervised的方法。

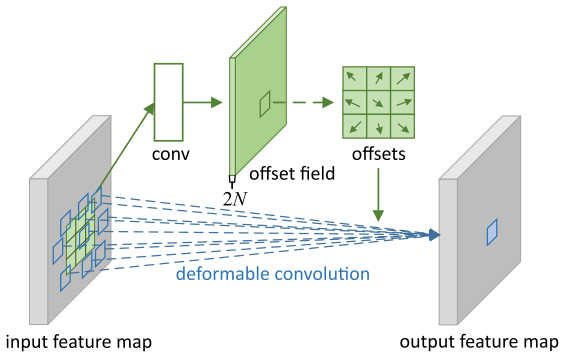

提名三

可形變卷積(DCN)

提名四

深度學(xué)習(xí)框架、圖像識(shí)別、圖像生成、模型優(yōu)化 、自然語(yǔ)言處理

深度學(xué)習(xí)框架

論文名稱:Caffe: Convolutional Architecture for Fast Feature Embedding

論文鏈接:https://arxiv.org/abs/1408.5093

驚艷理由:在那個(gè)大家都用matlab和自己diy深度學(xué)習(xí)框架的年代,賈大神的Caffe橫空出世,為深度學(xué)習(xí)領(lǐng)域創(chuàng)立了一個(gè)通用、易拓展的框架,使復(fù)現(xiàn)、開發(fā)各種新型算法變得更加容易,可以說(shuō)是開山鼻祖。

對(duì)標(biāo)武功:《天龍八部》內(nèi)的易筋經(jīng)。易筋鍛骨,重塑七經(jīng),這不正和caffe的效用不謀而合?caffe不就相當(dāng)于重塑了深度學(xué)習(xí)的筋骨,使得后續(xù)各種五花八門的算法變得可能實(shí)現(xiàn)?

圖像識(shí)別

論文名稱:Deep Residual Learning for Image Recognition

論文鏈接:https://arxiv.org/pdf/1512.03385.pdf

驚艷理由:一個(gè)簡(jiǎn)簡(jiǎn)單單的skip connection一招制敵,優(yōu)雅至極,直接將CNN的表現(xiàn)提升了一個(gè)大檔次。

對(duì)標(biāo)武功:《天涯明月刀》里傅紅雪的刀法。傅紅雪的武功就一招——拔刀收刀,簡(jiǎn)單卻致命,正如resnet的skip connection. 這一刀是傅紅雪拔了千萬(wàn)次刀后凝練的精魂,正與skip connection是作者做了無(wú)數(shù)實(shí)驗(yàn)與分析后凝練的結(jié)構(gòu)如出一轍。

圖像生成

論文名稱:Generative Adversarial Networks

論文鏈接:https://arxiv.org/abs/1406.2661

驚艷理由:Encoder-decoder 出現(xiàn)已久, 分類器出現(xiàn)也很久,Goodfellow卻是真正意義上把這二者完美結(jié)合起來(lái)的第一人,是現(xiàn)如今圖像視頻模擬生成的鼻祖。

對(duì)標(biāo)武功:《射雕英雄傳》里的左右互博。老頑童讓左手和右手打架,結(jié)果兩只手突飛猛進(jìn),Goodfellow 讓generator 和discriminator 互相打架,結(jié)果兩個(gè)模型變得越來(lái)越強(qiáng),最后甚至可以以假亂真。

模型優(yōu)化

論文名稱:Distilling the Knowledge in a Neural Network

論文鏈接:https://arxiv.org/pdf/1503.02531.pdf

驚艷理由: ?知識(shí)蒸餾的開山之作,在不增加任何online inference資源的情況下,讓模型得到極大優(yōu)化。

對(duì)標(biāo)武功:《天龍八部》里的北冥神功。段譽(yù)吸各個(gè)高手的內(nèi)功變成了天龍三絕之一,student net吸取teacher net的知識(shí)變成了更robust的模型。

自然語(yǔ)言處理

論文名稱:Language Models are Few-Shot Learners(GPT-3)

論文鏈接:https://arxiv.org/pdf/2005.14165.pdf

驚艷理由:在看到這篇論文之前,我做夢(mèng)也想不到一個(gè)NLP模型居然有175億個(gè)參數(shù),可以說(shuō)是深度學(xué)習(xí)里的暴力美學(xué)的極致了。

對(duì)標(biāo)武功:降龍十八掌。降龍十八掌剛猛無(wú)雙,遇到強(qiáng)敵以剛勁的掌力與無(wú)所畏懼的氣勢(shì)壓倒對(duì)方。GPT-3龐大無(wú)比,遇到語(yǔ)言數(shù)據(jù)以175億的模型參數(shù)與超出想象的計(jì)算資源死磕硬剛。如果喬峰是個(gè)深度學(xué)習(xí)科學(xué)家,一定會(huì)愛(ài)死這個(gè)模型。

提名五

CAM,class activation map

作者:Ferenas

那就從我的研究領(lǐng)域中挑一個(gè)出來(lái)吧,我的研究方向是基于image-level的弱監(jiān)督語(yǔ)義分割,(貌似這個(gè)點(diǎn)近兩年趨勢(shì)漸淡),而其中令我最驚艷的就是CAM,class activation map

文章題目叫Learning Deep Features for Discriminative Localization,google百度一下都可以找到。這篇文章其實(shí)是想探究我們的CNN在學(xué)習(xí)圖像的時(shí)候到底重點(diǎn)關(guān)注在哪個(gè)部分。這里拋開論文里面的繁瑣的數(shù)學(xué)解釋啥的(大家可以看看原論文),最后論文用一張圖表示了這個(gè)大概是怎么樣的一個(gè)過(guò)程。

對(duì)你沒(méi)有看錯(cuò),圖像關(guān)注的部分就是將該類的fc層中的權(quán)重和feature maps對(duì)應(yīng)加權(quán)求和就行了。說(shuō)實(shí)話我覺(jué)得這個(gè)真的是經(jīng)過(guò)很多實(shí)驗(yàn)才發(fā)現(xiàn)的idea。因此通過(guò)這個(gè)CAM我們便可知這個(gè)網(wǎng)絡(luò)到底在學(xué)什么東西。

至于后面CAM變體例如grad-cam等大家可以去查閱了解。通過(guò)這個(gè)驚艷的CAM,我覺(jué)得是開了基于弱監(jiān)督圖像分割領(lǐng)域的先河,簡(jiǎn)直是祖先級(jí)別的神工作。

為什么這么說(shuō)呢,基于image-level的弱監(jiān)督分割旨在僅通過(guò)分類標(biāo)簽而生成對(duì)應(yīng)的分割標(biāo)簽圖,(畢竟手工標(biāo)記分割圖上的像素太燒錢了呀哈哈哈 )你看看CAM,如果通過(guò)閾值一下的話,那些熱點(diǎn)處的不就可以作為置信度高的前景像素標(biāo)簽了嘛!!!

于是你便可以看到大量的弱監(jiān)督領(lǐng)域分割之作都是在這個(gè)CAM之上完成的。不僅如此,CAM也在可解釋領(lǐng)域中被作為一種基本的工具。這篇五年前的文章至今仍在視覺(jué)領(lǐng)域中放光發(fā)熱,讓很多的學(xué)者以此為基石展開研究。

我也是很感謝這篇工作讓我接觸到弱監(jiān)督領(lǐng)域。畢竟是我轉(zhuǎn)做計(jì)算機(jī)視覺(jué)讀的第一篇文章hhhh,所以,thank you, CAM!

回答1-王晉東不在家:

https://www.zhihu.com/question/440729199/answer/1697212235

回答2-rainy:

https://www.zhihu.com/question/440729199/answer/1693346011

回答3-陀飛輪:

https://www.zhihu.com/question/440729199/answer/1695810150

回答4-葉小飛:

https://www.zhihu.com/question/440729199/answer/1698687630

回答5-Ferenas:

https://www.zhihu.com/question/440729199/answer/1695809572

歡迎圍觀朋友圈

推薦閱讀

(點(diǎn)擊標(biāo)題可跳轉(zhuǎn)閱讀)

機(jī)器學(xué)習(xí)最困難的部分:超參數(shù)調(diào)試

神經(jīng)網(wǎng)絡(luò)之CNN與RNN的關(guān)系

【機(jī)器學(xué)習(xí)基礎(chǔ)】多標(biāo)簽分類的玩法

老鐵,三連支持一下,好嗎?↓↓↓?