吳恩達(dá),新冠陽性

?

?

吳恩達(dá)表示,由于自己已經(jīng)接種了疫苗和加強(qiáng)針,目前的癥狀和與輕度的流感差不多。感謝全世界從事疫苗工作的人們。

大年初一的時(shí)候,他還發(fā)推祝大家虎年快樂。

?

還有不到 3 個(gè)月就要過 46 歲生日了,希望大佬好好休息,早日康復(fù)。

成就一覽

成就一覽

吳恩達(dá)無疑是當(dāng)代人工智能和機(jī)器學(xué)習(xí)領(lǐng)域最權(quán)威的學(xué)者之一,同時(shí)在商業(yè)上也頗有建樹。

?

吳恩達(dá)是斯坦福大學(xué)計(jì)算機(jī)科學(xué)系和電氣工程系的客座教授,曾任斯坦福人工智能實(shí)驗(yàn)室主任。

?

吳恩達(dá)的理想是讓世界上每個(gè)人能夠接受高質(zhì)量的、免費(fèi)的教育。于是便與達(dá)芙妮?科勒?(機(jī)器學(xué)習(xí)界的一姐和大牛,《Probabilistic Graphical Models: Principles and Techniques》的作者)一起創(chuàng)建了在線教育平臺 Coursera。

?

?

吳恩達(dá)于 1976 年出生于英國倫敦。他的父母都是來自香港的移民。在成長過程中,他在香港和新加坡度過了一段時(shí)間,后來于 1992 年從新加坡萊佛士書院畢業(yè)。

?

1997 年,他獲得了賓夕法尼亞州匹茲堡卡尼基美隆大學(xué)班級頂尖的計(jì)算機(jī)科學(xué)、統(tǒng)計(jì)學(xué)和經(jīng)濟(jì)學(xué)三重專業(yè)大學(xué)學(xué)位。1996 年至 1998 年間,他在 AT&T 貝爾實(shí)驗(yàn)室進(jìn)行了強(qiáng)化學(xué)習(xí),模型選擇和特征選擇的研究。

?

1998 年,吳恩達(dá)在馬薩諸塞州劍橋的麻省理工學(xué)院獲得碩士學(xué)位。在麻省理工學(xué)院,他為網(wǎng)絡(luò)上的研究論文建立了第一個(gè)公開可用,自動索引的網(wǎng)絡(luò)搜索引擎(它是 CiteSeer/ResearchIndex 的前身,但專注于機(jī)器學(xué)習(xí))。

?

趣味哏圖:「當(dāng)你看到以下片頭標(biāo)時(shí),就會知道影視產(chǎn)品很棒:20 世紀(jì)佛克斯、派拉蒙、華納兄弟、吳恩達(dá)微笑」

?

2011 年,吳恩達(dá)在谷歌創(chuàng)建了谷歌大腦項(xiàng)目,以通過分布式集群計(jì)算器開發(fā)超大規(guī)模的人工神經(jīng)網(wǎng)絡(luò)。

?

2014 年 5 月 16 日,吳恩達(dá)加入百度,負(fù)責(zé)「百度大腦」計(jì)劃,并擔(dān)任百度公司首席科學(xué)家。2017 年 3 月 20 日,吳恩達(dá)宣布從百度辭職。

?

2017 年 12 月,吳恩達(dá)宣布成立人工智能公司 Landing.ai,擔(dān)任公司的首席執(zhí)行官。

?

趣味哏圖:「AI 的文藝形象是終結(jié)者,真實(shí)形象是吳恩達(dá)公開課」

?

作為教師,他保持一項(xiàng)紀(jì)錄:在 2013-1014 年斯坦福大學(xué)秋季學(xué)期的「機(jī)器學(xué)習(xí)」課程中,這門由吳恩達(dá)主講的課程有超過 800 名學(xué)生選修。這曾是斯坦福歷史上最多人同時(shí)選修的課程。

?

沒有任何教室可以容納,所以很多人都是在家看課堂錄像。不過這門計(jì)算機(jī)專業(yè)的研究生課程比 Coursera 上的同名公開課要難很多,用他自己的話來說就是 “這(和 Coursera 上的相比)可以說是兩門課”。

?

吳教授公開課金句:「聽不懂先不要怕」

?

他在斯坦福公開課與 Coursera 里主講機(jī)器學(xué)習(xí),效果極佳,在業(yè)界和普羅大眾中都非常受歡迎。

趣味哏圖:「女友:你看泰坦尼克都不哭!難以置信!你究竟有沒有感情!你哭過沒有!AI 學(xué)子:有啊,吳恩達(dá)公開課結(jié)尾出手寫感謝字幕的時(shí)候。」

?

吳恩達(dá)在 Coursera 上的機(jī)器學(xué)習(xí)課程,平均得分 4.9 分。Coursera 上的課程評分滿分 5 分,大部分公開課處于 4-4.5 分之間,能做到 4.9 分的課程很少,而這門課程有近五萬人給出評分。按 Freecodecamp 的統(tǒng)計(jì),這是機(jī)器學(xué)習(xí)在線課程中最受歡迎的一門。

?

?

吳恩達(dá)的公開課程中高數(shù)內(nèi)容相對不多,在同類公開課中比較親善大眾。他解釋過原因:「這門課沒有使用過多數(shù)學(xué)的原因就是考慮到其受眾廣泛,因此用直覺式的解釋讓大家有信心繼續(xù)堅(jiān)持學(xué)習(xí)。」

?

趣味哏圖:「吳恩達(dá)公開課,默默為 AI 新丁擋下了微積分、線代、統(tǒng)計(jì)、概率論這些高數(shù)火力,讓學(xué)子們得以安眠。」

?

80% 的數(shù)據(jù) + 20% 的模型 = 更好的機(jī)器學(xué)習(xí)

80% 的數(shù)據(jù) + 20% 的模型 = 更好的機(jī)器學(xué)習(xí)

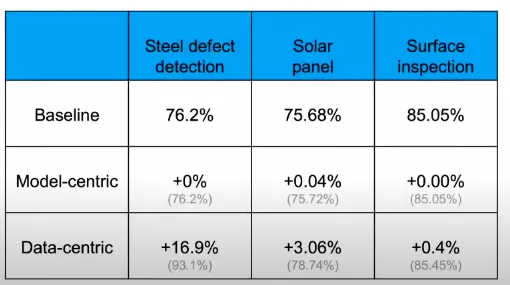

機(jī)器學(xué)習(xí)的進(jìn)步是模型帶來的還是數(shù)據(jù)帶來的,這可能是一個(gè)世紀(jì)辯題。

?

吳恩達(dá)對此的想法是,一個(gè)機(jī)器學(xué)習(xí)團(tuán)隊(duì) 80% 的工作應(yīng)該放在數(shù)據(jù)準(zhǔn)備上,確保數(shù)據(jù)質(zhì)量是最重要的工作。

?

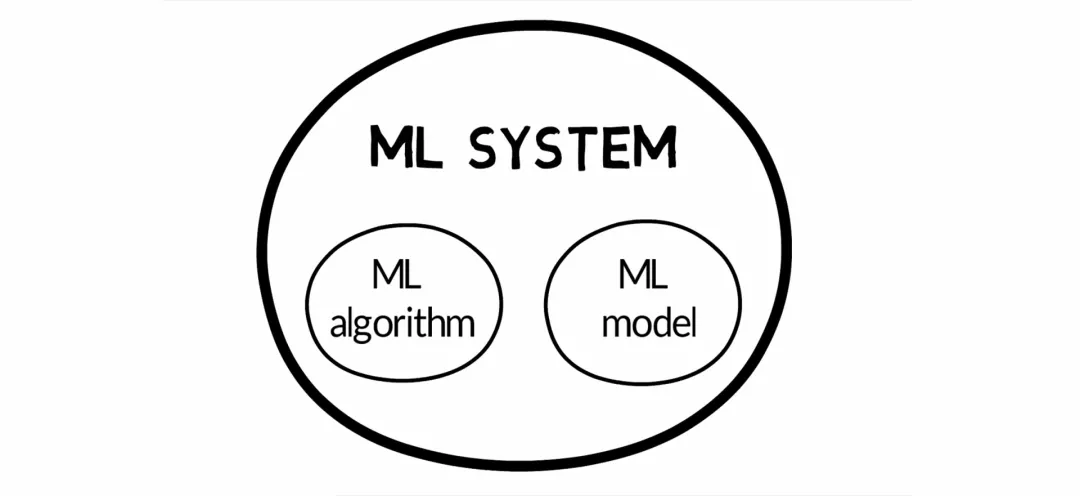

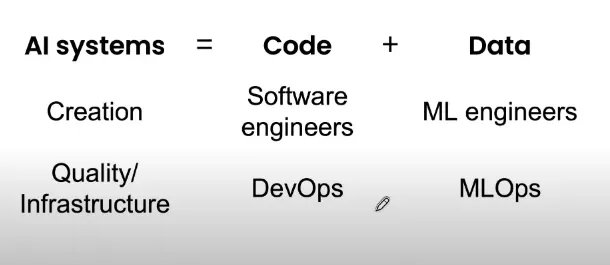

「AI = Data + Code」

?

?

出現(xiàn)問題時(shí),大部分團(tuán)隊(duì)會本能地嘗試改進(jìn)代碼。但是對于許多實(shí)際應(yīng)用而言,集中精力改善數(shù)據(jù)會更有效。

?

吳恩達(dá)認(rèn)為,如果更多地強(qiáng)調(diào)以數(shù)據(jù)為中心而不是以模型為中心,那么機(jī)器學(xué)習(xí)將快速發(fā)展。

?

?

我們都知道 Google 的 BERT,OpenAI 的 GPT-3。但是,這些神奇的模型僅解決了業(yè)務(wù)問題的 20%。而剩下 80% 就是數(shù)據(jù)的質(zhì)量。

?

?

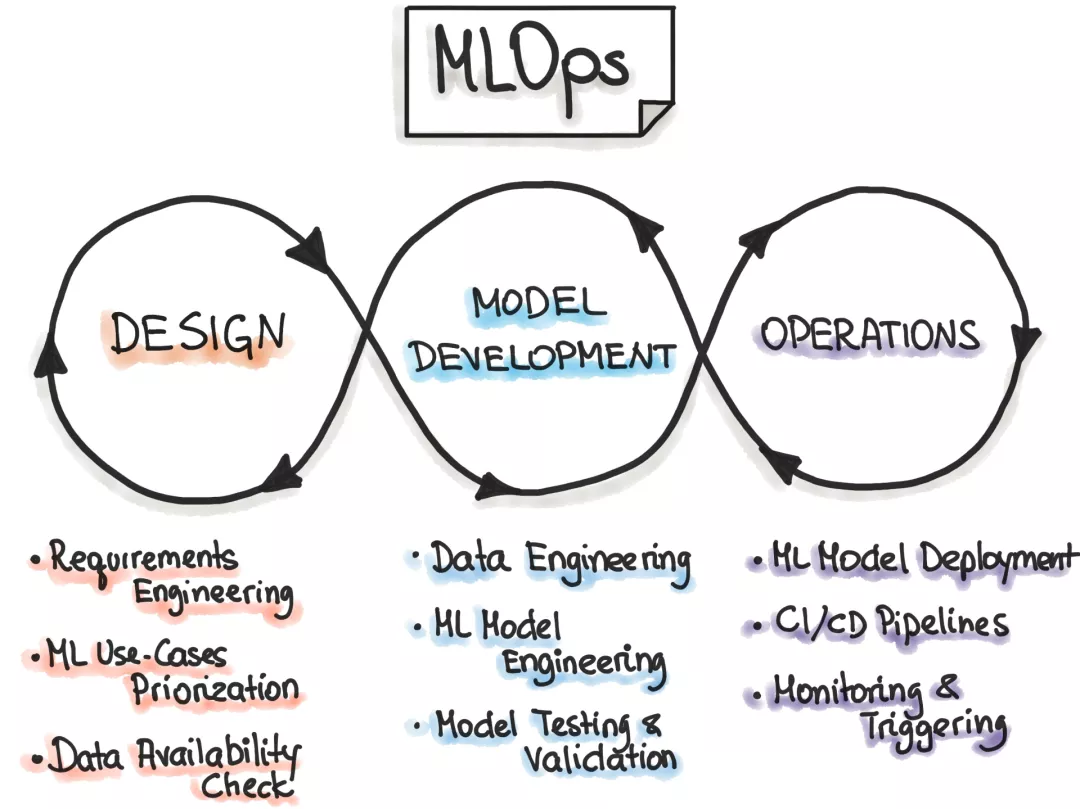

MLOps 是什么?

MLOps 是什么?

?

MLOps,即 Machine Learning 和 Operations 的組合,是 ModelOps 的子集。

?

它是數(shù)據(jù)科學(xué)家與操作專業(yè)人員之間進(jìn)行協(xié)作和交流以幫助管理機(jī)器學(xué)習(xí)任務(wù)生命周期的一種實(shí)踐。

?

?

與 DevOps 或 DataOps 方法類似,MLOps 希望提高自動化程度并提高生產(chǎn) ML 的質(zhì)量,同時(shí)還要關(guān)注業(yè)務(wù)和法規(guī)要求。

?

比如在缺少數(shù)據(jù)的應(yīng)用場景中進(jìn)行部署 AI 時(shí),例如農(nóng)業(yè)場景,你不能指望自己有一百萬臺拖拉機(jī)為自己收集數(shù)據(jù)。

?

基于 MLOps,吳恩達(dá)也提出幾點(diǎn)建議:

?

MLOps 的最重要任務(wù)是提供高質(zhì)量數(shù)據(jù)。 標(biāo)簽的一致性也很重要。檢驗(yàn)標(biāo)簽是否有自己所管轄的明確界限,即使標(biāo)簽的定義是好的,缺乏一致性也會導(dǎo)致模型效果不佳。 系統(tǒng)地改善 baseline 模型上的數(shù)據(jù)質(zhì)量要比追求具有低質(zhì)量數(shù)據(jù)的最新模型要好。 如果訓(xùn)練期間出現(xiàn)錯(cuò)誤,那么應(yīng)當(dāng)采取以數(shù)據(jù)為中心的方法。 如果以數(shù)據(jù)為中心,對于較小的數(shù)據(jù)集(<10,000 個(gè)樣本),則數(shù)據(jù)容量上存在很大的改進(jìn)空間。 當(dāng)使用較小的數(shù)據(jù)集時(shí),提高數(shù)據(jù)質(zhì)量的工具和服務(wù)至關(guān)重要。

參考資料:

https://twitter.com/AndrewYNg/status/1490808144267673601