來(lái)!一起捋一捋機(jī)器學(xué)習(xí)分類(lèi)算法

KNN算法的優(yōu)缺點(diǎn)是什么?

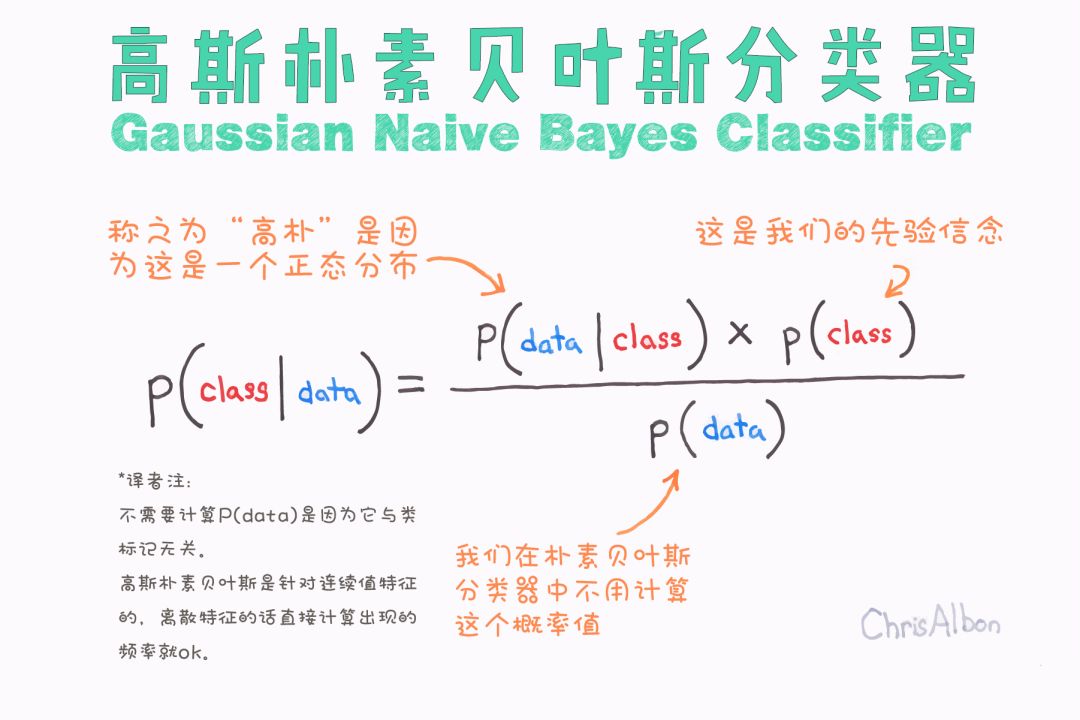

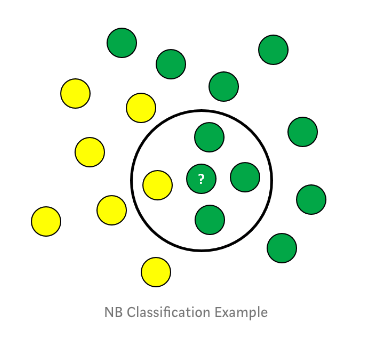

Naive Bayes算法的基本假設(shè)是什么?

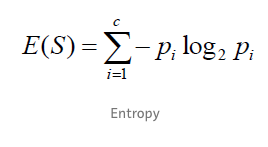

entropy loss是如何定義的?

最后,分類(lèi)算法調(diào)參常用的圖像又有哪些?

機(jī)器學(xué)習(xí)是使計(jì)算機(jī)無(wú)需顯式編程就能學(xué)習(xí)的研究領(lǐng)域。 ——阿瑟·塞繆爾,1959年

“如果一個(gè)程序在使用既有的經(jīng)驗(yàn)(E)執(zhí)行某類(lèi)任務(wù)(T)的過(guò)程中被認(rèn)為是“具備學(xué)習(xí)能力的”,那么它一定需要展現(xiàn)出:利用現(xiàn)有的經(jīng)驗(yàn)(E),不斷改善其完成既定任務(wù)(T)的性能(P)的特性。” ——Tom Mitchell, 1997

https://builtin.com/data-science/introduction-to-machine-learning

監(jiān)督學(xué)習(xí)

https://builtin.com/data-science/tour-top-10-algorithms-machine-learning-newbies

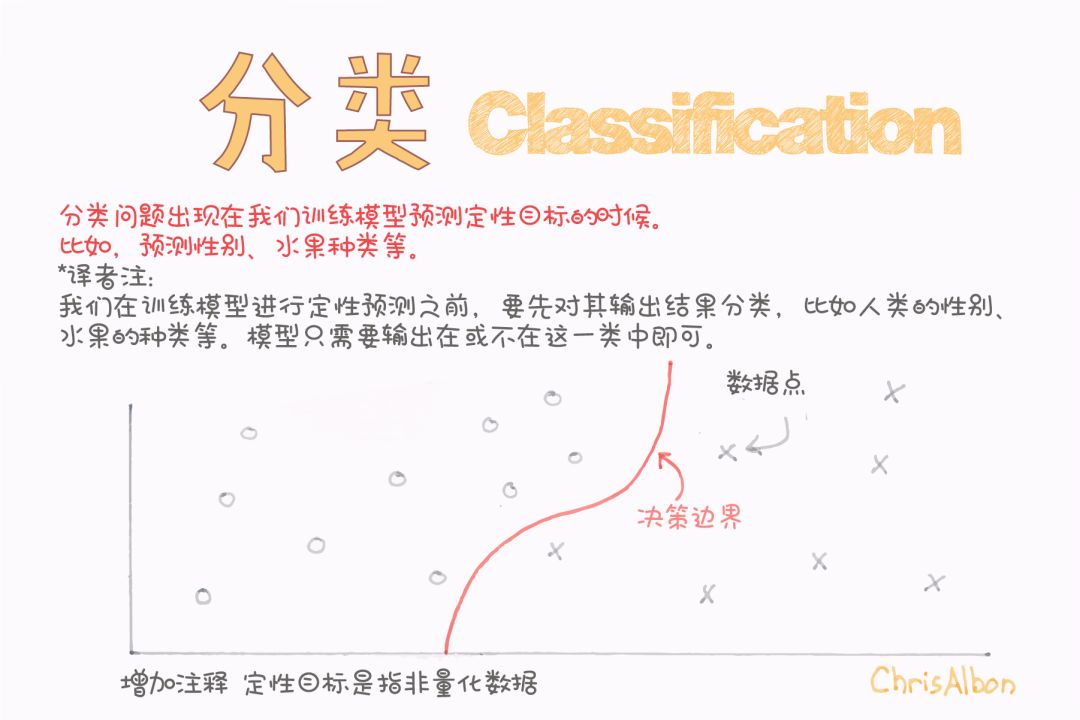

分類(lèi)問(wèn)題

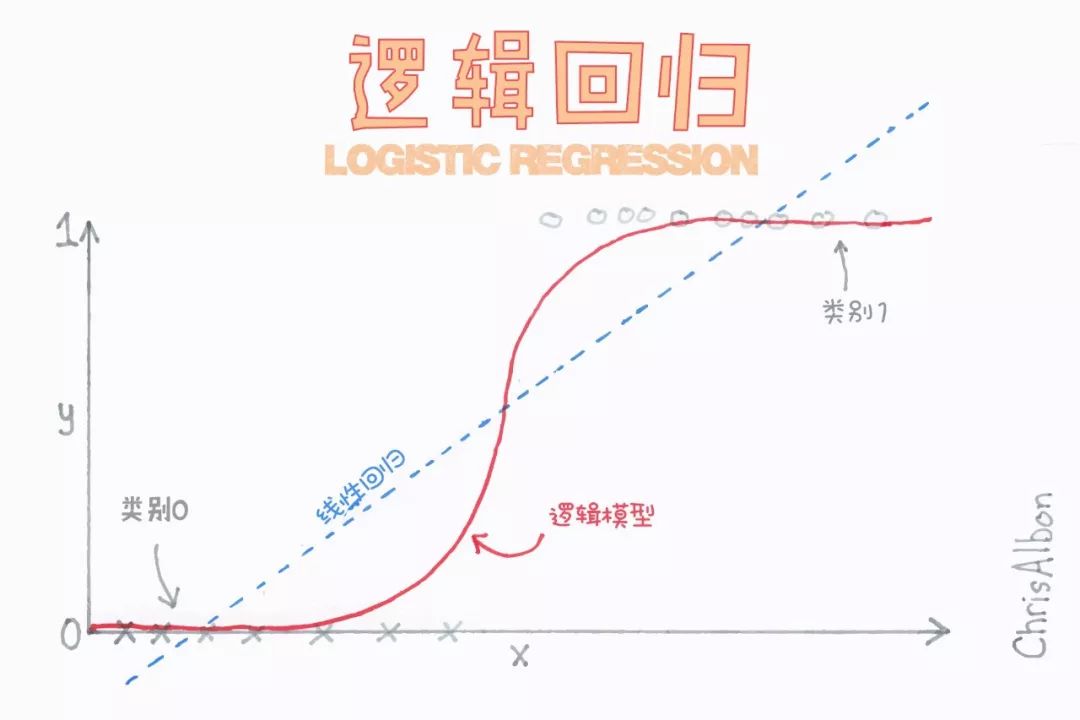

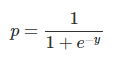

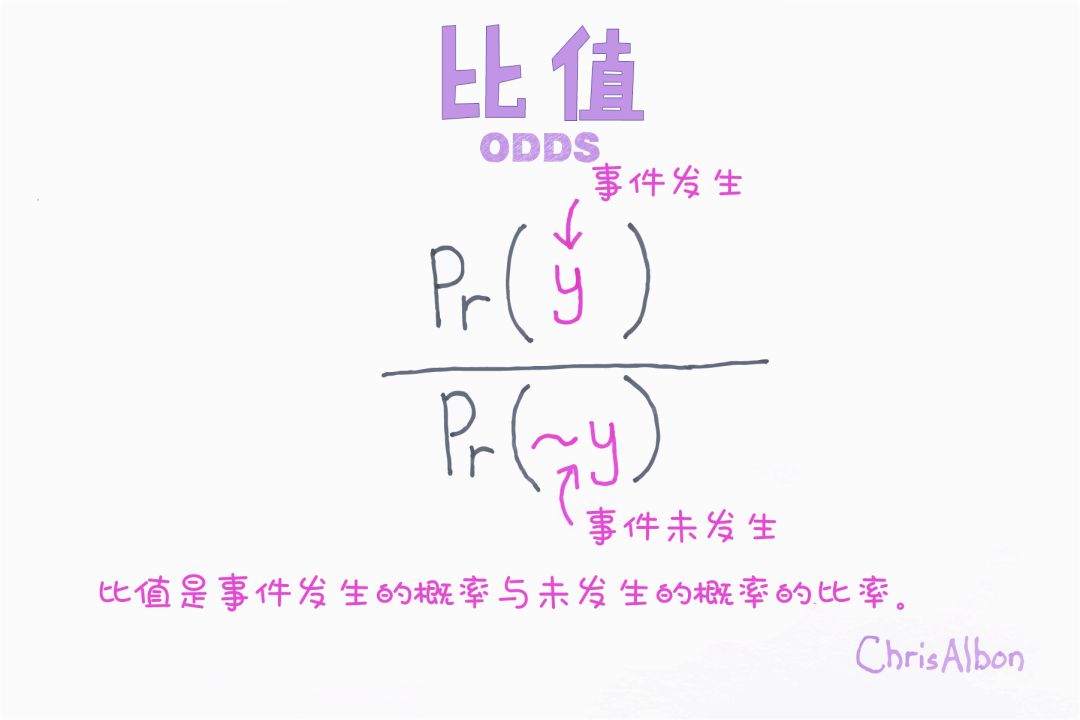

邏輯回歸

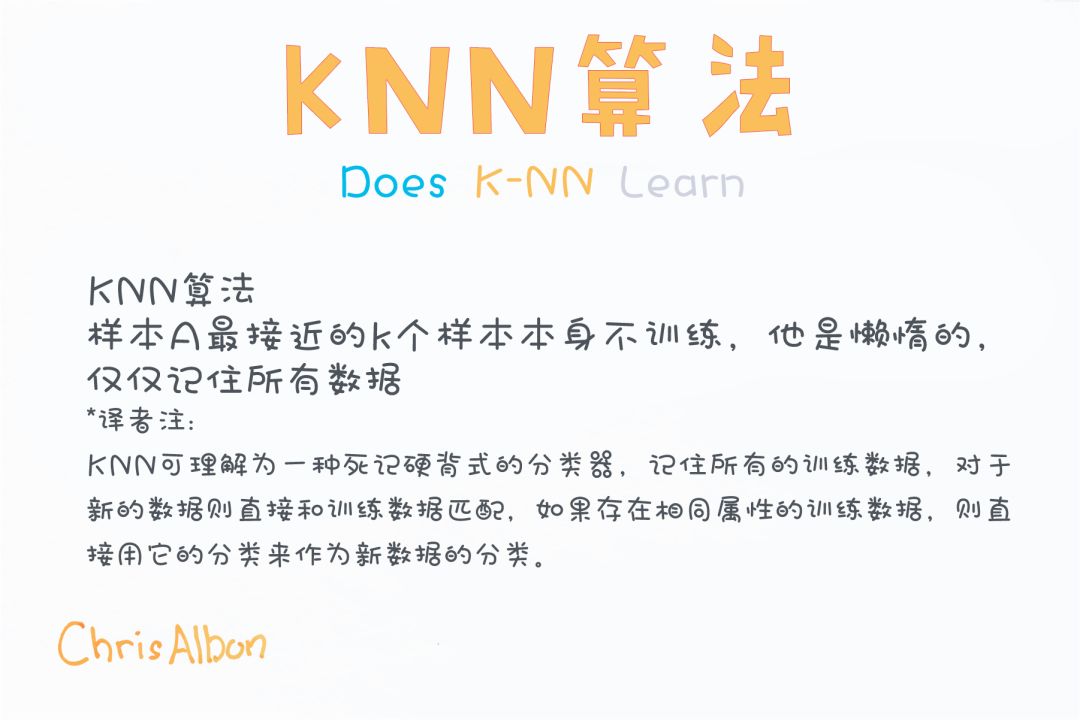

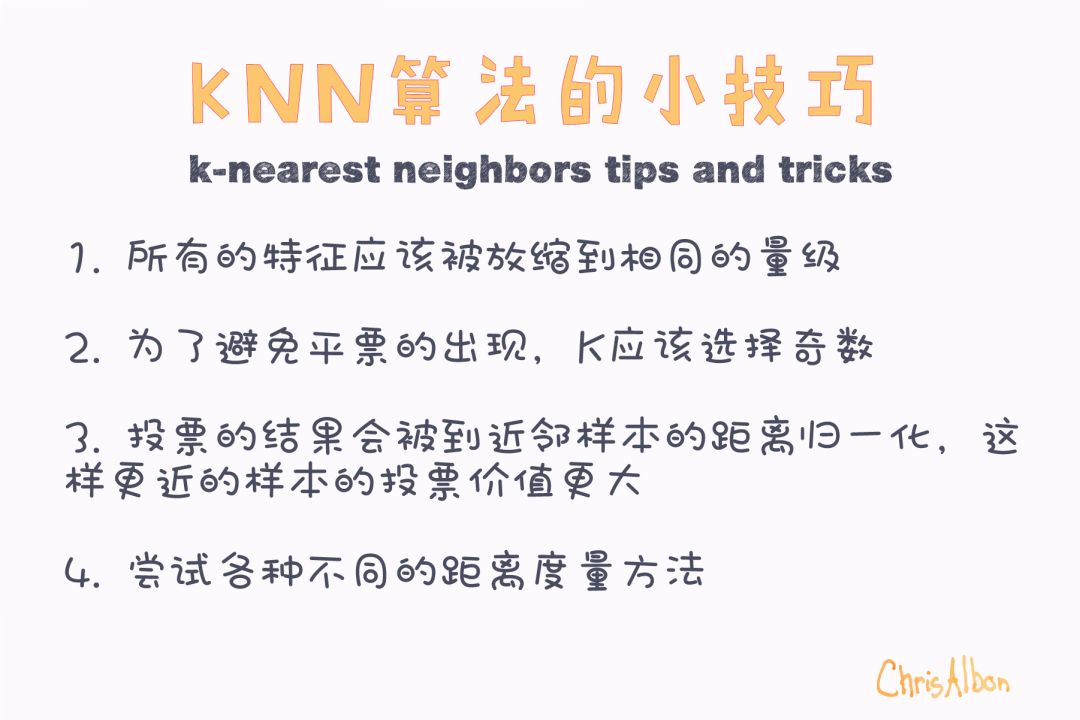

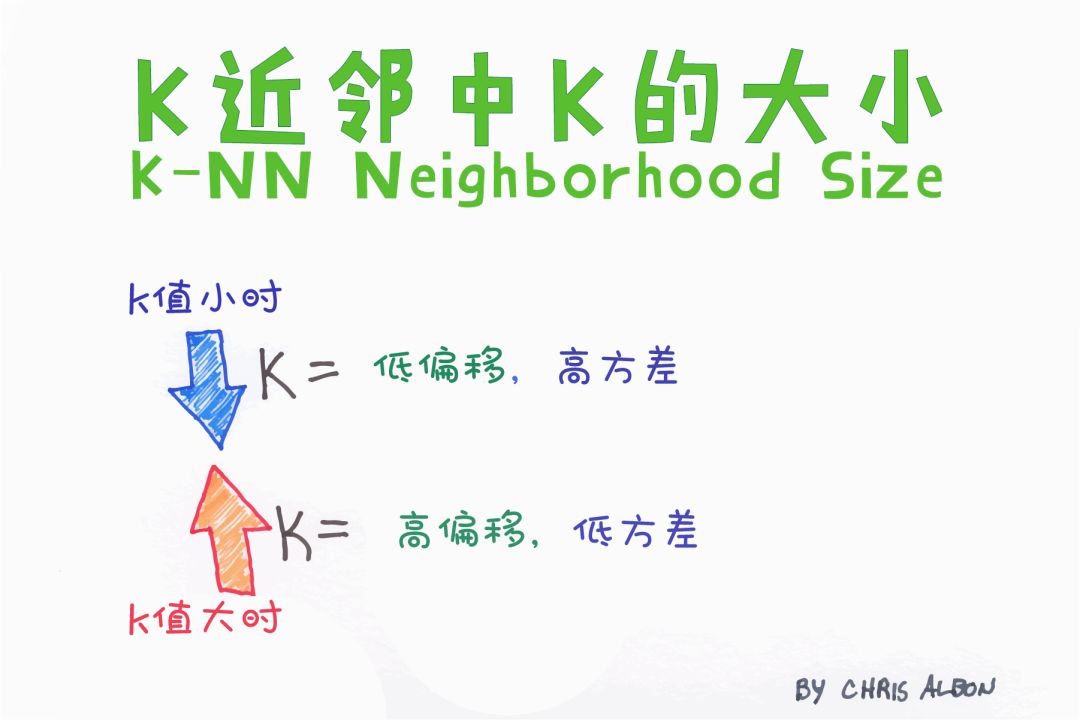

K-近鄰算法(K-NN)

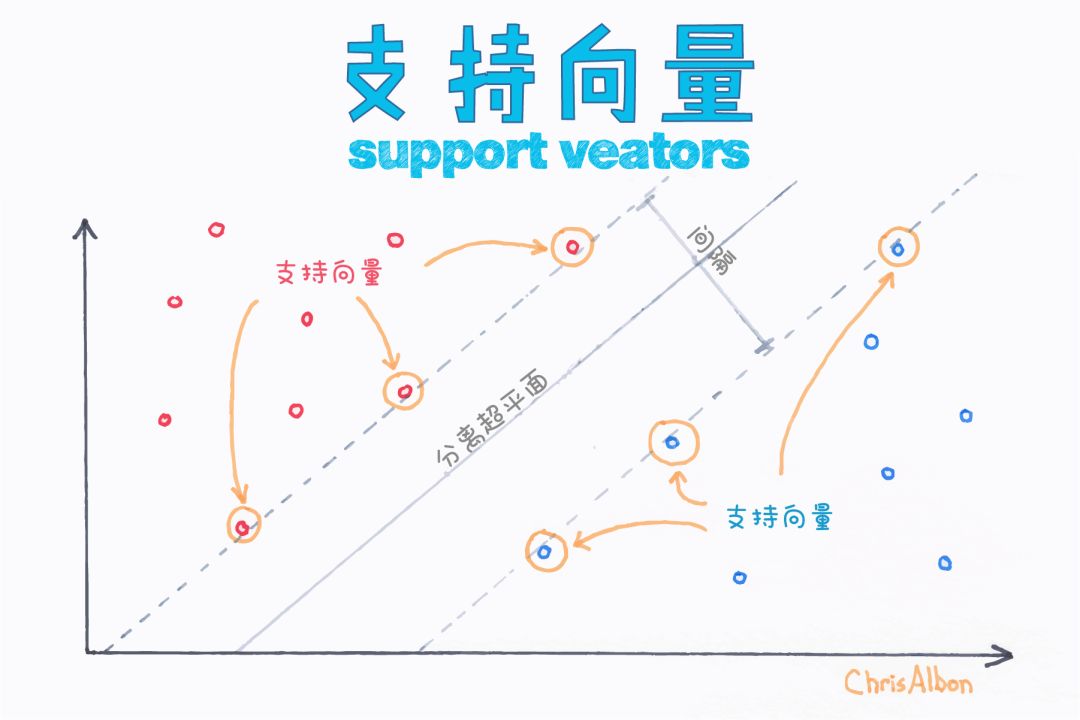

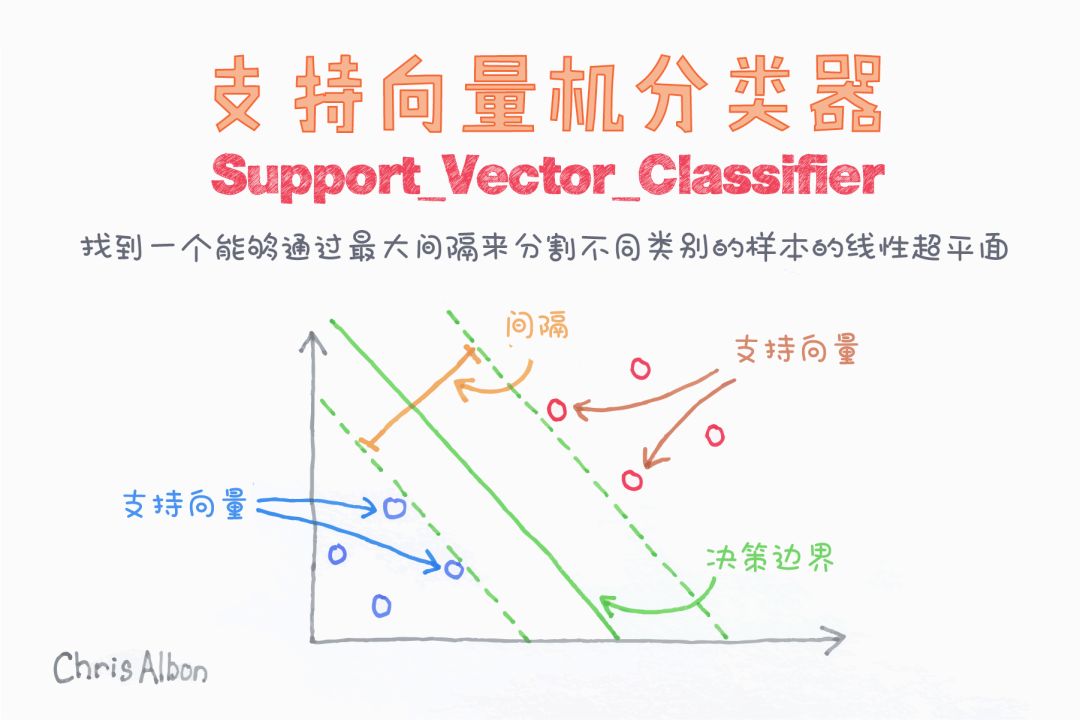

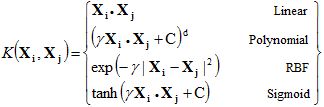

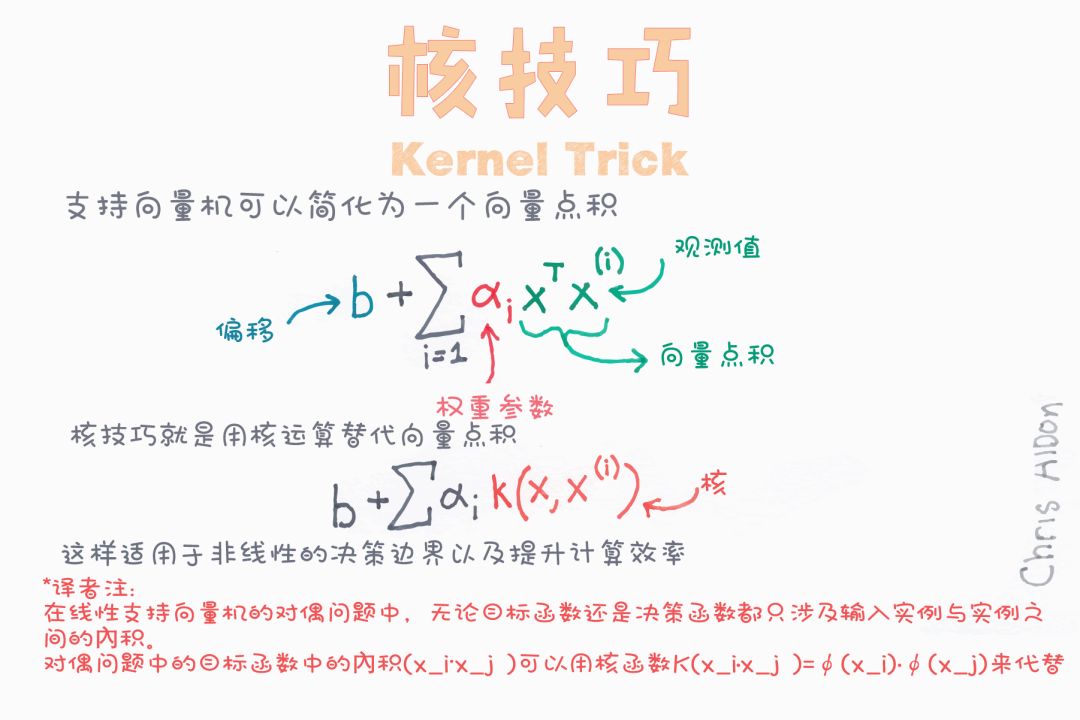

支持向量機(jī)(SVM)

前文討論的就是線性SVM。

多項(xiàng)式核中需要指定多項(xiàng)式的次數(shù)。它允許在輸入空間中使用曲線進(jìn)行分割。

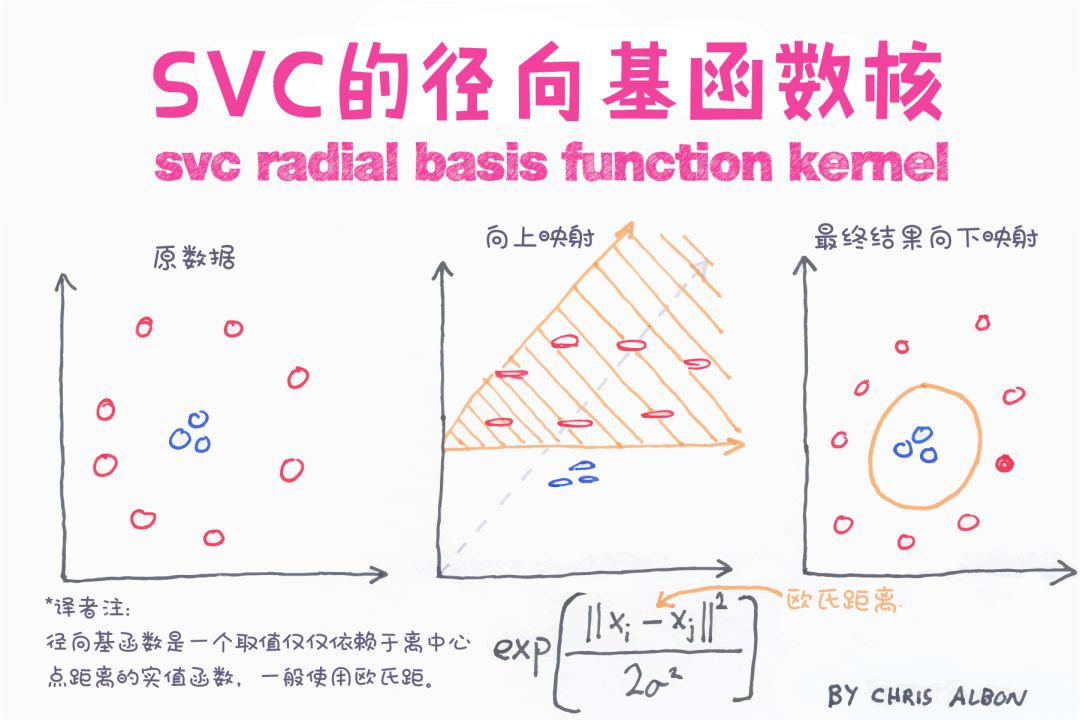

徑向基核(radial basis function, RBF)可用于非線性可分變量。使用平方歐幾里德距離,參數(shù)的典型值會(huì)導(dǎo)致過(guò)度擬合。sklearn中默認(rèn)使用RBF。

類(lèi)似于與邏輯回歸類(lèi)似,sigmoid核用于二分類(lèi)問(wèn)題。

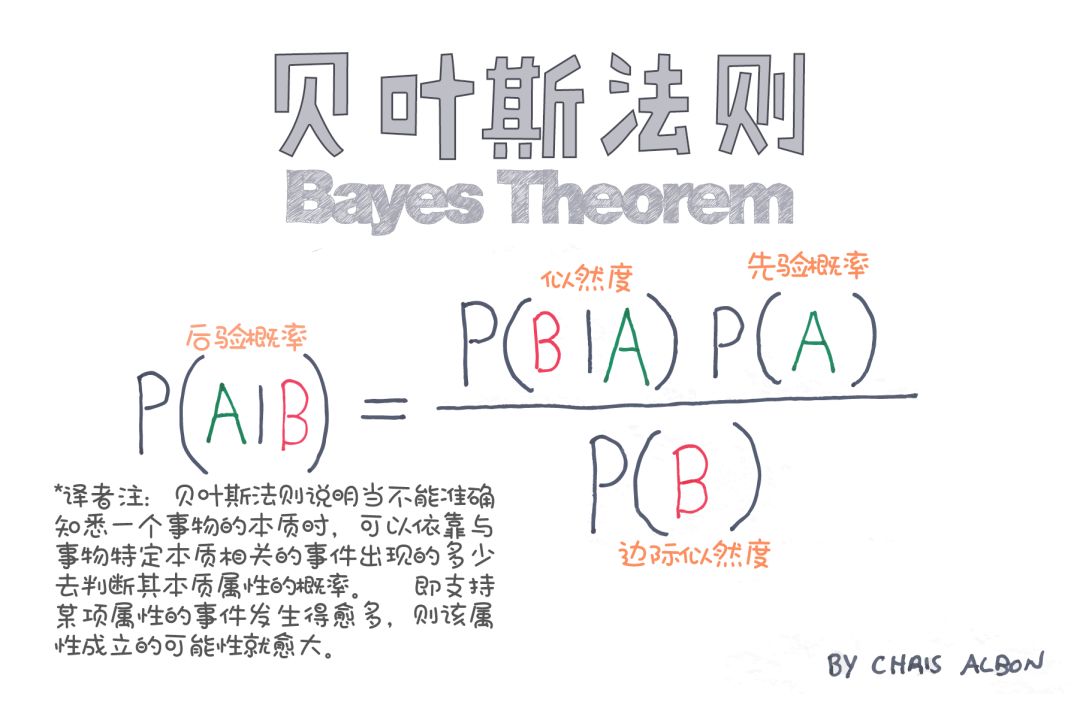

樸素貝葉斯

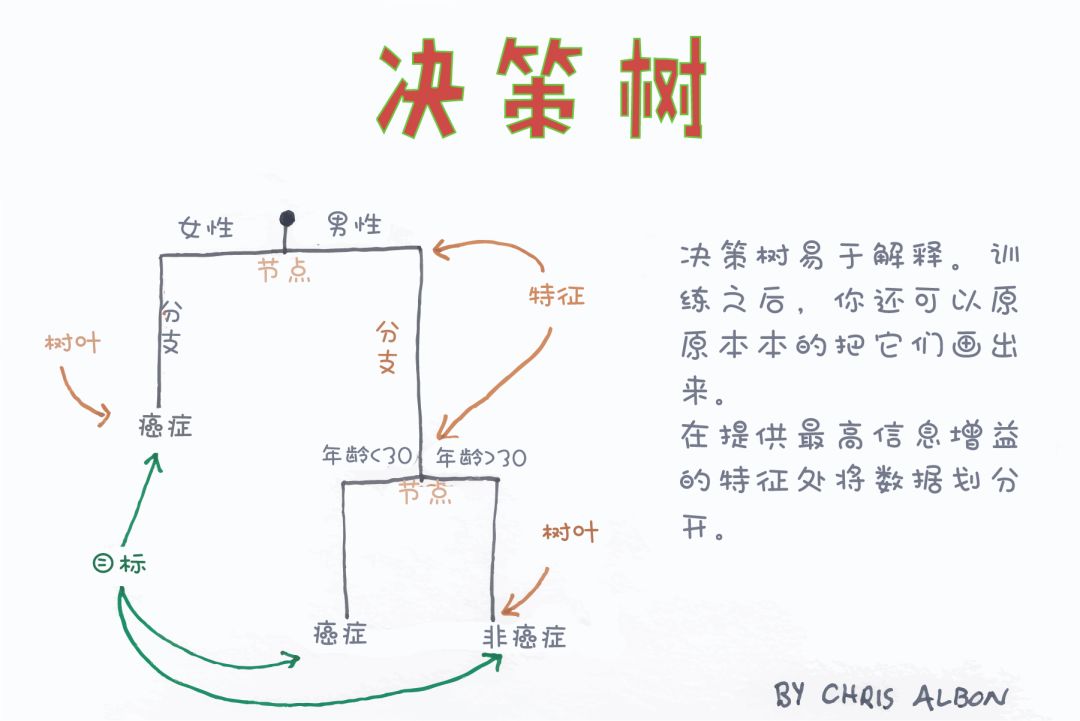

決策樹(shù)分類(lèi)

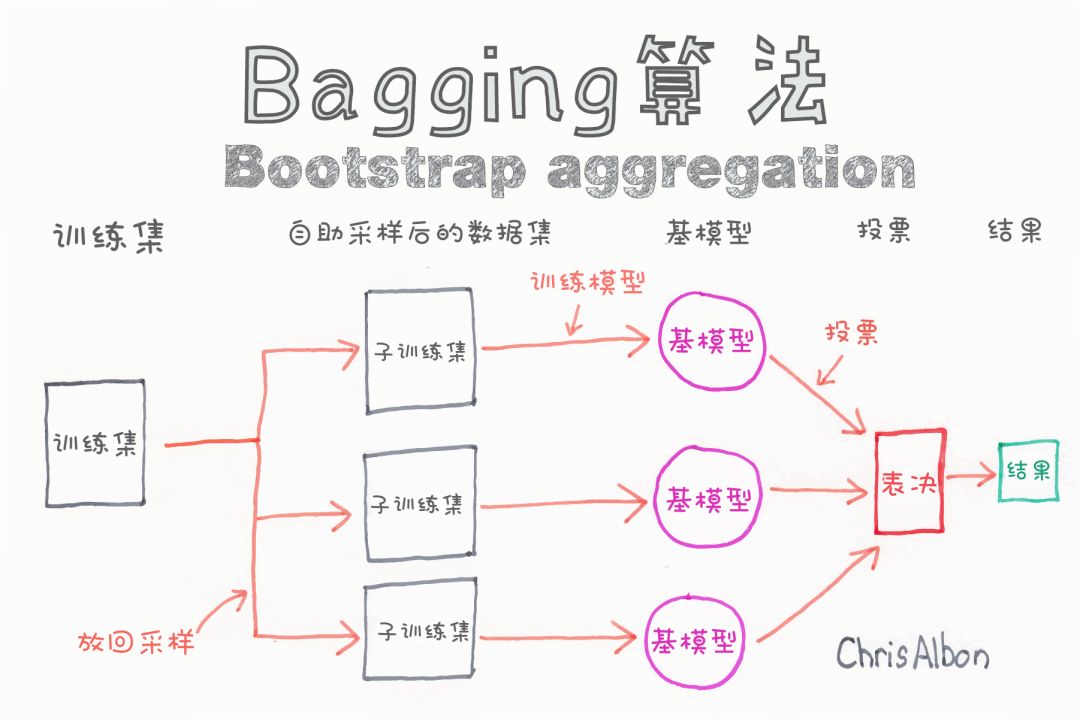

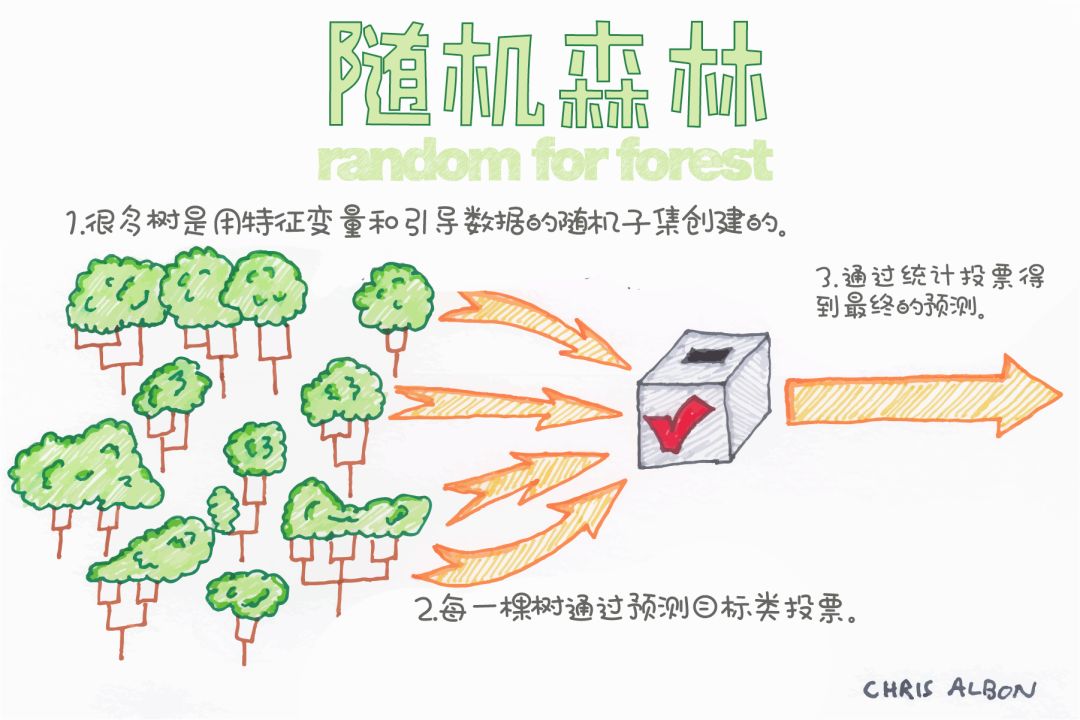

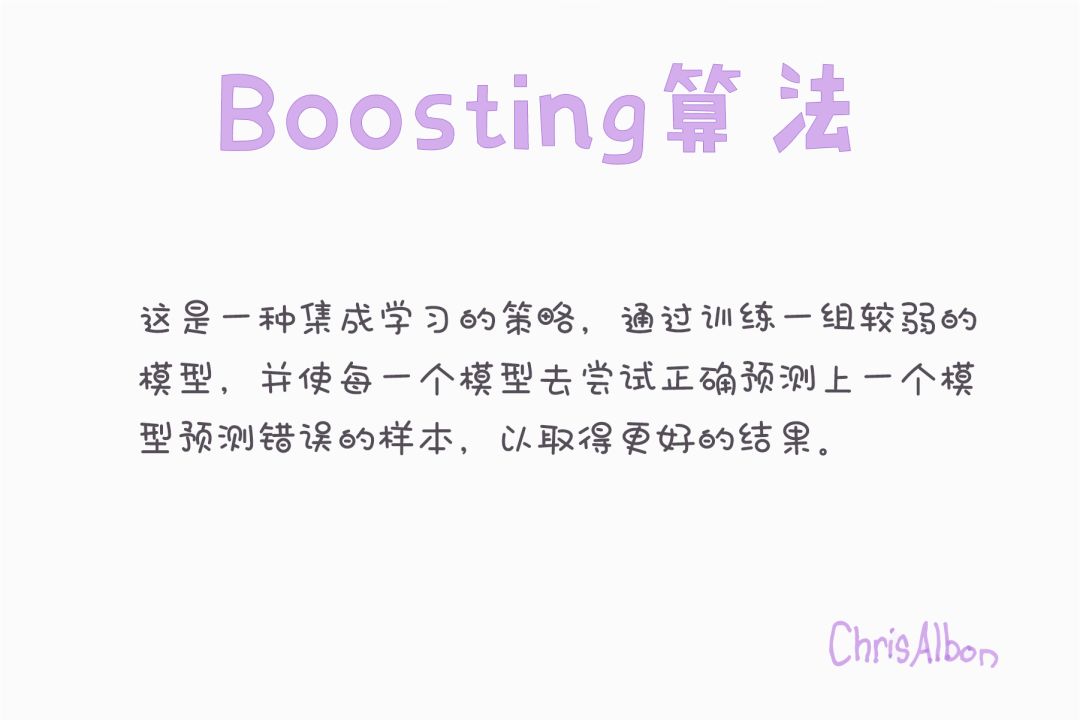

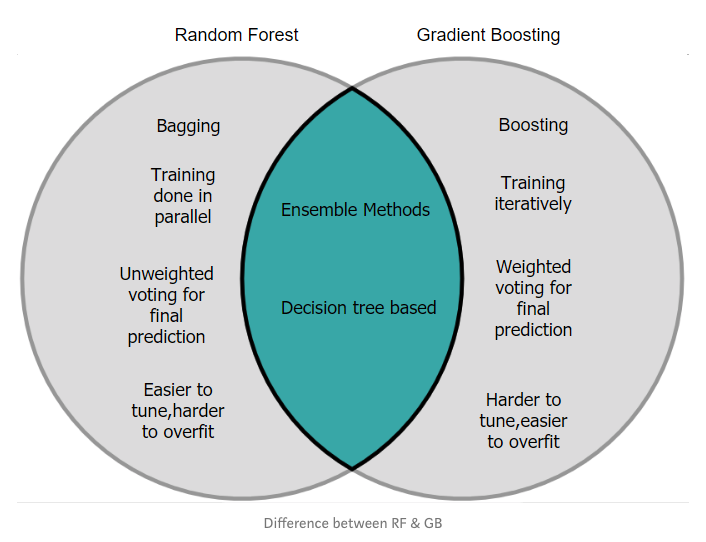

分類(lèi)的集成算法

梯度提升分類(lèi)器

使用淺層決策樹(shù)初始化預(yù)測(cè)結(jié)果。

計(jì)算殘差值(實(shí)際預(yù)測(cè)值)。

構(gòu)建另一棵淺層決策樹(shù),將上一棵樹(shù)的殘差作為輸入進(jìn)行預(yù)測(cè)。

用新預(yù)測(cè)值和學(xué)習(xí)率的乘積作為最新預(yù)測(cè)結(jié)果,更新原有預(yù)測(cè)結(jié)果。

重復(fù)步驟2-4,進(jìn)行一定次數(shù)的迭代(迭代的次數(shù)即為構(gòu)建的決策樹(shù)的個(gè)數(shù))。

https://medium.com/mlreview/gradient-boosting-from-scratch-1e317ae4587d%20/t%20_blank

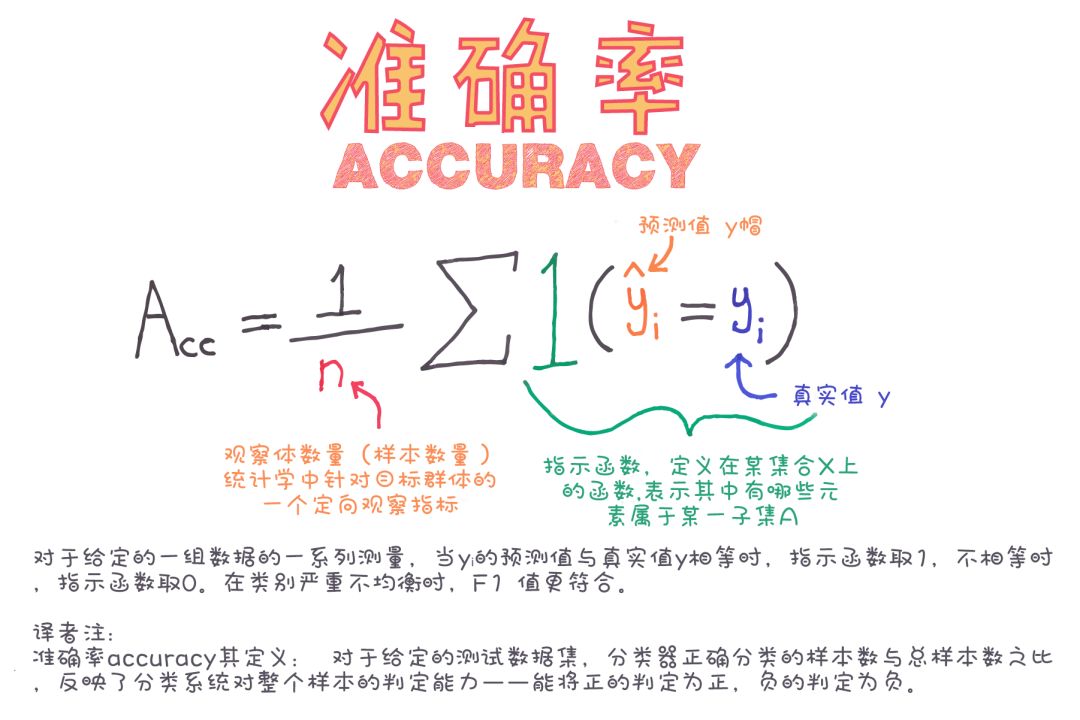

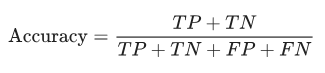

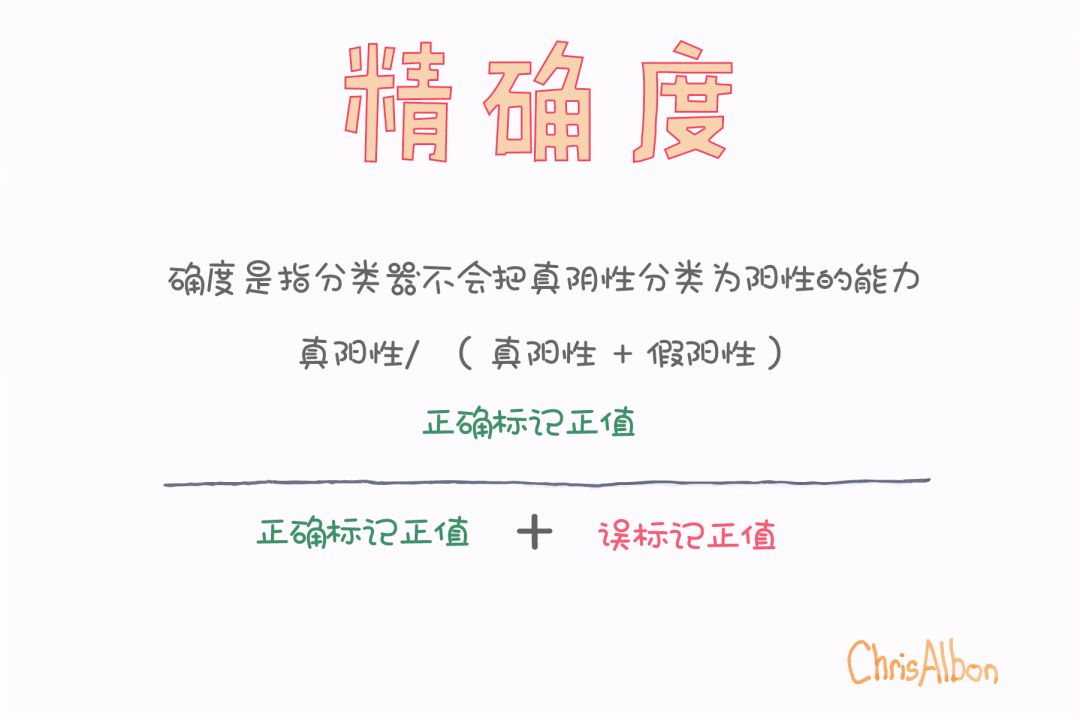

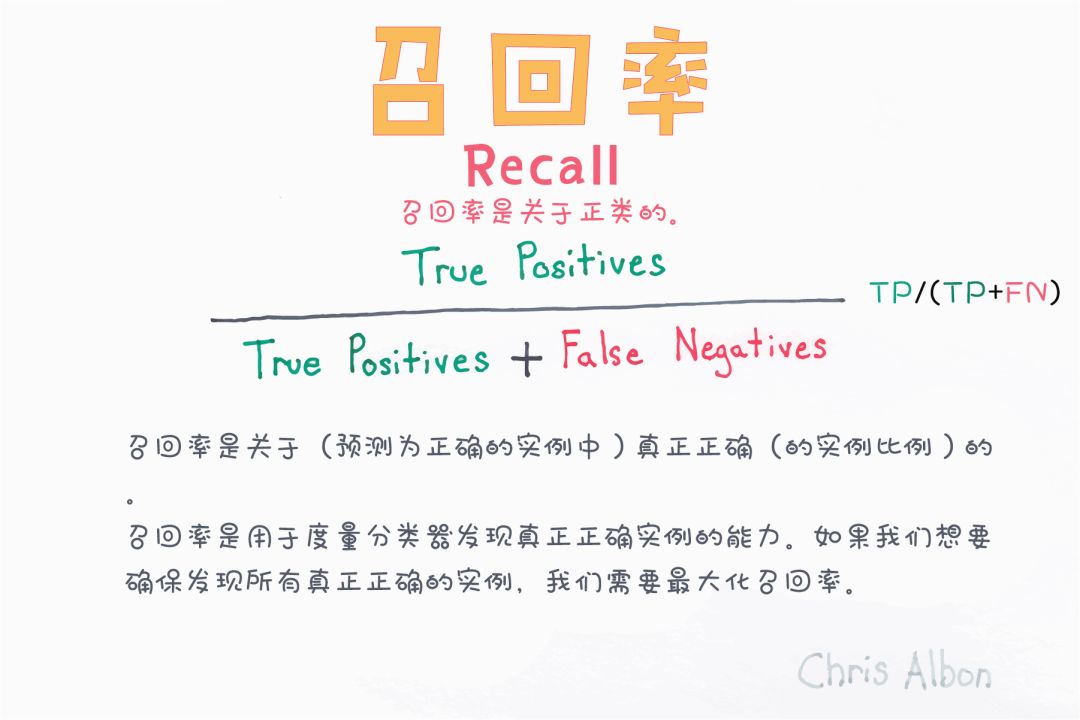

分類(lèi)器的性能

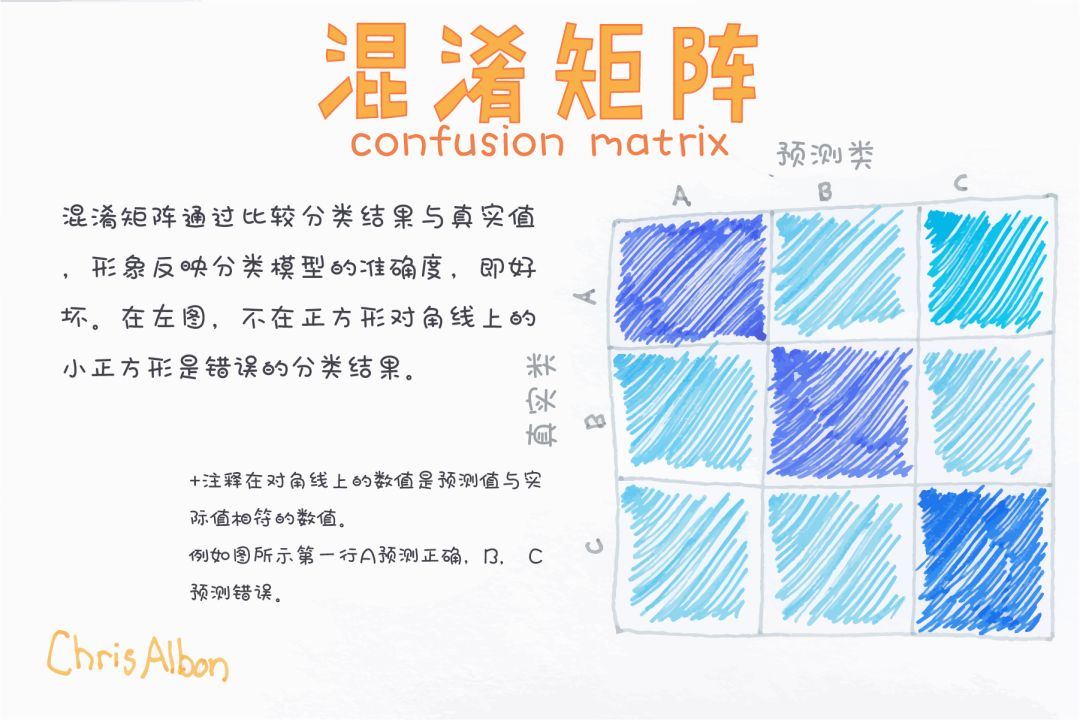

混淆矩陣

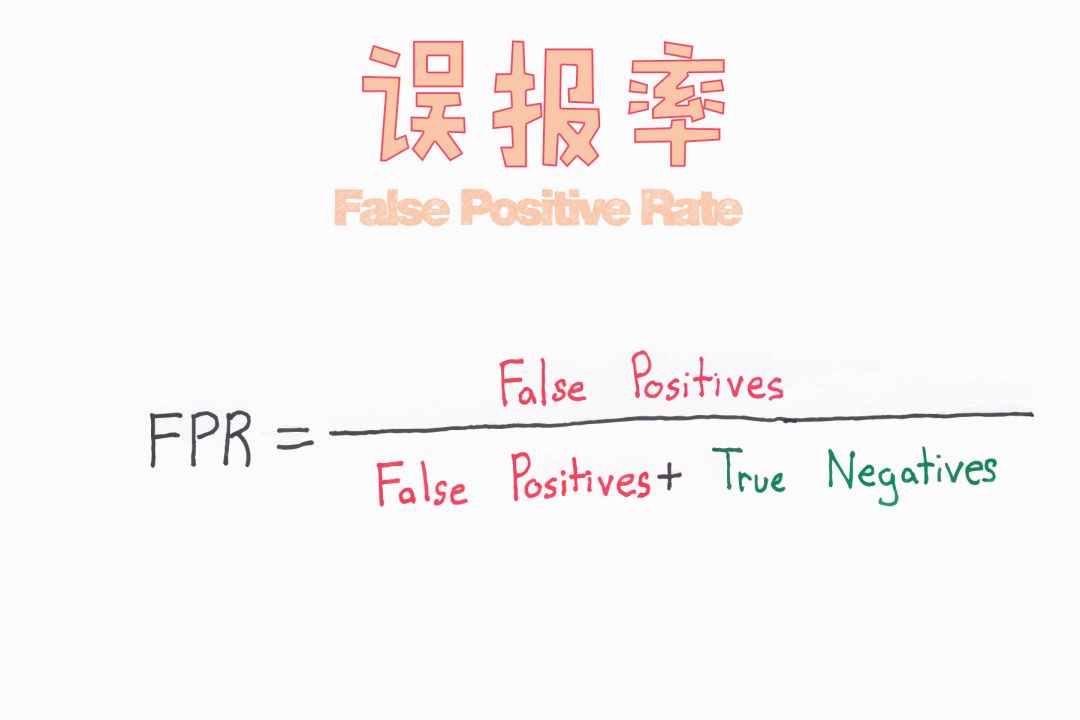

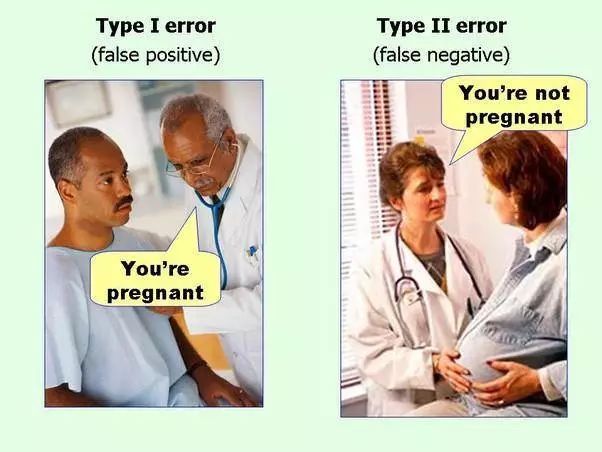

假正例&假負(fù)例

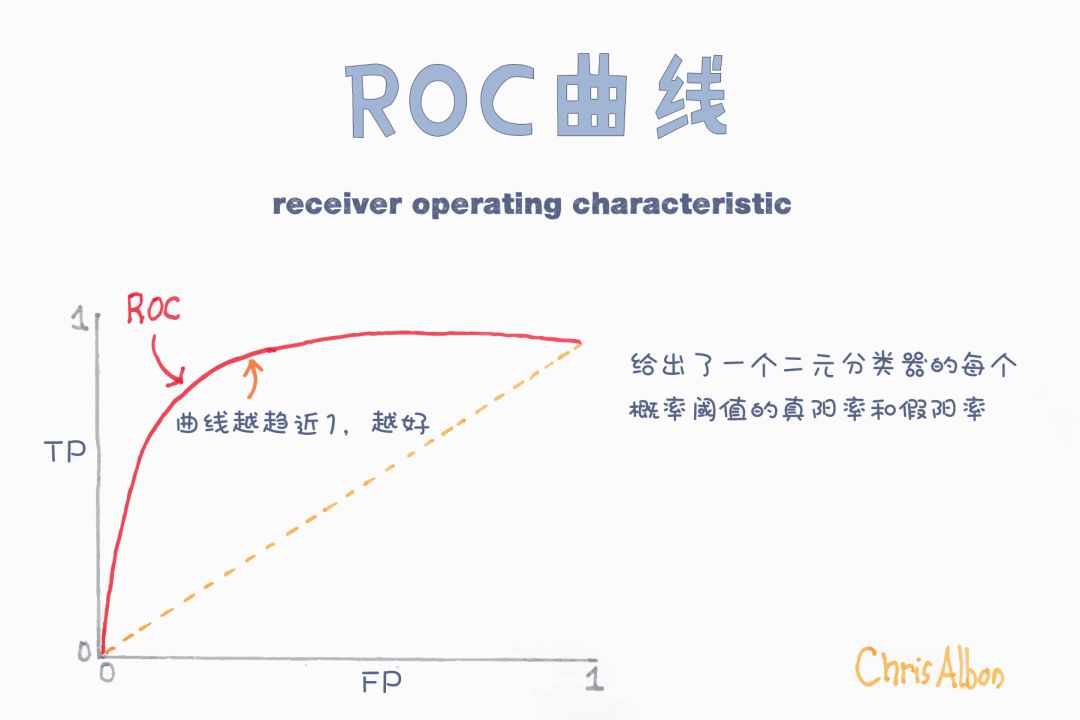

接受者操作曲線(ROC)和曲線下的面積(AUC)

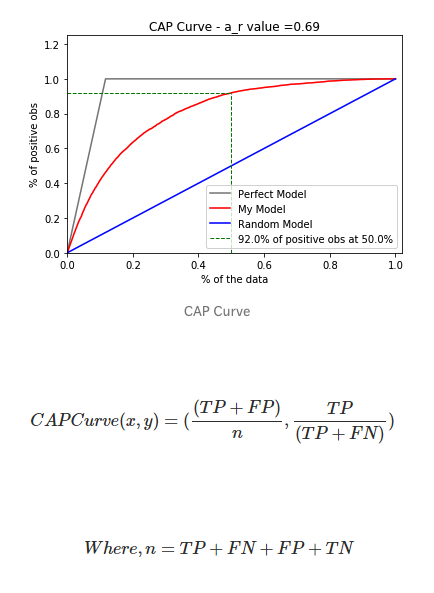

累積精度曲線

http://www.semspirit.com/artificial-intelligence/machine-learning/classification/classifier-evaluation/classifier-evaluation-with-cap-curve-in-python/" "_blank"

https://github.com/BadreeshShetty/Supervised-ML-Classification" "_blank"Github Repo

https://builtin.com/data-science/supervised-machine-learning-classification

End

End

聲明:部分內(nèi)容來(lái)源于網(wǎng)絡(luò),僅供讀者學(xué)術(shù)交流之目的。文章版權(quán)歸原作者所有。如有不妥,請(qǐng)聯(lián)系刪除。