基于深度學(xué)習(xí)的醫(yī)學(xué)圖像半監(jiān)督分割

點(diǎn)擊上方“小白學(xué)視覺”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

本文轉(zhuǎn)自:計(jì)算機(jī)視覺life

準(zhǔn)確、魯棒地從醫(yī)學(xué)圖像中分割出器官或病變?cè)谠S多臨床應(yīng)用中起著至關(guān)重要的作用,如診斷和治療計(jì)劃。隨著標(biāo)注數(shù)據(jù)的大量增加,深度學(xué)習(xí)在圖像分割方面獲得了巨大地成功。然而,對(duì)于醫(yī)學(xué)圖像來說,標(biāo)注數(shù)據(jù)的獲取通常是昂貴的,因?yàn)樯蓽?zhǔn)確的注釋需要專業(yè)知識(shí)和時(shí)間,特別是在三維圖像中。為了降低標(biāo)記成本,近年來人們提出了許多方法來開發(fā)一種高性能的醫(yī)學(xué)圖像分割模型,以減少標(biāo)記數(shù)據(jù)。例如,將用戶交互與深度神經(jīng)網(wǎng)絡(luò)相結(jié)合,交互式地進(jìn)行圖像分割,可以減少標(biāo)記的工作量。自監(jiān)督學(xué)習(xí)方法是利用無標(biāo)簽數(shù)據(jù),以監(jiān)督的方式訓(xùn)練模型,學(xué)習(xí)基礎(chǔ)知識(shí)然后進(jìn)行知識(shí)遷移。半監(jiān)督學(xué)習(xí)框架直接從有限地帶標(biāo)簽數(shù)據(jù)和大量的未帶標(biāo)簽數(shù)據(jù)中學(xué)習(xí),得到高質(zhì)量的分割結(jié)果。弱監(jiān)督學(xué)習(xí)方法從邊框、涂鴉或圖像級(jí)標(biāo)簽中學(xué)習(xí)圖像分割,而不是使用像素級(jí)標(biāo)注,這減少了標(biāo)注的負(fù)擔(dān)。但是,弱監(jiān)督學(xué)習(xí)和自監(jiān)督學(xué)習(xí)在醫(yī)學(xué)圖像分割任務(wù)上性能依舊受限,尤其是在三維醫(yī)學(xué)圖像的分割上。除此之外,少量標(biāo)注數(shù)據(jù)和大量未標(biāo)注數(shù)據(jù)更加符合實(shí)際臨床場(chǎng)景。本文總結(jié)了近些年出現(xiàn)的用于醫(yī)學(xué)影像的半監(jiān)督學(xué)習(xí)方法,這些方法大致可以分為:(1),基于數(shù)據(jù)擾動(dòng)或模型擾動(dòng)或數(shù)據(jù)模型同時(shí)擾動(dòng)正則化;(2),基于多任務(wù)層面的一致性約束。

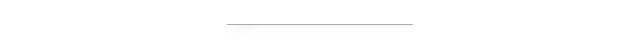

1. TCSM-V1: Semi-supervised Skin Lesion Segmentation via Transformation Consistent Self-ensembling Model. (BMVC2018)

總結(jié):這篇文章的方法類似于Temporal ensembling for semi-supervised learning(ICLR2017)通過給輸入數(shù)據(jù)加擾動(dòng)(transformation)來正則化模型 (一次迭代模型需要前向傳播兩次,輸入分別是未變化的圖像和變化后的圖像,然后變化后圖像得到的結(jié)果進(jìn)行反變換然后構(gòu)建這兩個(gè)預(yù)測(cè)結(jié)果的一致性損失),直接將未標(biāo)注數(shù)據(jù)利用起來,想法很簡(jiǎn)潔但效果很不錯(cuò)。

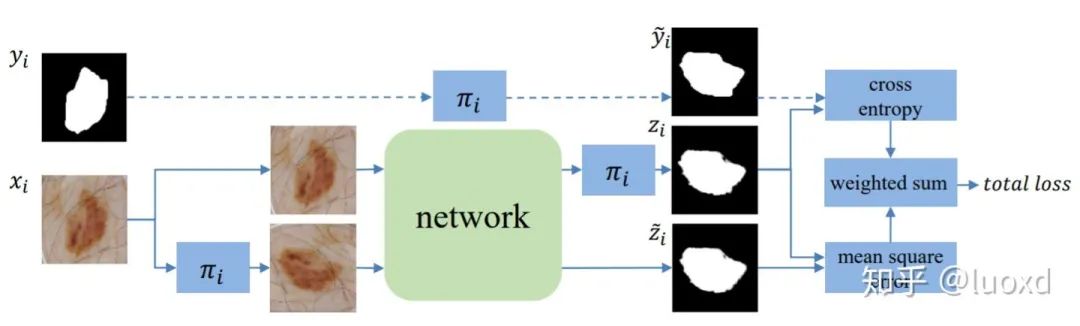

2. TCSM-V2: Transformation-Consistent Self-Ensembling Model for Semisupervised Medical Image Segmentation. (TNNLS2020)

總結(jié):這篇在Mean Teacher (NIPS2017) 的基礎(chǔ)上引入了更多的數(shù)據(jù)擾動(dòng)(flip, rotate, rescale,noise等等)和模型擾動(dòng)(dropout)來構(gòu)建同一輸入在不同擾動(dòng)下的一致性。然后取得了很不錯(cuò)的效果。

以上兩篇的文章代碼也已開源:

https://github.com/xmengli999/TCSM

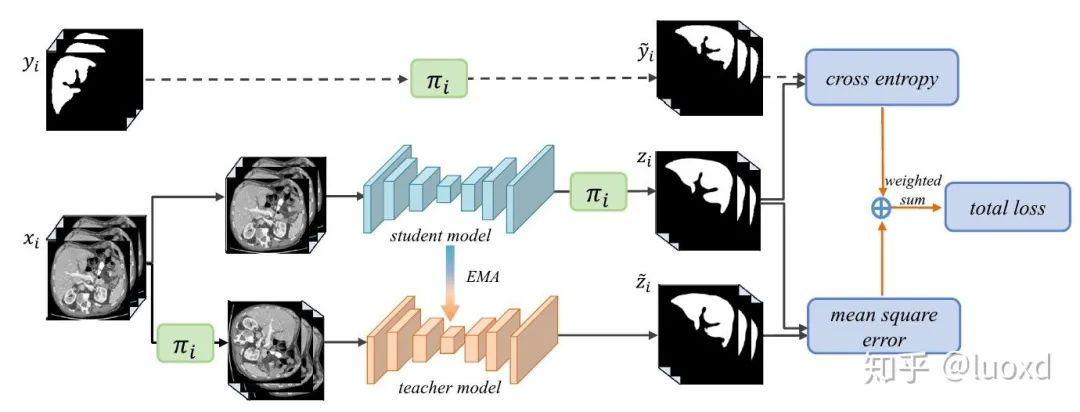

3. Uncertainty-aware Self-ensembling Model for Semi-supervised 3D Left Atrium Segmentation (MICCAI2019)

總結(jié):這篇文章整合了Mean Teacher (NIPS2017) 和不確定性估計(jì)來進(jìn)行半監(jiān)督學(xué)習(xí),通過不確定性圖來指導(dǎo)(加權(quán))Mean Teacher模型從未標(biāo)注的數(shù)據(jù)上逐步學(xué)習(xí)。不確定性圖的計(jì)算采用了經(jīng)典的蒙特卡洛 Dropout多次推理來獲得,這樣會(huì)帶來一些額外的計(jì)算開銷,但帶來了性能的提升,可以得到不錯(cuò)的效果,而且現(xiàn)在利用不確定性估計(jì)來提高網(wǎng)絡(luò)性能也是一個(gè)熱門的研究方向。

這篇文章代碼已開源:

https://github.com/yulequan/UA-MT

值得一提的是,Dr. Lequan的代碼寫得非常簡(jiǎn)潔易學(xué),后續(xù)也有很多在此基礎(chǔ)上改進(jìn)的算法。

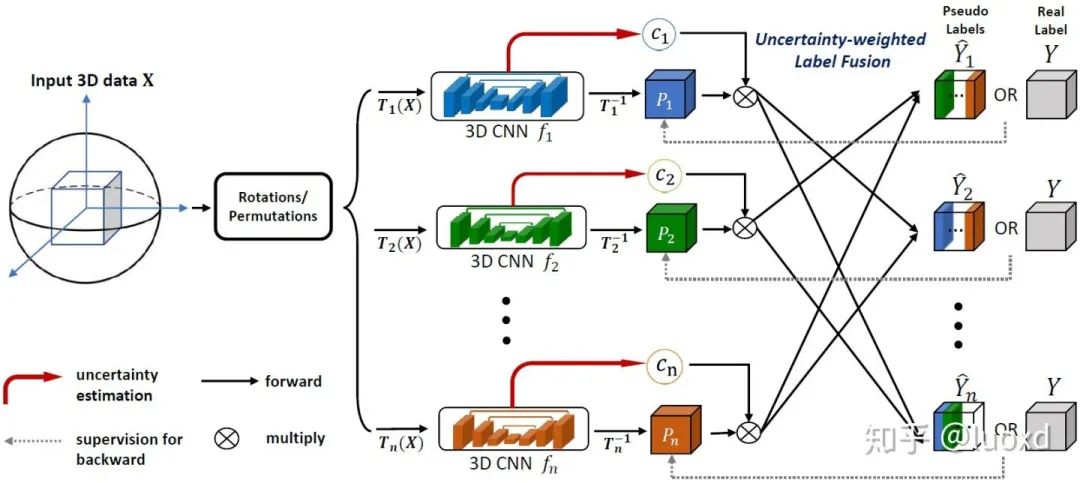

4. 3D Semi-Supervised Learning with Uncertainty-Aware Multi-View Co-Training (WACV2020,MedIA2020)

總結(jié):這篇文章結(jié)合了前面提到的幾篇的所有特點(diǎn)(沒有采用Mean Teacher Model),并將多視角的聯(lián)合訓(xùn)練引入到醫(yī)學(xué)圖像的半監(jiān)督和域適應(yīng)的問題中,想法很新穎,實(shí)現(xiàn)也不難,而且效果很不錯(cuò),只是隨著視角的不斷增加計(jì)算開銷會(huì)越來越大。

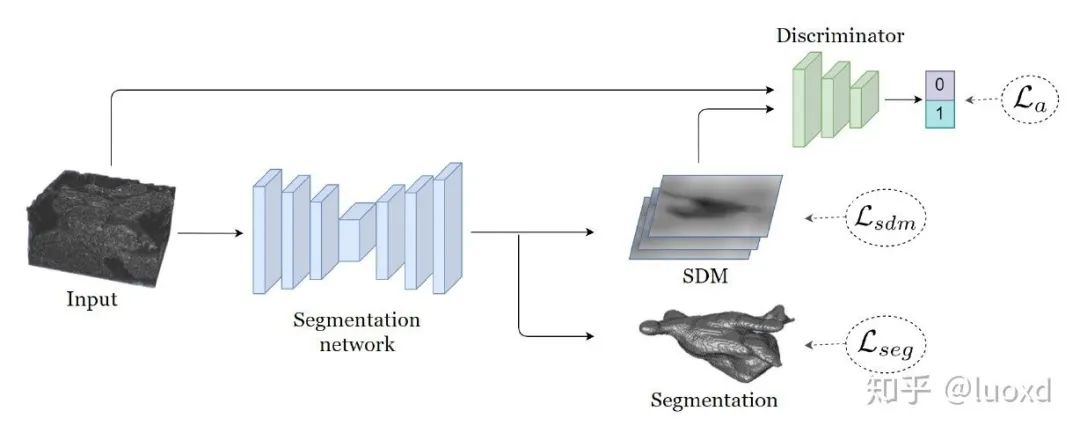

5. Shape-aware Semi-supervised 3D Semantic Segmentation for Medical Images (MICCAI2020)

總結(jié): 這篇文章采用了一個(gè)常用的多任務(wù)網(wǎng)絡(luò)結(jié)構(gòu),同時(shí)進(jìn)行圖像分割和帶符號(hào)的距離圖回歸(引入了形狀和位置先驗(yàn)),并用判別器來作為正則化項(xiàng),與以前常見用判別器做正則化項(xiàng)方法不同的是,本文的判別器輸入時(shí)帶符號(hào)的距離圖和原圖,而不是分割結(jié)果和原圖。這樣設(shè)計(jì)可以使整個(gè)未標(biāo)記數(shù)據(jù)集的預(yù)測(cè)分布平滑,并引入了很強(qiáng)的形狀和位置先驗(yàn)信息,保證分割結(jié)果的穩(wěn)定性和魯棒性。

這篇論文的代碼也已經(jīng)開源:

https://github.com/kleinzcy/SASSnet

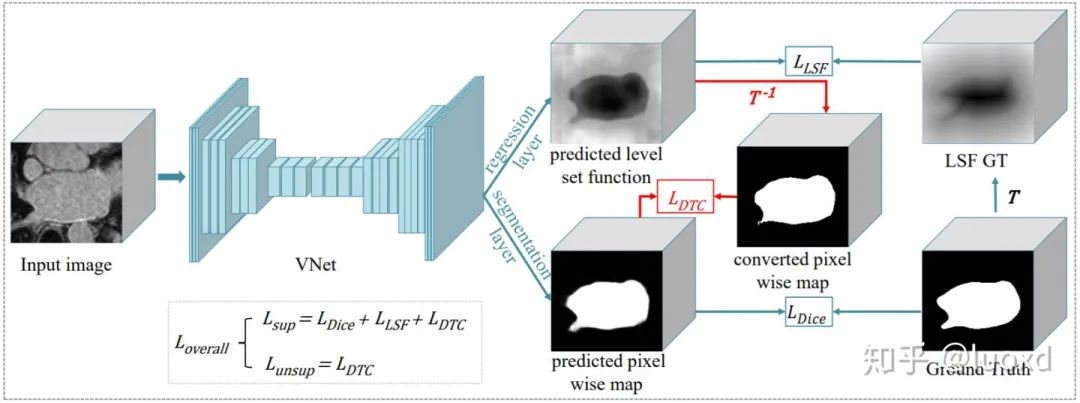

6. Semi-supervised Medical Image Segmentation through Dual-task Consistency (Arxiv)

總結(jié): 前面五篇文章主要還是基于數(shù)據(jù)層面和模型層面的擾動(dòng)來構(gòu)建一致性來進(jìn)行半監(jiān)督學(xué)習(xí)。本文(DTC)從任務(wù)層面來構(gòu)建了一致性進(jìn)行半監(jiān)督學(xué)習(xí),與SASSNet一樣本文采用了一個(gè)多任務(wù)網(wǎng)絡(luò)結(jié)構(gòu),同時(shí)進(jìn)行分割和水平集函數(shù)回歸,不同的是SASSNet用判別器來進(jìn)行正則化(data-level),而本文利用兩個(gè)任務(wù)之間的表示差異來構(gòu)建一致性(task-level)。與Mean Teacher等模型需要多次前向傳播相比,DTC模型簡(jiǎn)單,計(jì)算開銷也不大,除此之外,還有可以構(gòu)建許多跨任務(wù)的一致性進(jìn)行全監(jiān)督,半監(jiān)督或者是跨域(DA)學(xué)習(xí)。

這篇論文代碼也已經(jīng)開源:

https://github.com/Luoxd1996/DTC

以上論文更多細(xì)節(jié)和實(shí)驗(yàn)結(jié)果可以參考這些論文原文,此處只是個(gè)人的近期總結(jié),更多內(nèi)容也歡迎大家補(bǔ)充,也希望大家能設(shè)計(jì)出更好的半監(jiān)督學(xué)習(xí)算法來降低對(duì)標(biāo)注數(shù)據(jù)的依賴。

交流群

歡迎加入公眾號(hào)讀者群一起和同行交流,目前有SLAM、三維視覺、傳感器、自動(dòng)駕駛、計(jì)算攝影、檢測(cè)、分割、識(shí)別、醫(yī)學(xué)影像、GAN、算法競(jìng)賽等微信群(以后會(huì)逐漸細(xì)分),請(qǐng)掃描下面微信號(hào)加群,備注:”昵稱+學(xué)校/公司+研究方向“,例如:”張三 + 上海交大 + 視覺SLAM“。請(qǐng)按照格式備注,否則不予通過。添加成功后會(huì)根據(jù)研究方向邀請(qǐng)進(jìn)入相關(guān)微信群。請(qǐng)勿在群內(nèi)發(fā)送廣告,否則會(huì)請(qǐng)出群,謝謝理解~