【學(xué)術(shù)相關(guān)】近5年十大最具影響力的 AI 論文,你知道幾個(gè)?

每年世界各地的科學(xué)家都會(huì)在AI領(lǐng)域發(fā)表數(shù)千篇研究論文,但是只有少數(shù)文章受到廣泛大家的青睞,并在全球范圍內(nèi)產(chǎn)生影響力。在本文中我將分享過(guò)去5年在頂級(jí)AI會(huì)議上發(fā)表的十大最具影響力的研究論文,排名基于AI會(huì)議和期刊的引用次數(shù)。

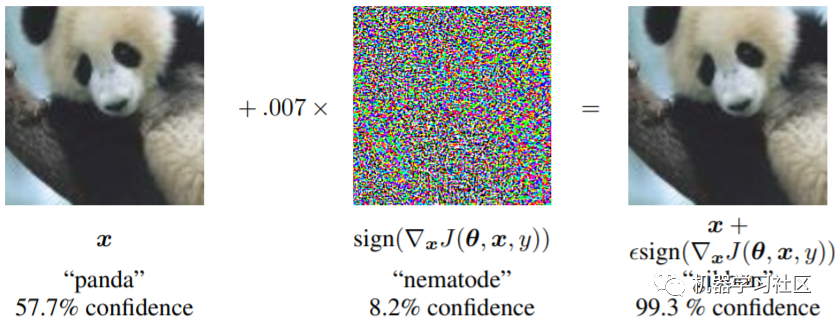

10 解釋和利用對(duì)抗性示例

論文地址:https://arxiv.org/abs/1412.6572

該論文是神經(jīng)網(wǎng)絡(luò)生成對(duì)抗性示例,引入對(duì)抗訓(xùn)練作為一種正則化技術(shù)的最快速方法之一。

它反應(yīng)了一個(gè)非常有趣的現(xiàn)象,即攻擊者對(duì)輸入進(jìn)行微小的修改就會(huì)大大降低任何精確的機(jī)器學(xué)習(xí)模型的性能。在其他任務(wù)(例如文本和視頻)中也觀察到了這種現(xiàn)象,并導(dǎo)致大量的研究工作,重新考慮ML在現(xiàn)實(shí)世界中的關(guān)鍵任務(wù)的適用性。

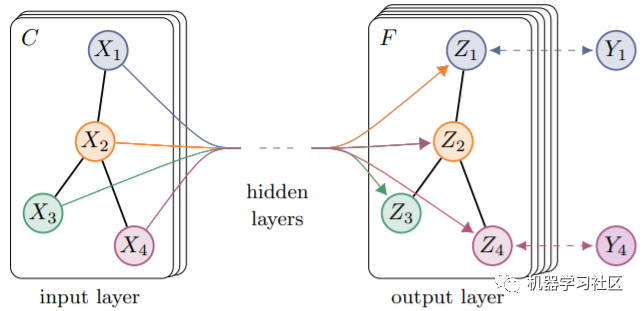

9 半監(jiān)督學(xué)習(xí)卷積神經(jīng)網(wǎng)絡(luò)

論文地址:https://arxiv.org/abs/1609.02907

在圖上實(shí)現(xiàn)半監(jiān)督節(jié)點(diǎn)分類的一個(gè)簡(jiǎn)單但有效的圖卷積網(wǎng)絡(luò)。

圖卷積網(wǎng)絡(luò)將深度學(xué)習(xí)帶入了圖域,顯示了它較以前主導(dǎo)該領(lǐng)域的手工啟發(fā)式方法優(yōu)越性。

8 DCGAN:深度學(xué)習(xí)生成對(duì)抗卷積神經(jīng)網(wǎng)絡(luò)

論文地址:https://arxiv.org/abs/1511.06434

提出了DCGAN,一種用于GAN模型生成器的深層CNN架構(gòu),可獲取以前不存在的自然圖像。

GAN是能夠生成人,動(dòng)物或物體的新圖像的機(jī)器學(xué)習(xí)模型,在照片編輯和設(shè)計(jì)應(yīng)用程序中獲得廣泛認(rèn)可。該方法對(duì)于生成新逼真的圖像的所有現(xiàn)代GAN模型都至關(guān)重要。

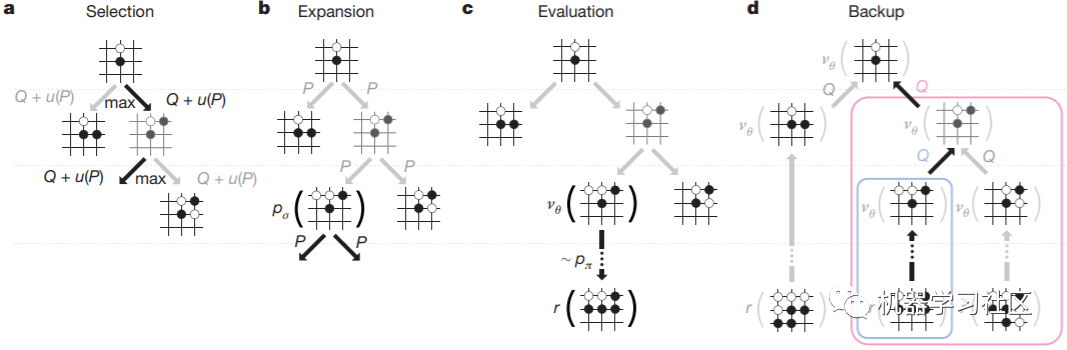

7 用深度神經(jīng)網(wǎng)絡(luò)和樹(shù)搜索掌握圍棋游戲

論文地址:https://www.nature.com/articles/nature16961

引入AlphaGo,它是深度強(qiáng)化學(xué)習(xí)與蒙特卡洛樹(shù)搜索算法的結(jié)合,在圍棋游戲中擊敗了其他程序和專業(yè)人類玩家。

歷史上第一次,計(jì)算機(jī)程序贏得人類被認(rèn)為是不可能至少再過(guò)十年。

這是史上第一次計(jì)算機(jī)程序贏得了人類最強(qiáng)大的玩家之一,李塞多爾。這是AI的一個(gè)重要里程碑,在此之前,人們認(rèn)為需要至少十年才會(huì)達(dá)到這個(gè)壯舉。

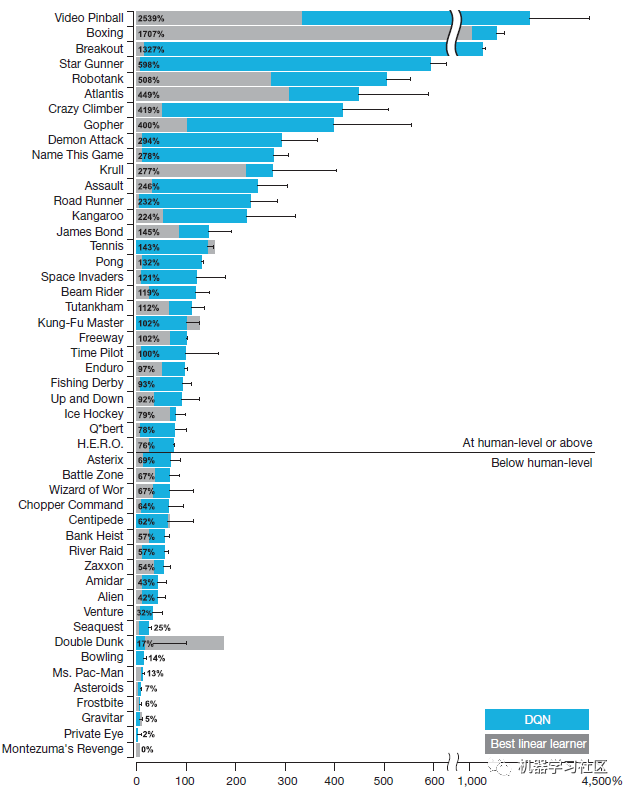

6 通過(guò)深度學(xué)習(xí)掌握人類級(jí)別操控力

論文地址:https://www.nature.com/articles/nature14236

引入強(qiáng)化學(xué)習(xí)算法DQN,該算法性能可在許多Atari游戲中達(dá)到人類專業(yè)玩家的水平。

制造業(yè)、機(jī)器人技術(shù)和物流等背后的算法已從硬編碼規(guī)則轉(zhuǎn)變?yōu)閺?qiáng)化學(xué)習(xí)模型。DQN是最流行的深度強(qiáng)化學(xué)習(xí)算法之一,它在各種應(yīng)用程序中均表現(xiàn)出卓越的性能,而無(wú)需將手動(dòng)設(shè)計(jì)的策略融入其中。

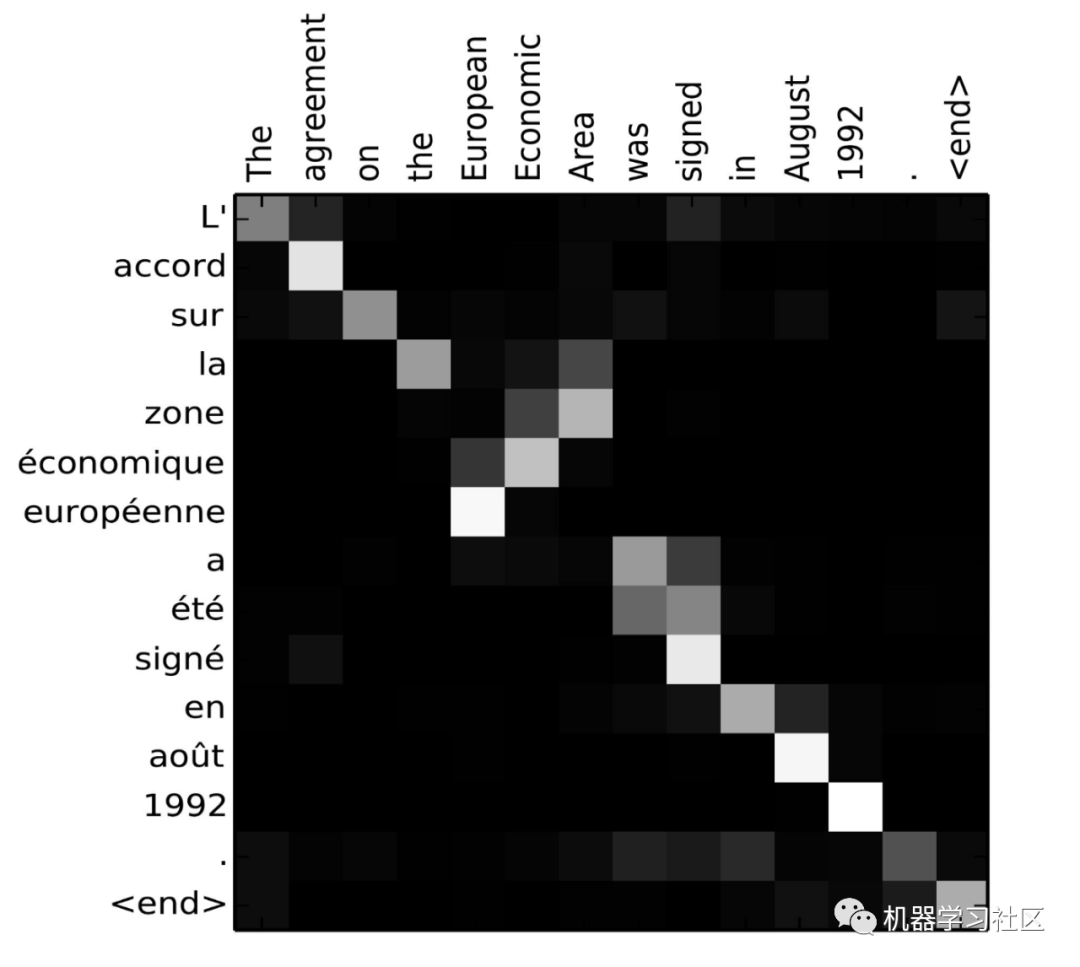

5 基于聯(lián)合學(xué)習(xí)對(duì)齊和翻譯的神經(jīng)機(jī)器翻譯

論文地址:https://arxiv.org/abs/1409.0473

神經(jīng)網(wǎng)絡(luò)首次使用注意力機(jī)制進(jìn)行機(jī)器翻譯。注意力是模型只關(guān)注源句中的特定單詞而不是整個(gè)句子的一種方式。

在機(jī)器翻譯中,傳統(tǒng)模型(例如RNN)試圖將有關(guān)源語(yǔ)句的所有信息壓縮為單個(gè)向量。模型可以有效地將每個(gè)詞表示為向量,然后關(guān)注每個(gè)詞,不僅可以在NLP中而且可以在ML的所有其他領(lǐng)域中有效地構(gòu)建神經(jīng)網(wǎng)絡(luò)。

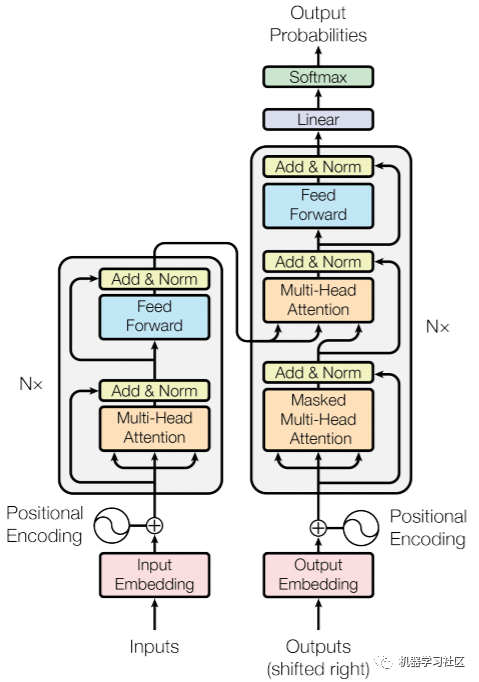

4 Attention Is All You Need

論文地址:https://arxiv.org/abs/1706.03762

Transformer 是一個(gè)有效的神經(jīng)網(wǎng)絡(luò),它完全基于注意力機(jī)制,在機(jī)器翻譯中具有出色的性能。

Transformer模型是另一種流行的語(yǔ)言模型BERT的一部分,它取代了RNN和CNN作為許多處理文本和圖像的應(yīng)用程序的默認(rèn)模型,只需要attention機(jī)制就能解決Seq-Seq的問(wèn)題, 并且能夠一步到位獲取了全局信息。

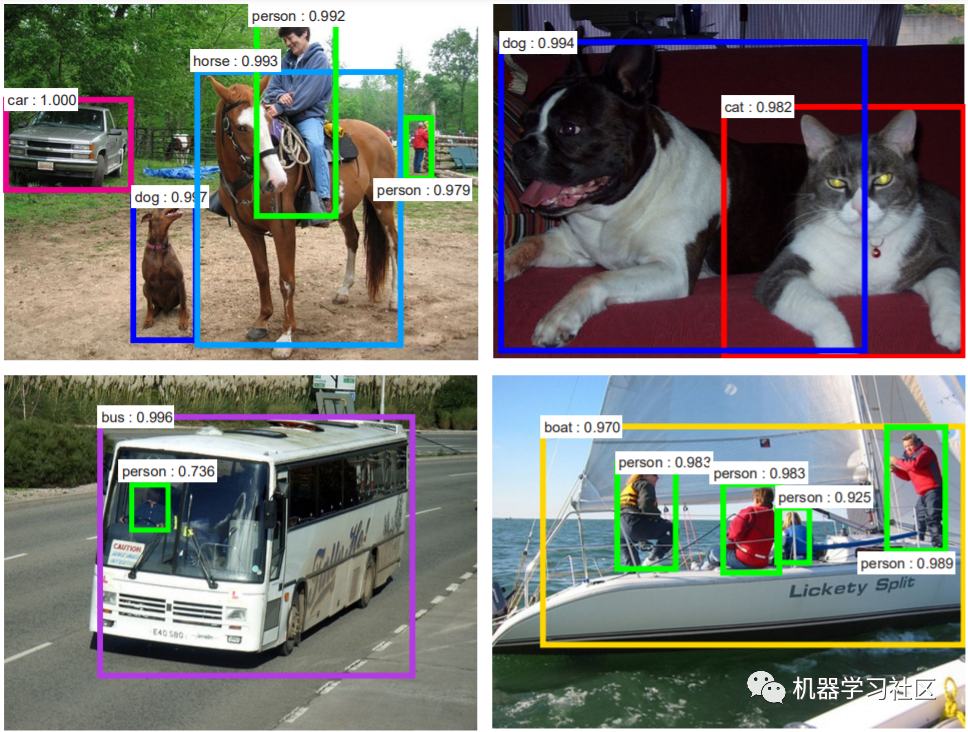

3 Faster R-CNN: 通過(guò)Region Proposal網(wǎng)絡(luò)實(shí)現(xiàn)實(shí)時(shí)目標(biāo)檢測(cè)

論文地址:https://arxiv.org/abs/1506.01497

高效的端到端卷積神經(jīng)網(wǎng)絡(luò),用于圖像和視頻中的目標(biāo)檢測(cè)。

影響:Faster R-CNN是工業(yè)環(huán)境中CV應(yīng)用蓬勃發(fā)展的原因。它在安全攝像頭、自動(dòng)駕駛汽車和移動(dòng)應(yīng)用程序中的使用極大地影響了我們今天對(duì)機(jī)器的看法。

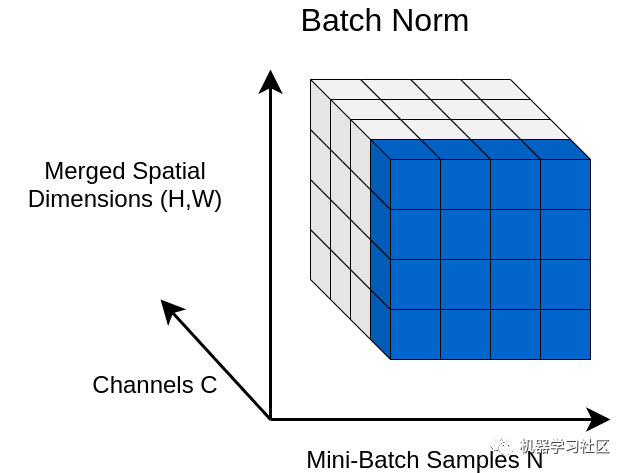

2 批歸一化:通過(guò)減少內(nèi)部協(xié)變量偏移來(lái)加速深度網(wǎng)絡(luò)訓(xùn)練

論文地址:https://arxiv.org/abs/1502.03167

通過(guò)對(duì)輸入特征進(jìn)行歸一化,使神經(jīng)網(wǎng)絡(luò)訓(xùn)練更快,更穩(wěn)定的一種簡(jiǎn)單方法。

批歸一化(Batch normalization)是如今幾乎所有神經(jīng)網(wǎng)絡(luò)的主流趨勢(shì),批歸一的存在是深度神經(jīng)網(wǎng)絡(luò)目前取得先進(jìn)成果的原因之一。

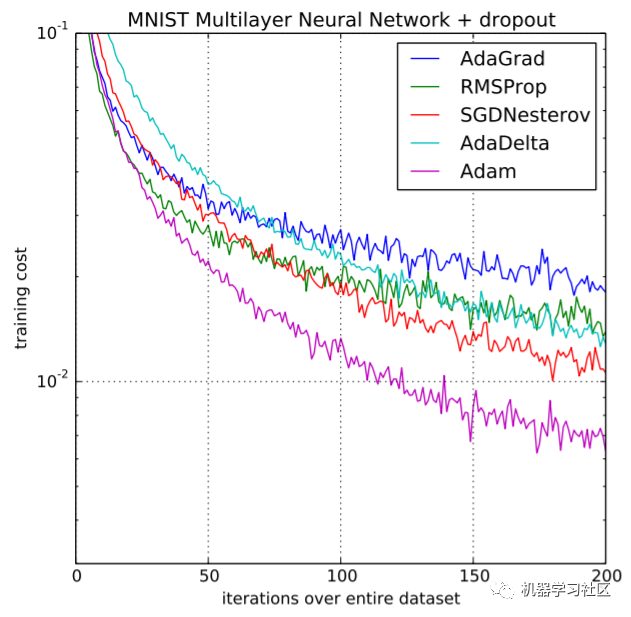

1 Adam:一種隨機(jī)優(yōu)化方法

論文地址:https://arxiv.org/abs/1412.6980

Adam是一種基于一階梯度的隨機(jī)優(yōu)化算法,它提供了神經(jīng)網(wǎng)絡(luò)的快速收斂,已被用作當(dāng)今人們訓(xùn)練的數(shù)百萬(wàn)個(gè)神經(jīng)網(wǎng)絡(luò)的默認(rèn)優(yōu)化算法。

往期精彩回顧

本站qq群851320808,加入微信群請(qǐng)掃碼: