圖解3種常見的深度學(xué)習(xí)網(wǎng)絡(luò)結(jié)構(gòu):FC、CNN、RNN

導(dǎo)讀:深度學(xué)習(xí)可以應(yīng)用在各大領(lǐng)域中,根據(jù)應(yīng)用情況的不同,深度神經(jīng)網(wǎng)絡(luò)的形態(tài)也各不相同。

常見的深度學(xué)習(xí)模型主要有全連接(Fully Connected,F(xiàn)C)網(wǎng)絡(luò)結(jié)構(gòu)、卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network,CNN)和循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Network,RNN)。

它們均有著自身的特點(diǎn),在不同的場景中發(fā)揮著重要作用。本文將為讀者介紹三種模型的基本概念以及它們各自適用的場景。

01 全連接網(wǎng)絡(luò)結(jié)構(gòu)

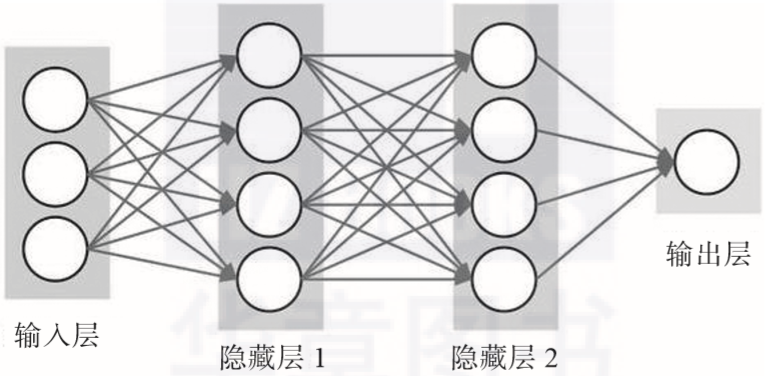

全連接(FC)網(wǎng)絡(luò)結(jié)構(gòu)是最基本的神經(jīng)網(wǎng)絡(luò)/深度神經(jīng)網(wǎng)絡(luò)層,全連接層的每一個(gè)節(jié)點(diǎn)都與上一層的所有節(jié)點(diǎn)相連。

全連接層在早期主要用于對提取的特征進(jìn)行分類,然而由于全連接層所有的輸出與輸入都是相連的,一般全連接層的參數(shù)是最多的,這需要相當(dāng)數(shù)量的存儲(chǔ)和計(jì)算空間。

參數(shù)的冗余問題使單純的FC組成的常規(guī)神經(jīng)網(wǎng)絡(luò)很少會(huì)被應(yīng)用于較為復(fù)雜的場景中。常規(guī)神經(jīng)網(wǎng)絡(luò)一般用于依賴所有特征的簡單場景,比如說房價(jià)預(yù)測模型和在線廣告推薦模型使用的都是相對標(biāo)準(zhǔn)的全連接神經(jīng)網(wǎng)絡(luò)。FC組成的常規(guī)神經(jīng)網(wǎng)絡(luò)的具體形式如圖2-7所示。

▲圖2-7 FC組成的常規(guī)神經(jīng)網(wǎng)絡(luò)

02 卷積神經(jīng)網(wǎng)絡(luò)

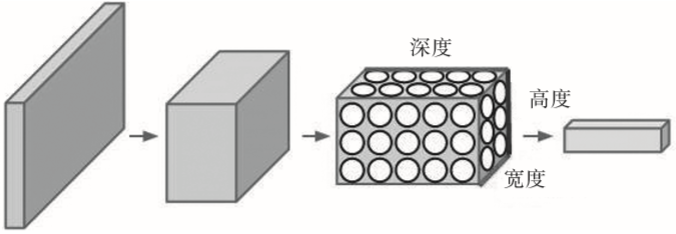

卷積神經(jīng)網(wǎng)絡(luò)(CNN)是一種專門用來處理具有類似網(wǎng)格結(jié)構(gòu)的數(shù)據(jù)的神經(jīng)網(wǎng)絡(luò),如圖像數(shù)據(jù)(可以看作二維的像素網(wǎng)格)。與FC不同的地方在于,CNN的上下層神經(jīng)元并不都能直接連接,而是通過“卷積核”作為中介,通過“核”的共享大大減少了隱藏層的參數(shù)。

簡單的CNN是一系列層,并且每個(gè)層都通過一個(gè)可微函數(shù)將一個(gè)量轉(zhuǎn)化為另一個(gè)量,這些層主要包括卷積層(Convolutional Layer)、池化層(Pooling Layer)和全連接層(FC Layer)。

卷積網(wǎng)絡(luò)在諸多應(yīng)用領(lǐng)域都有很好的應(yīng)用效果,特別是在大型圖像處理的場景中表現(xiàn)得格外出色。圖2-8展示了CNN的結(jié)構(gòu)形式,一個(gè)神經(jīng)元以三維排列組成卷積神經(jīng)網(wǎng)絡(luò)(寬度、高度和深度),如其中一個(gè)層展示的那樣,CNN的每一層都將3D的輸入量轉(zhuǎn)化成3D的輸出量。

▲圖2-8 CNN的結(jié)構(gòu)形式

03 循環(huán)神經(jīng)網(wǎng)絡(luò)

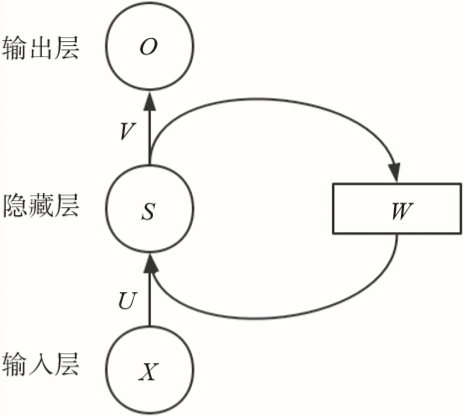

循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)也是常用的深度學(xué)習(xí)模型之一(如圖2-9所示),就像CNN是專門用于處理網(wǎng)格化數(shù)據(jù)(如一個(gè)圖像)的神經(jīng)網(wǎng)絡(luò),RNN是一種用于處理序列數(shù)據(jù)的神經(jīng)網(wǎng)絡(luò)。

如音頻中含有時(shí)間成分,因此音頻可以被表示為一維時(shí)間序列;語言中的單詞都是逐個(gè)出現(xiàn)的,因此語言的表示方式也是序列數(shù)據(jù)。RNN在機(jī)器翻譯、語音識別等領(lǐng)域中均有非常好的表現(xiàn)。

▲圖2-9?簡單的RNN結(jié)構(gòu)