用于語義分割的特征共享協(xié)作網(wǎng)絡(luò)

點(diǎn)擊上方“小白學(xué)視覺”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

近年來,深度神經(jīng)網(wǎng)絡(luò)在圖像識(shí)別領(lǐng)域取得了較高的精度。在借鑒人類學(xué)習(xí)方法的基礎(chǔ)上,提出了一種基于協(xié)作學(xué)習(xí)的語義分割方法。我們使用兩個(gè)相同的網(wǎng)絡(luò)和路徑在兩個(gè)網(wǎng)絡(luò)之間發(fā)送特征映射。同時(shí)訓(xùn)練兩個(gè)網(wǎng)絡(luò)。通過共享特征映射,兩個(gè)網(wǎng)絡(luò)中的一個(gè)可以獲得單個(gè)網(wǎng)絡(luò)無法獲得的信息。此外,為了提高合作程度,我們提出了只連接同一層和多層的兩種方法。我們?cè)趦煞N網(wǎng)絡(luò)上評(píng)估了我們提出的想法。一個(gè)是雙注意網(wǎng)絡(luò)(DANet),另一個(gè)是DeepLabv3+。與傳統(tǒng)的單一網(wǎng)絡(luò)和集成網(wǎng)絡(luò)相比,該方法具有更好的分割精度。

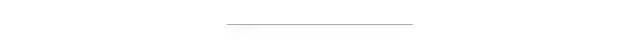

我們準(zhǔn)備兩個(gè)網(wǎng)絡(luò),并引入兩個(gè)網(wǎng)絡(luò)之間的連接,從頂部網(wǎng)絡(luò)獲得的特征映射可以發(fā)送到底部網(wǎng)絡(luò),并將兩個(gè)特征映射連接起來。由于這兩個(gè)網(wǎng)絡(luò)都訓(xùn)練來解決分割問題,為任務(wù)尋址好的信息被發(fā)送到底層網(wǎng)絡(luò)。因此,底層網(wǎng)絡(luò)可以利用從頂層網(wǎng)絡(luò)獲得的好的特征映射來解決任務(wù),而底層網(wǎng)絡(luò)則專注于頂層網(wǎng)絡(luò)無法解決的問題。由于底層網(wǎng)絡(luò)將上層網(wǎng)絡(luò)獲得的特征圖進(jìn)行拼接,拼接后的特征圖中濾波器的數(shù)量比原網(wǎng)絡(luò)多出兩倍。這就是我們?cè)诒疚闹刑岢龅暮献鲗W(xué)習(xí)。

在我們的方法中,我們采用了以下?lián)p失,因?yàn)槲覀兊姆椒ㄍ瑫r(shí)分別訓(xùn)練兩個(gè)cnn。我們使用Softmax交叉熵來計(jì)算損失(Loss = Loss1 + Loss2)其中Loss1為CNN1的Loss, Loss2為CNN2的Loss。兩種損耗同時(shí)得到優(yōu)化。在這種網(wǎng)絡(luò)結(jié)構(gòu)中,我們可以訓(xùn)練兩個(gè)網(wǎng)絡(luò),同時(shí)共享單個(gè)網(wǎng)絡(luò)無法獲得的特征映射。合作學(xué)習(xí)有幾個(gè)優(yōu)點(diǎn)。首先,我們可以通過使用兩個(gè)網(wǎng)絡(luò)之間的特征映射來增加有用信息的數(shù)量。由于第一個(gè)網(wǎng)絡(luò)解決了分割任務(wù),因此已經(jīng)獲得了解決該任務(wù)的特征。因此,第二網(wǎng)絡(luò)可以學(xué)習(xí)任務(wù)使用信息從第一個(gè)網(wǎng)絡(luò)作為參考。基于以上原因,我們認(rèn)為合作學(xué)習(xí)對(duì)于提高準(zhǔn)確性是有效的。

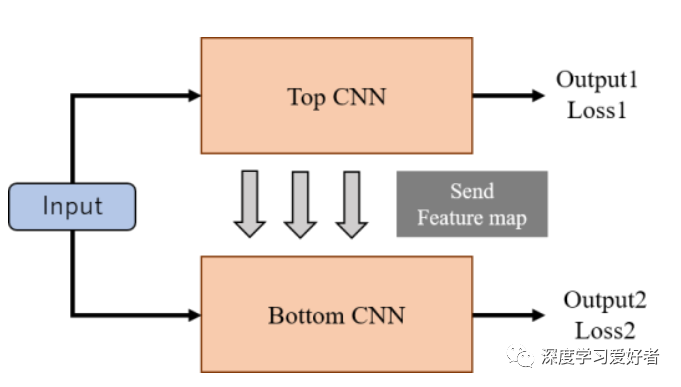

在本文中,我們提出了兩種合作學(xué)習(xí)的連接方法。第一種連接方法是在相同的層之間。第二種連接方法是多層之間的連接。下面的小節(jié)將解釋這兩種方法。通過與集成網(wǎng)絡(luò)的比較,驗(yàn)證了協(xié)同連接的有效性。集成網(wǎng)絡(luò)使用兩個(gè)相同的cnn。集成網(wǎng)絡(luò)與我們方法的區(qū)別如圖2 (a)所示。

圖1合作網(wǎng)絡(luò)的結(jié)構(gòu)

圖2集成網(wǎng)絡(luò)(a)和提出的協(xié)作網(wǎng)絡(luò)(b)(c)結(jié)構(gòu)

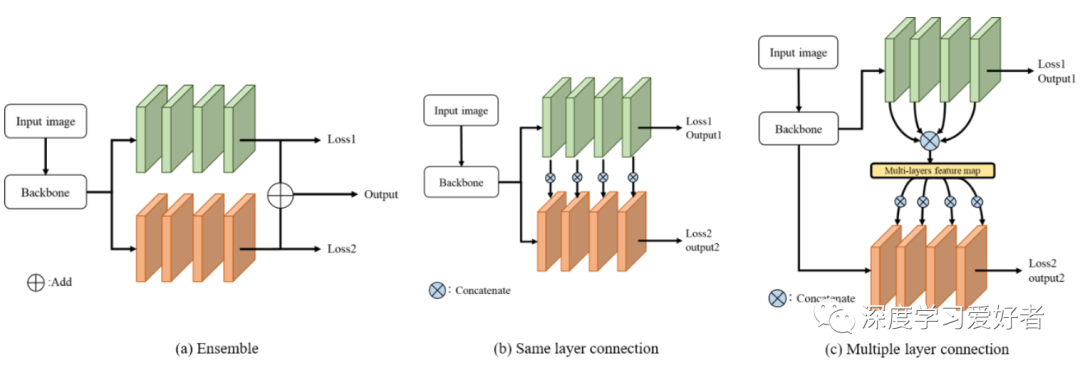

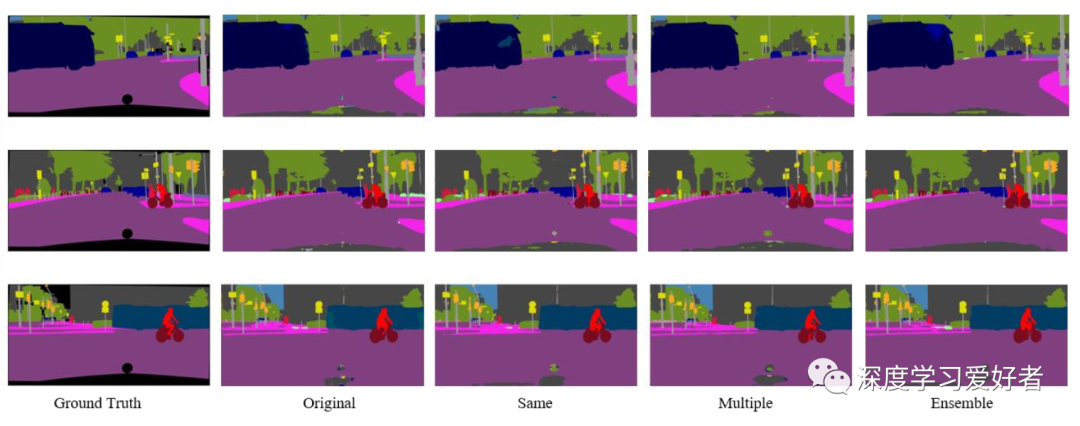

城市景觀數(shù)據(jù)集上的分割結(jié)果(val)。baseline是DANet。

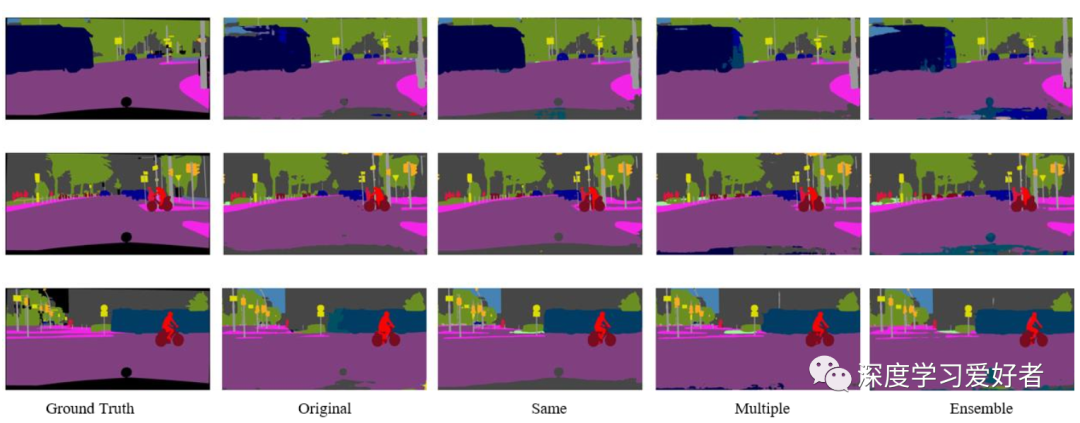

城市景觀數(shù)據(jù)集上的分割結(jié)果(val)。baseline為Deeplabv3+

通過以上實(shí)驗(yàn),我們證實(shí)了無論使用哪種基線網(wǎng)絡(luò),合作學(xué)習(xí)都能提高準(zhǔn)確率。對(duì)于DANet而言,采用同一層連接的合作學(xué)習(xí)比采用不同層連接的合作學(xué)習(xí)具有更高的準(zhǔn)確率。另一方面,DeepLabv3+的多層連接精度更高。從這些結(jié)果來看,最優(yōu)的連接方法依賴于基線CNN。DANet使用注意模塊對(duì)feature map進(jìn)行增強(qiáng)。因此,同一層連接可以使用對(duì)應(yīng)層的重要特征。另一方面,不同的層連接不能在不同的層上很好地使用這些特性。

在DeepLabv3+的情況下,使用一種編碼解碼器結(jié)構(gòu)來聚合多尺度信息。多層連接可以從多層中提供有效的信息。因此,DeepLabv3+結(jié)構(gòu)的多層連接獲得了較高的精度,因?yàn)閬碜圆煌瑢哟蔚脑S多信息可以幫助DeepLabv3+結(jié)構(gòu)獲得有效的信息。我們認(rèn)為采用一種簡(jiǎn)單的編譯碼結(jié)構(gòu)網(wǎng)絡(luò)是有效的不同層連接。如果我們?cè)趫D4中使用注意模塊。城市景觀數(shù)據(jù)集上的分割結(jié)果(val)。基線是由Deeplabv3+增強(qiáng)特征映射,同層連接的合作學(xué)習(xí)是有效的。

在實(shí)驗(yàn)中,我們將圖2(a)所示的網(wǎng)絡(luò)集成與提出的協(xié)作網(wǎng)絡(luò)進(jìn)行了比較。所提出的兩種連接方法比兩種網(wǎng)絡(luò)集成的方法更精確。通過兩種實(shí)驗(yàn)驗(yàn)證了該協(xié)作網(wǎng)絡(luò)的有效性。

論文鏈接:https://arxiv.org/pdf/2101.07905.pdf

交流群

歡迎加入公眾號(hào)讀者群一起和同行交流,目前有SLAM、三維視覺、傳感器、自動(dòng)駕駛、計(jì)算攝影、檢測(cè)、分割、識(shí)別、醫(yī)學(xué)影像、GAN、算法競(jìng)賽等微信群(以后會(huì)逐漸細(xì)分),請(qǐng)掃描下面微信號(hào)加群,備注:”昵稱+學(xué)校/公司+研究方向“,例如:”張三 + 上海交大 + 視覺SLAM“。請(qǐng)按照格式備注,否則不予通過。添加成功后會(huì)根據(jù)研究方向邀請(qǐng)進(jìn)入相關(guān)微信群。請(qǐng)勿在群內(nèi)發(fā)送廣告,否則會(huì)請(qǐng)出群,謝謝理解~