超實用性:盲噪聲的盲超分辨的非對稱卷積神經(jīng)網(wǎng)絡

點擊上方“程序員大白”,選擇“星標”公眾號

重磅干貨,第一時間送達

極市導讀

本文介紹一篇提出一種用于盲噪聲的盲超分辨的非對稱卷積神經(jīng)網(wǎng)絡的工作,該論文打破傳統(tǒng)的一個模型只能處理固定縮放因子的圖像超分辨問題,巧妙地通過一個網(wǎng)絡訓練出用于處理固定縮放因子的圖像超分辨、盲超分辨任務及盲噪聲的盲超分辨模型。

由哈爾濱工業(yè)大學、國立清華大學及香港中文大學的學者提出了一種用于盲噪聲的盲超分辨的非對稱卷積神經(jīng)網(wǎng)絡,該論文已經(jīng)在AriXv上發(fā)表。該論文打破傳統(tǒng)的一個模型只能處理固定縮放因子的圖像超分辨問題,該文巧妙地通過一個網(wǎng)絡訓練出用于處理固定縮放因子的圖像超分辨、盲超分辨任務及盲噪聲的盲超分辨模型,這對手機和相機等拍照設備具有較強的應用性。

論文題目:Asymmetric CNN for image super-resolution

作者: Chunwei Tian, Yong Xu, Wangmeng Zuo, Chia-Wen Lin and David Zhang

單位:哈爾濱工業(yè)大學、國立清華大學、香港中文大學

論文鏈接:https://arxiv.org/pdf/2103.13634.pdf

論文中給出的代碼鏈接:https://github.com/hellloxiaotian/ACNet

動機:

已有圖像超分辨的卷積神經(jīng)網(wǎng)絡都沒有考慮到局部特征點的作用,而直接通過殘差或者連接操作方法融合不同水平的特征,以提高預測超分辨圖像的質(zhì)量。但該操作會因信息冗余,導致訓練效率減慢。此外,已有圖像超分辨方法大部分都是通過一個縮放因子來訓練一個圖像超分辨模型,這與真實世界中收集到無固定尺寸的低分辨率圖像的復原是相悖的。因此,作者們提出了盲噪聲的盲超分辨的非對稱卷積神經(jīng)網(wǎng)絡。

思路:

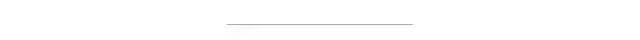

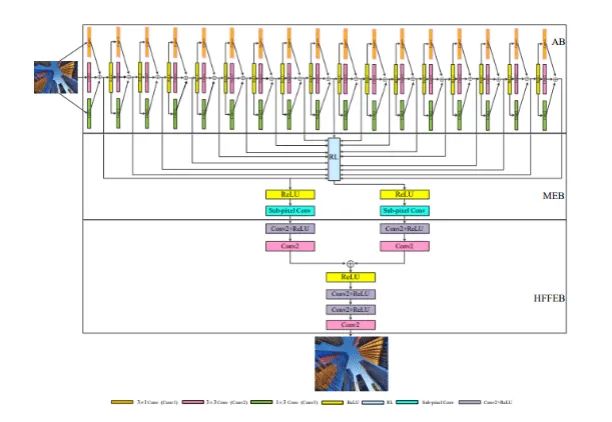

ACNet通過由3x1, 1x3和3x3組成的非對稱卷積結(jié)構在水平和豎直方向上增強方核卷積作用,突顯局部關鍵特征對SISR任務的作用和加快訓練效率,如網(wǎng)絡結(jié)構圖的AB塊所示;為了防止ACNet會因網(wǎng)絡深度加深而導致SR性能下降,ACNet利用殘差學習操作集成獲得網(wǎng)絡層次特征,這不僅強化低頻特征,同時該操作也通過充分考慮深度特征和寬度特征而使獲得低頻特征更魯棒,具體如網(wǎng)絡結(jié)構圖中非對稱塊(AB)所示;為了獲得盲超分辨模型及盲噪聲的盲超分辨模型,一組并行的子像素卷積技術(上采樣)被用到記憶增強塊(MEB)中,具體如MEB和上采樣結(jié)構圖;最好,為了防止上采樣過程中,模型不穩(wěn)定,高頻特征融合增強塊(HFFEB)結(jié)合獲得高頻特征和低頻特征學習得到更精準的超分辨特征,這樣能防止之前操作導致特征過分增強現(xiàn)象。為了全面驗證提出的ACNet在固定縮放因子圖像超分辨、盲圖像超分辨及盲噪聲的盲圖像超分辨上的好性能,本文選擇定量分析和定性分析設計驗證實驗,具體如下所示:

1.網(wǎng)絡結(jié)構圖 2.上采樣操作

2.上采樣操作

3.實驗設置

為了公平地設計實驗,本文選擇和2018 ECCV發(fā)表的CARN-M一樣的MSE作為損失函數(shù)及選擇Adam優(yōu)化器共同優(yōu)化參數(shù),其余初試參數(shù)如下:1.beta_1 0.9, beta_2 0.999;2.10-8的epsilon;3.660000步;4.Batch size為16;5.初始學習率為10-4,每400000步學習率減半。4.不同方法在不同數(shù)據(jù)集的SR結(jié)果 為了更全面證明本文提出方法的性能,這里選擇定量分析和定性分析來驗證ACNet在圖像超分辨上性能。

定量分析:

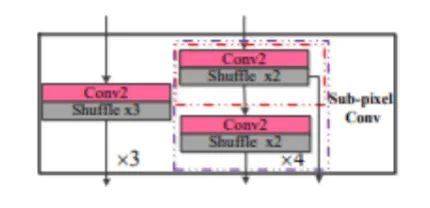

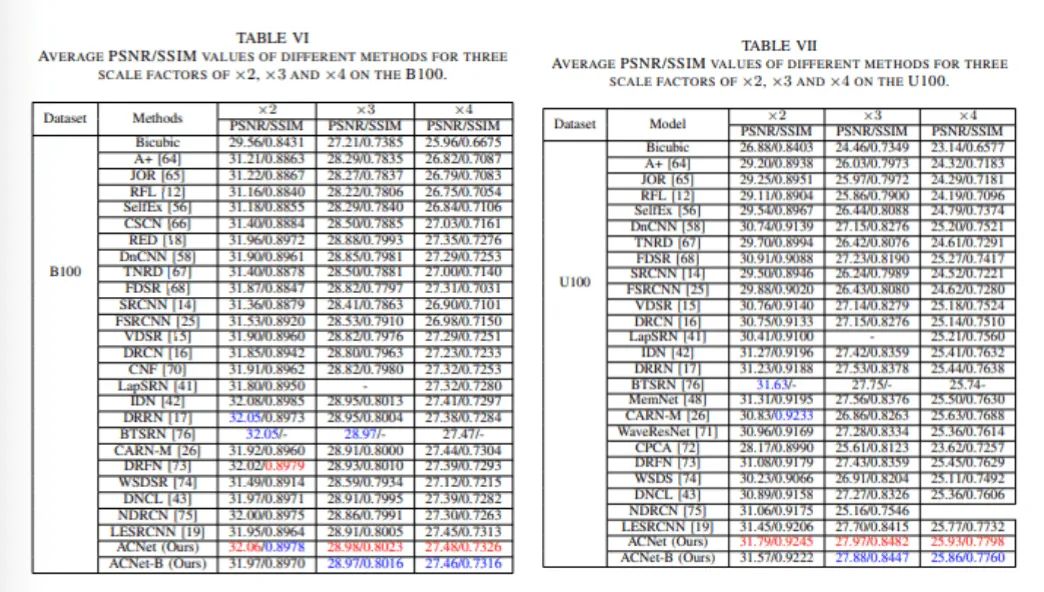

本文首先選擇在四個基準的超分辨數(shù)據(jù)集(Set5、Set14、B100和U100)上對于不同縮放因子(x2、x3和x4)測試不同方法的PSNR/SSIM。由表TABLE IV-TABLE VII可知,本文提出的ACNet和ACNet-B(盲超分辨模型)在不同數(shù)據(jù)集上對于不同縮放因子都取得具有競爭力的性能。

(1)不同方法在Set5和Set14數(shù)據(jù)集對于不同縮放因子的PSNR/SSIM值 (2)不同方法在B100和U100數(shù)據(jù)集對于不同縮放因子的PSNR/SSIM值

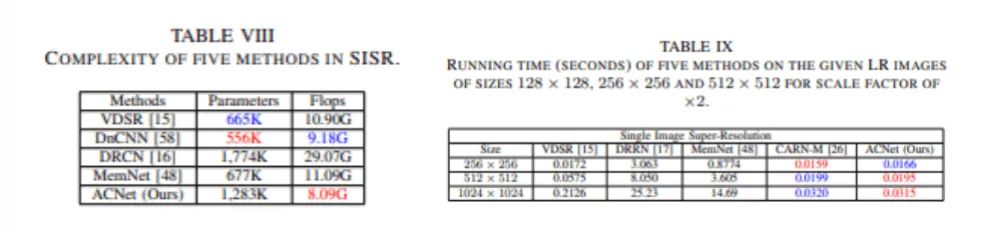

(2)不同方法在B100和U100數(shù)據(jù)集對于不同縮放因子的PSNR/SSIM值 其次,考慮到模型復雜度和恢復高質(zhì)量圖像的時間是衡量超分辨技術在數(shù)字設備上實用性的重要指標,本文利用選擇包括幾種經(jīng)典的方法(2016 CVPR-VDSR、2017 TIP-DnCNN、2016 CVPR-DRCN、2017 CVPR-DRRCN、 2017 CVPR MemNet和2018 ECCV CARN-M)來作為對比方法來設計實驗。通過表TABLE VIII中參數(shù)和FLOPS和表TABLE IX可知,本文提出的ACNet在復雜度和復原高質(zhì)量圖像的運行速度上與主流方法相比是非常有優(yōu)勢的。

其次,考慮到模型復雜度和恢復高質(zhì)量圖像的時間是衡量超分辨技術在數(shù)字設備上實用性的重要指標,本文利用選擇包括幾種經(jīng)典的方法(2016 CVPR-VDSR、2017 TIP-DnCNN、2016 CVPR-DRCN、2017 CVPR-DRRCN、 2017 CVPR MemNet和2018 ECCV CARN-M)來作為對比方法來設計實驗。通過表TABLE VIII中參數(shù)和FLOPS和表TABLE IX可知,本文提出的ACNet在復雜度和復原高質(zhì)量圖像的運行速度上與主流方法相比是非常有優(yōu)勢的。

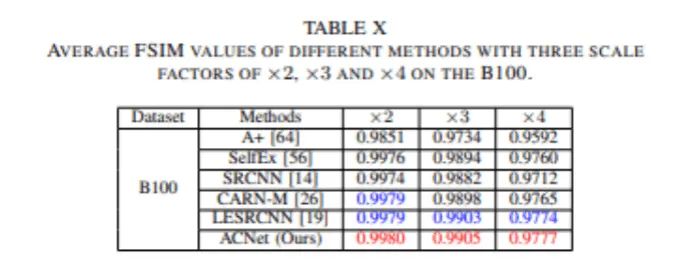

(3)復雜度和運行時間 接著,為了更全面測試本文提出的ACNet在感知方面也具有優(yōu)勢,本文利用圖像質(zhì)量評估方法FSIM來測試ACNet。由表TABLE X可知,本文提出的ACNet在不同縮放因子下比其他對比方法獲得更好FSIM值,這說明了ACNet在圖像質(zhì)量評估方法取得了更好的性能。(4)圖像質(zhì)量評估

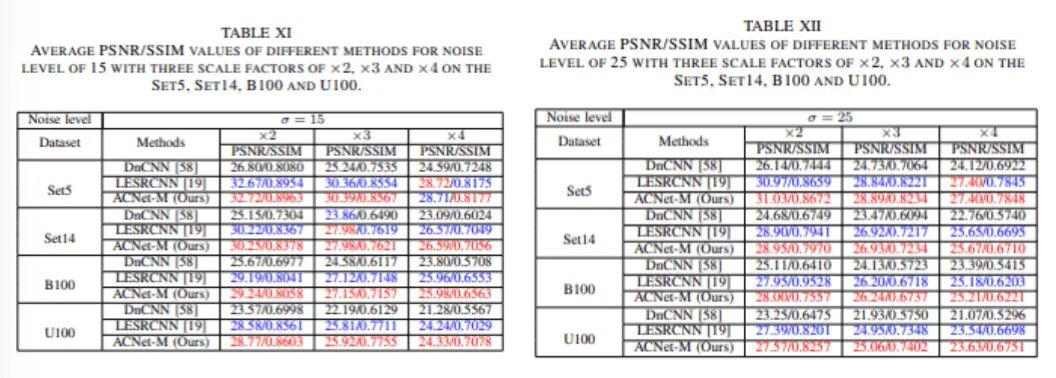

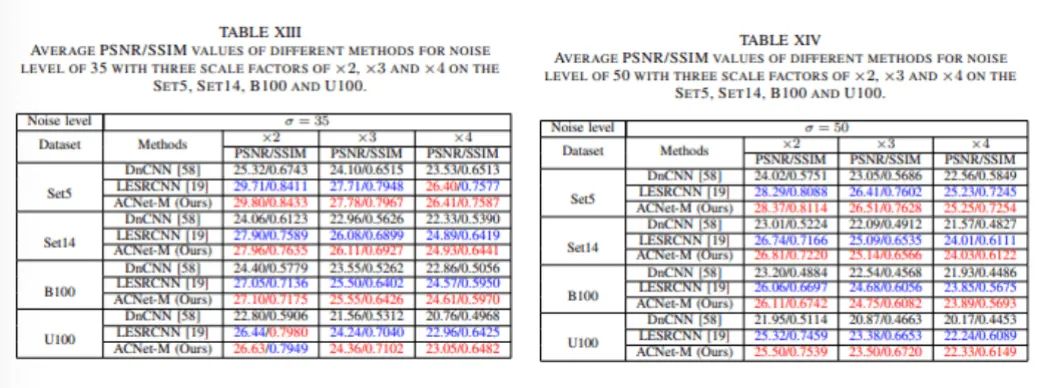

接著,為了更全面測試本文提出的ACNet在感知方面也具有優(yōu)勢,本文利用圖像質(zhì)量評估方法FSIM來測試ACNet。由表TABLE X可知,本文提出的ACNet在不同縮放因子下比其他對比方法獲得更好FSIM值,這說明了ACNet在圖像質(zhì)量評估方法取得了更好的性能。(4)圖像質(zhì)量評估 最后,為了測試本文提出的ACNet對于恢復帶有噪聲的低分辨圖像上也是有效的。本文設計不同數(shù)據(jù)集不同縮放因子條件下利用不同方法處理低頻噪聲的低分辨圖像和高頻高分辨率圖像。從表TABLE XI和TABLE XII中可知,本文提出的ACNet在恢復低頻15和25的不同縮放因子的低分辨圖像比其他經(jīng)典深度學習去噪方法DnCNN和圖像超分辨方法LESRCNN更有效。從表TABLE XIII和TABLE XIV中可知,本文提出的ACNet在恢復低頻35和50的不同縮放因子的低分辨圖像比其他經(jīng)典深度學習去噪方法DnCNN和圖像超分辨方法LESRCNN更有效。其中,ACNet-M是包含盲噪聲的盲超分辨模型。由以上可知,本文提出的ACNet在恢復低頻噪聲低分辨圖像和高頻噪聲高水平圖像的都具有良好的魯棒性。

最后,為了測試本文提出的ACNet對于恢復帶有噪聲的低分辨圖像上也是有效的。本文設計不同數(shù)據(jù)集不同縮放因子條件下利用不同方法處理低頻噪聲的低分辨圖像和高頻高分辨率圖像。從表TABLE XI和TABLE XII中可知,本文提出的ACNet在恢復低頻15和25的不同縮放因子的低分辨圖像比其他經(jīng)典深度學習去噪方法DnCNN和圖像超分辨方法LESRCNN更有效。從表TABLE XIII和TABLE XIV中可知,本文提出的ACNet在恢復低頻35和50的不同縮放因子的低分辨圖像比其他經(jīng)典深度學習去噪方法DnCNN和圖像超分辨方法LESRCNN更有效。其中,ACNet-M是包含盲噪聲的盲超分辨模型。由以上可知,本文提出的ACNet在恢復低頻噪聲低分辨圖像和高頻噪聲高水平圖像的都具有良好的魯棒性。

(5)包含低頻噪聲的低分辨圖像復原結(jié)果

(6)包含高頻噪聲的低分辨圖像復原結(jié)果

定性分析:

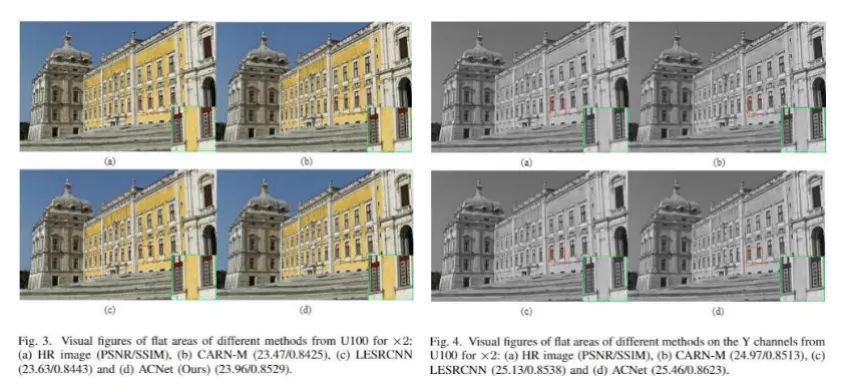

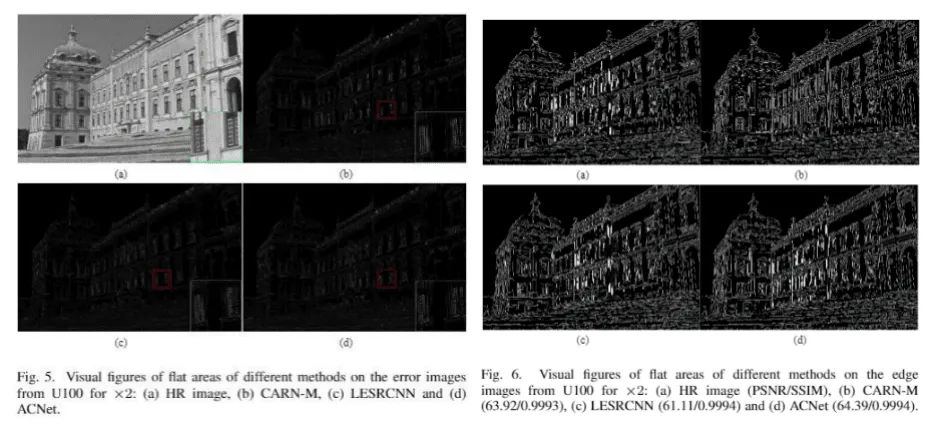

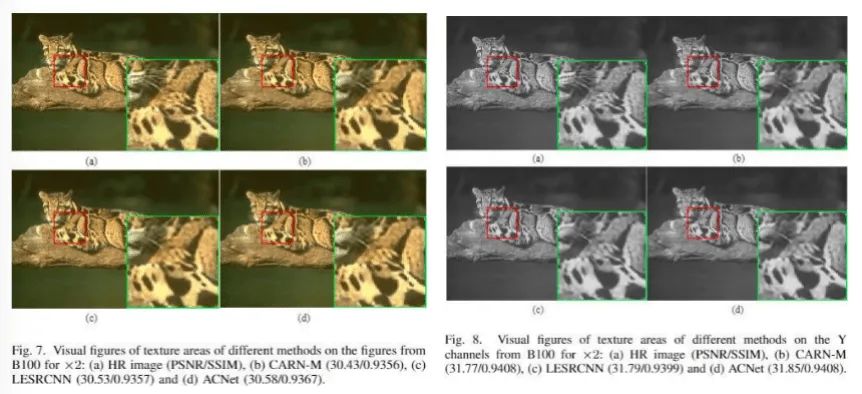

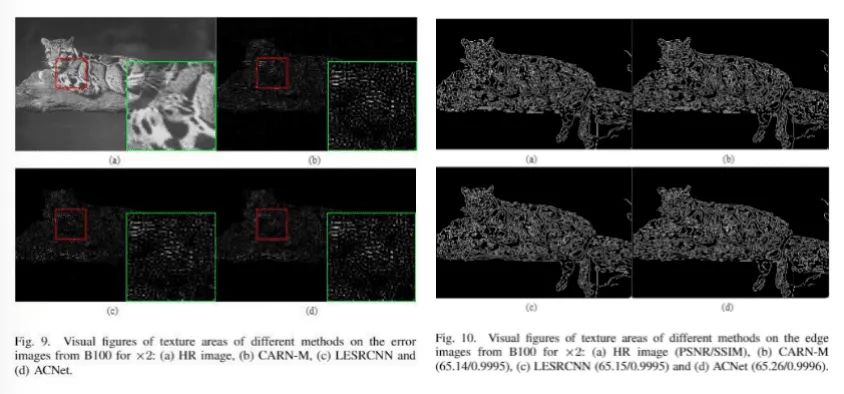

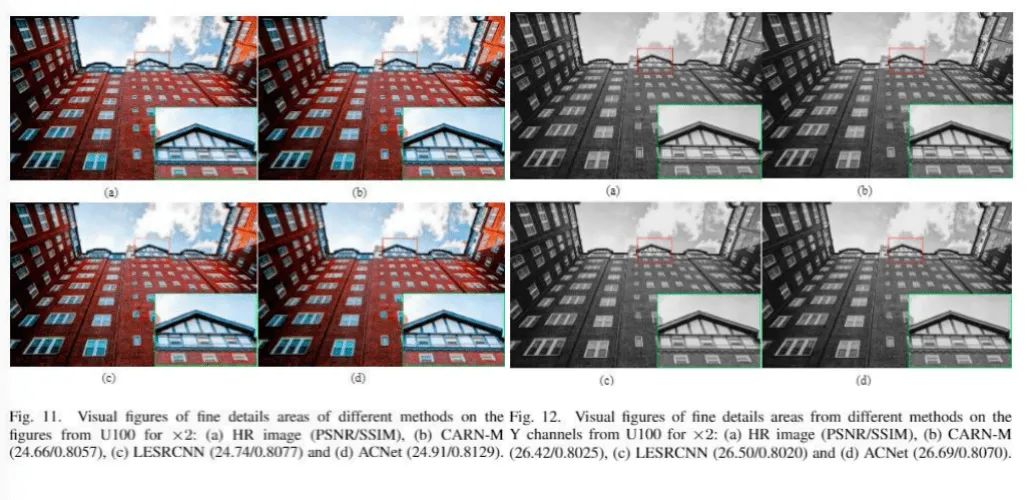

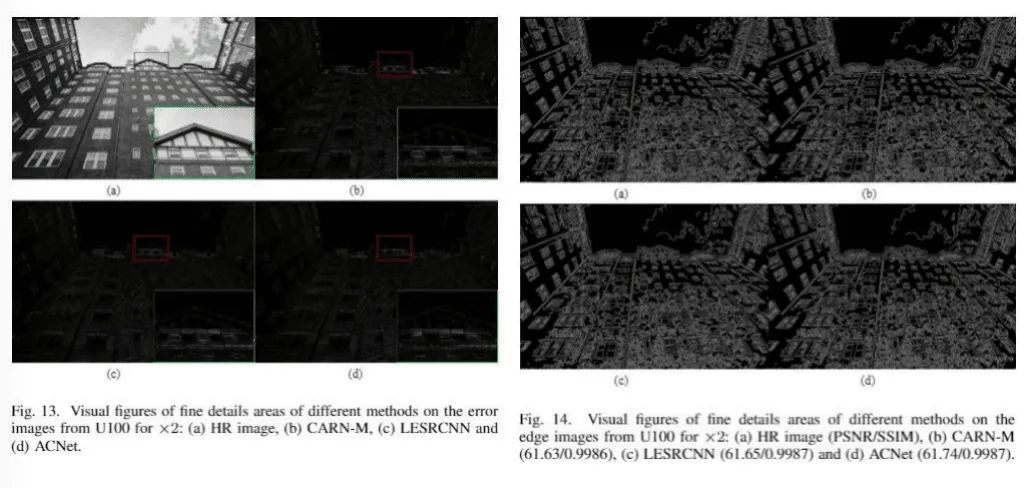

本文選擇在高清圖像、Y通道圖像、錯誤圖像(預測高質(zhì)量圖像與給出的高質(zhì)量圖像)、邊緣圖像上選擇一個區(qū)域來測試平坦、紋理及恢復細節(jié)信息好壞等。對于高清圖像、Y通道圖像及邊緣圖像來說,選擇的觀察區(qū)越清晰,代表對應的超分辨方法性能越好。對于錯誤圖像來說,細節(jié)信息越少,代表對應的超分辨性能越好。從圖3-圖13可知,本文提出的ACNet從不同視角的可視化圖像上均驗證它在圖像超分辨任務上強的魯棒性。

(7)獲得高清圖像和Y通道圖像的平坦區(qū)域可視化結(jié)果 (8)獲得錯誤圖像和邊緣圖像的平坦區(qū)域可視化結(jié)果

(8)獲得錯誤圖像和邊緣圖像的平坦區(qū)域可視化結(jié)果

(9)獲得高清圖像和Y圖像的紋理區(qū)域可視化結(jié)果 (10)獲得錯誤圖像和邊緣圖像的紋理區(qū)域可視化結(jié)果

(10)獲得錯誤圖像和邊緣圖像的紋理區(qū)域可視化結(jié)果 (11)獲得高清圖像和Y圖像的細節(jié)信息區(qū)域可視化結(jié)果

(11)獲得高清圖像和Y圖像的細節(jié)信息區(qū)域可視化結(jié)果

(12)獲得錯誤圖像和邊緣圖像的細節(jié)信息區(qū)域可視化結(jié)果

結(jié)論:

作者們從網(wǎng)絡設計和功能出發(fā)提出一種實用性的超分辨網(wǎng)絡。通過非對稱卷積核的作用在不同方向上增強局部關鍵特征對圖像超分辨的作用。該操作不僅提高了圖像超分辨性能,也加快訓練效率。此外,作者們通過并行上采樣技術使一個模型能解決固定縮放因子的圖像超分辨、盲超分辨、盲噪聲的盲超分辨問題,這使用戶或者開發(fā)者能根據(jù)各自需求,選擇不同功能。

推薦閱讀

國產(chǎn)小眾瀏覽器因屏蔽視頻廣告,被索賠100萬(后續(xù))

年輕人“不講武德”:因看黃片上癮,把網(wǎng)站和786名女主播起訴了

關于程序員大白

程序員大白是一群哈工大,東北大學,西湖大學和上海交通大學的碩士博士運營維護的號,大家樂于分享高質(zhì)量文章,喜歡總結(jié)知識,歡迎關注[程序員大白],大家一起學習進步!