【NLP】Contrastive Learning NLP Papers

來(lái)自 | 知乎

作者 | 光某人

地址 | https://zhuanlan.zhihu.com/p/363900943

編輯 | 機(jī)器學(xué)習(xí)算法與自然語(yǔ)言處理公眾號(hào)

本文僅作學(xué)術(shù)分享,若侵權(quán),請(qǐng)聯(lián)系后臺(tái)刪文處理

具體知識(shí)請(qǐng)參閱我之前的文章:

https://zhuanlan.zhihu.com/p/346686467

這里的論文我會(huì)慢慢更新【最近組里活挺多的,慢慢來(lái)】

1.解決NMT的單詞遺漏[acl2019]

論文標(biāo)題:Reducing Word Omission Errors in Neural Machine Translation: A Contrastive Learning Approach

論文鏈接:aclweb.org/anthology/P1

1.0 問(wèn)題

NMT系統(tǒng)容易省略基本單詞,會(huì)減弱機(jī)器翻譯的充分性。

由于神經(jīng)網(wǎng)絡(luò)缺乏可解釋性,很難解釋這些遺漏錯(cuò)誤是如何發(fā)生的,也很難用邏輯規(guī)則的方式來(lái)消除它們。

所以本文采用對(duì)比學(xué)習(xí)的方法來(lái)顯式地解決這個(gè)問(wèn)題。

示例:

I love it so much that I cannot sleep well.  我太喜歡它 (了以至于 ) 我夜不能寐

我太喜歡它 (了以至于 ) 我夜不能寐

1.1 使用CL動(dòng)機(jī)

適應(yīng)性強(qiáng):可以對(duì)所有NMT模型加入CL進(jìn)行對(duì)比學(xué)習(xí)來(lái)微調(diào)缺省后句向量與原向量距離。

語(yǔ)言獨(dú)立性強(qiáng):方法是獨(dú)立于語(yǔ)言的,可以應(yīng)用于任何語(yǔ)言。

訓(xùn)練快:對(duì)比學(xué)習(xí)從一個(gè)預(yù)先訓(xùn)練的NMT模型開(kāi)始,通常只有幾百個(gè)步驟。

用對(duì)比學(xué)習(xí)的思想解決該問(wèn)題,其基本思想仍然與對(duì)比學(xué)習(xí)的思想是一致的:

使NMT模型能夠?qū)⒏叩母怕史峙浣o真實(shí)(ground-truth)翻譯,而將較低的概率分配給錯(cuò)誤翻譯。

根據(jù)真實(shí)翻譯進(jìn)行省略詞數(shù)、改變?cè)~頻和詞性設(shè)計(jì)不同類(lèi)型的負(fù)實(shí)例,進(jìn)行數(shù)據(jù)增強(qiáng)。

1.2 如何使用CL

輸入:并行訓(xùn)練集  ,包含已翻譯好的句子對(duì)

,包含已翻譯好的句子對(duì)

輸出:無(wú)缺漏翻譯的句子

用隨機(jī)初始化獲得D的最大似然估計(jì)

構(gòu)建否定集

在

基礎(chǔ)上用對(duì)比學(xué)習(xí)獲得

基礎(chǔ)上用對(duì)比學(xué)習(xí)獲得  上的

上的

第一步,在平行語(yǔ)料庫(kù)(1-2行)上使用最大似然估計(jì)(MLE)訓(xùn)練模型獲得絕對(duì)空間向量。

在第二步中,通過(guò)省略ground-truth翻譯中的單詞來(lái)自動(dòng)構(gòu)建否定例(第3行)。

在第三步中,以估計(jì)最大似然值為起點(diǎn),使用對(duì)比學(xué)習(xí)對(duì)模型進(jìn)行微調(diào)。

1.3 聯(lián)合Loss

找到一組模型參數(shù),使訓(xùn)練集進(jìn)行正常翻譯的對(duì)數(shù)似然最大化:

1.4 數(shù)據(jù)增強(qiáng)

基于并行語(yǔ)料庫(kù)中的真實(shí)實(shí)例對(duì)構(gòu)建負(fù)實(shí)例。

基于以下幾種規(guī)則對(duì)數(shù)據(jù)構(gòu)建負(fù)實(shí)例:

隨意省略。

按單詞頻率省略。

按詞性省略。

1.5 對(duì)比損失【Triplet Loss變形】

這里是N個(gè)不同負(fù)樣本平均概率與1個(gè)正樣本間的概率差要趨向于margin 。本文實(shí)驗(yàn)取N=1。

1.6 實(shí)驗(yàn)

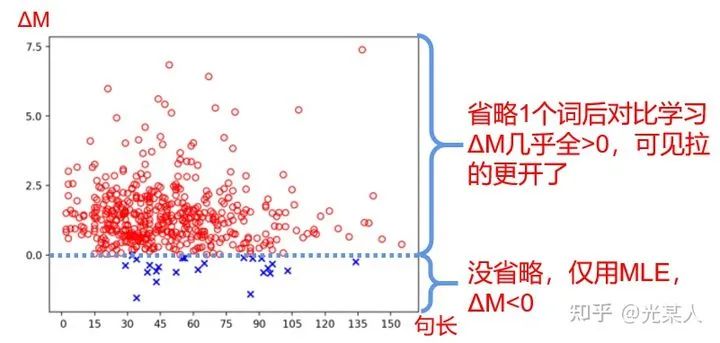

文章定義了margin difference 來(lái)衡量margin的大小。

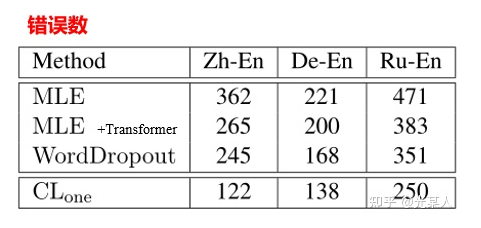

效果:

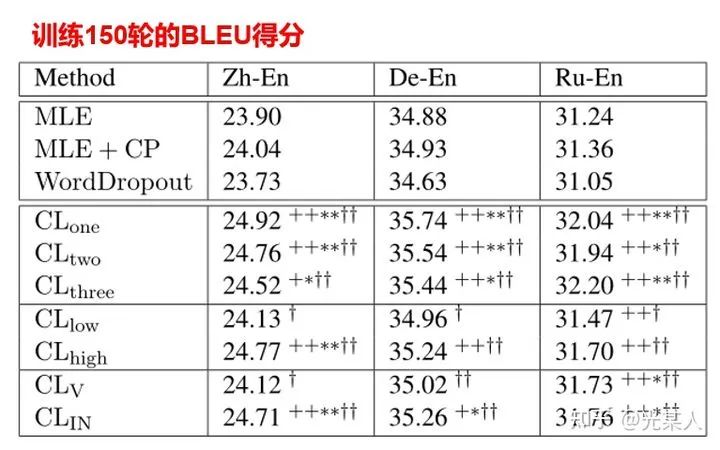

然后作者也對(duì)不同省略方法進(jìn)行拆解比較其效果:

注:  指隨機(jī)省略1,2,3個(gè)詞進(jìn)行對(duì)比學(xué)習(xí)。

指隨機(jī)省略1,2,3個(gè)詞進(jìn)行對(duì)比學(xué)習(xí)。  指隨機(jī)省略低頻詞,高頻詞。

指隨機(jī)省略低頻詞,高頻詞。  指隨機(jī)省略動(dòng)詞或介詞。

指隨機(jī)省略動(dòng)詞或介詞。

首先,我們可以看到CL收斂還是很快的,而且,對(duì)于省略來(lái)說(shuō),隨機(jī)省略一個(gè)詞,省略高頻詞,省略介詞,對(duì)比學(xué)習(xí)效果最好。

2. 常識(shí)推理的對(duì)比性自我監(jiān)督學(xué)習(xí)

論文標(biāo)題:Contrastive Self-Supervised Learning for Commonsense Reasoning

論文鏈接:aclweb.org/anthology/20

代碼鏈接:github.com/SAP-samples/

2.0 問(wèn)題

該文章提出了一種自監(jiān)督的方法來(lái)解決指代消解(Pronoun Disambiguation)和 Winograd Schema Challenge 問(wèn)題,減少目前監(jiān)督方法對(duì)常識(shí)推理的限制 。

示例:

“它”指:

這件衣服放不進(jìn)這箱子,因?yàn)?span style="font-weight: 600;">它太大 了

A.衣服 B.箱子

這件衣服放不進(jìn)這箱子,因?yàn)?span style="font-weight: 600;">它太小 了

A.衣服 B.箱子

2.1 使用CL動(dòng)機(jī)

訓(xùn)練快:對(duì)比學(xué)習(xí)能夠較好的穩(wěn)定優(yōu)化和加快收斂速度。

自動(dòng)化尋找差異:采用該方式進(jìn)行正則化,用于尋求語(yǔ)言模型中個(gè)體候選概率的最大差異。

2.2 如何使用CL

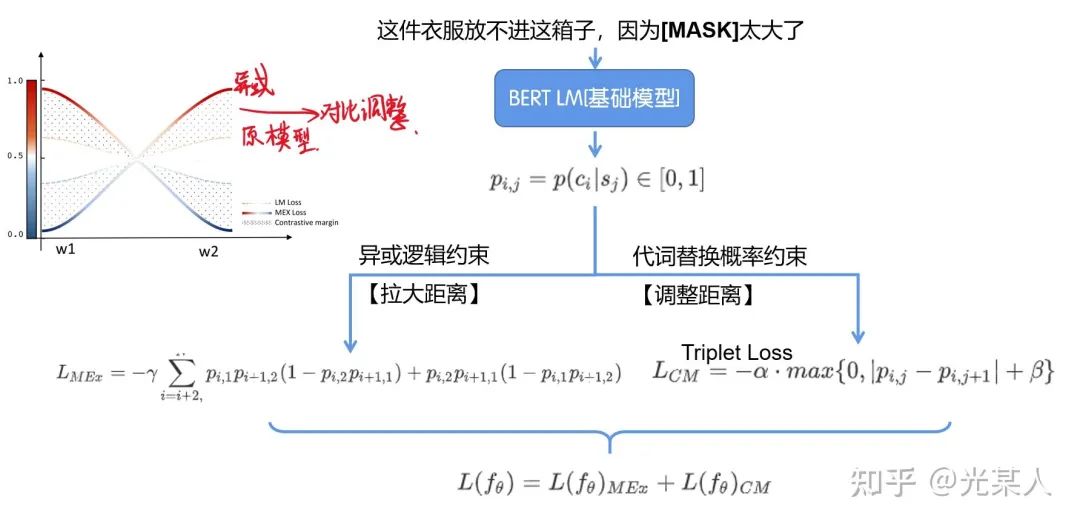

2.2.1 互斥損失

該文章利用了與所謂的觸發(fā)詞相關(guān)的訓(xùn)練語(yǔ)料庫(kù)的特征結(jié)構(gòu),它負(fù)責(zé)在代詞消解中翻轉(zhuǎn)答案,從而構(gòu)造兩兩對(duì)比的輔助預(yù)測(cè)來(lái)實(shí)現(xiàn)這樣的常識(shí)推理。

在上面的示例中,big,small充當(dāng)觸發(fā)詞,這兩個(gè)選項(xiàng)包含文中所有的實(shí)體,那么二者存在異或的關(guān)系,即要么A成立,要么B成立。考慮到觸發(fā)詞所建立的上下文,候選答案A在第一句中要么是對(duì)的,要么在第二句中是對(duì)的【另一句是錯(cuò)的】。

則有異或關(guān)系

所以對(duì)于  ,

,

從例子中可以看出,觸發(fā)詞產(chǎn)生了訓(xùn)練對(duì)的相互排斥關(guān)系。該方法的目標(biāo)是將這種成對(duì)關(guān)系作為訓(xùn)練階段的唯一監(jiān)督信號(hào)。所以這里引入 互斥損失(Mutual Exclusive (MEx) loss),最大限度地提高這兩個(gè)看似合理的候選項(xiàng)的相互排斥概率。

具體來(lái)說(shuō),給定一對(duì)訓(xùn)練句子,將要解決的代詞從句子中屏蔽(mask)掉,并使用語(yǔ)言模型來(lái)預(yù)測(cè)這樣的候選詞中只有一個(gè)可以填充mask的位置,而填充互斥條件。

2.2.2 原始CL

因?yàn)榧偃缭瓉?lái)是正確的指代,那么被交換的指代就是負(fù)例了,那么就采用Triplet Loss:

2.3 聯(lián)合Loss

所以二者聯(lián)合即可

2.4 整體結(jié)構(gòu)

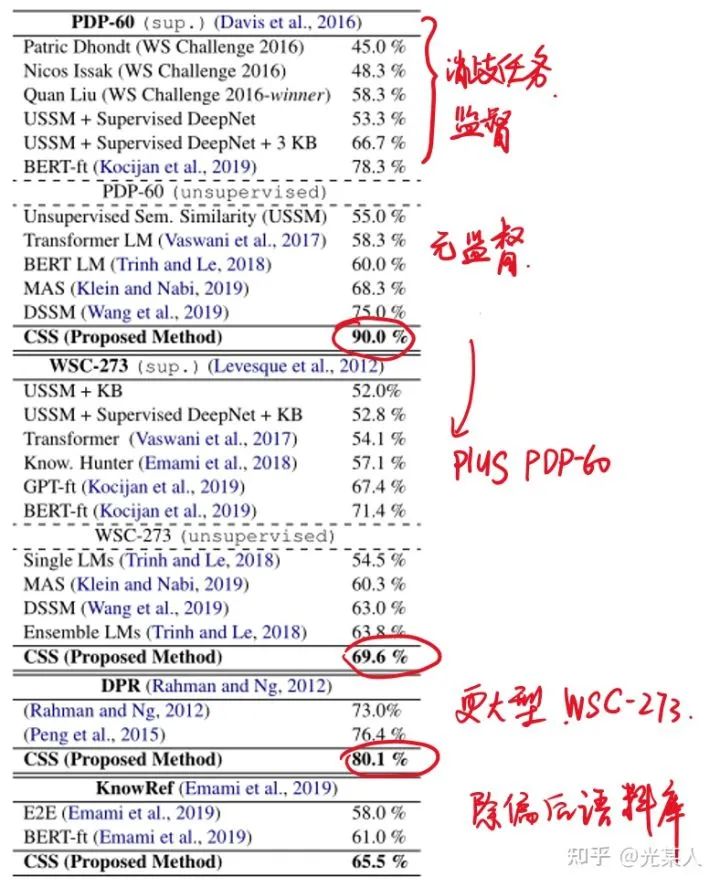

2.5 試驗(yàn)結(jié)果

往期精彩回顧

本站qq群851320808,加入微信群請(qǐng)掃碼: