語(yǔ)義分割入門(mén)的總結(jié)

點(diǎn)擊上方“小白學(xué)視覺(jué)”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

作者:Yanpeng Sun

https://zhuanlan.zhihu.com/p/74318967

聲明:僅做學(xué)術(shù)分享,侵刪

目的:給定一張圖像,我們要對(duì)這張圖像上的每個(gè)pixel逐一進(jìn)行分類(lèi),結(jié)果展示如下圖:

上圖中的實(shí)例分割是語(yǔ)義分割的延伸,要區(qū)別出相同類(lèi)別的不同個(gè)體。

應(yīng)用場(chǎng)景:無(wú)人駕駛、輔助醫(yī)療等。

1.灰度分割(Gray Level Segmentation)

語(yǔ)義分割的最簡(jiǎn)單形式是對(duì)一個(gè)區(qū)域設(shè)定必須滿足的硬編碼規(guī)則或?qū)傩裕M(jìn)而指定特定類(lèi)別標(biāo)簽. 編碼規(guī)則可以根據(jù)像素的屬性來(lái)構(gòu)建,如灰度級(jí)強(qiáng)度(gray level intensity). 基于該技術(shù)的一種分割方法是 Split and Merge 算法. 該算法是通過(guò)遞歸地將圖像分割為子區(qū)域,直到可以分配標(biāo)簽;然后再合并具有相同標(biāo)簽的相鄰子區(qū)域。

這種方法的問(wèn)題是規(guī)則必須是硬編碼的. 而且,僅使用灰度級(jí)信息是很難表示比如人類(lèi)等復(fù)雜類(lèi)別的. 因此,需要特征提取和優(yōu)化技術(shù)來(lái)正確地學(xué)習(xí)復(fù)雜類(lèi)別的特征表示。

2.條件隨機(jī)場(chǎng)(Conditional Random Fields)

CRFs 是一類(lèi)用于結(jié)構(gòu)化預(yù)測(cè)的統(tǒng)計(jì)建模方法. 不同于分類(lèi)算法,CRFs 在進(jìn)行預(yù)測(cè)前,會(huì)考慮像素的鄰近信息(neighboring context),如像素間的關(guān)系. 這使得 CRFs 成為語(yǔ)義分割的理想候選者. 這里介紹下 CRFs 在語(yǔ)義分割中的應(yīng)用.

圖像中的每個(gè)像素都是與有限的可能狀態(tài)集相關(guān). 在語(yǔ)義分割中,target 類(lèi)別標(biāo)簽就是可能狀態(tài)集. 將一個(gè)狀態(tài)(或,label u) 分配給的單個(gè)像素 x 的成本(cost) 被稱(chēng)為一元成本(unary cost). 為了對(duì)像素間的關(guān)系進(jìn)行建模, 還進(jìn)一步考慮將一對(duì)標(biāo)簽(labels (u, v)) 分配給一對(duì)像素 (x, y),其被成為成對(duì)成本(pairwise cost). 可以采用直接相鄰的像素對(duì)作為像素對(duì)(Grid CRF);也可以采用圖像中所有的像素構(gòu)建像素對(duì)(Denser CRF)。

圖像中所有 unary cost 和 pairwise cost 的相加和作為 CRF 的能量函數(shù)(或損失函數(shù),loss). 求解最小化即可得到較好的分割輸出。

深度學(xué)習(xí)極大地簡(jiǎn)化了語(yǔ)義分割的流程(pipeline),并得到了較高質(zhì)量的分割結(jié)果

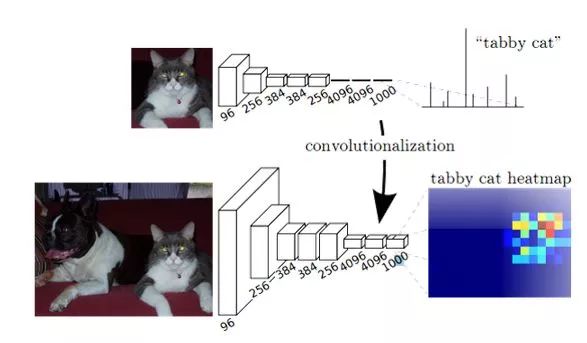

3.FCN

FCN方法的提出成功的將深度學(xué)習(xí)方法成功的引入到了語(yǔ)義分割領(lǐng)域,由于要預(yù)測(cè)的圖像是一個(gè)二維的表示,因此提出了全卷積網(wǎng)絡(luò)用來(lái)抽取圖像中的特征,將得到的高級(jí)語(yǔ)義特征上采樣到指定的維度,從而得到了最終的預(yù)測(cè)結(jié)果,從而自然的形成了Encoder-Decoder框架,這也成為了語(yǔ)義分割領(lǐng)域中通用框架之一。

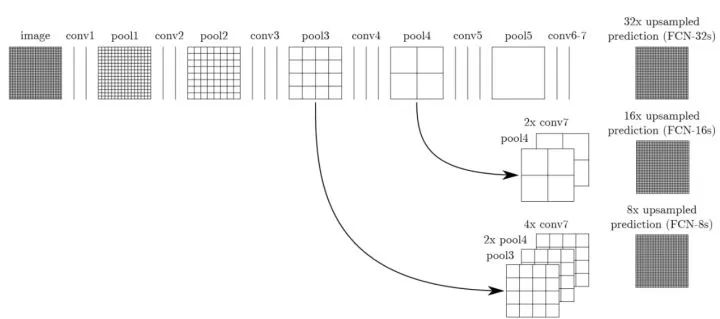

具體的模型圖如下:

由于在Encoder中獲取到圖像的高級(jí)語(yǔ)義,但是其并不是最終分割的結(jié)果,因此作者采用轉(zhuǎn)置卷積的方法將該高級(jí)特征上采樣到指定的維度,從而得到最終的分割結(jié)果。由于直接上采樣之后的結(jié)果并不好,因此在改論文中引入了跳躍模型就是將不同卷積層下獲取到的特征相融合,從而改善模型的效果,其具體結(jié)構(gòu)如下所示:

4.U-NET, SegNet 等

為了改善FCN中的弊端,隨后提出了很多模型最經(jīng)典的是U-Net,SegNet,但是他們的本質(zhì)上并沒(méi)有改變Encoder-Decoder模型的架構(gòu)。

5.DeepLab系列

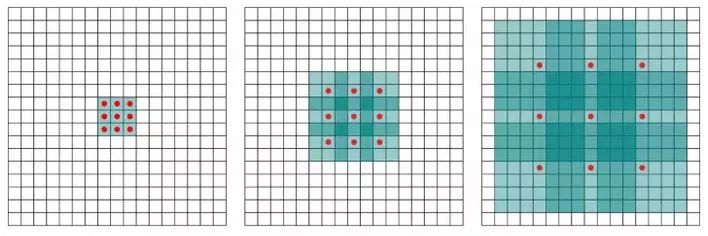

DeepLab的出現(xiàn)帶來(lái)了一個(gè)新的方法就是擴(kuò)展卷積(空洞卷積)方法,卷積層引入了一個(gè)稱(chēng)為 “擴(kuò)張率(dilation rate)”的新參數(shù),該參數(shù)定義了卷積核處理數(shù)據(jù)時(shí)各值的間距。其目的是為了擴(kuò)大模型的感受野,使其能夠感受到更大范圍下的特征信息。具體的體現(xiàn)如下所示:

擴(kuò)展卷積方法的提出讓人們可以去除Encoder-Decoder框架的限制。隨后deeplab算法的改進(jìn)也提出了例如多尺度學(xué)習(xí)的通則紅描述方法(ASPP等)

6.NOW

面對(duì)監(jiān)督式方法---最近的方法大家更注重于實(shí)時(shí)的語(yǔ)義分割任務(wù),也就是輕量級(jí)的語(yǔ)義分割網(wǎng)絡(luò)的設(shè)計(jì)。當(dāng)然還有一些其他的方法,例如針對(duì)不同的領(lǐng)域設(shè)計(jì)不同的語(yǔ)義分割網(wǎng)絡(luò)、改進(jìn)上采樣方法等。

面對(duì)弱監(jiān)督方法---目前出現(xiàn)了很多弱監(jiān)督方法,就是通過(guò)學(xué)習(xí)圖像分類(lèi)的數(shù)據(jù)集(image-level tag)中的信息,來(lái)完成語(yǔ)義分割這種密度預(yù)測(cè)的任務(wù)。當(dāng)然還有使用框架注釋來(lái)標(biāo)注數(shù)據(jù)(bounding-boxes tag)的。

1、數(shù)據(jù)問(wèn)題:分割不像檢測(cè)等任務(wù),只需要標(biāo)注一個(gè)類(lèi)別就可以拿來(lái)使用,分割需要精確的像素級(jí)標(biāo)注,包括每一個(gè)目標(biāo)的輪廓等信息,因此使得制作數(shù)據(jù)集成本過(guò)高;

2、計(jì)算資源問(wèn)題:現(xiàn)在想要得到較高的精度的語(yǔ)義分割模型就需要使用類(lèi)似于ResNet101等深網(wǎng)絡(luò)。同時(shí),分割預(yù)測(cè)了每一個(gè)像素,這就要求feature map的分辨率盡可能的高,這都說(shuō)明了計(jì)算資源的問(wèn)題,雖然也有一些輕量級(jí)的網(wǎng)絡(luò),但精度還是太低了;

3、精細(xì)分割:目前的方法中對(duì)于圖像中的大體積的東西能夠很好的分類(lèi),但是對(duì)于細(xì)小的類(lèi)別,由于其輪廓太小,從而無(wú)法精確的定位輪廓,造成精度較低;

4、上下文信息:分割中上下文信息很重要,否則會(huì)造成一個(gè)目標(biāo)被分成多個(gè)part,或者不同類(lèi)別目標(biāo)分類(lèi)成相同類(lèi)別;

評(píng)價(jià)指標(biāo):

1、執(zhí)行時(shí)間:速度或運(yùn)行時(shí)間是一個(gè)非常有價(jià)值的度量,因?yàn)榇蠖鄶?shù)系統(tǒng)需要保證推理時(shí)間可以滿足硬實(shí)時(shí)的需求。然而在通常的實(shí)驗(yàn)中其影響是很不明顯的,并且該指標(biāo)非常依賴硬件設(shè)備及后臺(tái)實(shí)現(xiàn),致使一些比較是無(wú)用的。

2、內(nèi)存占用:在運(yùn)行時(shí)間相同的情況下,記錄系統(tǒng)運(yùn)行狀態(tài)下內(nèi)存占用的極值和均值是及其有價(jià)值的。

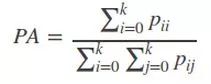

3、精確度:這里指的是逐像素標(biāo)記的精度測(cè)量,假設(shè)共有k個(gè)類(lèi)(從l0到lk其中有一個(gè)類(lèi)別是屬于背景的。),Pij表示本屬于i類(lèi)但是被預(yù)測(cè)為j類(lèi)的像素個(gè)數(shù),Pii表示為真正分對(duì)類(lèi)的數(shù)量,而Pij與Pji分別被稱(chēng)為假正樣本和假負(fù)樣本。

1)Pixel Accuracy(PA,像素精度):標(biāo)記正確的像素占總像素的比例

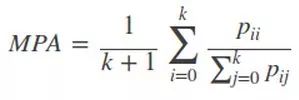

2)Mean Pixel Accuracy(MPA,平均像素精度):計(jì)算每個(gè)類(lèi)內(nèi)被正確分類(lèi)像素?cái)?shù)比例,之后求所有類(lèi)的平均數(shù)。

3)Mean Intersection over Union(MIoU,均交并比):為語(yǔ)義分割的標(biāo)準(zhǔn)度量,其計(jì)算兩個(gè)集合的交集和并集之比,這兩個(gè)集合分別為ground truth 與predicted segmentation,在每個(gè)類(lèi)上計(jì)算IoU,之后將其求平均。

-----IoU即真正樣本數(shù)量/(真正樣本數(shù)量+假正樣本數(shù)量+假負(fù)樣本數(shù)量)

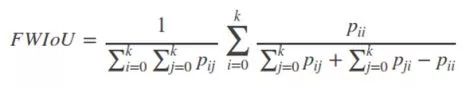

4)Frequency weighted Intersection over Union(FWIoU,頻權(quán)交并):是MIoU的一種提升,這種方法根據(jù)每個(gè)類(lèi)出現(xiàn)的頻率為期設(shè)置權(quán)重。

交流群

歡迎加入公眾號(hào)讀者群一起和同行交流,目前有SLAM、三維視覺(jué)、傳感器、自動(dòng)駕駛、計(jì)算攝影、檢測(cè)、分割、識(shí)別、醫(yī)學(xué)影像、GAN、算法競(jìng)賽等微信群(以后會(huì)逐漸細(xì)分),請(qǐng)掃描下面微信號(hào)加群,備注:”昵稱(chēng)+學(xué)校/公司+研究方向“,例如:”張三?+?上海交大?+?視覺(jué)SLAM“。請(qǐng)按照格式備注,否則不予通過(guò)。添加成功后會(huì)根據(jù)研究方向邀請(qǐng)進(jìn)入相關(guān)微信群。請(qǐng)勿在群內(nèi)發(fā)送廣告,否則會(huì)請(qǐng)出群,謝謝理解~