【學(xué)術(shù)相關(guān)】清北等單位 100 位大佬署名論文,被曝 10 處抄襲,第一單位致歉:追責(zé)到人

來源:Retraction

"

"

2021年7月14日,Katherine Lee等人在預(yù)印版平臺arXiv 在線發(fā)表題為“Deduplicating Training Data Makes Language Models Better”的研究文章,該研究開發(fā)了兩種工具,允許研究人員對訓(xùn)練數(shù)據(jù)集進(jìn)行重復(fù)數(shù)據(jù)刪除——例如,從 C4 中刪除重復(fù)超過 60,000 次的單個 61 個單詞的英語句子。重復(fù)數(shù)據(jù)刪除使研究人員能夠訓(xùn)練發(fā)出記憶文本的頻率降低十倍的模型,并且需要更少的訓(xùn)練步驟來達(dá)到相同或更好的準(zhǔn)確性。?該研究還可以減少訓(xùn)練測試重疊,這會影響超過 4% 的標(biāo)準(zhǔn)數(shù)據(jù)集驗(yàn)證集,從而可以進(jìn)行更準(zhǔn)確的評估。

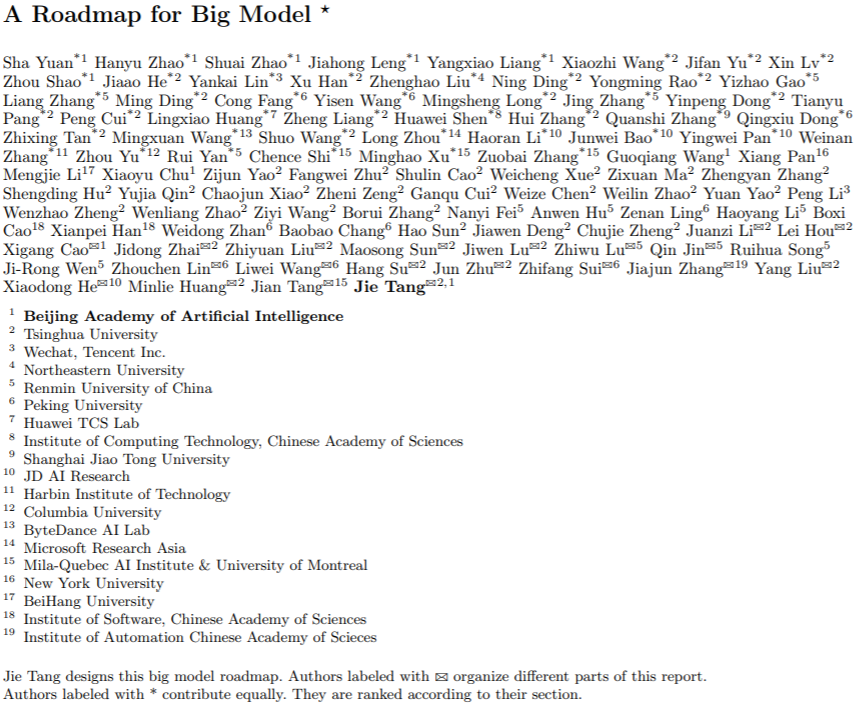

2022年3月26日,清華大學(xué)、東北大學(xué)、紐約大學(xué)、北京大學(xué)、哥倫比亞大學(xué)、哈爾濱工業(yè)大學(xué)、北京航空航天大學(xué)、上海交通大學(xué)、蒙特利爾大學(xué)等多單位合作,唐杰等100多為作者在預(yù)印版平臺arXiv 在線發(fā)表題為“A Roadmap for Big Model”的綜述文章,該綜述不僅涵蓋了 BM 技術(shù)本身,還涵蓋了 BM 培訓(xùn)和應(yīng)用 BM 的先決條件,將 BM 審查分為四個部分:資源、模型、關(guān)鍵技術(shù)和應(yīng)用。

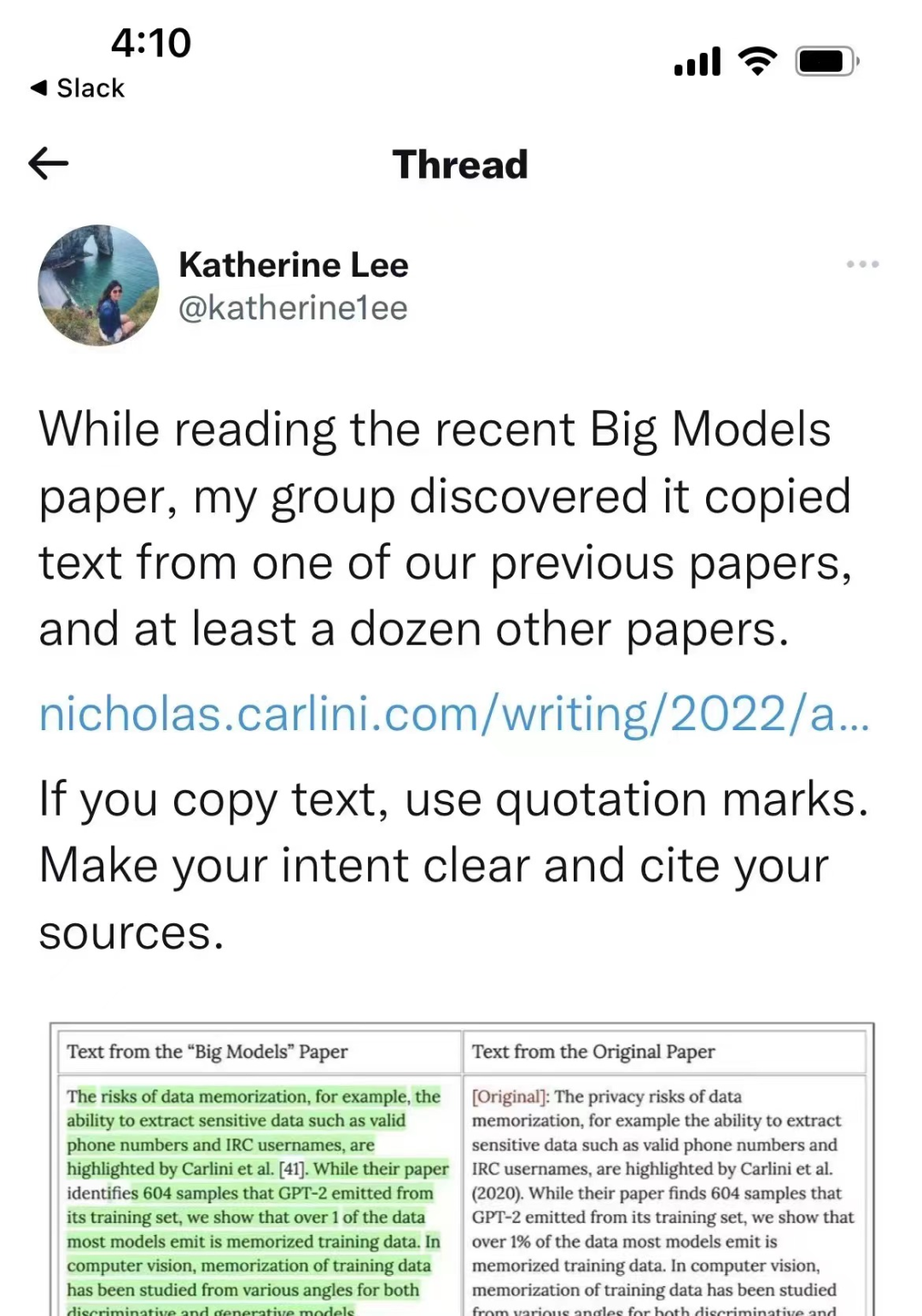

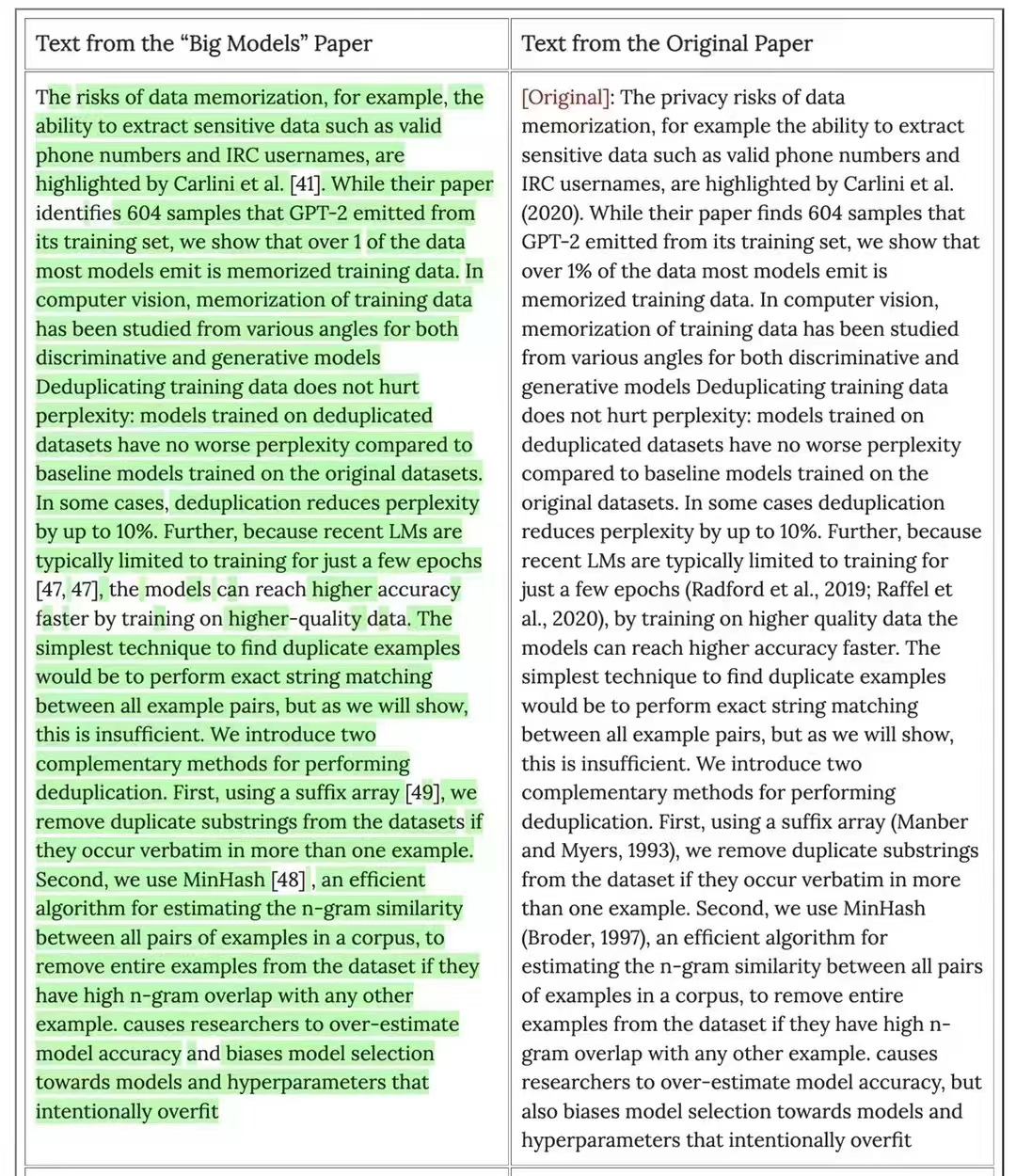

但是,近期Katherine Lee爆料,唐杰等人發(fā)表的文章與Katherine Lee等人先前發(fā)表的“Deduplicating Training Data Makes Language Models Better”文章存在大量重疊。

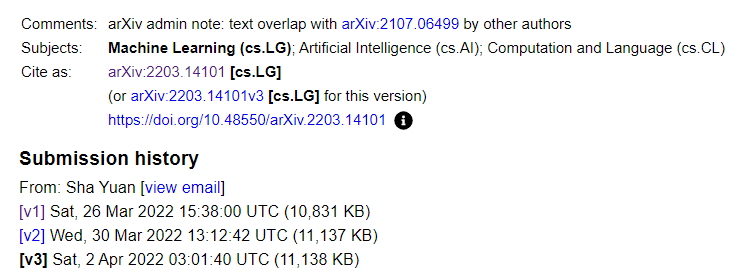

由于Katherine Lee的爆料,arXiv也在唐杰等人發(fā)表的文章做了文章重疊的警示。

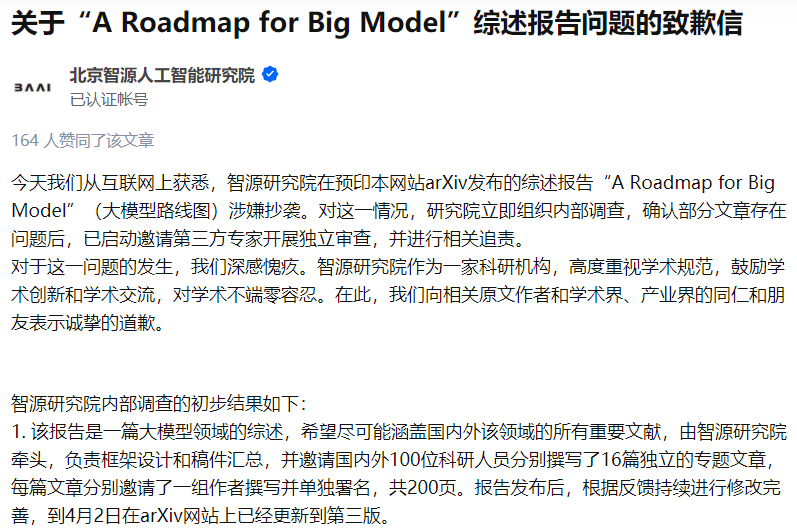

該文章的第一作者單位北京智源人工智能研究院發(fā)布說明稱,已展開調(diào)查,對學(xué)術(shù)不端零容忍。

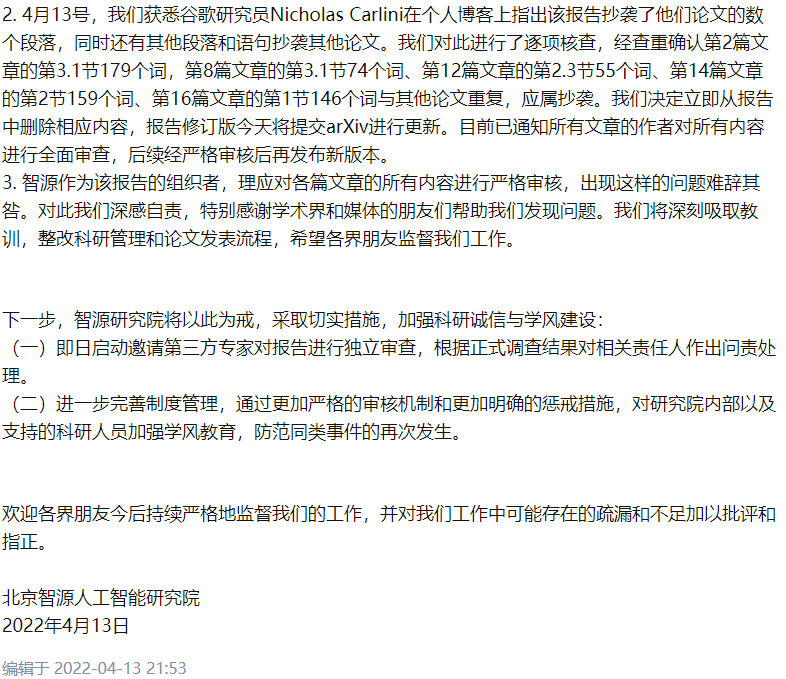

2022年4月13日,北京智源人工智能研究院分布了初步研究調(diào)查報告:

今天我們從互聯(lián)網(wǎng)上獲悉,智源研究院在預(yù)印本網(wǎng)站arXiv發(fā)布的綜述報告“A Roadmap for Big Model”(大模型路線圖)涉嫌抄襲。對這一情況,研究院立即組織內(nèi)部調(diào)查,確認(rèn)部分文章存在問題后,已啟動邀請第三方專家開展獨(dú)立審查,并進(jìn)行相關(guān)追責(zé)。

對于這一問題的發(fā)生,我們深感愧疚。智源研究院作為一家科研機(jī)構(gòu),高度重視學(xué)術(shù)規(guī)范,鼓勵學(xué)術(shù)創(chuàng)新和學(xué)術(shù)交流,對學(xué)術(shù)不端零容忍。在此,我們向相關(guān)原文作者和學(xué)術(shù)界、產(chǎn)業(yè)界的同仁和朋友表示誠摯的道歉。

參考消息:

https://arxiv.org/abs/2203.14101

https://arxiv.org/abs/2107.06499

https://zhuanlan.zhihu.com/p/497629749

https://zhuanlan.zhihu.com/p/498064778

僅作學(xué)術(shù)分享之用,如有不妥,請聯(lián)系刪除!

往期精彩回顧