Nature重磅:人類的這一能力,被AI掌握甚至超越了

本文約1800字,建議閱讀5分鐘

在該研究中,紐約大學(xué)心理學(xué)和數(shù)據(jù)科學(xué)助理教授 Brenden Lake 和西班牙加泰羅尼亞研究所(ICREA)教授 Marco Baroni 提出了一個具有類似人類系統(tǒng)泛化能力的神經(jīng)網(wǎng)絡(luò)。

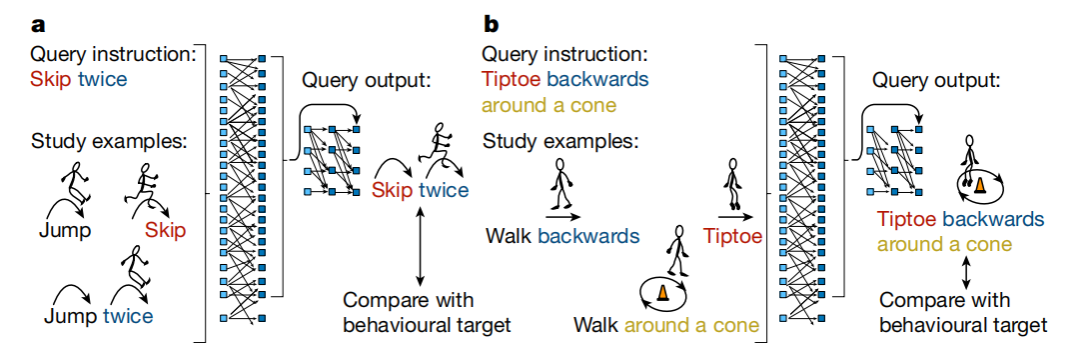

人們善于學(xué)習(xí)新概念,并將它們與已有概念進行系統(tǒng)組合。例如,一旦一個孩子學(xué)會了如何跳躍,他們可以通過組合技能理解如何向后跳或繞錐形物跳兩次。

這種將新老概念結(jié)合的能力被稱為系統(tǒng)泛化(systematic generalization)。

而此前,Jerry Fodor 和 Zenon Pylyshyn 兩位認知科學(xué)家曾主張,人工神經(jīng)網(wǎng)絡(luò)缺乏這種能力,因此不適合作為人類認知的可靠模型。

然而,一篇發(fā)表在 Nature 上的最新研究挑戰(zhàn)了這個已經(jīng)存在了 35 年的觀點。

在該研究中,紐約大學(xué)心理學(xué)和數(shù)據(jù)科學(xué)助理教授 Brenden Lake 和西班牙加泰羅尼亞研究所(ICREA)教授 Marco Baroni 提出了一個具有類似人類系統(tǒng)泛化能力的神經(jīng)網(wǎng)絡(luò)。

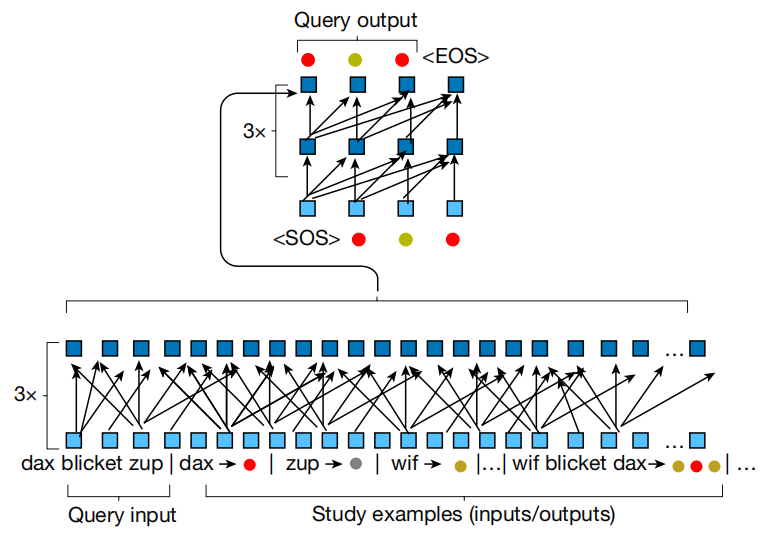

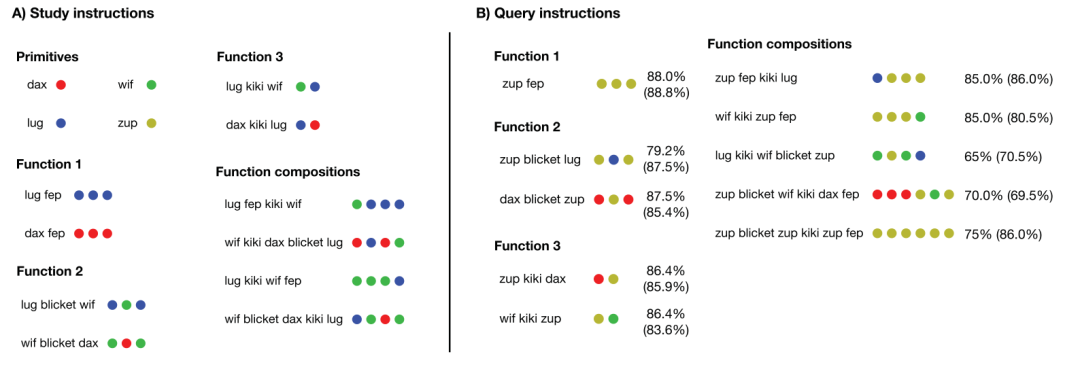

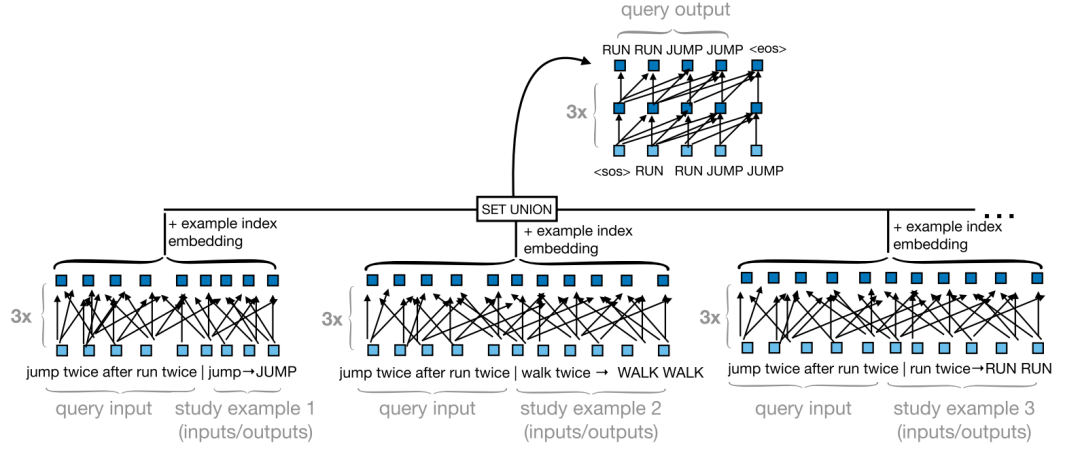

具體而言,研究團隊使用了一種“組合性元學(xué)習(xí)(MLC)”的方法來優(yōu)化組織能力。通過并行比較人類與神經(jīng)網(wǎng)絡(luò),他們發(fā)現(xiàn),MLC 能掌握、有時甚至能超過類似人類的系統(tǒng)泛化能力。另外,MLC 還在多個系統(tǒng)化泛化基準測試中提高了機器學(xué)習(xí)系統(tǒng)的組合技能。

該方法可以讓機器與人進行更自然的互動,甚至超過目前最好的 AI 系統(tǒng)。雖然基于大型語言模型(LLMs)的系統(tǒng)(如 ChatGPT)在許多情況下都能很好地進行對話,但在其他情況下卻表現(xiàn)出明顯的缺陷和不一致。

相關(guān)論文以“Human-like systematic generalization through a meta-learning neural network”為題,已發(fā)表在權(quán)威科學(xué)期刊 Nature 上。

研究團隊表示,雖然元學(xué)習(xí)方法無法讓該神經(jīng)網(wǎng)絡(luò)對訓(xùn)練之外的任務(wù)進行泛化,但他們的研究結(jié)果有助于今后開發(fā)出行為更像人類大腦的 AI。