端到端偽激光圖像3D目標(biāo)檢測(cè)

點(diǎn)擊上方“小白學(xué)視覺”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

本文由博主:?授權(quán)轉(zhuǎn)載,二次轉(zhuǎn)載請(qǐng)聯(lián)系原作者

原文地址:https://blog.csdn.net/qq_26623879/article/details/109234324

End-to-End Pseudo-LiDAR for Image-Based 3D Object Detection

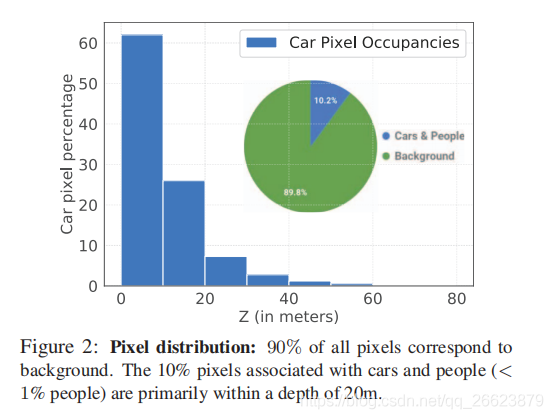

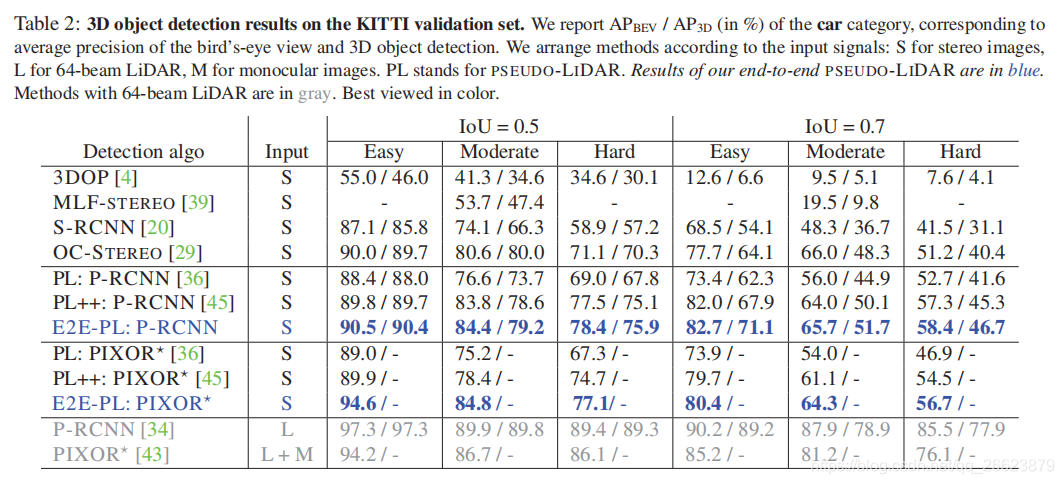

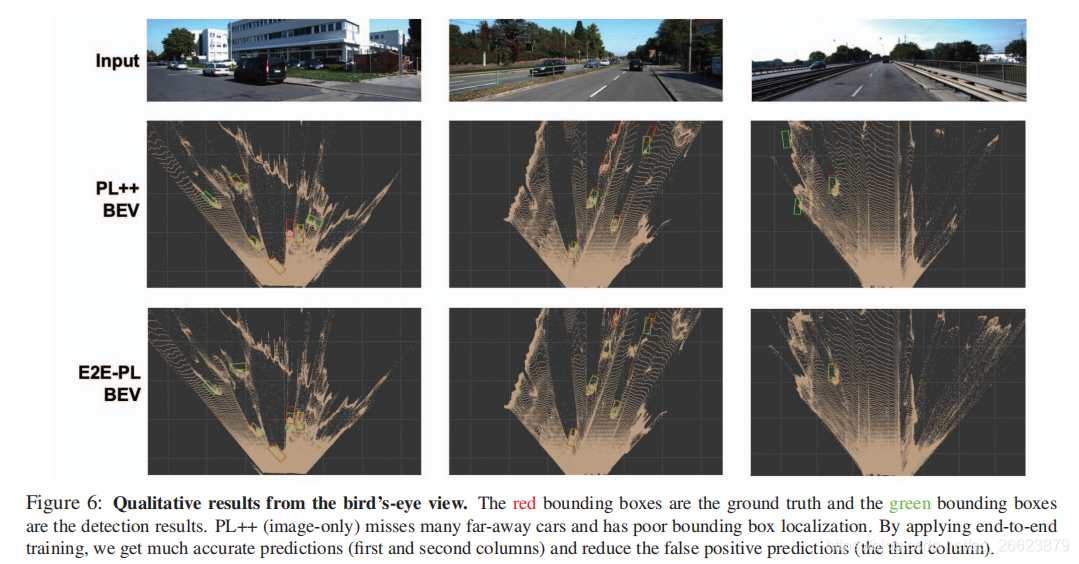

自主駕駛是安全、準(zhǔn)確檢測(cè)三維物體的必要條件。盡管激光雷達(dá)傳感器可以提供精確的三維點(diǎn)云環(huán)境估計(jì)值,但在許多情況下,它們的成本也高得讓人望而卻步。最近,偽激光雷達(dá)(PL)的引入使得基于LiDAR傳感器的方法與基于廉價(jià)立體相機(jī)的方法之間的精度差距大大縮小。PL通過將二維深度圖輸出轉(zhuǎn)換為三維點(diǎn)云輸入,將用于三維深度估計(jì)的最新深度神經(jīng)網(wǎng)絡(luò)與用于三維目標(biāo)檢測(cè)的深度神經(jīng)網(wǎng)絡(luò)相結(jié)合。然而,到目前為止,這兩個(gè)網(wǎng)絡(luò)必須分開訓(xùn)練。在本文中,我們介紹了一個(gè)新的框架,它基于可微的表示變化(CoR)模塊,允許對(duì)整個(gè)PL管道進(jìn)行端到端的訓(xùn)練。該框架與大多數(shù)最先進(jìn)的網(wǎng)絡(luò)兼容,適用于這兩項(xiàng)任務(wù),并與PointRCNN相結(jié)合,在所有基準(zhǔn)測(cè)試中始終優(yōu)于PL—在提交時(shí),在基于KITTI圖像的3D目標(biāo)檢測(cè)排行榜上獲得了最高的排名。

基于激光雷達(dá)的方法存在問題

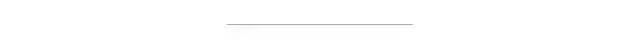

目標(biāo)檢測(cè)嚴(yán)重依賴與3D point的準(zhǔn)確性,位置和檢測(cè)需要近似object surfaces

不能夠檢測(cè)到遠(yuǎn)處的目標(biāo),由于車和人在圖像中只占10%(kitti),受激光范圍限制,訓(xùn)練的時(shí)候會(huì)忽略遠(yuǎn)處的物體當(dāng)前偽激光雷達(dá)存在的問題

沒有實(shí)現(xiàn)端到端的深度預(yù)測(cè)和目標(biāo)檢測(cè)聯(lián)合訓(xùn)練

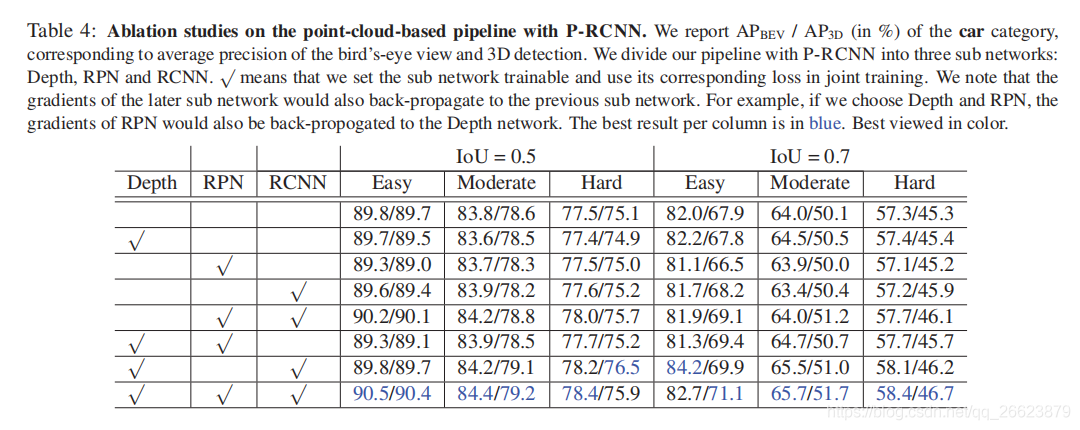

本文提出的端到端框架解決不能夠聯(lián)合訓(xùn)練的缺點(diǎn)。其中,錯(cuò)誤檢測(cè)或錯(cuò)誤定位對(duì)象的錯(cuò)誤信號(hào)可以“softly attend ”影響預(yù)測(cè)最大的像素(可能是2D中對(duì)象上或周圍的像素),引導(dǎo)深度估計(jì)器為后續(xù)檢測(cè)器改進(jìn)提供依據(jù)。為了使來自最終檢測(cè)損失的誤差信號(hào)反向傳播,深度估計(jì)器和目標(biāo)檢測(cè)器之間的表示變化(CoR)必須相對(duì)于估計(jì)的深度是可微的。

本文確定了兩種主要的CoR類型-子采樣和量化-將現(xiàn)有的基于LiDAR的探測(cè)器合并到偽LiDAR框架中。

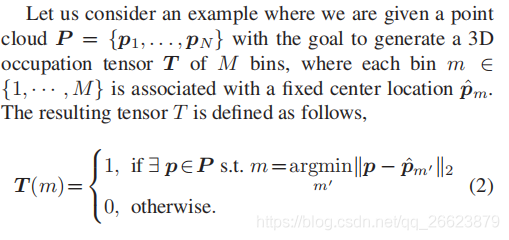

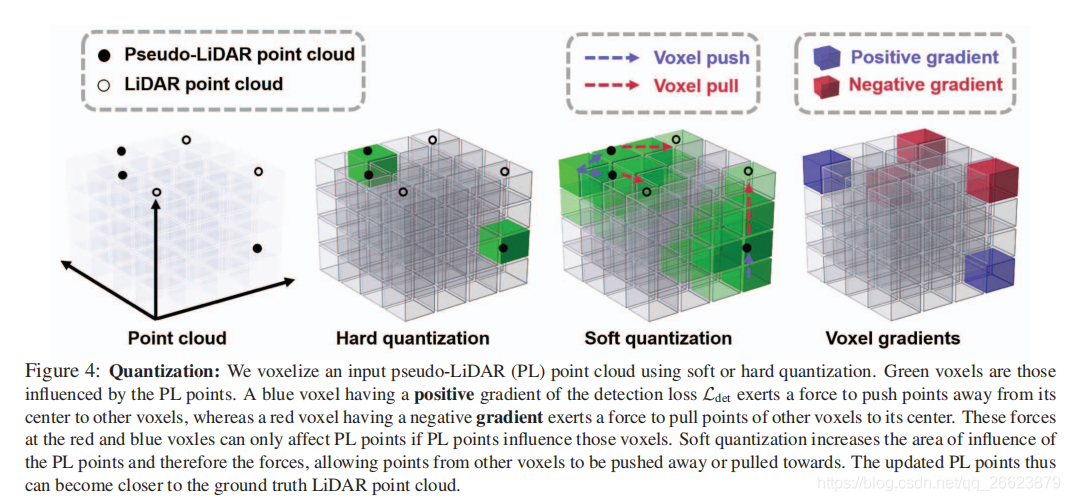

三維點(diǎn)的位置被離散成一個(gè)固定的網(wǎng)格,在得到的張量1中只記錄占用(即{0,1})或密度(即[0,1])。這種方法的優(yōu)點(diǎn)是可以直接應(yīng)用二維和三維卷積從張量中提取特征。然而,這種離散化過程使得反向傳播變得困難。

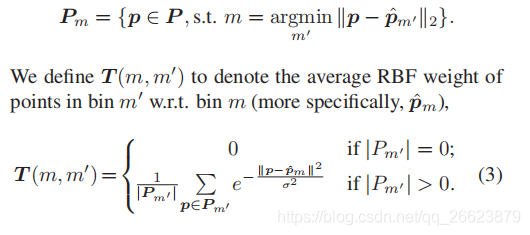

本文引入了一個(gè) radial basis function(RBF)在給定的面元m的中心?pm附近,而不是二進(jìn)制占用,這樣保持了一個(gè)“Softly”計(jì)數(shù)的點(diǎn),由RBF加權(quán)。進(jìn)一步地,允許任何給定的m受到close bins Nm的影響。然后我們相應(yīng)地修改了T的定義。讓Pm表示落入bin m的點(diǎn)集:

首先,我們?nèi)コ懈哂诩す饫走_(dá)信號(hào)可以覆蓋的正常高度的3D點(diǎn),例如天空的像素點(diǎn)。此外,我們還可以通過亞抽樣來稀疏化剩余的點(diǎn)。第二步是可選的,但在[45]中建議使用,因?yàn)樯疃葓D生成的點(diǎn)數(shù)量比激光雷達(dá)大得多:偽激光雷達(dá)信號(hào)中平均有300000個(gè)點(diǎn),而激光雷達(dá)信號(hào)中有18000個(gè)點(diǎn)(在汽車的正面視圖中)。雖然密集的表示在精確度方面是有利的,但它們確實(shí)減慢了目標(biāo)檢測(cè)網(wǎng)絡(luò)的速度。我們采用了一種基于角度的稀疏化方法。我們通過將球坐標(biāo)(r,θ,φ)離散化來定義三維空間中的多個(gè)料倉(cāng)。具體來說,我們離散θ(極角)和φ(方位角)來模擬激光雷達(dá)光束。然后我們保持一個(gè)單一的三維點(diǎn)(x,y,z)的球坐標(biāo)落在同一個(gè)箱子里。因此,生成的點(diǎn)云模擬真實(shí)的激光雷達(dá)點(diǎn)。

交流群

歡迎加入公眾號(hào)讀者群一起和同行交流,目前有SLAM、三維視覺、傳感器、自動(dòng)駕駛、計(jì)算攝影、檢測(cè)、分割、識(shí)別、醫(yī)學(xué)影像、GAN、算法競(jìng)賽等微信群(以后會(huì)逐漸細(xì)分),請(qǐng)掃描下面微信號(hào)加群,備注:”昵稱+學(xué)校/公司+研究方向“,例如:”張三?+?上海交大?+?視覺SLAM“。請(qǐng)按照格式備注,否則不予通過。添加成功后會(huì)根據(jù)研究方向邀請(qǐng)進(jìn)入相關(guān)微信群。請(qǐng)勿在群內(nèi)發(fā)送廣告,否則會(huì)請(qǐng)出群,謝謝理解~