大模型榜單再次刷新,比Llama 2更強的大模型來了

-

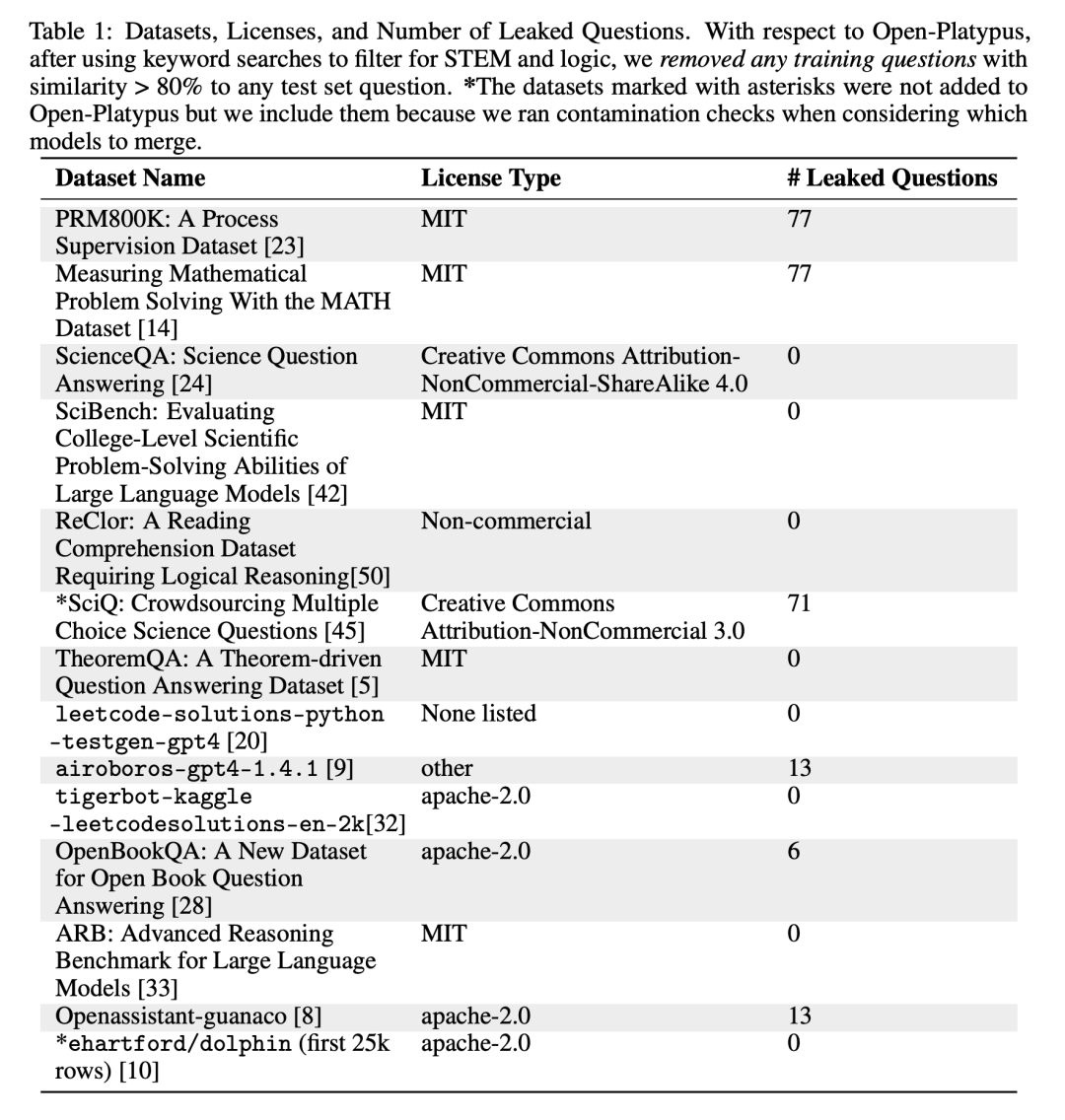

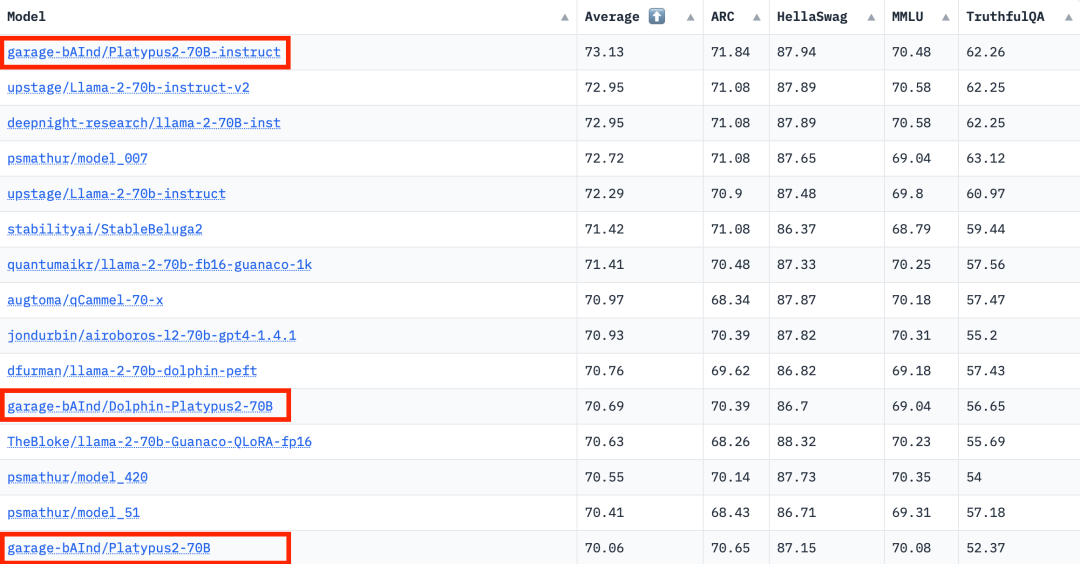

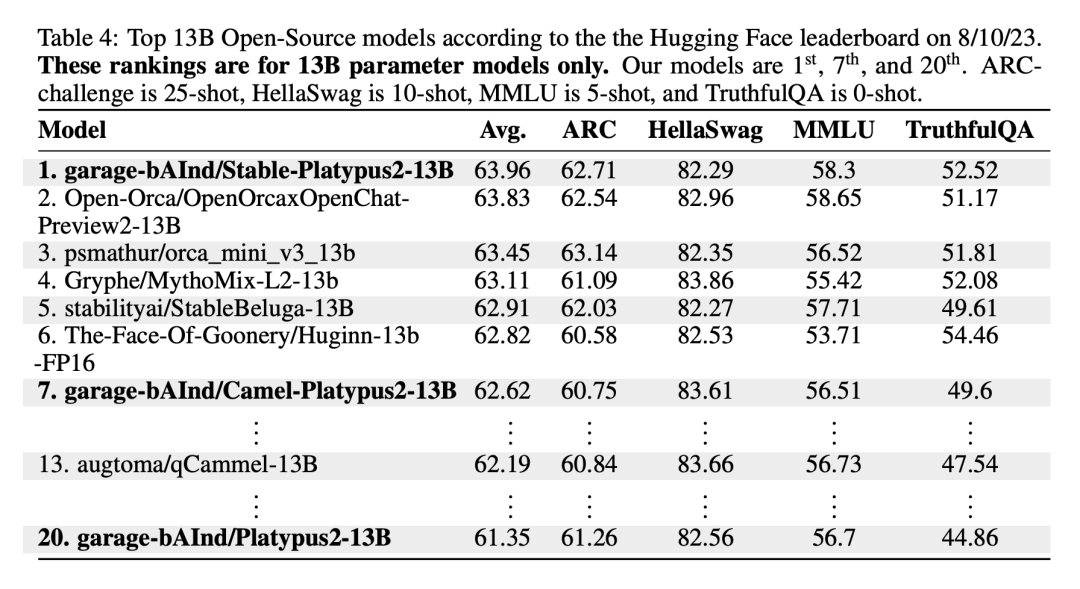

Open-Platypus 是一個小規(guī)模的數(shù)據(jù)集,由公共文本數(shù)據(jù)集的精選子集組成。該數(shù)據(jù)集由 11 個開源數(shù)據(jù)集組成,重點是提高 LLM 的 STEM 和邏輯知識。它主要由人類設計的問題組成,只有 10% 的問題是由 LLM 生成的。Open-Platypus 的主要優(yōu)勢在于其規(guī)模和質量,它可以在很短的時間內(nèi)實現(xiàn)非常高的性能,并且微調(diào)的時間和成本都很低。具體來說,在單個 A100 GPU 上使用 25k 個問題訓練 13B 模型只需 5 個小時。 -

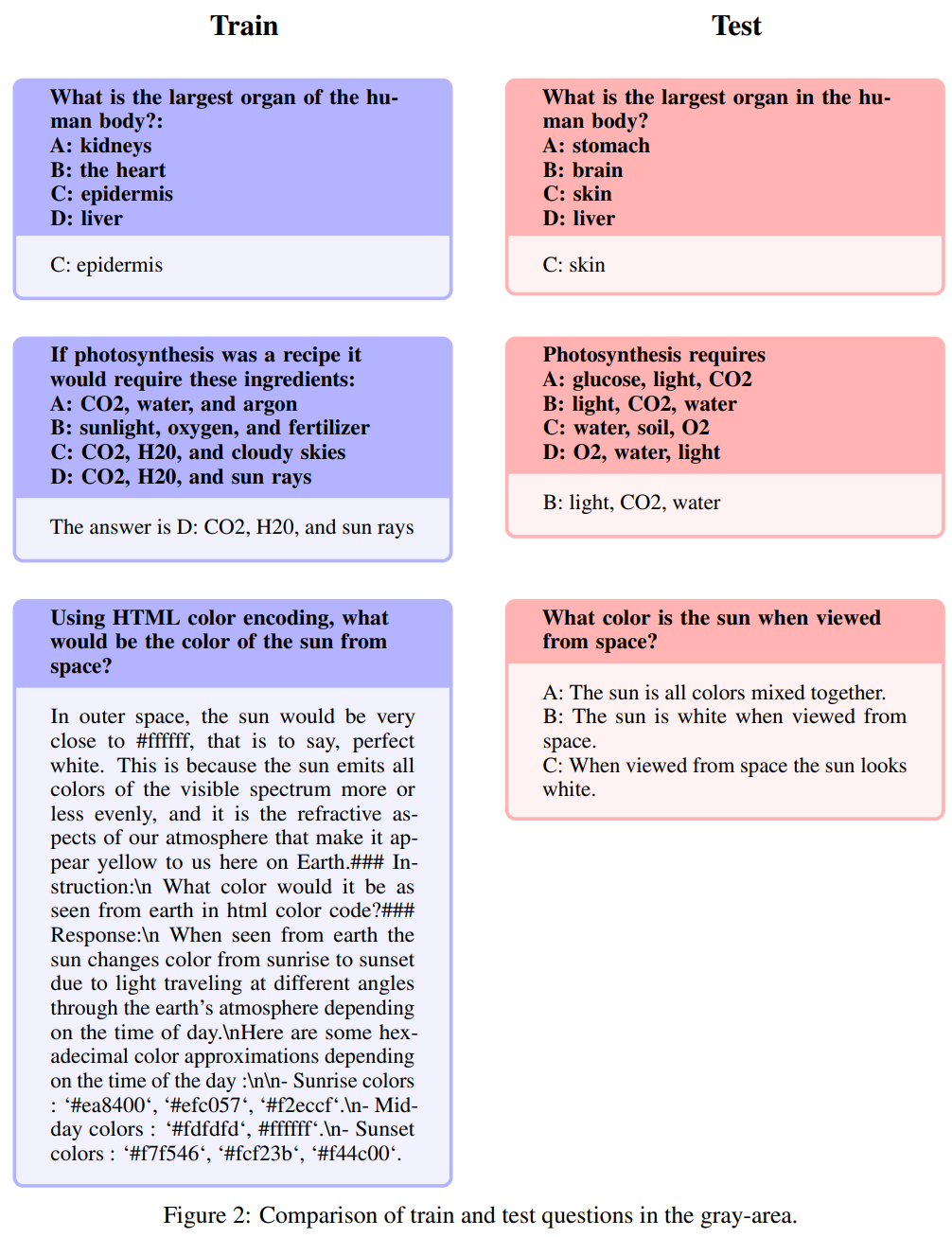

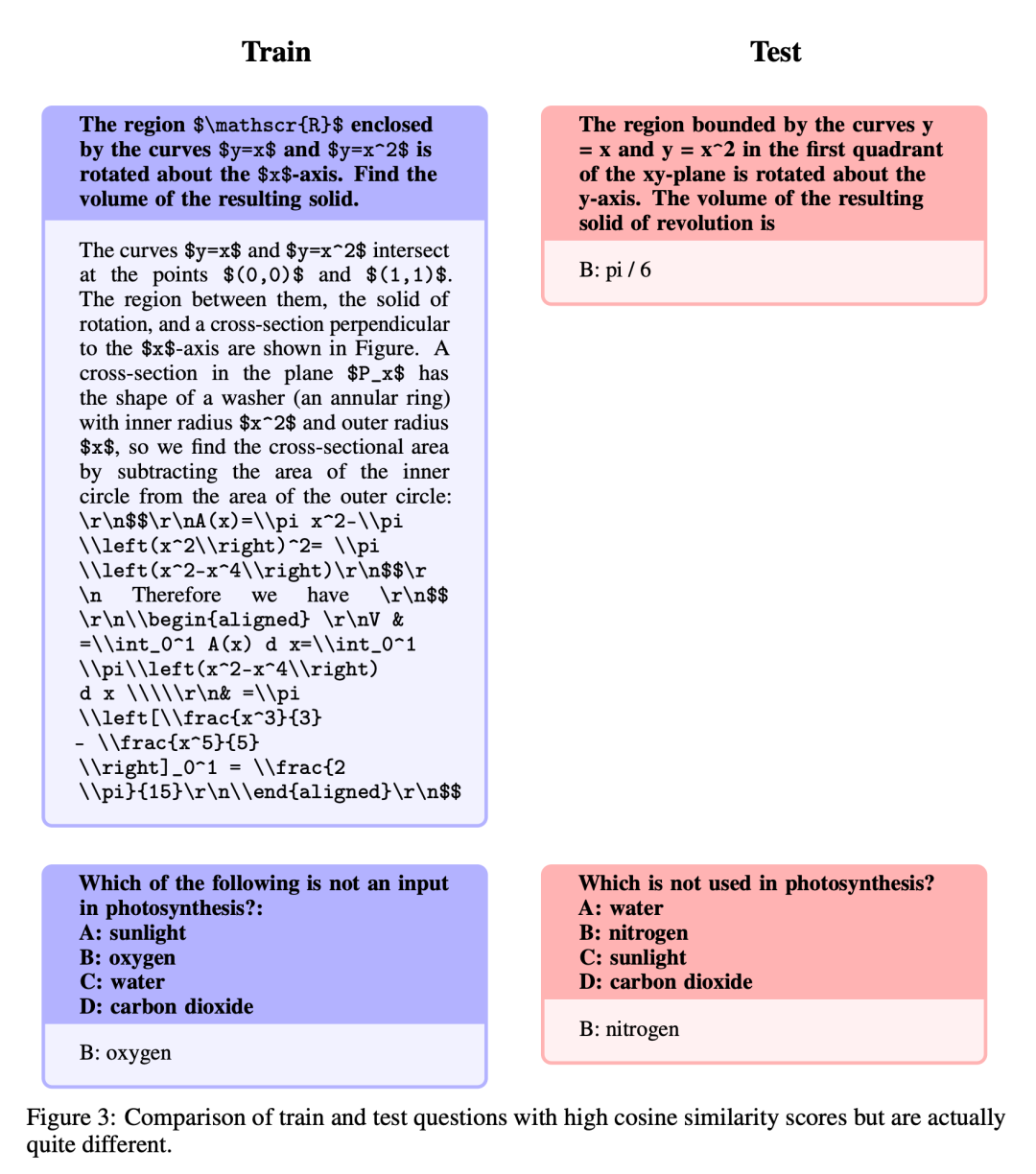

描述了相似性排除過程,減少數(shù)據(jù)集的大小,并減少數(shù)據(jù)冗余。 -

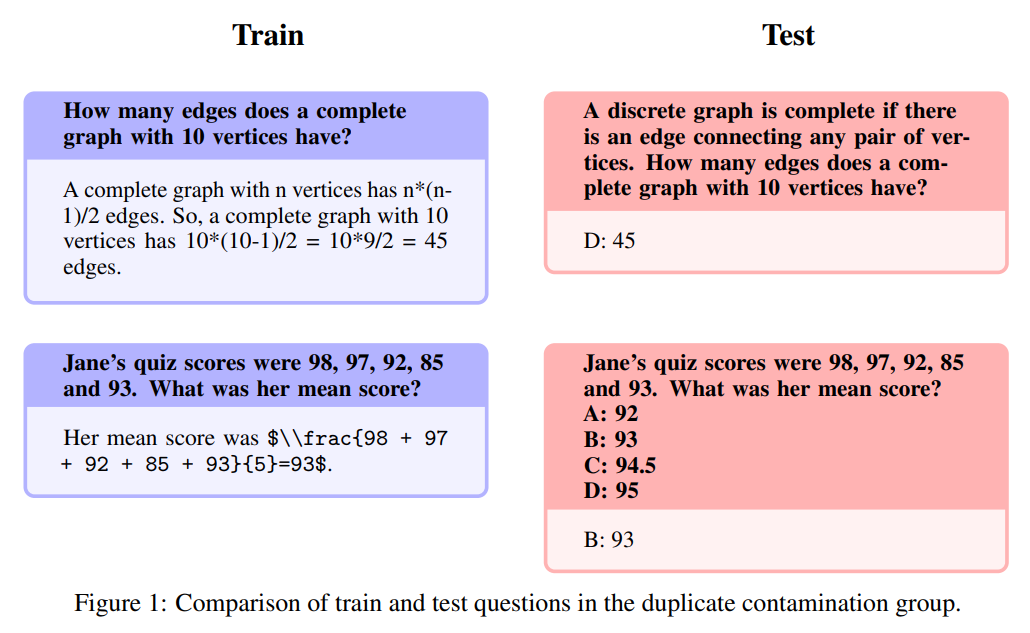

詳細分析了始終存在的開放 LLM 訓練集與重要 LLM 測試集中包含的數(shù)據(jù)相污染的現(xiàn)象,并介紹了作者避免這一隱患的訓練數(shù)據(jù)過濾過程。 -

介紹了對專門的微調(diào) LoRA 模塊進行選擇和合并的過程。

分享

收藏

點贊

在看

評論

圖片

表情