CB Loss:基于有效樣本的類別不平衡損失

點擊左上方藍字關(guān)注我們

轉(zhuǎn)載自 | AI公園

本文綜述了康奈爾大學、康奈爾科技、谷歌Brain和Alphabet公司的基于有效樣本數(shù)的類平衡損失(CB損失)。

1. 類別平衡問題

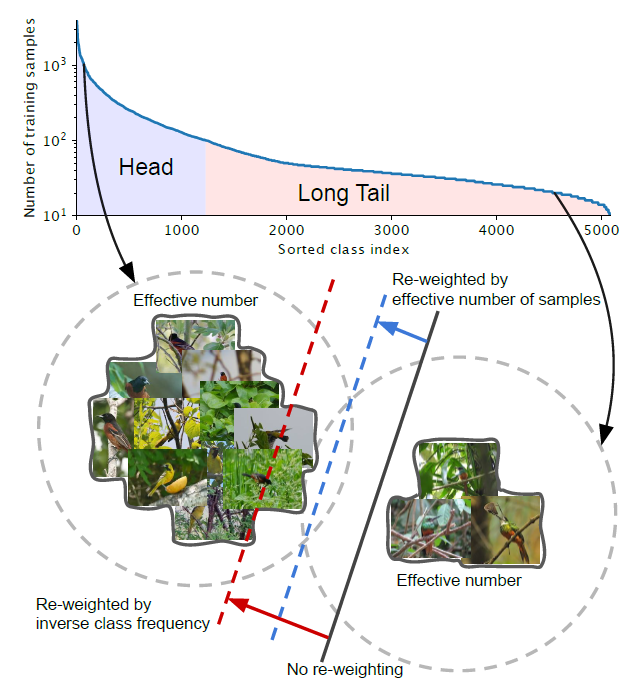

假設(shè)有像上面那樣的不平衡的類。head:對于索引小的類,這些類有較多的樣本。Tail:對于大索引的類,這些類的樣本數(shù)量較少。黑色實線:直接在這些樣本上訓練的模型偏向于優(yōu)勢類。紅色虛線:通過反向類頻率來重新加權(quán)損失可能會在具有高類不平衡的真實數(shù)據(jù)上產(chǎn)生較差的性能。藍虛線:設(shè)計了一個類平衡項,通過反向有效樣本數(shù)來重新加權(quán)損失。

2. 有效樣本數(shù)量

2.1. 定義

直覺上,數(shù)據(jù)越多越好。但是,由于數(shù)據(jù)之間存在信息重疊,隨著樣本數(shù)量的增加,模型從數(shù)據(jù)中提取的邊際效益會減少

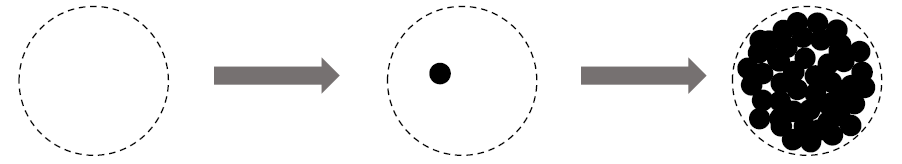

左:給定一個類,將該類的特征空間中所有可能數(shù)據(jù)的集合表示為S。假設(shè)S的體積為N且N≥1。中:S子集中的每個樣本的單位體積為1,可能與其他樣本重疊。Right:從S中隨機抽取每個子集,覆蓋整個S集合。采樣的數(shù)據(jù)越多,S的覆蓋率就越好。期望的采樣數(shù)據(jù)總量隨著樣本數(shù)量的增加而增加,以N為界。

因此,將有效樣本數(shù)定義為樣本的期望體積。

這個想法是通過使用一個類的更多數(shù)據(jù)點來捕捉邊際效益的遞減。由于現(xiàn)實世界數(shù)據(jù)之間的內(nèi)在相似性,隨著樣本數(shù)量的增加,新添加的樣本極有可能是現(xiàn)有樣本的近重復(fù)。另外,cnn是用大量的數(shù)據(jù)增廣來訓練的,所有的增廣實例也被認為與原始實例相同。對于一個類,N可以看作是唯一原型的數(shù)量。

2.2. 數(shù)學公式

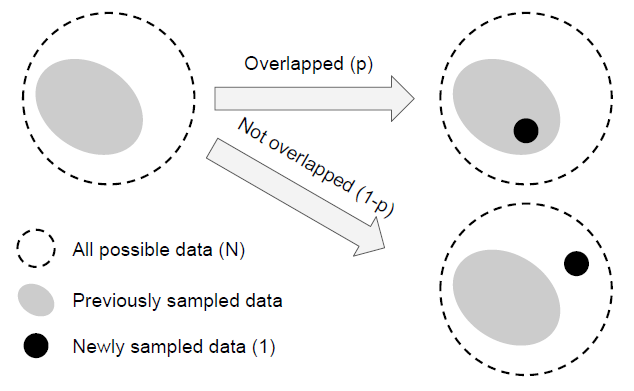

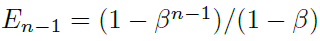

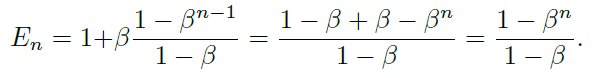

En表示樣本的有效數(shù)量(期望體積)。為了簡化問題,不考慮部分重疊的情況。也就是說,一個新采樣的數(shù)據(jù)點只能以兩種方式與之前的采樣數(shù)據(jù)交互:完全在之前的采樣數(shù)據(jù)集中,概率為p,或完全在原來的數(shù)據(jù)集之外,的概率為1- p。

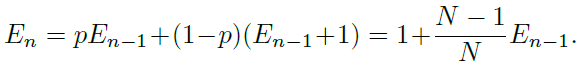

有效數(shù)字:En = (1?β^n)/(1?β),其中,β = (N? 1)/N,這個命題可以用數(shù)學歸納法證明。當E1 = 1時,不存在重疊,E1 =(1?β^1)/(1?β) = 1成立。假設(shè)已經(jīng)有n?1個樣本,并且即將對第n個樣本進行采樣,現(xiàn)在先前采樣數(shù)據(jù)的期望體積為En ?1,而新采樣的數(shù)據(jù)點與先前采樣點重疊的概率為 p = E(n?1)/N。因此,第n個實例采樣后的期望體積為:

此時:

我們有:

上述命題表明有效樣本數(shù)是n的指數(shù)函數(shù)。超參數(shù)β∈[0,1)控制En隨著n的增長有多快。

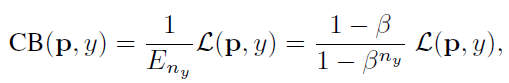

3. 類別平衡 Loss (CB Loss)

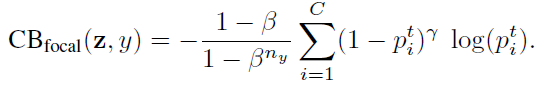

類別平衡(CB)loss可以寫成:

其中,ny是類別y的ground-truth的數(shù)量。β = 0對應(yīng)沒有重新加權(quán), β → 1對應(yīng)于用反向頻率進行加權(quán)。

提出的有效樣本數(shù)的新概念使我們能夠使用一個超參數(shù)β來平滑地調(diào)整無重權(quán)和反向類頻率重權(quán)之間的類平衡項。

所提出的類平衡項是模型不可知的和損失不可知的,因為它獨立于損失函數(shù)L和預(yù)測類概率p的選擇。

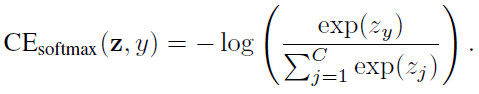

3.1. 類別平衡的 Softmax 交叉熵損失

給定一個標號為y的樣本,該樣本的softmax交叉熵(CE)損失記為:

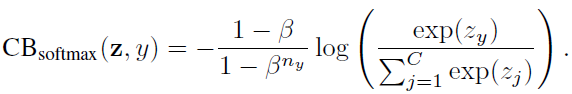

假設(shè)類y有ny個訓練樣本,類平衡(CB)softmax交叉熵損失為:

3.2. 類別平衡的 Sigmoid 交叉熵損失

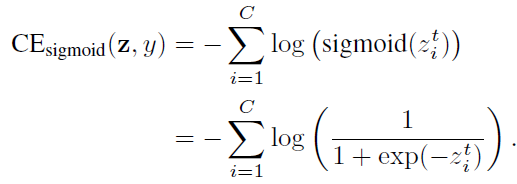

當對多類問題使用sigmoid函數(shù)時,網(wǎng)絡(luò)的每個輸出都執(zhí)行一個one-vs-all分類,以預(yù)測目標類在其他類中的概率。在這種情況下,Sigmoid不假定類之間的互斥性。由于每個類都被認為是獨立的,并且有自己的預(yù)測器,所以sigmoid將單標簽分類和多標簽預(yù)測統(tǒng)一起來。這是一個很好的屬性,因為現(xiàn)實世界的數(shù)據(jù)通常有多個語義標簽。sigmoid交叉熵(CE)損失可以寫成:

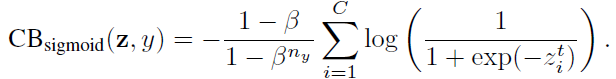

類平衡(CB) sigmoid交叉熵損失為:

3.3. 類別平衡 Focal Loss

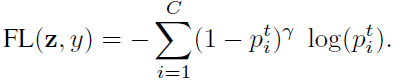

Focal loss (FL)是在RetinaNet中提出的,可以減少分類很好的樣本的損失,聚焦于困難的樣本。

類別平衡的 (CB) Focal Loss為:

4. 實驗結(jié)果

4.1. 數(shù)據(jù)集

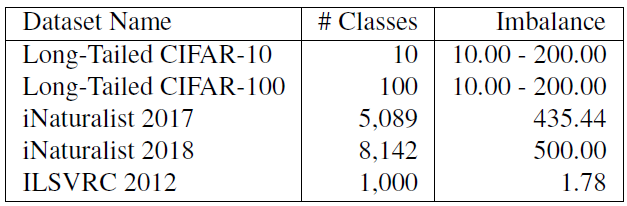

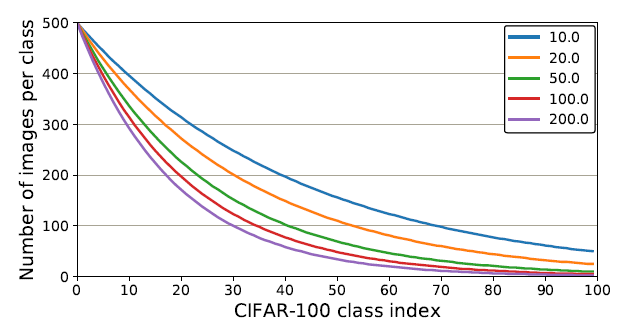

試驗了CIFAR-10和CIFAR-100的5個不平衡系數(shù)分別為10、20、50、100和200的長尾版本。iNaturalist 和ILSVRC是天然的類別不平衡數(shù)據(jù)集。

上面顯示了每個類具有不同不平衡因素的圖像數(shù)量。

4.2. CIFAR 數(shù)據(jù)集

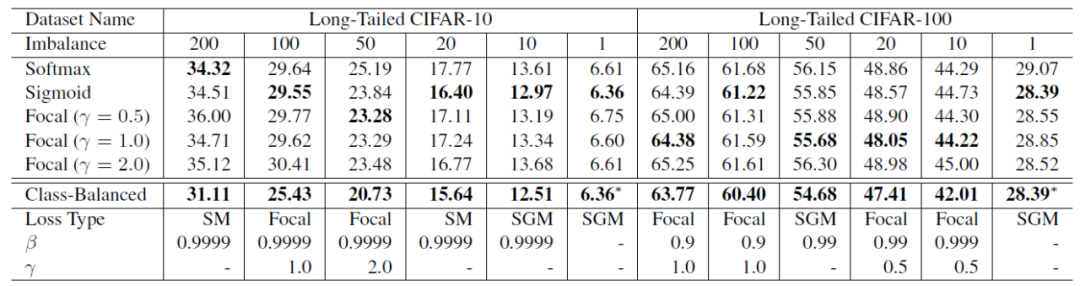

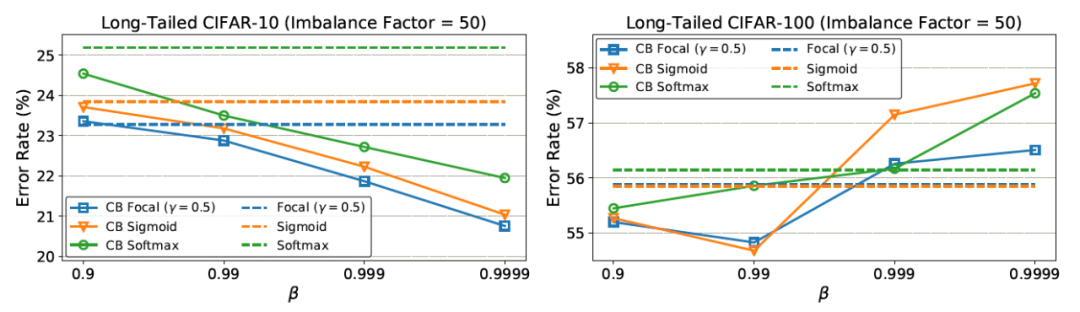

loss類型的超參數(shù)搜索空間為{softmax, sigmoid, focal}, [focal loss]的超參數(shù)搜索空間為β∈{0.9,0.99,0.999,0.9999},γ∈{0.5,1.0,2.0}。在CIFAR-10上,最佳的β一致為0.9999。但在CIFAR-100上,不同不平衡因子的數(shù)據(jù)集往往有不同且較小的最優(yōu)β。

在CIFAR-10上,根據(jù)β = 0.9999重新加權(quán)后,有效樣本數(shù)與樣本數(shù)接近。這意味著CIFAR-10的最佳重權(quán)策略與逆類頻率重權(quán)類似。在CIFAR-100上,使用較大的β的性能較差,這表明用逆類頻率重新加權(quán)不是一個明智的選擇,需要一個更小的β,具有更平滑的跨類權(quán)重。例如,一個特定鳥類物種的獨特原型數(shù)量應(yīng)該小于一個一般鳥類類的獨特原型數(shù)量。由于CIFAR-100中的類比CIFAR-10更細粒度,因此CIFAR-100的N比CIFAR-10小。

4.3. 大規(guī)模數(shù)據(jù)集

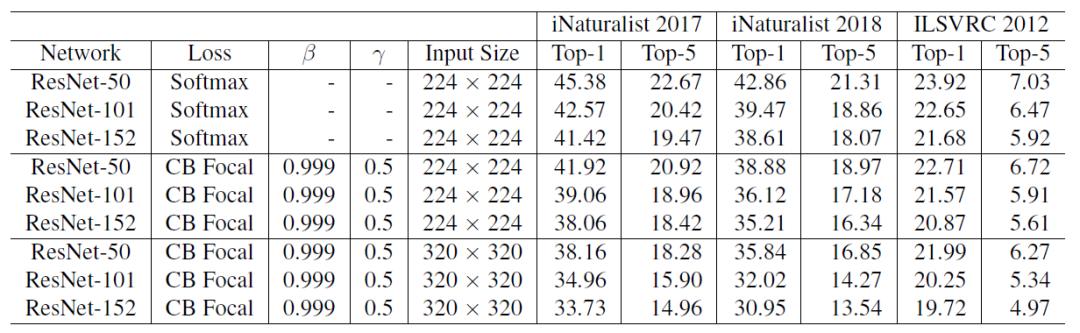

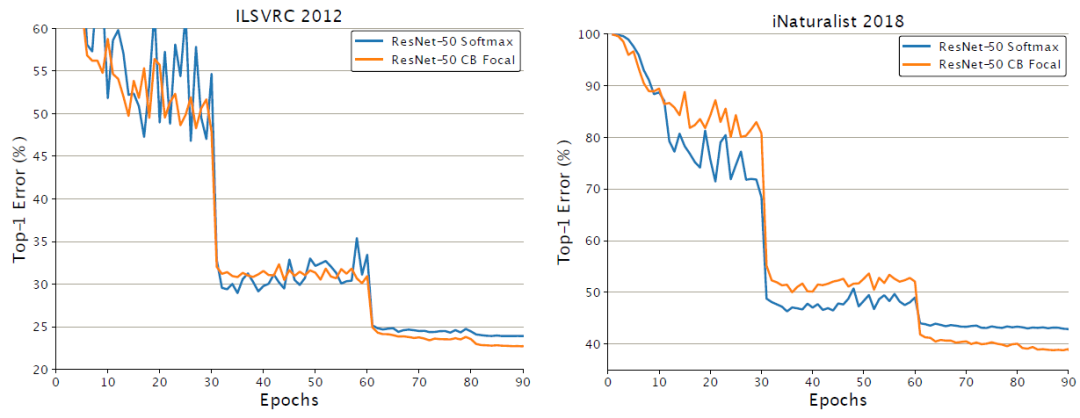

使用了類平衡的Focal Loss,因為它具有更大的靈活性,并且發(fā)現(xiàn)β = 0.999和γ = 0.5在所有數(shù)據(jù)集上都獲得了合理的良好的性能。值得注意的是,使用了類別平衡的Focal Loss來代替Softmax交叉熵,ResNet-50能夠達到和ResNet-152相應(yīng)的性能。

以上數(shù)字顯示類平衡的Focal Loss損失經(jīng)過60個epochs的訓練后,開始顯示其優(yōu)勢。

END

整理不易,點贊三連↓