CVPR 2021 | 圖像轉(zhuǎn)換 今如何?幾篇GAN論文

點(diǎn)擊上方“機(jī)器學(xué)習(xí)與生成對(duì)抗網(wǎng)絡(luò)”,關(guān)注星標(biāo)

獲取有趣、好玩的前沿干貨!

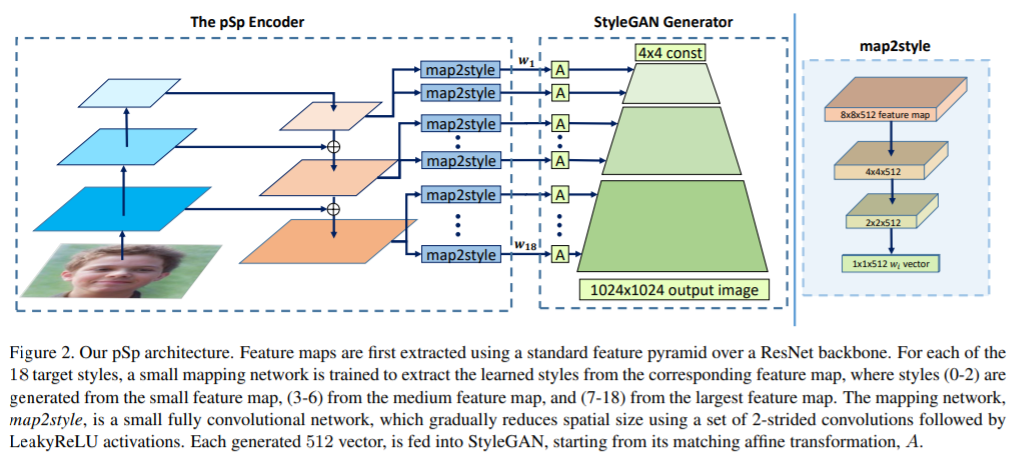

1,Encoding in Style: a StyleGAN Encoder for Image-to-Image Translation

提出一個(gè)通用的圖像轉(zhuǎn)換框架pixel2style2pixel(pSp)。pSp框架基于編碼器網(wǎng)絡(luò),直接生成一系列風(fēng)格向量,然后將它們輸入到預(yù)訓(xùn)練的StyleGAN生成器中,從而擴(kuò)展成“W+潛在空間”。

編碼器可以直接將真實(shí)圖像嵌入到W+,而無需其它優(yōu)化。利用編碼器直接解決圖像轉(zhuǎn)換任務(wù),如此一來圖像轉(zhuǎn)換任務(wù)可定義為:從某些輸入域到潛在域的編碼問題。

此前的方法中,StyleGAN編碼器一般是“先反轉(zhuǎn)(圖像到潛碼),后編輯”。而pSp不要求輸入圖像在StyleGAN域中進(jìn)行特征表示,也可以處理各種任務(wù)。由于不需要對(duì)抗,極大地簡化了訓(xùn)練過程,在沒有“圖像對(duì)(源圖像,目標(biāo)圖像)”的嚴(yán)格標(biāo)簽數(shù)據(jù)下提供更好的支持,并且通過風(fēng)格的重采樣可以支持多模式合成。

實(shí)驗(yàn)表明,pSp在各種圖像轉(zhuǎn)換任務(wù)中也表現(xiàn)出不俗的潛力。即使與專為某種任務(wù)而設(shè)計(jì)的最新解決方案相比,例如人臉轉(zhuǎn)換任務(wù),pSp也表現(xiàn)極佳。代碼:https://github.com/eladrich/pixel2style2pixel

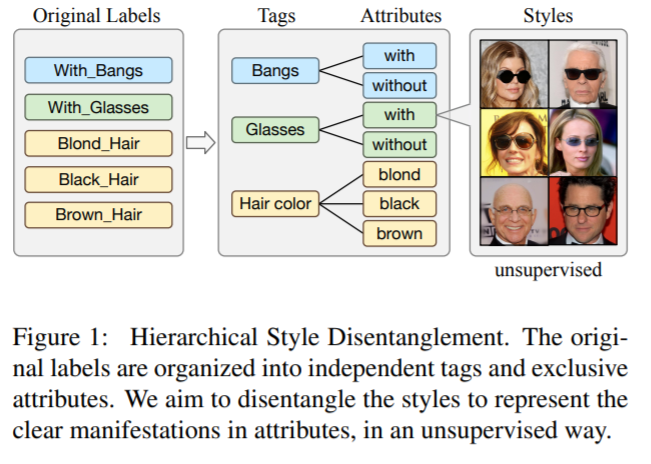

2,Image-to-image Translation via Hierarchical Style Disentanglement

近來,圖像轉(zhuǎn)換任務(wù)在多標(biāo)簽(不同標(biāo)簽為條件)和多風(fēng)格的生成任務(wù)上都取得了不錯(cuò)進(jìn)展。

但由于標(biāo)簽不具備獨(dú)立性、排他性,圖像轉(zhuǎn)換結(jié)果b并不能完全精準(zhǔn)可控。本文提出分層風(fēng)格分離(HiSD)來解決此問題。具體來說,將標(biāo)簽組織成分層的樹狀結(jié)構(gòu),其中獨(dú)立的標(biāo)簽,排他的屬性和解耦的風(fēng)格從上到下進(jìn)行分配。相應(yīng)地,設(shè)計(jì)一種新的轉(zhuǎn)換過程以適應(yīng)上述結(jié)構(gòu),確定可控轉(zhuǎn)換的風(fēng)格。在CelebA-HQ數(shù)據(jù)集上的定性和定量實(shí)驗(yàn)都證明HiSD的能力。代碼:https://github.com/imlixinyang/HiSD

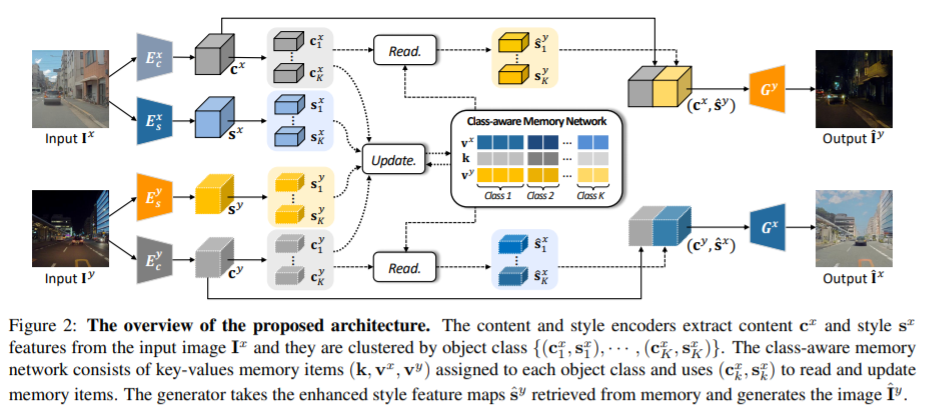

3,Memory-guided Unsupervised Image-to-image Translation

為實(shí)例級(jí)別的圖像轉(zhuǎn)換問題提供了一種新的無監(jiān)督框架。盡管近期一些方法通過融進(jìn)額外的物體標(biāo)簽可以取得進(jìn)一步的效果,但通常無法處理多個(gè)不同對(duì)象的的情形。主要原因是,在推理過程中,這些算法將全局整體的風(fēng)格應(yīng)用于整幅圖像,而沒有考慮實(shí)例個(gè)體與背景之間或個(gè)體內(nèi)部間的風(fēng)格差異。

為此,提出一個(gè)類別感知的內(nèi)存網(wǎng)絡(luò),可以顯示地明確說明局部風(fēng)格變化。引入一組具有讀/更新操作的鍵值存儲(chǔ)結(jié)構(gòu),以記錄類別的風(fēng)格變化,且在測(cè)試階段無需目標(biāo)檢測(cè)器就可以訪問它們。

“鍵”存儲(chǔ)的是與域無關(guān)的內(nèi)容表征,用于分配內(nèi)存,而“值”則編碼了域特定的風(fēng)格表征。還提出一種特征對(duì)比損失,以增強(qiáng)內(nèi)存的判別能力。實(shí)驗(yàn)表明,通過合并內(nèi)存,可以跨域遷移類別感知的、準(zhǔn)確的風(fēng)格表征。

4,ReMix: Towards Image-to-Image Translation with Limited Data

當(dāng)可用的訓(xùn)練數(shù)據(jù)是有限的時(shí)候,基于生成對(duì)抗網(wǎng)絡(luò)(GAN)的圖像到圖像(I2I)轉(zhuǎn)換方法通常有過擬合的現(xiàn)象發(fā)生。

這項(xiàng)工作提出一種數(shù)據(jù)增強(qiáng)方法(ReMix)來解決此問題:在特征級(jí)別上對(duì)訓(xùn)練樣本進(jìn)行插值,并根據(jù)樣本之間的感知關(guān)系提出一種新的內(nèi)容損失。生成器學(xué)習(xí)轉(zhuǎn)換中間樣本,而不是記住訓(xùn)練集,從而迫使判別器有更好的泛化能力。

只需稍作修改,即可輕松將ReMix方法合并到現(xiàn)有GAN模型中。在眾多任務(wù)上的實(shí)驗(yàn)結(jié)果表明,配備ReMix方法的GAN模型效果更佳。

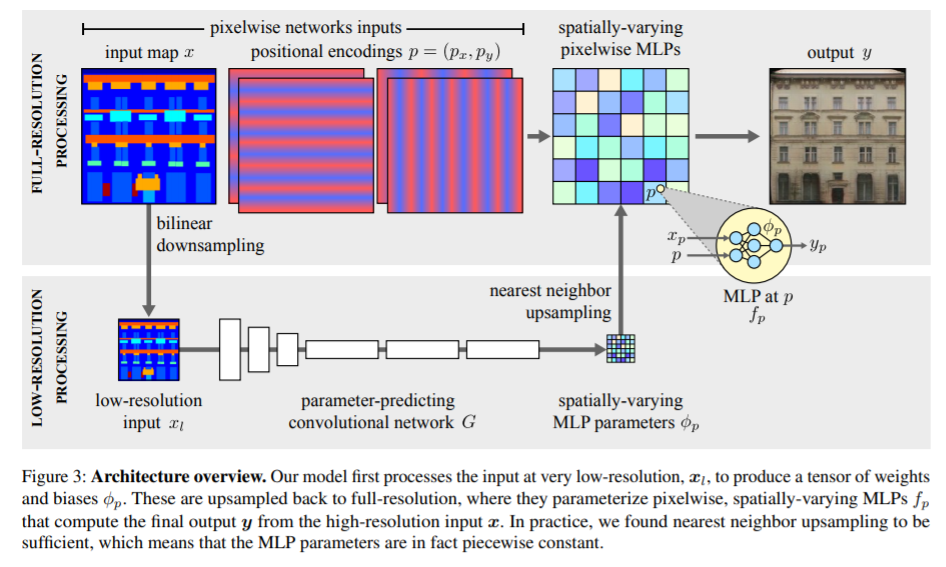

5,Spatially-Adaptive Pixelwise Networks for Fast Image Translation

介紹了一種新的生成器網(wǎng)絡(luò)結(jié)構(gòu),通過將其設(shè)計(jì)為全分辨率圖像的極輕量級(jí)網(wǎng)絡(luò),以實(shí)現(xiàn)快速高效的高分辨率圖像轉(zhuǎn)換。

通過簡單的仿射變換和非線性組合的操作,將每個(gè)像素都獨(dú)立于其它像素去進(jìn)行處理。主要采取三個(gè)關(guān)鍵步驟,使這種方法看似簡單但極具表現(xiàn)力。

首先,逐像素網(wǎng)絡(luò)的參數(shù)在空間上是變化的,因此與簡單的1×1卷積相比,它們可以表示更廣泛的函數(shù)類。其次,這些參數(shù)是由快速卷積網(wǎng)絡(luò)預(yù)測(cè)的,該網(wǎng)絡(luò)處理輸入的低分辨率表示。第三,通過拼接空間坐標(biāo)的正弦編碼來增強(qiáng)輸入圖像,為生成高質(zhì)量的圖像內(nèi)容提供了有效的歸納偏置(inductive bias)。

實(shí)驗(yàn)表明模型比此前的方法快達(dá)18倍,同時(shí)在不同的圖像分辨率和轉(zhuǎn)換中也有著極具競(jìng)爭力的視覺質(zhì)量。

等你著陸!【GAN生成對(duì)抗網(wǎng)絡(luò)】知識(shí)星球!

附下載 | 《可解釋的機(jī)器學(xué)習(xí)》中文版

附下載 |《TensorFlow 2.0 深度學(xué)習(xí)算法實(shí)戰(zhàn)》

附下載 |《計(jì)算機(jī)視覺中的數(shù)學(xué)方法》分享

《基于深度學(xué)習(xí)的表面缺陷檢測(cè)方法綜述》

《基于深度神經(jīng)網(wǎng)絡(luò)的少樣本學(xué)習(xí)綜述》