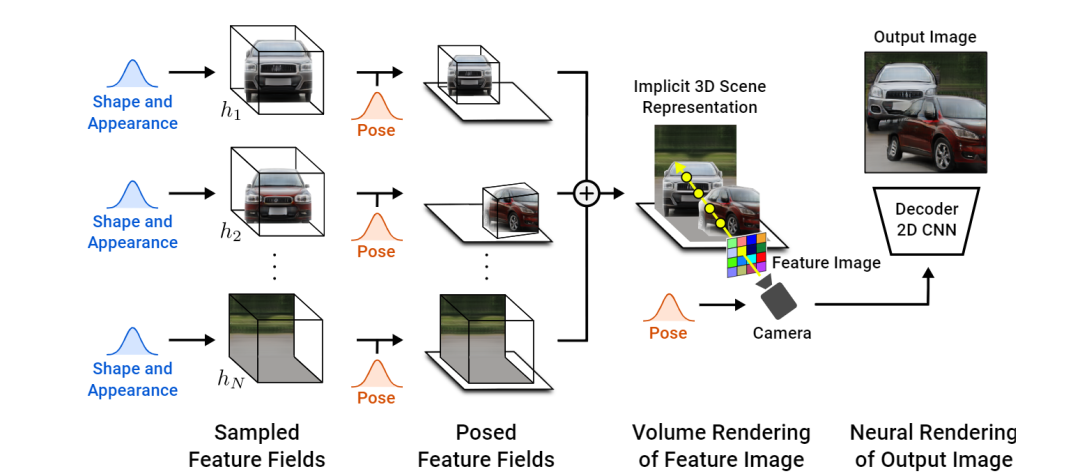

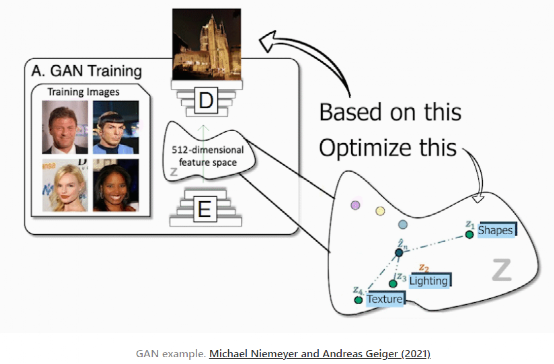

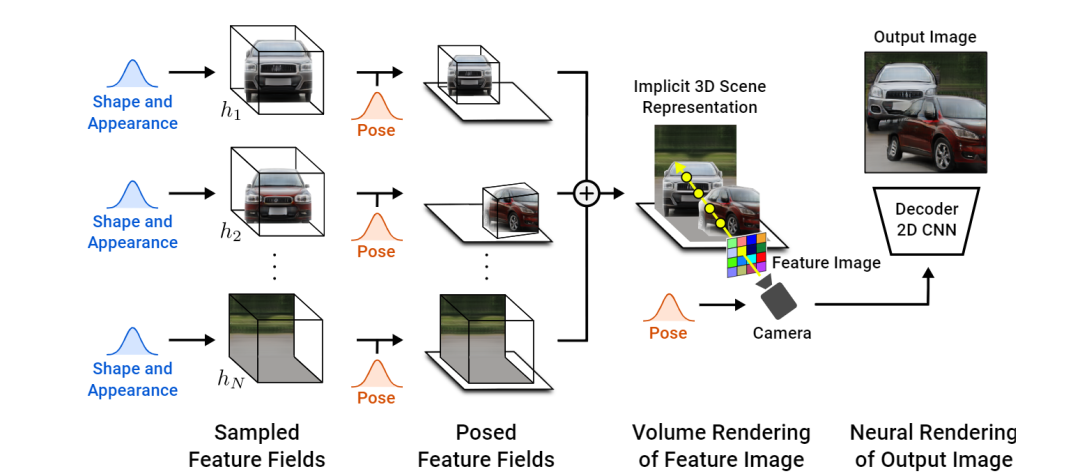

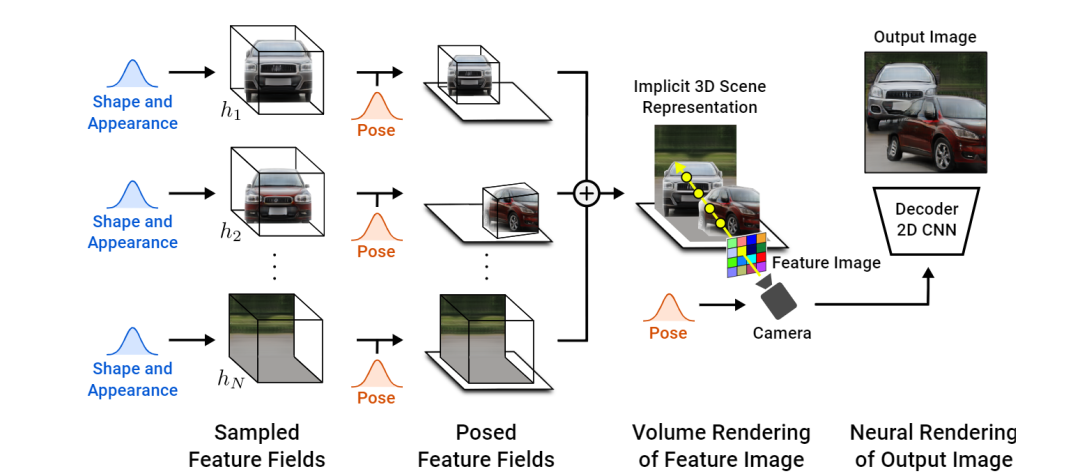

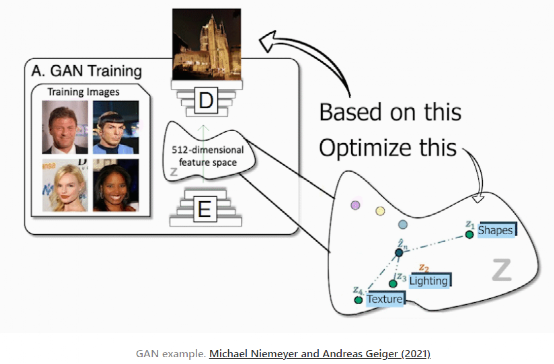

CVPR 2021 年度最佳論文獎,頒發(fā)給了來自德國馬克斯 - 普朗克研究所(Max Planck Institute)的 Michael Niemeyer 和蒂賓根大學(Tubingen)的 Andreas Geiger。這篇名為 “GIRAFFE: representation Scenes as composition Generative Neural Feature Fields” 的論文,提出了一個基于學習的、完全可微的渲染引擎 GIRAFFE,可以用于將場景合成為多個 “特征域” 的綜合,完成可控圖像的合成任務(wù)。換句話說,該任務(wù)著眼于生成新的圖像并控制將要出現(xiàn)的內(nèi)容、對象及其位置和方向、背景等等。使用改進的 GAN 架構(gòu),他們甚至可以在不影響背景或其他對象的情況下移動圖像中的對象。傳統(tǒng)的 GANs 架構(gòu)使用下圖的編碼器和解碼器設(shè)置。在訓練過程中,編碼器接收圖像后將其編碼為對應(yīng)的壓縮表征(condensed representation),隨后解碼器利用此表征來創(chuàng)建一個改變樣式的新圖像。而該團隊在訓練數(shù)據(jù)集中將所有的圖像重復(fù)多次,以便編碼器和解碼器學習如何在訓練階段最大化所要實現(xiàn)任務(wù)的結(jié)果。一旦訓練完成,你任意發(fā)送一張圖像到編碼器,它會進行同樣的過程,按你的需求生成一張新的且未知的圖像。無論何種任務(wù),它的工作原理都非常相似,不論是把一張臉的圖像轉(zhuǎn)換成如卡通形象般的別樣風格,還是用草圖創(chuàng)作出一幅美麗的風景。僅使用解碼器(decoder)(考慮到它是創(chuàng)作新圖像的模型,也將其稱為生成器),便可實現(xiàn)在這個編碼信息空間中游走,并向生成器發(fā)送樣本信息,以生成無限量的新圖像。團隊成員將這種被編碼的信息空間稱為潛在空間(latent space),而用來生成新圖像的信息稱為潛碼(latent code)。在任務(wù)的實現(xiàn)過程中,基本上選擇在最優(yōu)空間內(nèi)隨機選擇一些潛碼,然后在遵循生成器的訓練過程的前提下,根據(jù)任務(wù)的預(yù)期目標生成一個新的隨機圖像。這真是令人難以置信,但正如剛才所說的,圖像是完全隨機的,我們沒有或很少有想法,它會是什么樣子,這已經(jīng)是非常少的有用的創(chuàng)造者了。實際上,通過獲取物體形狀和外觀的潛碼并將其發(fā)送給解碼器或生成器,他們便能夠控制物體的姿態(tài),這意味著可以進行物體的移動,改變物體的外觀,添加其他對象,改變背景,甚至改變相機的姿勢。所有的這些轉(zhuǎn)換都可以在每個對象或背景上獨立完成,而不影響圖像中的任何其他內(nèi)容。如你所見,這種方法比其他基于 GAN 的方法要好得多,這些方法僅停留在 2D 圖像世界中,通常無法將對象彼此分離,并且都受到特定對象修改的影響。而文中方法的不同之處在于,提供了一種模塊化的框架,以完全可微且可學習的方式從對象中構(gòu)建和組成 3D 場景。但除此之外,過程非常相似:編碼信息,識別對象,在潛在空間中進行編輯,然后解碼生成新的圖像。在這里,還有很多步驟需要在潛在空間中完成。研究團隊將其視為經(jīng)典 GANs 圖像合成網(wǎng)絡(luò)與神經(jīng)渲染器(neural renderer)的結(jié)合,其中,正如我們所見,神經(jīng)渲染器用于從發(fā)送到網(wǎng)絡(luò)的圖像生成 3D 場景。實現(xiàn)這一目標主要有以下三個步驟。需要注意的是,編碼輸入圖像后則意味著已處于潛在空間之中。這并非是簡單的 3D 場景,而是一個由 3D 元素組成的 3D 場景,即對象和背景。這種將圖像視為由生成的體渲染圖組成的場景的方式允許它們在生成的圖像中改變攝像機位,并獨立地控制對象。這是使用一個與先前論文中出現(xiàn)的類似的模型 NERV 來實現(xiàn)的,但不是使用一個單一的模型來從輸入圖像生成整個鎖定的場景,而是采用兩個單獨的模型獨立生成對象和背景,這里稱做采樣特征域(Sampled Feature Fields)。該網(wǎng)絡(luò)的參數(shù)也在訓練過程中學習。至于細節(jié)方面,它非常類似于先前文章中提到的 NERF。第二步:編輯區(qū)域。具備了帶有分離元素的場景,便可以單獨編輯它們而不影響圖像的其余部分。當然,他們可以對物體做任何想做的操作,比如改變其位置和方向。換句話說,他們改變了對象或背景的姿態(tài)。在這一點上,甚至可以添加新的對象放置在其想要的任何方位。然后,通過把所有的特征字段添加到一起,將它們簡單地組合到涵蓋所有對象和背景的最終 3D 場景中。由于當前階段仍處于 3D 世界中,團隊可以通過改變攝像機的視角來決定如何看待場景。然后,根據(jù)該相機光線和其他參數(shù)(如 alpha 值和透射率)來評估每個像素。這就得到了所謂的特征圖像,但這個特征圖像是由每個像素的特征向量組成的圖像。因為處于潛在性空間之中,這些特征需要轉(zhuǎn)換成 RGB 顏色和高分辨率圖像。這是使用典型的解碼器來完成的,就像其他 GANs 架構(gòu)一樣,將其放大到原始尺寸,同時學習 RGB 通道的特征轉(zhuǎn)換。由此,你可以對生成的內(nèi)容進行更多的控制。當然,正如你所看到的,落地到真實數(shù)據(jù)中時仍然是不完美的。盡管如此,這項工作仍然讓人印象深刻,它是朝著正確方向邁出的重要一步,特別是考慮到這些都是由 GANs 生成的合成圖像,并且這是第一篇能夠?qū)⑸蓤D像控制在這種精度水平的論文。GIRAFFE 堪稱是對近期 NERF 和 GANs 相關(guān)領(lǐng)域的一個令人興奮的研究,在此強烈推薦讀者朋友們可以下載論文閱讀,以具體了解他們的模型是如何工作的(作者公眾號“數(shù)據(jù)實戰(zhàn)派” 后臺回復(fù) “CVPR”,即可獲得論文下載鏈接)。

下載APP

下載APP