FPT:又是借鑒Transformer,這次多方向融合特征金字塔 | ECCV 2020

論文提出用于特征金字塔的高效特征交互方法FPT,包含3種精心設(shè)計的特征增強操作,分別用于借鑒層內(nèi)特征進行增強、借鑒高層特征進行增強以及借鑒低層特征進行增強,F(xiàn)PT的輸出維度與輸入一致,能夠自由嵌入到各種包含特征金字塔的檢測算法中,從實驗結(jié)果來看,效果不錯

來源:曉飛的算法工程筆記 公眾號

論文: Feature Pyramid Transformer

論文地址:https://arxiv.org/abs/2007.09451 論文代碼:https://github.com/ZHANGDONG-NJUST/FPT

Introduction

? 講論文前先捋一下CNN網(wǎng)絡(luò)結(jié)構(gòu)相關(guān)的知識,論文的思想主要來自兩個,一個是特征金字塔結(jié)構(gòu),一個是Non-local網(wǎng)絡(luò):

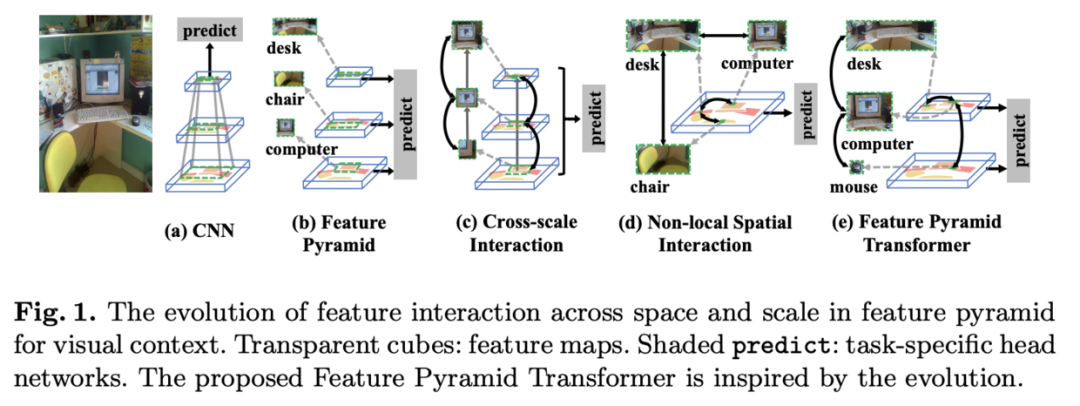

首先是特征金字塔,如圖1a,CNN網(wǎng)絡(luò)以層級結(jié)構(gòu)的形式逐層提取更豐富的特征,然后使用最后的特征層進行預(yù)測。但對于一些小物體而言,最后一層的特征圖往往沒有足夠的像素點進行預(yù)測。為了更好地對不同大小的物體進行預(yù)測,人們提出圖1b的金字塔特征,大物體使用高層的粗粒度特征,小物體使用底層的細(xì)粒度特征。對于一些pixel-level任務(wù),比如語義分割,需要綜合不同層的上下文信息進行細(xì)致的預(yù)測,所以就需要圖1c的預(yù)測結(jié)構(gòu)。 其次是Non-local network,該網(wǎng)絡(luò)借鑒了NLP模型的Self-attention思想,如圖1d所示,能夠借鑒特征圖上的其它特征點來對當(dāng)前特征點進行增強。

? 基于上面兩個思想,論文提出了FPT(Feature Pyramid Transformer),結(jié)構(gòu)如圖1e所示,核心在特征金字塔上進行類似Non-local的特征增強,然后再使用多層特征進行預(yù)測。FPT設(shè)計了3種特征增強操作,也是論文的主要貢獻:

ST(Self-Transformer):跟non-local操作一樣在對當(dāng)前層進行特征增強。 GT(Grounding Transformer):這是top-down形式的non-local操作,將高層特征(尺寸小的)分別用于低層特征的增強。 RT(Rendering Transformer):這是bottom-up形式的non-local操作,將低層特征(尺寸大的)分別用于高層特征的增強。

Feature Pyramid Transformer

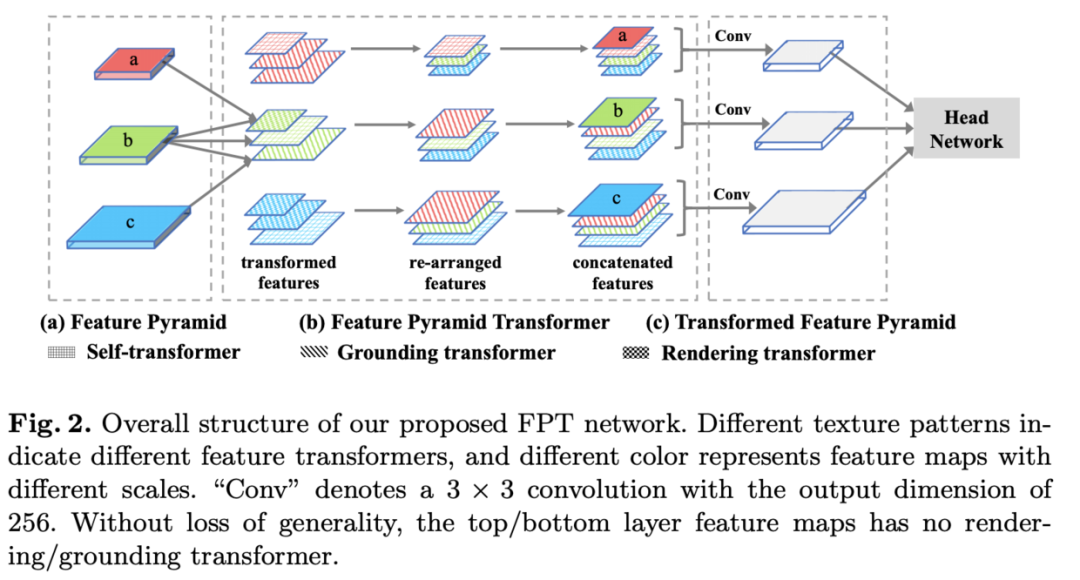

? FPT的特征轉(zhuǎn)換流程如圖2所示,輸入為金字塔特征,首先對每層特征分別進行ST、GT、RT特征增強得到多個增強后的特征,然后對增強的特征按尺寸進行排序,將相同大小的特征concate到一起,通過卷積將增強后的特征維度恢復(fù)到輸入時的相同維度。

Non-Local Interaction Revisited

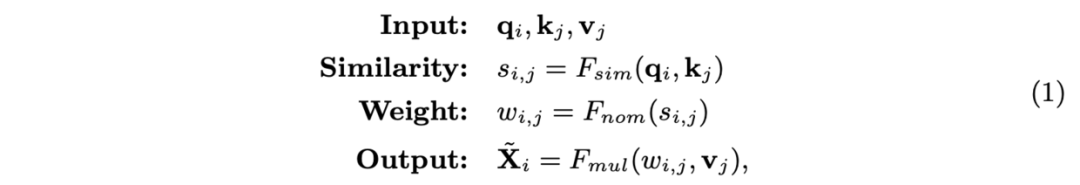

? 由于論文提出的特征增強操作與non-local操作有很大關(guān)系,這里需要先介紹下non-local的思想。常規(guī)non-local操作的輸入為單特征圖上的queries(Q), keys(K)和values(V),輸出與尺寸相同的增強特征:

,,,、和為對應(yīng)的線性變換,和為特征圖上的第和位置上的特征,為相似度函數(shù),默認(rèn)為點積,為歸一化函數(shù),默認(rèn)為softmax,為權(quán)重集成函數(shù),默認(rèn)為矩陣相乘,為輸出特征圖的第位置上的特征。

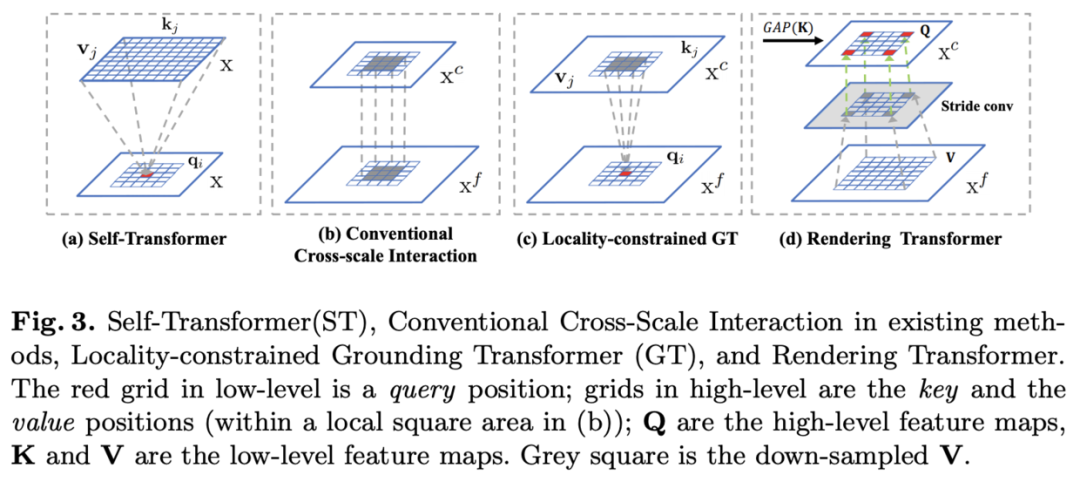

Self-Transformer

? ST為改進版non-local操作,如圖1a所示,主要有兩點不同:

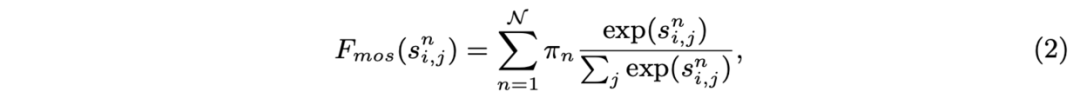

將和分為部分,然后計算每部分的每組和相似度分?jǐn)?shù) 相似度計算使用改進的MoS(Mixture of Softmaxes)函數(shù):  為特征集成時的權(quán)重,為可學(xué)習(xí)的線性變換,為所有的均值。

為特征集成時的權(quán)重,為可學(xué)習(xí)的線性變換,為所有的均值。

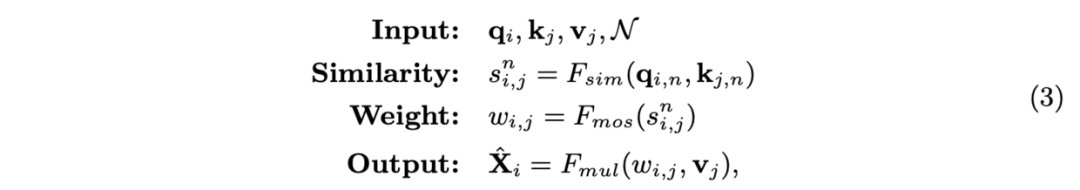

? 基于上述的改進,ST定義為:

Grounding Transformer

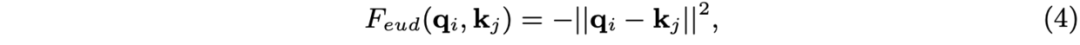

? GT是top-down形式的non-local操作,如圖2c所示,借用高層的粗粒度特征來增強低層的細(xì)粒度特征。在計算時,相似度計算由點積替換為更高效的歐氏距離:

,。GT跟ST一樣將和分為部分,完整的定義為:

? 在特征金字塔中,高低層特征分別包含圖片的全局和局部信息,而對于語義分割任務(wù),不需要關(guān)注過多高層的全局信息,更多的是需要query位置附近的上下文信息,所以圖3b的跨層卷積對語義分割任務(wù)十分有效。由于GT操作是全局計算,所以論文提出了局部約束(Locality-constrained)的GT操作LGT,如圖3c所示,每個只與高層局部區(qū)域的和進行計算。高層局部區(qū)域以對應(yīng)的位置為中心,邊長(square size)為固定值。如果高層的局部區(qū)域越出了特征圖,則使用0代替。

Rendering Transformer

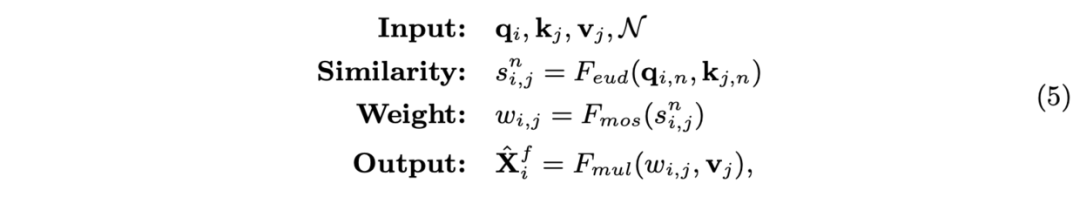

? 與GT相反,RT是bottom-up形式的non-local操作,借用低層的細(xì)粒度特征來增強高層的粗粒度特征。RT也是局部約束(Locality-constrained)的,以channel-wise進行計算的,定義高層特征為,低層特征為和,計算步驟包含如下:

對和進行全局平均池化得到權(quán)重。 使用權(quán)重對進行加權(quán)得到。 對進行帶stride的卷積下采樣得到。 使用卷積對進行調(diào)整,并與相加,再過一層卷積后輸出。

? 完整RT的定義為:

為外積函數(shù),為帶stride的卷積,為用于調(diào)整的卷積,為包含卷積的特征相加函數(shù)。

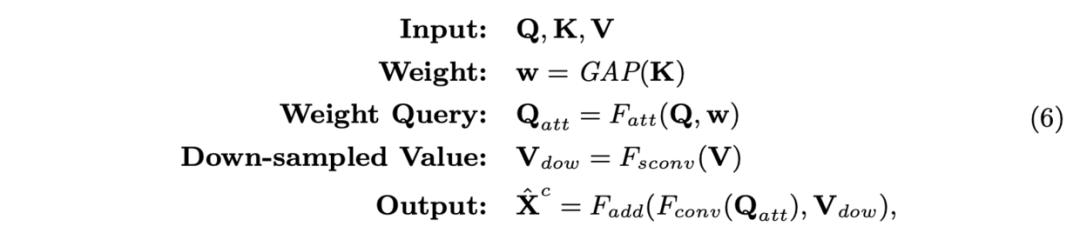

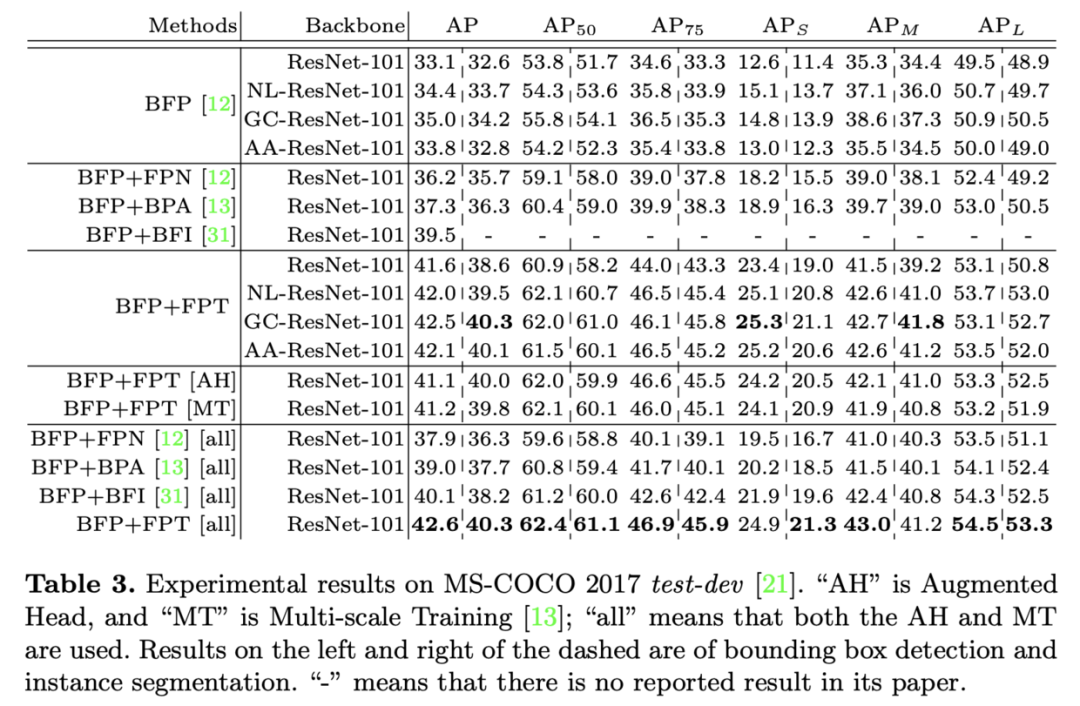

Experiments

? 在COCO上與其它算法的對比實驗。

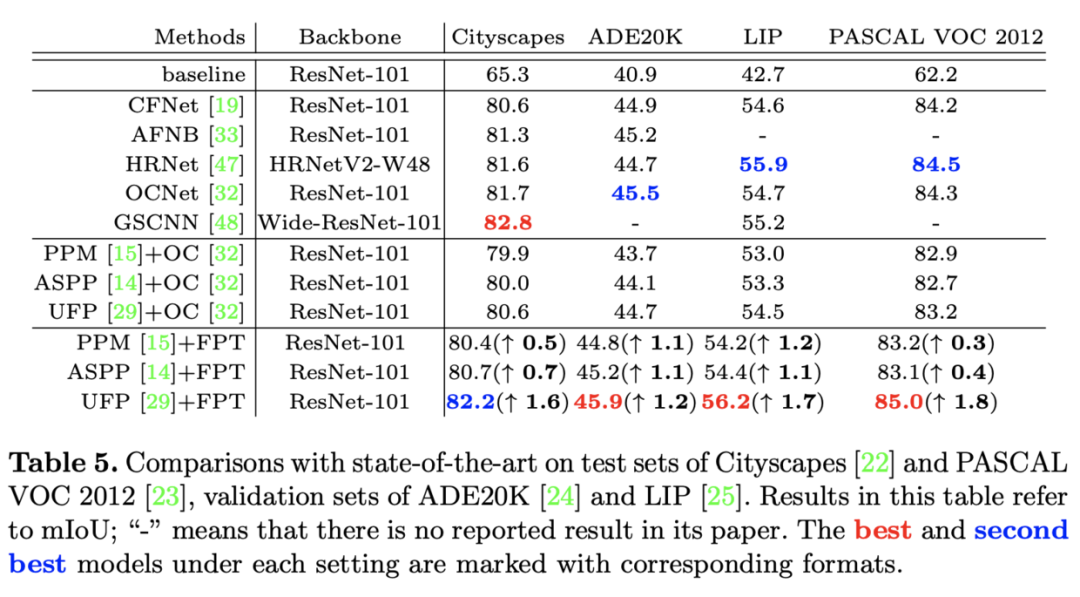

? 在多個數(shù)據(jù)集上的進行語義分割性能對比。

Conclusion

? 論文提出用于特征金字塔的高效特征交互方法FPT,包含3種精心設(shè)計的特征增強操作,分別用于借鑒層內(nèi)特征進行增強、借鑒高層特征進行增強以及借鑒低層特征進行增強,F(xiàn)PT的輸出維度與輸入一致,能夠自由嵌入到各種包含特征金字塔的檢測算法中,從實驗結(jié)果來看,效果不錯。

?

下載1:何愷明頂會分享

在「AI算法與圖像處理」公眾號后臺回復(fù):何愷明,即可下載。總共有6份PDF,涉及 ResNet、Mask RCNN等經(jīng)典工作的總結(jié)分析

下載2:leetcode?開源書

在「AI算法與圖像處理」公眾號后臺回復(fù):leetcode,即可下載。每題都 runtime beats 100% 的開源好書,你值得擁有!

下載3 CVPR2020 在「AI算法與圖像處理」公眾號后臺回復(fù):CVPR2020,即可下載1467篇CVPR?2020論文 個人微信(如果沒有備注不拉群!) 請注明:地區(qū)+學(xué)校/企業(yè)+研究方向+昵稱

覺得不錯就點亮在看吧