基于Transformers入門自然語言處理!

前言

讀者朋友們好,我是多多,許久未見,甚是想念。

我最近忙了1件自己感覺有意義的事情,特來分享。我將之前零零散散的Transformer博客、講解文章進行了整理,形成了一個完整的教程叫做:learn nlp with transformers,翻譯過來是:基于Transformers入門自然語言處理。在這個Transformer橫行的時間點,我也希望這個開源教程能夠幫助到剛剛接觸Transformers、剛剛接觸NLP的同學(xué)們!

教程網(wǎng)站是:https://datawhalechina.github.io/learn-nlp-with-transformers

教程Github是:https://github.com/datawhalechina/learn-nlp-with-transformers (截止目前165 Stars 歡迎點Star支持)

先特別感謝以下個人,組織的大力支持,再對Transformer教程進行介紹。感謝:張帆,張賢,李濼秋,蔡杰,hlzhang,臺運鵬, 張紅旭,文睿,開源組織Datawhale,Datawhale熱心的組隊學(xué)習(xí)成員們以及內(nèi)測的全部同學(xué)們!

寫教程的出發(fā)點

寫這個教程的初衷是:當(dāng)初自己入門NLP的時候,受到了很多大佬博客的幫助,所以也希望自己在力所能及的范圍內(nèi)幫助一下未來的NLP、Transformer初學(xué)者。所以我在參考了網(wǎng)上諸多大佬的文章、代碼講解后,結(jié)合一些個人的理解,整理了這個教程。希望這個教程能幫助到以下特點的學(xué)習(xí)者:

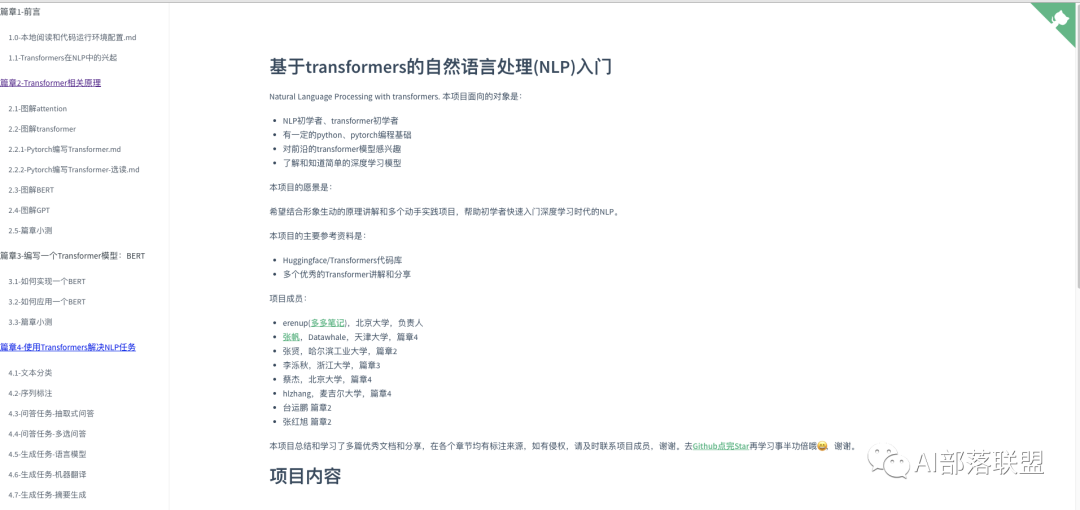

NLP初學(xué)者、transformer初學(xué)者 有一定的python、pytorch編程基礎(chǔ) 對前沿的transformer、NLP模型感興趣 了解和知道簡單的深度學(xué)習(xí)模型

教程主要內(nèi)容

教程從Attention、注意力機制出發(fā),講解Transformer模型結(jié)構(gòu),然后詳解BERT、GPT原理和預(yù)訓(xùn)練方法,再深入實現(xiàn)一個BERT,最后基于流行的Huggingface/Transformers代碼庫調(diào)用各種Transformer模型來解決4大類經(jīng)典NLP任務(wù)。

教程的主要章節(jié)和內(nèi)容是:

篇章1-前言 1.0-本地閱讀和代碼運行環(huán)境配置 1.1-Transformers在NLP中的興起 篇章2-Transformer相關(guān)原理 2.1-圖解attention 2.2-圖解transformer 2.2.1-Pytorch編寫Transformer 2.2.2-Pytorch編寫Transformer-選讀 2.3-圖解BERT 2.4-圖解GPT 2.5-篇章小測 篇章3-編寫一個Transformer模型:BERT 3.1-如何實現(xiàn)一個BERT 3.2-如何應(yīng)用一個BERT 3.3-篇章小測 篇章4-使用Transformers解決NLP任務(wù) 4.0-前言 4.1-文本分類 4.2-序列標(biāo)注 4.3-問答任務(wù)-抽取式問答 4.4-問答任務(wù)-多選問答 4.5-生成任務(wù)-語言模型 4.6-生成任務(wù)-機器翻譯 4.7-生成任務(wù)-摘要生成 4.8-篇章小測

感興趣的讀者朋友們可以在github中查看更多細節(jié),也歡迎點Star支持哦!

結(jié)語

由于本人水平有限,所撰寫的內(nèi)容難免出現(xiàn)錯誤,希望讀者朋友們在發(fā)現(xiàn)錯誤或者歧義的表述時能夠不吝指出,也可以提交pull request幫忙修正和改進,感謝!

覺得不錯幫點贊、轉(zhuǎn)發(fā)、在看支持吧~~謝謝。

歡迎關(guān)注公眾號后回復(fù)“交流”,進入Transformer學(xué)習(xí)群。