使用OpenCV對(duì)運(yùn)動(dòng)員的姿勢(shì)進(jìn)行檢測(cè)

點(diǎn)擊上方“小白學(xué)視覺(jué)”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

如今,體育運(yùn)動(dòng)的熱潮日益流行。同樣,以不正確的方式進(jìn)行運(yùn)動(dòng)的風(fēng)險(xiǎn)也在增加。有時(shí)可能會(huì)導(dǎo)致嚴(yán)重的傷害。考慮到這些原因,提出一種以分析運(yùn)動(dòng)員的關(guān)節(jié)運(yùn)動(dòng),來(lái)幫助運(yùn)動(dòng)員糾正姿勢(shì)的解決方案。

人體姿勢(shì)估計(jì)是計(jì)算機(jī)視覺(jué)領(lǐng)域的重要問(wèn)題。它的算法有助于定位手腕,腳踝,膝蓋等部位。這樣做是為了使用深度學(xué)習(xí)和卷積神經(jīng)網(wǎng)絡(luò)的概念提供個(gè)性化的運(yùn)動(dòng)訓(xùn)練體驗(yàn)。特別是對(duì)于體育活動(dòng)而言,訓(xùn)練質(zhì)量在很大程度上取決于圖像或視頻序列中人體姿勢(shì)的正確性。

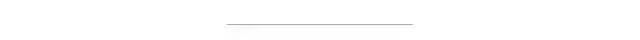

從圖像或視頻序列中檢測(cè)運(yùn)動(dòng)員的姿勢(shì)

數(shù)據(jù)集

正確選擇數(shù)據(jù)集以對(duì)結(jié)果產(chǎn)生適當(dāng)影響也是非常必要的。在此姿勢(shì)檢測(cè)中,模型在兩個(gè)不同的數(shù)據(jù)集即COCO關(guān)鍵點(diǎn)數(shù)據(jù)集和MPII人類(lèi)姿勢(shì)數(shù)據(jù)集上進(jìn)行了預(yù)訓(xùn)練。

1. COCO:COCO關(guān)鍵點(diǎn)數(shù)據(jù)集是一個(gè)多人2D姿勢(shì)估計(jì)數(shù)據(jù)集,其中包含從Flickr收集的圖像。迄今為止,COCO是最大的2D姿勢(shì)估計(jì)數(shù)據(jù)集,并被視為測(cè)試2D姿勢(shì)估計(jì)算法的基準(zhǔn)。COCO模型有18種分類(lèi)。COCO輸出格式:鼻子— 0,脖子—1,右肩—2,右肘—3,右手腕—4,左肩—5,左手肘—6,左手腕—7,右臀部—8,右膝蓋—9,右腳踝—10,左臀部—11,左膝—12,左腳踝—13,右眼—14,左眼—15,右耳—16,左耳—17,背景—18

2. MPII:MPII人體姿勢(shì)數(shù)據(jù)集是一個(gè)多人2D姿勢(shì)估計(jì)數(shù)據(jù)集,包含從Youtube視頻中收集的近500種不同的人類(lèi)活動(dòng)。MPII是第一個(gè)包含各種姿勢(shì)范圍的數(shù)據(jù)集,也是第一個(gè)在2014年發(fā)起2D姿勢(shì)估計(jì)挑戰(zhàn)的數(shù)據(jù)集。MPII模型輸出15分。MPII輸出格式:頭—0,脖子—1,右肩—2,右肘—3,右腕—4,左肩—5,左肘—6,左腕—7,右臀部—8,右膝蓋—9,右腳踝—10,左臀部—11,左膝蓋—12,左腳踝—13,胸部—14,背景—15

這些點(diǎn)是在對(duì)數(shù)據(jù)集進(jìn)行處理并通過(guò)卷積神經(jīng)網(wǎng)絡(luò)(CNN)進(jìn)行全面訓(xùn)練時(shí)生成的。

具體步驟

步驟1:需求收集(模型權(quán)重)和負(fù)載網(wǎng)絡(luò)

訓(xùn)練有素的模型需要加載到OpenCV中。這些模型在Caffe深度學(xué)習(xí)框架上進(jìn)行了訓(xùn)練。Caffe模型包含兩個(gè)文件,即.prototxt文件和.caffemodel文件。

.prototxt文件指定了神經(jīng)網(wǎng)絡(luò)的體系結(jié)構(gòu)。

.caffemodel文件存儲(chǔ)訓(xùn)練后的模型的權(quán)重。

然后我們將這兩個(gè)文件加載到網(wǎng)絡(luò)中。

# Specify the paths for the 2 filesprotoFile = "pose/mpi/pose_deploy_linevec_faster_4_stages.prototxt"weightsFile = "pose/mpi/pose_iter_160000.caffemodel"# Read the network into Memorynet = cv2.dnn.readNetFromCaffe(protoFile, weightsFile)

步驟2:讀取圖像并準(zhǔn)備輸入網(wǎng)絡(luò)

首先,我們需要使用blobFromImage函數(shù)將圖像從OpenCV格式轉(zhuǎn)換為Caffe blob格式,以便可以將其作為輸入輸入到網(wǎng)絡(luò)。這些參數(shù)將在blobFromImage函數(shù)中提供。由于OpenCV和Caffe都使用BGR格式,因此無(wú)需交換R和B通道。

# Read imageframe = cv2.imread("image.jpg")# Specify the input image dimensionsinWidth = 368inHeight = 368# Prepare the frame to be fed to the networkinpBlob = cv2.dnn.blobFromImage(frame, 1.0 / 255, (inWidth, inHeight), (0, 0, 0), swapRB=False, crop=False)# Set the prepared object as the input blob of the networknet.setInput(inpBlob)

步驟3:做出預(yù)測(cè)并解析關(guān)鍵點(diǎn)

一旦將圖像傳遞到模型,就可以使用OpenCV中DNN類(lèi)的正向方法進(jìn)行預(yù)測(cè),該方法通過(guò)網(wǎng)絡(luò)進(jìn)行正向傳遞,這只是說(shuō)它正在進(jìn)行預(yù)測(cè)的另一種方式。

output = net.forward()輸出為4D矩陣:

第一個(gè)維度是圖片ID(如果您將多個(gè)圖片傳遞到網(wǎng)絡(luò))。

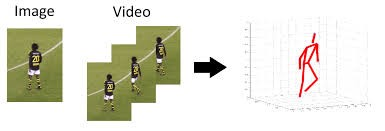

第二個(gè)維度指示關(guān)鍵點(diǎn)的索引。該模型會(huì)生成置信度圖(在圖像上的概率分布,表示每個(gè)像素處關(guān)節(jié)位置的置信度)和所有已連接的零件親和度圖。對(duì)于COCO模型,它由57個(gè)部分組成-18個(gè)關(guān)鍵點(diǎn)置信度圖+ 1個(gè)背景+ 19 * 2個(gè)部分親和度圖。同樣,對(duì)于MPI,它會(huì)產(chǎn)生44點(diǎn)。我們將僅使用與關(guān)鍵點(diǎn)相對(duì)應(yīng)的前幾個(gè)點(diǎn)。

第三維是輸出圖的高度。

第四個(gè)維度是輸出圖的寬度。

然后,我們檢查圖像中是否存在每個(gè)關(guān)鍵點(diǎn)。我們通過(guò)找到關(guān)鍵點(diǎn)的置信度圖的最大值來(lái)獲得關(guān)鍵點(diǎn)的位置。我們還使用閾值來(lái)減少錯(cuò)誤檢測(cè)。

置信度圖

一旦檢測(cè)到關(guān)鍵點(diǎn),我們便將其繪制在圖像上。

H = out.shape[2]W = out.shape[3]# Empty list to store the detected keypointspoints = []for i in range(len()):# confidence map of corresponding body's part.probMap = output[0, i, :, :]# Find global maxima of the probMap.minVal, prob, minLoc, point = cv2.minMaxLoc(probMap)# Scale the point to fit on the original imagex = (frameWidth * point[0]) / Wy = (frameHeight * point[1]) / Hif prob > threshold :cv2.circle(frame, (int(x), int(y)), 15, (0, 255, 255), thickness=-1, lineType=cv.FILLED)cv2.putText(frame, "{}".format(i), (int(x), int(y)), cv2.FONT_HERSHEY_SIMPLEX, 1.4, (0, 0, 255), 3, lineType=cv2.LINE_AA)# Add the point to the list if the probability is greater than the thresholdpoints.append((int(x), int(y)))else :points.append(None)cv2.imshow("Output-Keypoints",frame)cv2.waitKey(0)cv2.destroyAllWindows()

步驟4:繪制骨架

由于我們已經(jīng)繪制了關(guān)鍵點(diǎn),因此我們現(xiàn)在只需將兩對(duì)連接即可繪制骨架。

for pair in POSE_PAIRS:partA = pair[0]partB = pair[1]if points[partA] and points[partB]:points[partA], points[partB], (0, 255, 0), 3)

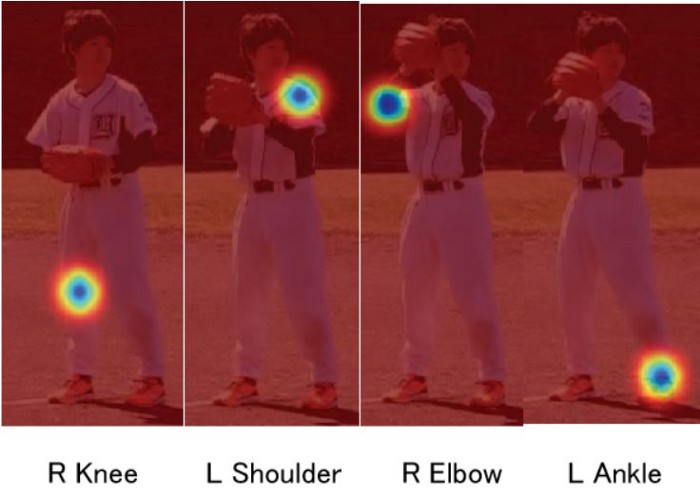

結(jié)果

上面顯示的輸出向我們顯示了運(yùn)動(dòng)員在特定時(shí)刻的準(zhǔn)確姿勢(shì)。下面是視頻的檢測(cè)結(jié)果。

項(xiàng)目源碼:https://github.com/ManaliSeth/Athlete-Pose-Detection

交流群

歡迎加入公眾號(hào)讀者群一起和同行交流,目前有SLAM、三維視覺(jué)、傳感器、自動(dòng)駕駛、計(jì)算攝影、檢測(cè)、分割、識(shí)別、醫(yī)學(xué)影像、GAN、算法競(jìng)賽等微信群(以后會(huì)逐漸細(xì)分),請(qǐng)掃描下面微信號(hào)加群,備注:”昵稱(chēng)+學(xué)校/公司+研究方向“,例如:”張三?+?上海交大?+?視覺(jué)SLAM“。請(qǐng)按照格式備注,否則不予通過(guò)。添加成功后會(huì)根據(jù)研究方向邀請(qǐng)進(jìn)入相關(guān)微信群。請(qǐng)勿在群內(nèi)發(fā)送廣告,否則會(huì)請(qǐng)出群,謝謝理解~