神經(jīng)網(wǎng)絡!圖解!

↑↑↑點擊上方藍字,回復資料,10個G的驚喜

神經(jīng)網(wǎng)絡是深度學習的載體,而神經(jīng)網(wǎng)絡模型中,最經(jīng)典非RNN模型所屬,盡管它不完美,但它具有學習歷史信息的能力。后面不管是encode-decode 框架,還是注意力模型,以及自注意力模型,以及更加強大的Bert模型家族,都是站在RNN的肩上,不斷演化、變強的。

這篇文章,闡述了RNN的方方面面,包括模型結構,優(yōu)缺點,RNN模型的幾種應用,RNN常使用的激活函數(shù),RNN的缺陷,以及GRU,LSTM是如何試圖解決這些問題,RNN變體等。

這篇文章最大特點是圖解版本,其次語言簡練,總結全面。

概述

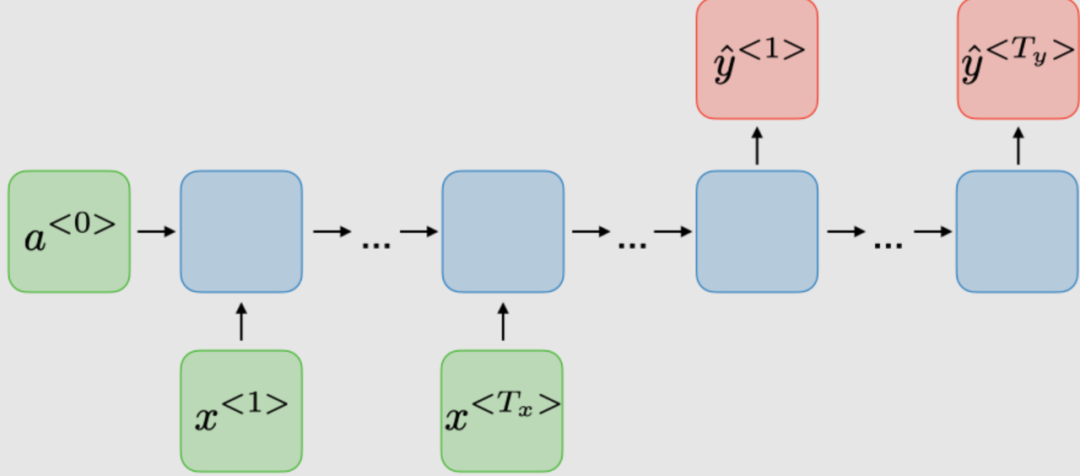

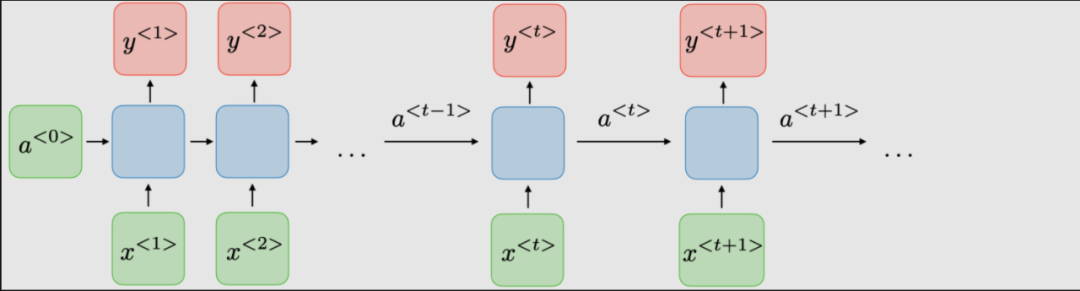

傳統(tǒng)RNN的體系結構。Recurrent neural networks,也稱為RNNs,是一類允許先前的輸出用作輸入,同時具有隱藏狀態(tài)的神經(jīng)網(wǎng)絡。它們通常如下所示:

對于每一時步 , 激活函數(shù) ,輸出 被表達為:

這里 是時間維度網(wǎng)絡的共享權重系數(shù)

是激活函數(shù)

下表總結了典型RNN架構的優(yōu)缺點:

| 優(yōu)點 | 缺點 |

|---|---|

| 處理任意長度的輸入 | 計算速度慢 |

| 模型形狀不隨輸入長度增加 | 難以獲取很久以前的信息 |

| 計算考慮了歷史信息 | 無法考慮當前狀態(tài)的任何未來輸入 |

| 權重隨時間共享 |

RNNs應用

RNN模型主要應用于自然語言處理和語音識別領域。下表總結了不同的應用:

| RNN 類型 | 圖解 | 例子 |

|---|---|---|

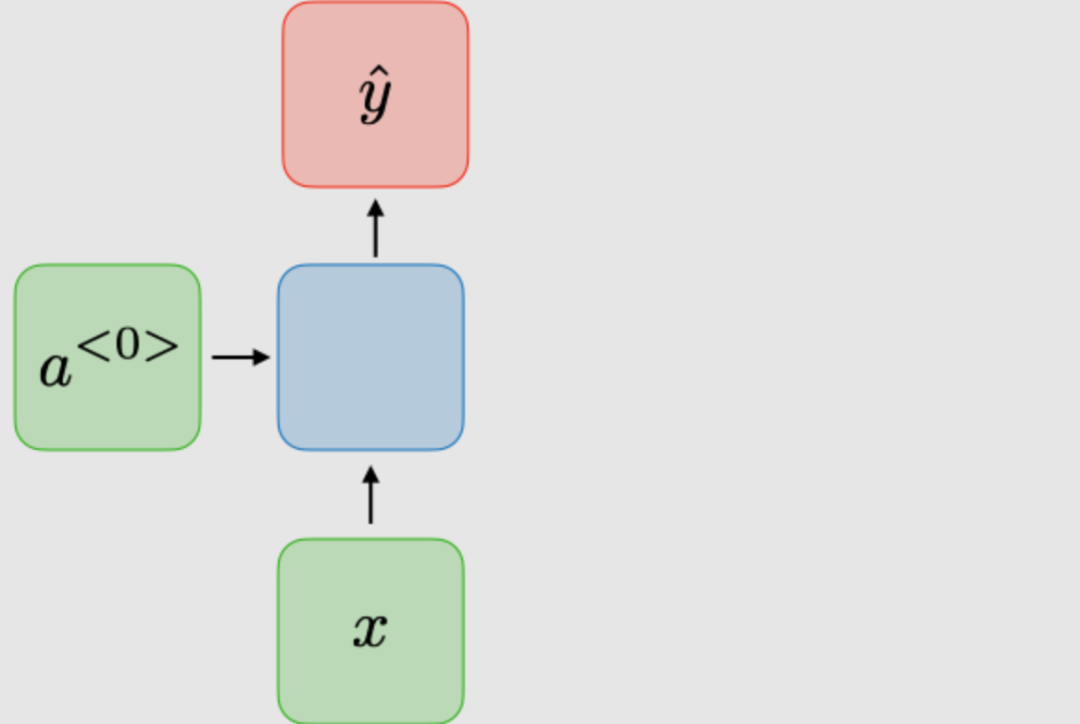

| 1對1 |

| 傳統(tǒng)神經(jīng)網(wǎng)絡 |

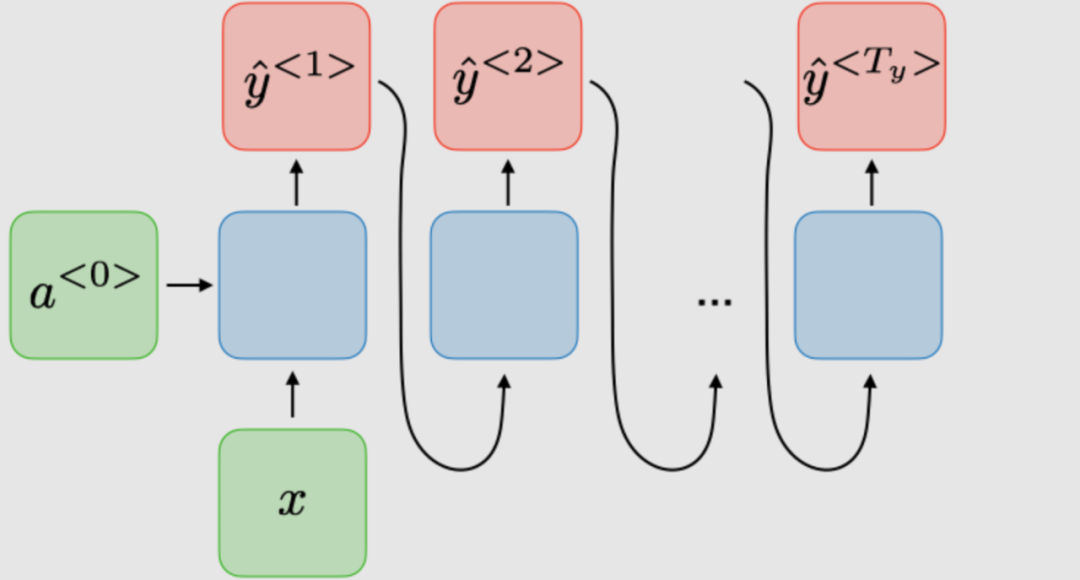

| 1對多 |

| 音樂生成 |

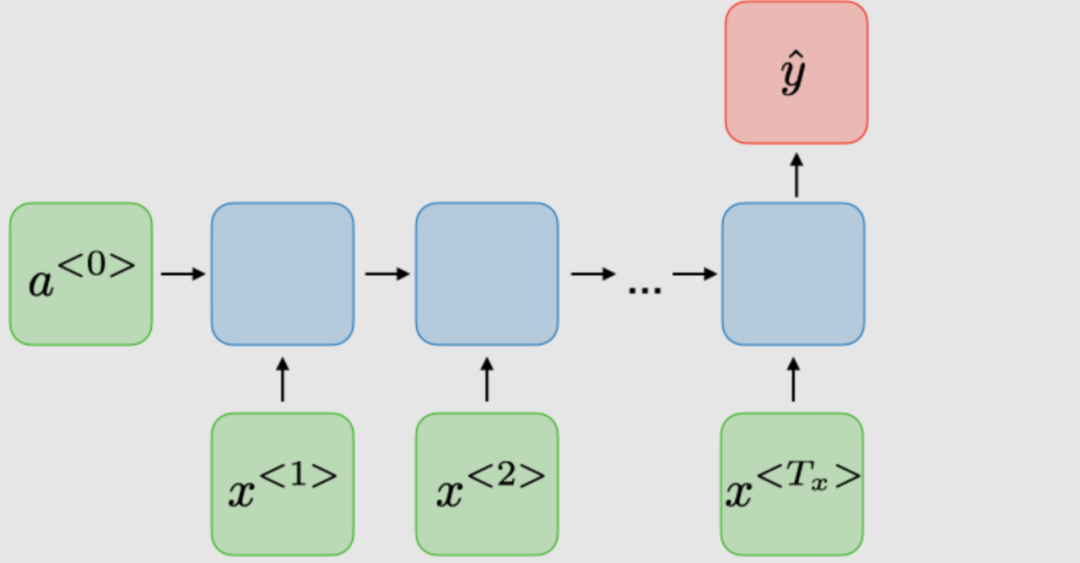

| 多對1 |

| 情感分類 |

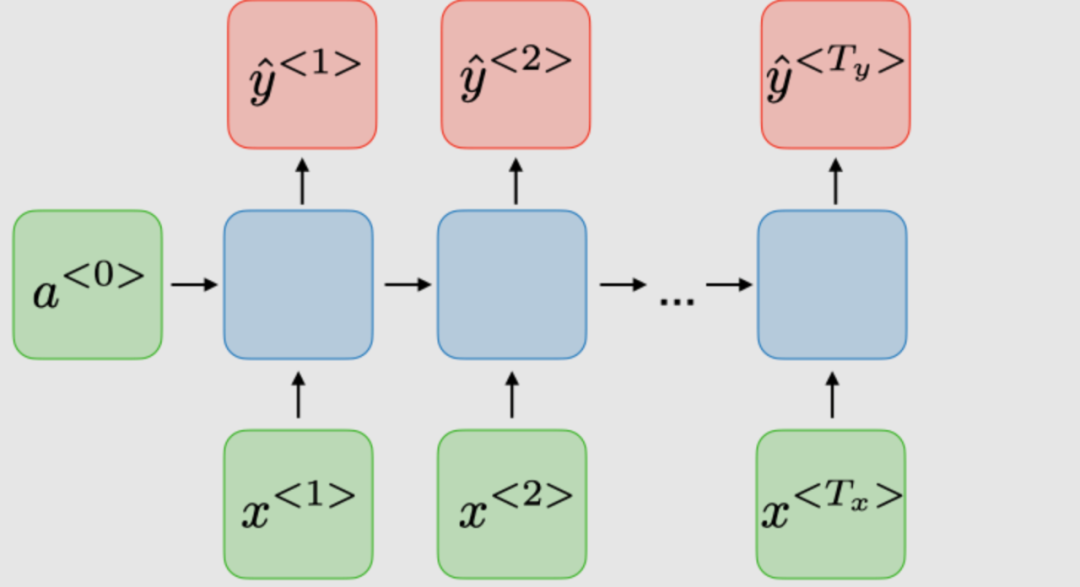

| 多對多 |

| 命名實體識別 |

| 多對多 |

| 機器翻譯 |

損失函數(shù)

對于RNN網(wǎng)絡,所有時間步的損失函數(shù) 是根據(jù)每個時間步的損失定義的,如下所示:

時間反向傳播

在每個時間點進行反向傳播。在時間步,損失相對于權重矩陣的偏導數(shù)表示如下:

處理長短依賴

常用激活函數(shù)

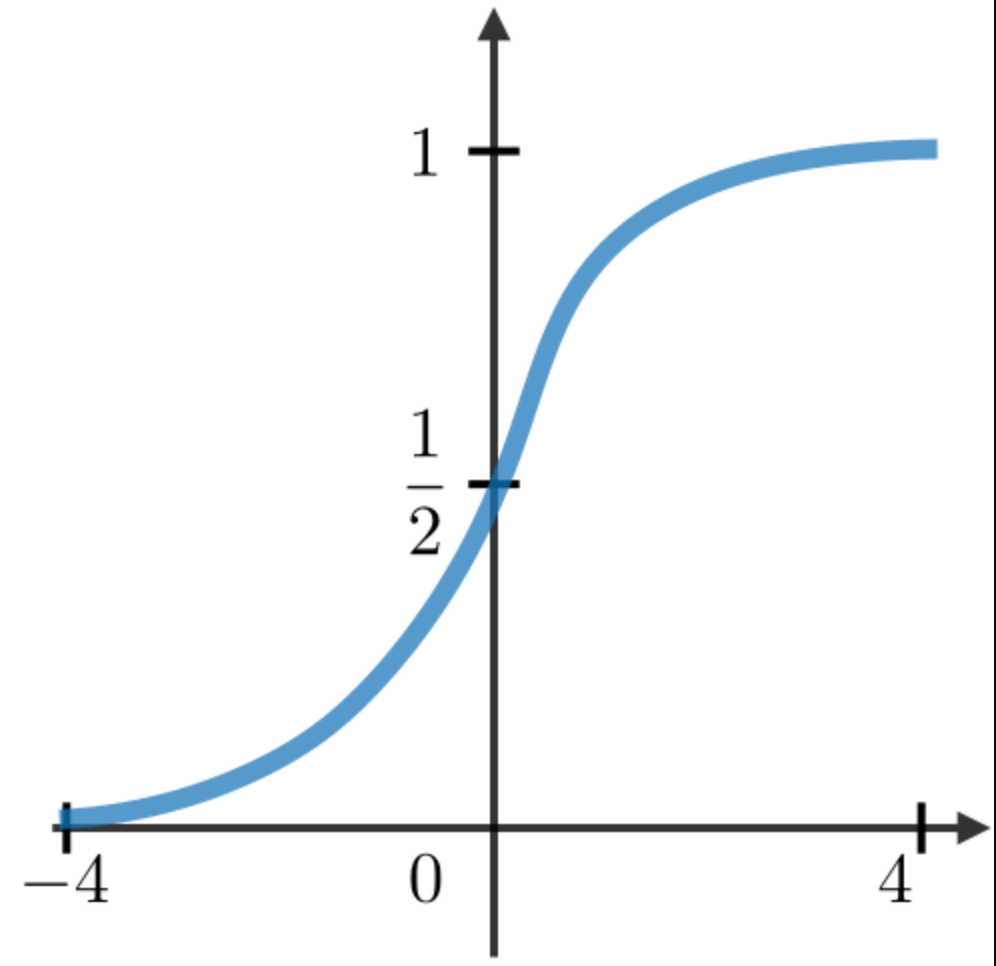

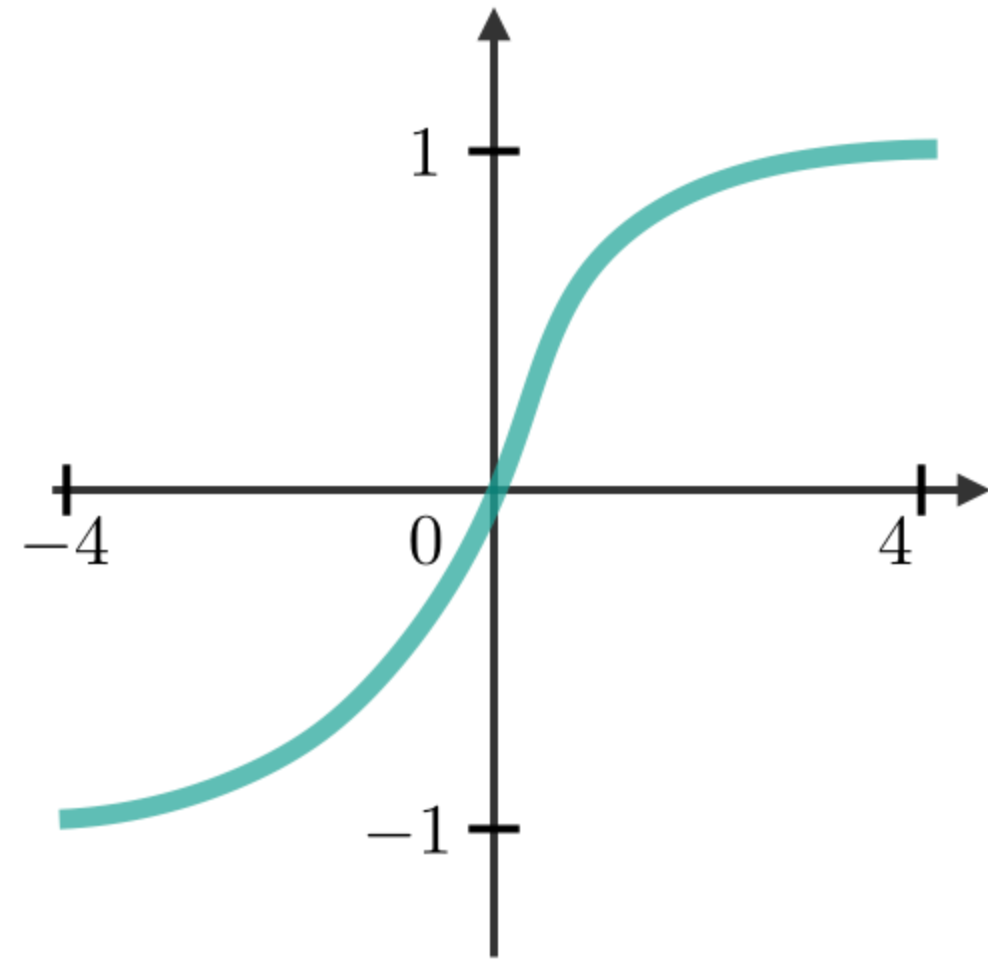

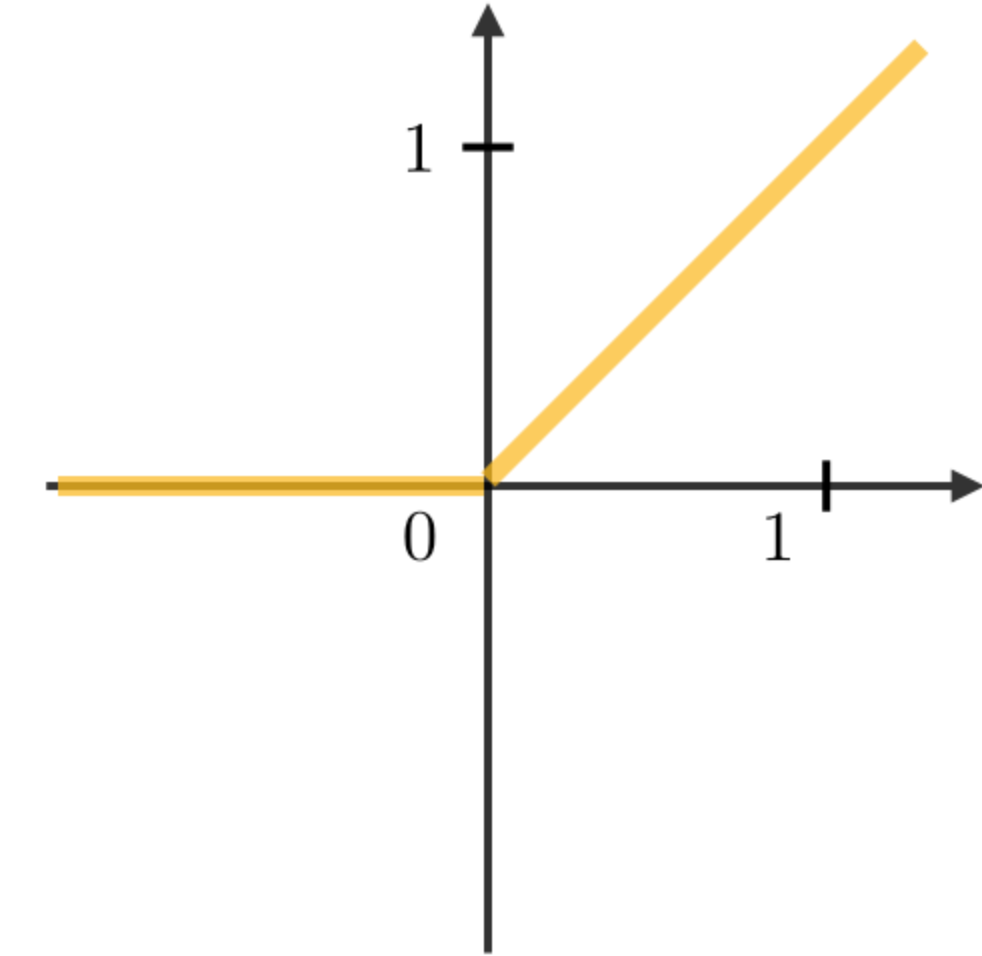

RNN模塊中最常用的激活函數(shù)描述如下:

| Sigmoid | Tanh | RELU |

|---|---|---|

|

|

|

梯度消失/爆炸

在RNN中經(jīng)常遇到梯度消失和爆炸現(xiàn)象。之所以會發(fā)生這種情況,是因為很難捕捉到長期的依賴關系,因為乘法梯度可以隨著層的數(shù)量呈指數(shù)遞減/遞增。

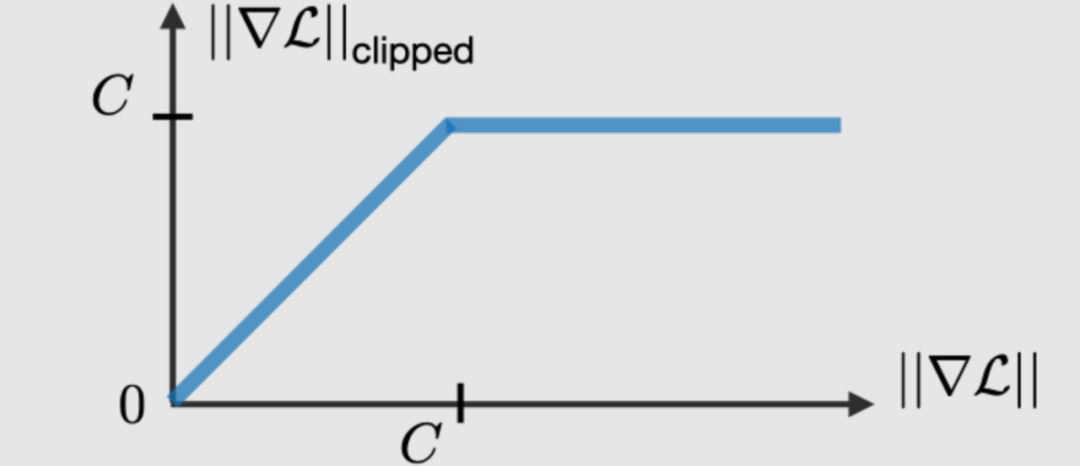

梯度修剪

梯度修剪是一種技術,用于執(zhí)行反向傳播時,有時遇到的梯度爆炸問題。通過限制梯度的最大值,這種現(xiàn)象在實踐中得以控制。

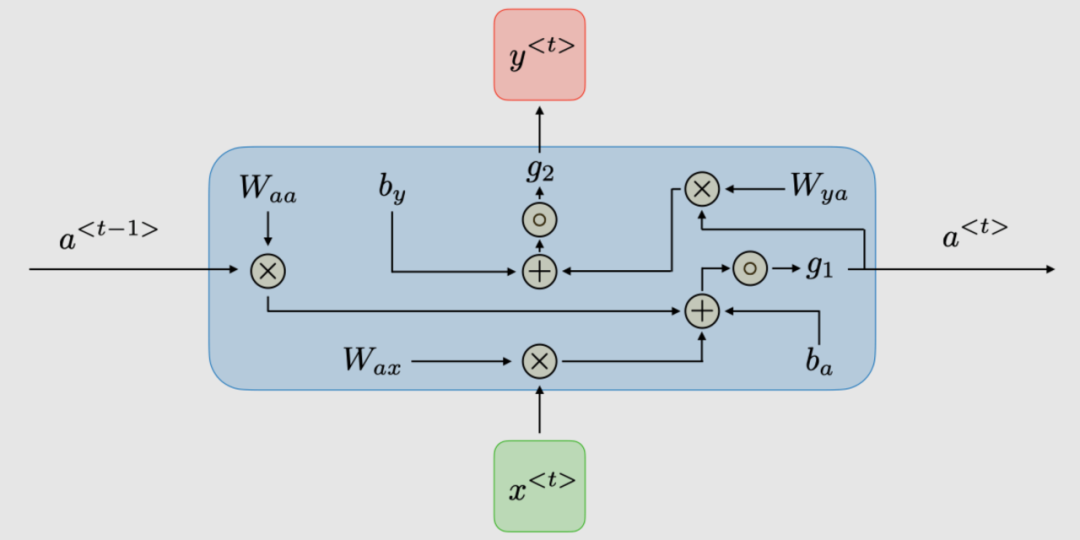

門的類型

為了解決消失梯度問題,在某些類型的RNN中使用特定的門,并且通常有明確的目的。它們通常標注為,等于:

其中,是特定于門的系數(shù),是sigmoid函數(shù)。主要內(nèi)容總結如下表:

| 門的種類 | 作用 | 應用 |

|---|---|---|

| 更新門 | 過去對現(xiàn)在有多重要? | GRU, LSTM |

| 關聯(lián)門 | 丟棄過去信息? | GRU, LSTM |

| 遺忘門 | 是不是擦除一個單元? | LSTM |

| 輸出門 | 暴露一個門的多少? | LSTM |

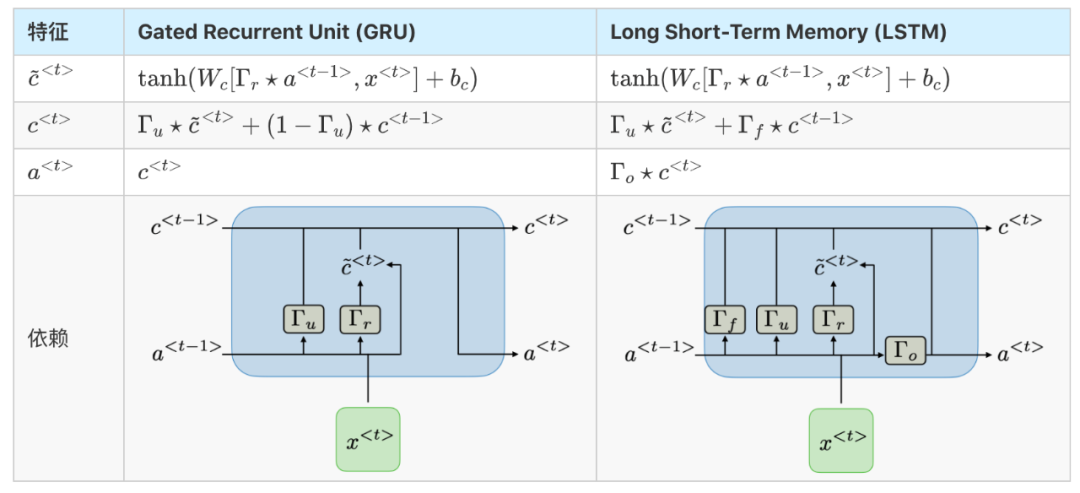

GRU/LSTM

Gated Recurrent Unit(GRU)和長-短期記憶單元(LSTM)處理傳統(tǒng)RNNs遇到的消失梯度問題,LSTM是GRU的推廣。下表總結了每種結構的特征方程:

RNN的變體

下表總結了其他常用的RNN模型:

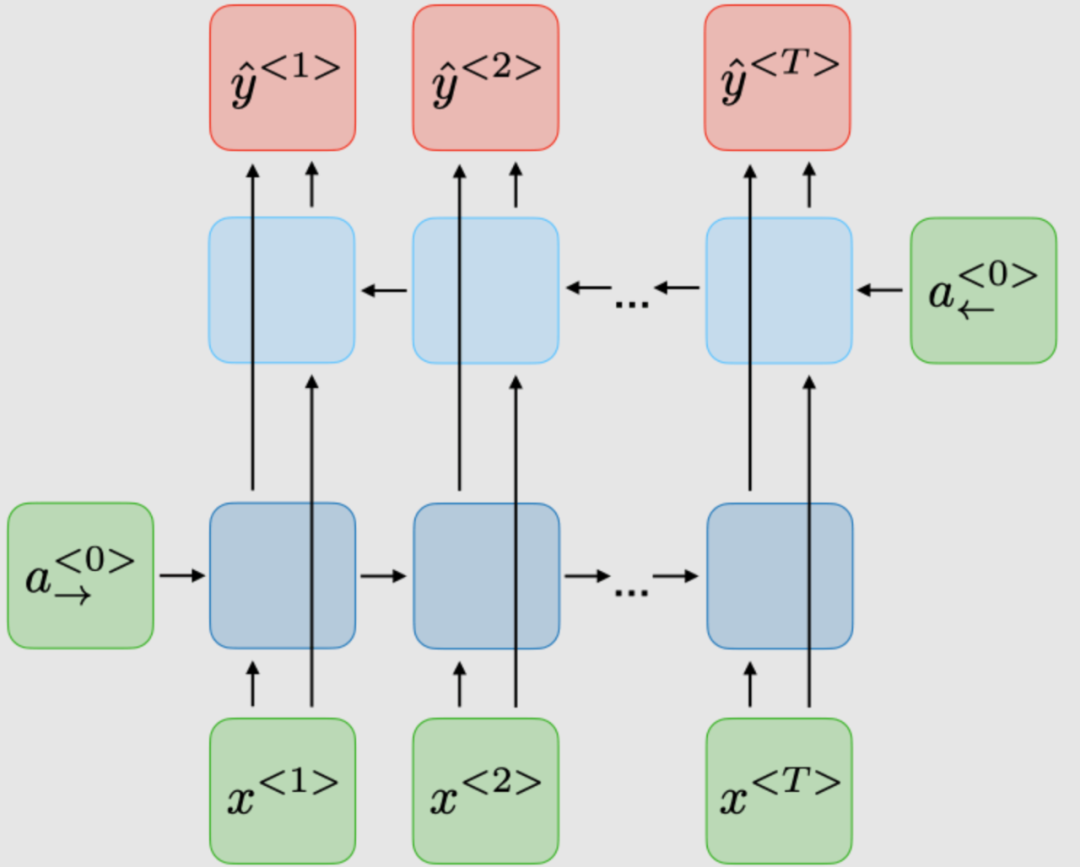

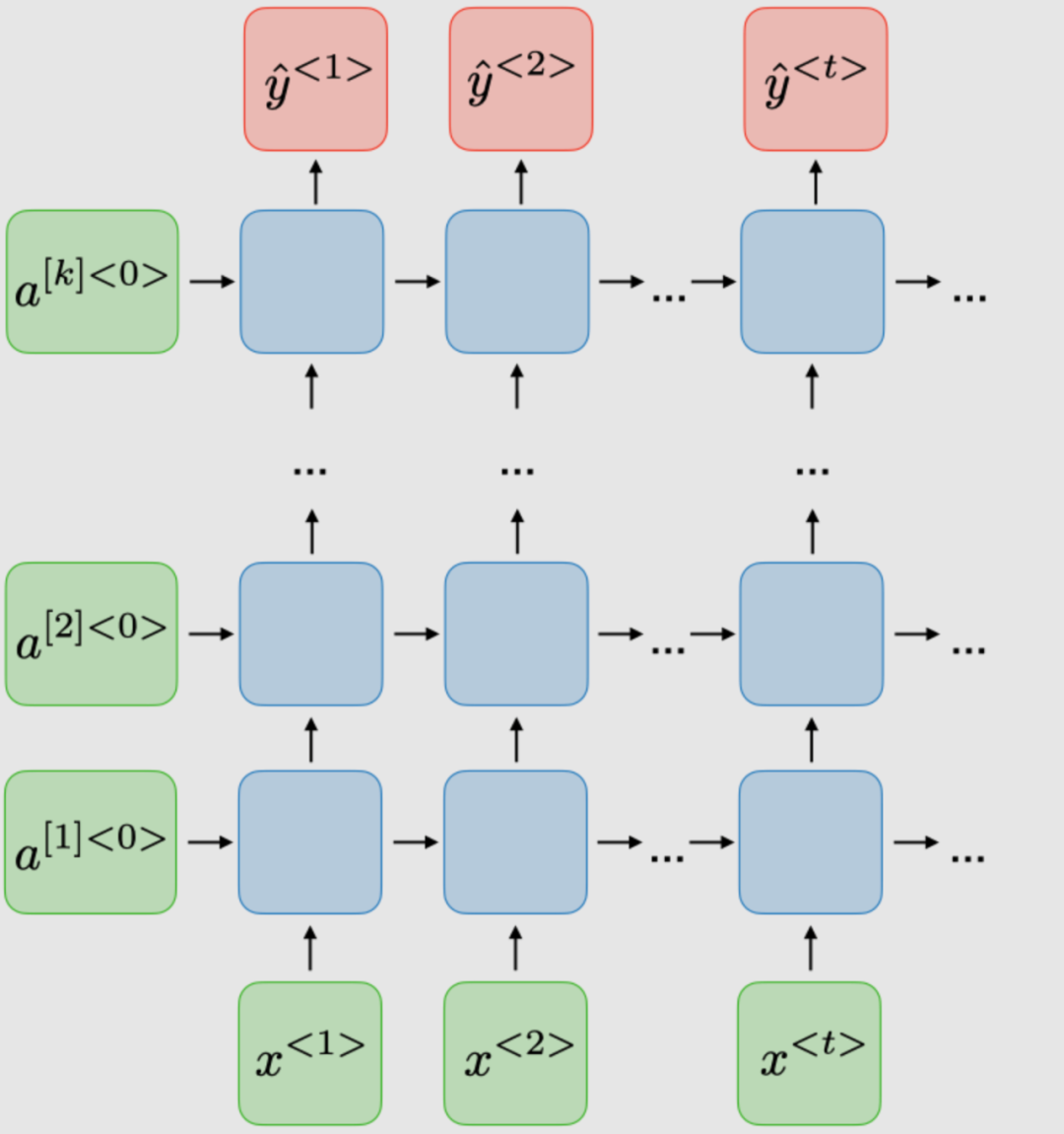

| Bidirectional (BRNN) | Deep (DRNN) |

|---|---|

|

|

也可以加一下老胡的微信 圍觀朋友圈~~~

推薦閱讀

(點擊標題可跳轉閱讀)

求分享 求點贊 求在看!!