單目標(biāo)跟蹤方法-D3s

? ?作者:? 晟? 沚?? ? ? ? ??

現(xiàn)有跟蹤算法中存在的問題

對于目標(biāo)定位的搜索問題僅適用于目標(biāo)的低維變換(平移、尺度放縮),不能有效地解決更為常見的變換(橫縱比改變、旋轉(zhuǎn)等)

現(xiàn)有方法用基于采樣的搜索或者邊界框回歸方式對目標(biāo)框的橫縱比進(jìn)行估計(jì),受到矩形框自身的限制(需要與坐標(biāo)軸對齊)

當(dāng)邊界框不能很好地表示目標(biāo)時(shí),基于模板的變換估計(jì)不一定可靠。比如當(dāng)目標(biāo)自身伸展時(shí),矩形邊界框?yàn)榱税暾哪繕?biāo),會(huì)圈入很多無關(guān)的背景信息。目標(biāo)在旋轉(zhuǎn)時(shí)也是類似,不同切面的外觀之間差異很大。簡單來說就是模板難以充分地表達(dá)目標(biāo)的各種可能的外觀。在面對這些情況時(shí),逐像素分割能夠?qū)崿F(xiàn)更準(zhǔn)確的定位,于是跟蹤問題轉(zhuǎn)變?yōu)榱艘曨l物體分割問題。

視頻物體分割一直依賴無法直接用于跟蹤,一般起到的是輔助作用,這是因?yàn)橐曨l物體分割要解決的問題是短時(shí)長(100 幀以內(nèi))視頻中的大物體分割,而在跟蹤中,目標(biāo)的外觀變化差異很大,并且會(huì)在雜亂的背景當(dāng)中移動(dòng),直接將視頻分割用于跟蹤會(huì)導(dǎo)致無法恢復(fù)的跟蹤失敗。

SiamRPN 的問題。SiamRPN 生成高質(zhì)量分割掩碼圖的過程分為兩步,一是通過 SiamRPN 分支定位邊界框,二是通過另一個(gè)分支在這個(gè)邊界框區(qū)域中計(jì)算掩碼圖,這種兩步過程將定位和分割步驟分開,沒有將二者聯(lián)合利用提高魯棒性(存疑:兩個(gè)任務(wù)一起如何提高魯棒性?)。另一個(gè)問題是固定的模板難以適應(yīng)變化的場景(一般是通過模板更新解決這個(gè)問題)。

設(shè)計(jì)理念

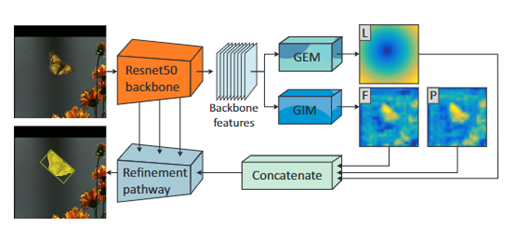

使用兩個(gè)視覺模型 GEM(geometrically constrained Euclideanmodel)和 GIM(geometricallyinvariant model)表示目標(biāo),幾何位置模型和幾何不變模型,一個(gè)約束目標(biāo)移動(dòng)的位置,一個(gè)約束目標(biāo)的形狀,二者結(jié)合后能夠?yàn)榉指钐峁┛煽康臉颖?/span>

??? GIM 犧牲空間相關(guān)性換取在目標(biāo)外觀顯著變化條件下預(yù)測邊界框大小的能力,GEM 只負(fù)責(zé)確定邊界框的位置(中心點(diǎn)),二者并行計(jì)算,最后融合輸出。

????經(jīng)過網(wǎng)絡(luò)的一次傳播,D3S 的主要輸出是一個(gè)分割圖(熱力圖),是僅用于分割端到端訓(xùn)練的。

??? D3S 可將分割圖轉(zhuǎn)換為帶有旋轉(zhuǎn)的矩形,替代原來容易出錯(cuò)的貪婪搜索方法。

??? D3S 未經(jīng)過傳統(tǒng)邊界框跟蹤的訓(xùn)練,并且沒有根據(jù)不同的數(shù)據(jù)集進(jìn)行重訓(xùn)練,具有優(yōu)異的泛化能力和靈活性。

?

算法流程

a. 將第一幀輸入骨干網(wǎng)絡(luò)提取特征

b. 將提取的特征分別輸入GIM模塊和GEM模塊,通過GIM模塊得到前景和背景信息,通過GEM模塊得到定位信息

c. 將三者通過Concat融合,然后輸入refinement得到第一幀mask和bounding box

d. 在跟蹤時(shí),使用骨干網(wǎng)絡(luò)提取待跟蹤幀搜索區(qū)域的特征

e. 將提取的特征輸入GIM模塊,通過與第一幀搜索區(qū)域比較得到像素級的前景相似度和背景相似度

f. 取每個(gè)像素相似度最高的前K個(gè),然后分別求平均得到該幀的前景相似度和背景相似度

g. 重復(fù)c即可得到該幀的mask和boundingbox

網(wǎng)絡(luò)結(jié)構(gòu)

?

D3S 模型分為 3 個(gè)部分:GEM、GIM 和 Refinement模塊。

在模板匹配的方法中,基于軸對稱的矩形框是一種不夠精確的表征方式,不能夠表達(dá)部分非軸對稱物體的外觀特征,當(dāng)后續(xù)幀中物體的寬高比發(fā)生大幅變化、物體旋轉(zhuǎn)或者有非剛性形變時(shí),會(huì)由于模板信息與后續(xù)幀差異過大而難以匹配。最準(zhǔn)確的定位方式其實(shí)是像素級別的前景背景mask分割。在現(xiàn)有結(jié)合分割的跟蹤算法中,流程大致是先定位再分割,只在目標(biāo)范圍內(nèi)計(jì)算mask,這樣沒有充分發(fā)揮分割對跟蹤的輔助作用。而頂尖的分割算法也有一定的局限性,難以應(yīng)對部分遮擋,外觀的大幅頻繁的變換以及在雜亂背景上的移動(dòng)的問題,這一定程度上限制了分割在跟蹤問題上的應(yīng)用。

本篇文章提出了兩個(gè)互補(bǔ)的模塊GIM(gemetrically invariant model)和GEM(gemetrically constrained euclidean model)。其中GIM犧牲了目標(biāo)的位置約束,可以在目標(biāo)有高度形變的前提下定位,GEM對目標(biāo)進(jìn)行位置約束,在GIM分割目標(biāo)不唯一的情況下對結(jié)果進(jìn)行篩選。

?

GIM

?

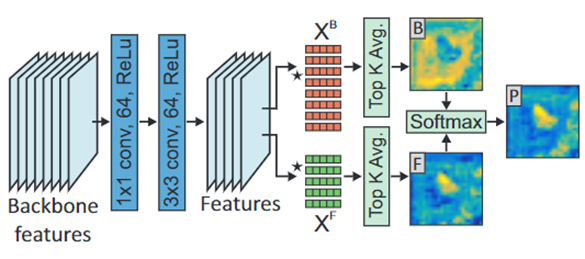

流程

a.將骨干網(wǎng)絡(luò)提取的特征輸入該模塊

b. 通過1x1和3x3卷積使特征適應(yīng)該模塊

c. 在第一幀target的每個(gè)像素上提取分割特征向量作為XF,在第一幀target附近的區(qū)域(搜索區(qū)域中非target部分)的每個(gè)像素上提取分割特征向量作為?XB

?

d. 在跟蹤時(shí)提取待跟蹤幀searchregion的像素級特征,記為 XGIM

e. 通過XGIM計(jì)算前景相似度和背景相似度

f. 取每個(gè)像素相似度最高的前K個(gè),然后分別求平均得到該幀的前景相似度和背景相似度

GIM 負(fù)責(zé)對目標(biāo)的形態(tài)進(jìn)行估計(jì),以分割的方式給出目標(biāo)所占的空間范圍(區(qū)分前景背景)。為了更加精確地分割可變形的目標(biāo)(視頻中目標(biāo)的外觀是不斷變化的),判斷區(qū)域內(nèi)前景(目標(biāo))和背景的空間約束不能太嚴(yán)格,因此 GIM 的輸出由和前景背景分別對應(yīng)的深度特征組成。

GIM 模塊首先將輸入經(jīng)過一個(gè)1x1和 3x3的卷積,目的是 1.降維 2.將 backbone 輸入的特征進(jìn)行調(diào)整,使其更適合于分割任務(wù)(YOLO 中同樣提出過類似的說法)。緊接在 backbone 后的卷積層起到類似于緩沖的作用,因?yàn)橛?xùn)練時(shí) backbone 網(wǎng)絡(luò)的參數(shù)是固定的,不進(jìn)行更新。

初始的前景/背景模型在第一幀中通過抽取像素級標(biāo)注數(shù)據(jù)建立,得到XF和 XB,二者是緊密相鄰的。

每個(gè)像素位置產(chǎn)生的特征向量都要和前景和背景通道進(jìn)行計(jì)算,每個(gè)像素位置產(chǎn)生多條特征向量,分別與前景/背景通道參數(shù)點(diǎn)乘(L2 正則化)得到一批相似度值,每個(gè)像素位置與前景/背景的相似度值為前 k 個(gè)相似度值的平均值。像素位置相似度值的計(jì)算過程對于前景和背景是完全一樣的,也就是每個(gè)像素位置都有前景相似度值和背景相似度值兩個(gè)值(較為寬松的判斷前景背景的空間約束)。除此之外,通過將全部像素位置的前景相似度值和背景相似度值進(jìn)行softmax計(jì)算,得到目標(biāo)的后驗(yàn)通道 。從 GIM 模塊繼續(xù)向后傳播的通道只有前景相似度F 和后驗(yàn)通道P。

GIM的設(shè)計(jì)如上圖。XF?是完全由第一幀的bbox中的內(nèi)容得到的,分布是前景的部分值大背景值小。?XB?則是搜索區(qū)域中全部背景特征,分布是背景值大前景值小。跟蹤幀的圖像過網(wǎng)絡(luò),在經(jīng)過1*1卷積降維,3*3卷積增強(qiáng)語義表達(dá),得到的特征分別與XF???XB做相關(guān),結(jié)果取前k張做平均得到最終的響應(yīng)圖F和B。B與??XB?相似程度高的部分被突出,其他部分被抑制,因此B基本上代表了圖像的背景信息,同理F代表前景信息。這兩張?zhí)卣鲌Dconcate起來做softmax,P選取的是softmax后表示前景的那一張?zhí)卣鲌D。由于softmax具有把大的數(shù)值放大,小的壓低的特性,因此B中的響應(yīng)越高,就會(huì)把F處的響應(yīng)壓得更低,這種做法可以理解為經(jīng)過兩次確認(rèn),F(xiàn),B互為補(bǔ)充,取得到最優(yōu)的部分作為最終的前景區(qū)域,這樣得到的前景區(qū)域更為精細(xì)。

GEM

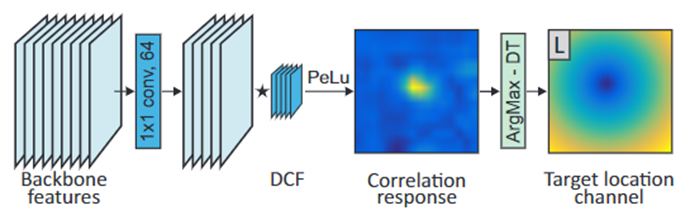

流程

a. 將骨干網(wǎng)絡(luò)提取的特征通過1x1卷積降維

b. 將降維后的特征使用相關(guān)濾波思想得到響應(yīng)圖

c. 計(jì)算響應(yīng)圖中最大響應(yīng)的位置到搜索區(qū)域中剩余像素的歐式距離,得到目標(biāo)位置通道

GIM可以將背景和前景完善的分離出來,但是缺乏相似目標(biāo)的區(qū)分能力,它犧牲了目標(biāo)的位置約束,可以在目標(biāo)有高度形變的前提下定位。

DCF 具有很好的判別性質(zhì),因此為了提高算法的判別能力,GEM 的前半部分直接移用了 ATOM 中的 DCF 結(jié)構(gòu)。但由于 DCF 算法只用到了最大響應(yīng)值,而 D3S 的輸出需要確定每個(gè)像素位置上是否出現(xiàn)了目標(biāo)(每個(gè)像素的類別是目標(biāo)還是背景),因此需要對 DCF 輸出的響應(yīng)圖進(jìn)行進(jìn)一步處理。GIM 處理的方式就是將 DCF 產(chǎn)生的響應(yīng)圖轉(zhuǎn)換為響應(yīng)圖上每個(gè)點(diǎn)到最大響應(yīng)值的距離圖,圖上的每個(gè)點(diǎn)的值就是在響應(yīng)圖上這個(gè)響應(yīng)點(diǎn)到最大響應(yīng)值點(diǎn)之間的歐式距離值。

GEM其實(shí)就是一個(gè)對目標(biāo)的位置約束,可以幫助網(wǎng)絡(luò)從若干的GIM分割出的目標(biāo)中選出最可能是目標(biāo)的一個(gè)。通過ATOM算法從第一幀可以學(xué)到一個(gè)比較判別力的filter,他和跟蹤幀作卷積可以得到一個(gè)比較可靠的響應(yīng)圖。然后計(jì)算最大響應(yīng)點(diǎn)到其他位置的歐式距離得到最后的L,也就是說距離定位到的目標(biāo)越遠(yuǎn),歐式距離越大,懲罰越大,而中心的懲罰最小。D3F依靠這樣一個(gè)響應(yīng)圖模型對GIM中分割出來的前景進(jìn)行篩選。

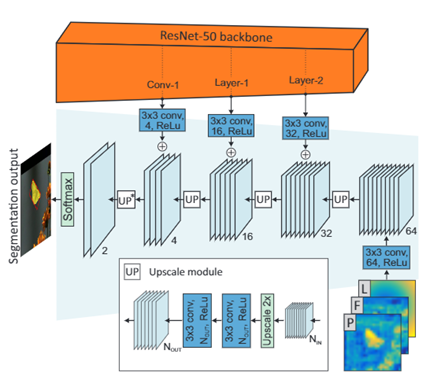

Refinement pathway

流程

a. 將GIM和GEM模塊輸出的特征通過Concat融合

b. 使用3x3卷積固定其channel為64

c. 然后通過上采樣模塊提高分辨率,并與骨干網(wǎng)絡(luò)中的特征通過相加得到融合特征

d. 重復(fù)c,最后通過Softmax得到mask

結(jié)合 GIM 和 GEM 的輸出,將兩個(gè)模塊的優(yōu)勢互補(bǔ),并對低分辨率的結(jié)果進(jìn)行上采樣,得到更為準(zhǔn)確的輸出。

將 GEM 的輸出目標(biāo)位置通道L和 GIM 的輸出前景相似度通道 F和后驗(yàn)通道 P進(jìn)行拼接,用 3x3的卷積核進(jìn)行處理。

在上采樣部分將backbone 網(wǎng)絡(luò)中不同層的輸出拼接到輸入中,可以實(shí)現(xiàn)細(xì)節(jié)上的優(yōu)化。每次上采樣都將輸入分辨率翻倍,隨后接2 個(gè) 3x3的卷積。從 GEM 和 GIM 模塊得到的輸入經(jīng)過上采樣后與 backbone 網(wǎng)絡(luò)中特定層的輸出進(jìn)行相加,將細(xì)節(jié)內(nèi)容加入到特征中。backbone 特定層的輸出并不是直接使用,而是先經(jīng)過 1 個(gè) 3x3的卷積后再與經(jīng)過上采樣的特征相加。

最后一個(gè)上采樣步驟中只有一個(gè) 3x3的卷積,上采樣后的輸出也沒有和 backbone 的輸出相加,而是后接 1 個(gè) softmax 層生成最終的分割概率圖結(jié)果。

結(jié)合下圖, 得到了目標(biāo)位置圖L,前景響應(yīng)圖F,后驗(yàn)前景響應(yīng)圖P,將他們concate起來通過一個(gè)U-net的結(jié)構(gòu)。得到L,P,F(xiàn)的過程視為encoder,上采樣恢復(fù)分辨率的過程視為decoder。其中L的大小與搜索區(qū)域相同,需要降采樣到和P,F(xiàn)相同。由于降采樣再升采樣的過程可能會(huì)導(dǎo)致大物體的邊緣和小物體本身的喪失,所以需要一些語義程度低但分辨率高的底層特征加以補(bǔ)充,因此在升采樣的過程中,還與resnet的conv-1,Layer-1,Layer-2的內(nèi)容疊加,用于復(fù)原在高層語義特征圖上可能丟失的特征。最后特征圖的分辨率恢復(fù)到與原圖相同,經(jīng)過softmax得分高的部分作為最后分割的前景,得分低的部分作為背景,然后擬合生成旋轉(zhuǎn)的邊界框。

下圖展現(xiàn)的是D3S的整體框架。

訓(xùn)練過程

初始化

D3S在跟蹤過程中,只有第一幀的信息被給出。經(jīng)過標(biāo)注的第一幀圖像用于初始化 D3S 模型,初始化的具體方式取決于提供的標(biāo)簽是矩形邊界框還是分割掩碼圖。

其中模塊GEM的初始化方法與ATOM相同,使用軸對齊的bbox標(biāo)注進(jìn)行初始化。

GIM的初始化要稍微復(fù)雜一些,如果第一幀有給定分割掩碼,則使用分割掩碼進(jìn)行初始化, GEM 首先將掩碼圖中的目標(biāo)區(qū)域進(jìn)行沿軸的矩形估計(jì),隨后按照ATOM 中的進(jìn)行初始化。GIM 將分割圖中的目標(biāo)像素作為前景樣本,目標(biāo)周圍 4 倍大小的非目標(biāo)像素作為背景樣本。

但是在大多數(shù)跟蹤數(shù)據(jù)集中并沒有分割的標(biāo)注。因此對于沒有分割標(biāo)注的數(shù)據(jù)集,GIM的初始是使用網(wǎng)絡(luò)預(yù)測的mask進(jìn)行初始化,?即根據(jù)矩形邊界框的內(nèi)容構(gòu)建一個(gè)近似的分割掩碼圖,將矩形框內(nèi)的像素作為前景樣本,矩形框外 4 倍于矩形框大小的周圍區(qū)域作為背景樣本,隨后在 D3S 上進(jìn)行跟蹤迭代,推斷得到一個(gè)近似的分割掩碼圖,D3S 為了速度和簡潔,只進(jìn)行了 1 次迭代。具體方法如下:將搜索區(qū)域的圖片crop出來過主干網(wǎng)絡(luò)的得到特征,作為訓(xùn)練幀和測試幀的特征,第一幀bbox所在位置每個(gè)像素值取1,其他取0作為輸入網(wǎng)絡(luò)的掩模,由第一幀目標(biāo)所在位置得到高斯圖L,這三個(gè)部分輸入網(wǎng)絡(luò)得到預(yù)測的mask,來用作為網(wǎng)絡(luò)的分割標(biāo)注的初始化。在產(chǎn)生分割標(biāo)注的過程中,由于多次迭代并沒有明顯的提升,為了保證效率作者只取了一次迭代。注意,如果初始幀的標(biāo)注是旋轉(zhuǎn)的邊界框時(shí),由于旋轉(zhuǎn)的標(biāo)注要比軸對齊的標(biāo)注更為緊實(shí),因此需要對由旋轉(zhuǎn)標(biāo)注得到輸入網(wǎng)絡(luò)的掩模進(jìn)行膨脹操作,使得這種約束稍微放松一些,然后與經(jīng)過網(wǎng)絡(luò)后得到的mask相乘,得到最終用作初始化的mask。

跟蹤過程與之前的跟蹤器類似,跟蹤幀在上一幀目標(biāo)所在位置裁剪出四倍目標(biāo)大小過網(wǎng)絡(luò),經(jīng)過圖5之后得到預(yù)測的mask,在迭代生成最后框準(zhǔn)的旋轉(zhuǎn)矩形框。

跟蹤階段

當(dāng)?shù)玫叫碌囊粠瑘D像時(shí),根據(jù)上一幀中的目標(biāo)位置,裁剪出 4 倍于目標(biāo)大小的區(qū)域作為新的樣本,隨后將樣本送入 D3S 網(wǎng)絡(luò)中得到分割掩碼圖,通過邊界框轉(zhuǎn)換模塊將掩碼圖轉(zhuǎn)換為所需的矩形框(普通/旋轉(zhuǎn)),將這個(gè)矩形框作為這一幀的跟蹤結(jié)果。GEM 中的 DCF 根據(jù)估計(jì)得到的新目標(biāo)位置通過反向傳播進(jìn)行更新。GIM 不進(jìn)行更新(GIM 負(fù)責(zé)區(qū)分前景背景,GEM 負(fù)責(zé)區(qū)分類似物體,GEM需要更新以保持魯棒性)。

?

邊界框轉(zhuǎn)換

?

D3S 通過輸入第一幀的訓(xùn)練樣本,可以給出后續(xù)幀的目標(biāo)分割概率圖,概率圖不能直接作為跟蹤結(jié)果,需要進(jìn)一步處理為明確的矩形區(qū)域范圍對目標(biāo)的大小位置進(jìn)行標(biāo)記,得到最終的跟蹤結(jié)果。這個(gè)轉(zhuǎn)換過程可以將分割概率圖轉(zhuǎn)換為普通的矩形,也可以轉(zhuǎn)換為旋轉(zhuǎn)矩形,取決于數(shù)據(jù)集的要求。

分割概率圖的概率閾值設(shè)定為 0.5,概率圖上以 0.5 為界分為兩類,得到二類分割掩碼圖,保留掩碼圖中的最大連通域,用最小二乘法擬合為橢圓,其中的橢圓形區(qū)域?yàn)槟繕?biāo)區(qū)域。將橢圓區(qū)域匹配為矩形的方法是通過橢圓的焦點(diǎn)和長短軸實(shí)現(xiàn),如此可以得到對目標(biāo)的旋轉(zhuǎn)矩形匹配。

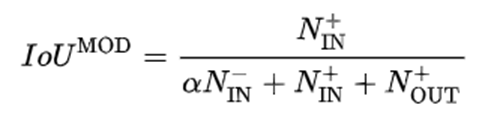

但是在上面的做法中,只考慮到了盡可能讓前景像素進(jìn)入BBox,但沒有考慮邊界框內(nèi)背景像素的數(shù)量。因此作者設(shè)計(jì)了一個(gè)指標(biāo)來迭代生成最好的BBox。

NIN+?NOUT+?分別表示矩形區(qū)域內(nèi)和矩形區(qū)域外的前景像素個(gè)數(shù), ??NIN-?表示矩形區(qū)域內(nèi)的背景像素個(gè)數(shù),alpha起到一定的調(diào)制作用。

整個(gè)邊界框匹配過程極快,平均只需 2ms 時(shí)間。

性能

在VOT的實(shí)驗(yàn)結(jié)果如下:

消融實(shí)驗(yàn)結(jié)果如下:

其中,? ?分別去掉網(wǎng)絡(luò)輸入的三張?zhí)卣鲌D中的一張,結(jié)果表明這三個(gè)輸入都是必要的,尤其?

?分別去掉網(wǎng)絡(luò)輸入的三張?zhí)卣鲌D中的一張,結(jié)果表明這三個(gè)輸入都是必要的,尤其? ?導(dǎo)致的結(jié)果下降,說明前景相似度主要保證了跟蹤器的穩(wěn)健性。

?導(dǎo)致的結(jié)果下降,說明前景相似度主要保證了跟蹤器的穩(wěn)健性。 ?是指GEM沒有使用D3S的輸出坐標(biāo)作為下一幀搜索區(qū)域定位的依據(jù),由此可以看出D3S的輸出坐標(biāo)要比GEM輸出要準(zhǔn)確很多。MA,MM是最后得到旋轉(zhuǎn)邊界框的方法,MA是使用最小外切矩形作為最終輸出,MM是指軸對齊的輸出是按照mask的最大最小坐標(biāo)得到的。可以看到最終得到包圍框時(shí),需要考慮到內(nèi)部包含的負(fù)樣本像素點(diǎn),盡可能減少這些像素對最終結(jié)果的提升是有效的。

?是指GEM沒有使用D3S的輸出坐標(biāo)作為下一幀搜索區(qū)域定位的依據(jù),由此可以看出D3S的輸出坐標(biāo)要比GEM輸出要準(zhǔn)確很多。MA,MM是最后得到旋轉(zhuǎn)邊界框的方法,MA是使用最小外切矩形作為最終輸出,MM是指軸對齊的輸出是按照mask的最大最小坐標(biāo)得到的。可以看到最終得到包圍框時(shí),需要考慮到內(nèi)部包含的負(fù)樣本像素點(diǎn),盡可能減少這些像素對最終結(jié)果的提升是有效的。

end

機(jī)器學(xué)習(xí)算法工程師

? ? ? ? ? ? ? ? ? ? ? ? ? ? 一個(gè)用心的公眾號

進(jìn)群,學(xué)習(xí),得幫助

你的關(guān)注,我們的熱度,

我們一定給你學(xué)習(xí)最大的幫助