實例分割新突破!港科大&快手開源重疊雙層的深度遮擋感知實例分割|CVPR2021

極市導(dǎo)讀

本文通過將圖像中感興趣區(qū)域(RoI)建模為兩個重疊圖層,并提出遮擋感知下的雙圖層實例分割網(wǎng)絡(luò)BCNet,該項工作目前在cvpr21圖像實例分割中獲得github星星數(shù)最多。 >>加入極市CV技術(shù)交流群,走在計算機視覺的最前沿

物體的互相遮擋在日常生活中普遍存在,嚴(yán)重的遮擋易帶來易混淆的遮擋邊界及非連續(xù)自然的物體形狀,從而導(dǎo)致當(dāng)前已有的檢測及分割等的算法性能大幅下降。本文通過將圖像建模為兩個重疊圖層,為網(wǎng)絡(luò)引入物體間的遮擋與被遮擋關(guān)系,從而提出了一個輕量級的能有效處理遮擋的實例分割算法。

論文地址| https://arxiv.org/pdf/2103.12340.pdf

論文代碼|https://github.com/lkeab/BCNet

01 摘要

由于物體的真實輪廓和遮擋邊界之間通常沒有區(qū)別,對高度重疊的對象進(jìn)行分割是非常具有挑戰(zhàn)性的。與之前的自頂向下的實例分割方法不同,本文提出遮擋感知下的雙圖層實例分割網(wǎng)絡(luò)BCNet,將圖像中的感興趣區(qū)域(Region of Interest,RoI)建模為兩個重疊圖層,其中頂部圖層檢測遮擋對象,而底圖層推理被部分遮擋的目標(biāo)物體。雙圖層結(jié)構(gòu)的顯式建模自然地將遮擋和被遮擋物體的邊界解耦,并在Mask預(yù)測的同時考慮遮擋關(guān)系的相互影響。作者在具有不同主干和網(wǎng)絡(luò)層選擇的One-stage和Two-stage目標(biāo)檢測器上驗證了雙層解耦的效果,顯著改善了現(xiàn)有圖像實例分割模型在處理復(fù)雜遮擋物體的表現(xiàn),并在COCO和KINS數(shù)據(jù)集上均取得總體性能的大幅提升。

02 背景

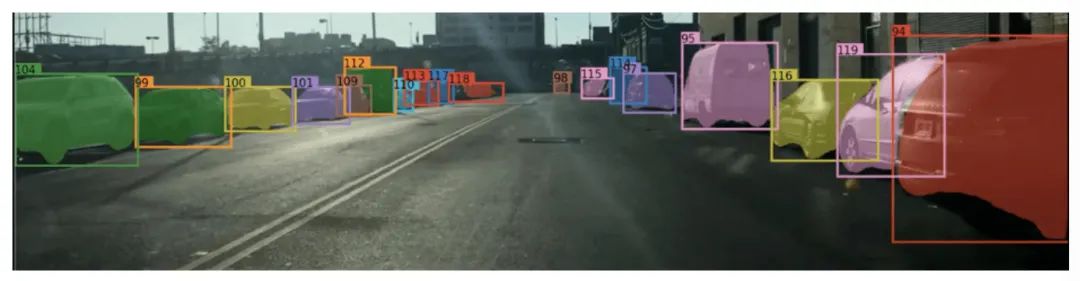

實例分割(Instance Segmentation)是圖像及視頻場景理解的基礎(chǔ)任務(wù),該任務(wù)將物體檢測與語義分割有機結(jié)合,不僅需要預(yù)測出輸入圖像的每一個像素點是否屬于物體,還需將不同的物體所包含的像素點區(qū)分開。目前,實例分割技術(shù)已經(jīng)大規(guī)模地應(yīng)用在短視頻編輯、視頻會議、醫(yī)學(xué)影像、自動駕駛等領(lǐng)域中, 下圖展示了在自動駕駛場景下其對周邊車輛的位置感知:

03 問題

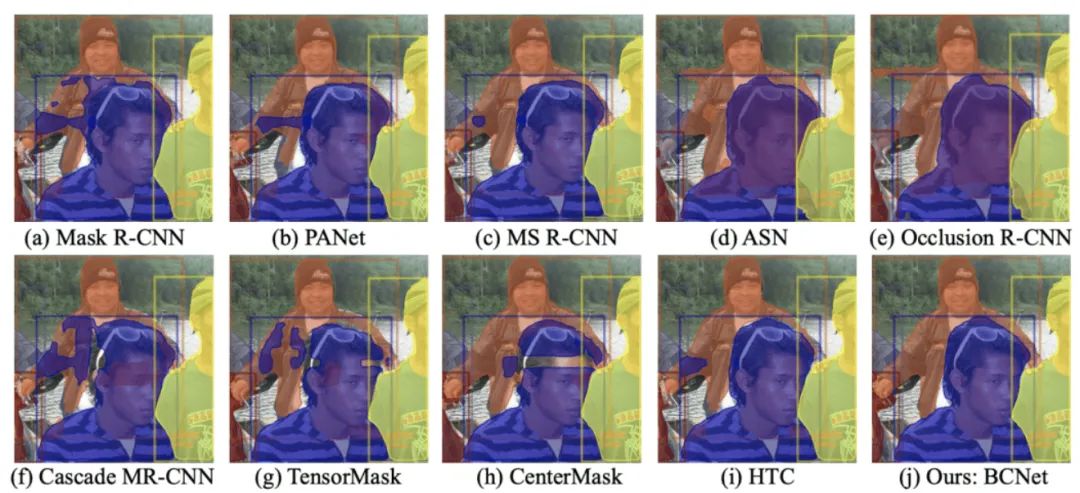

以Mask R-CNN為代表的實例分割方法通常遵循先檢測再分割(Detect-then-segment)的范例,即先獲取感興趣目標(biāo)檢測框,然后對區(qū)域內(nèi)的像素進(jìn)行Mask預(yù)測,在COCO數(shù)據(jù)集取得了領(lǐng)先性能并在工業(yè)界得到廣泛應(yīng)用。我們注意到大多數(shù)后續(xù)改進(jìn)算法如PANet、HTC、BlendMask、CenterMask等均著重于設(shè)計更好的網(wǎng)絡(luò)骨干(Backbone)、高低層特征的融合機制或級聯(lián)結(jié)構(gòu)(Cascade Structure),而忽視了掩膜預(yù)測分支(Mask Regression Head)的作用。同時,如圖1所示的重疊人群,大面積的實例分割錯誤都是由于同一感興趣區(qū)域(RoI)中包含的重疊物體混淆了不同物體的真實輪廓,特別是當(dāng)遮擋和被遮擋目標(biāo)都屬于相同類別或紋理顏色相似。

圖1 高度遮擋下的實例分割結(jié)果對比

04 成果

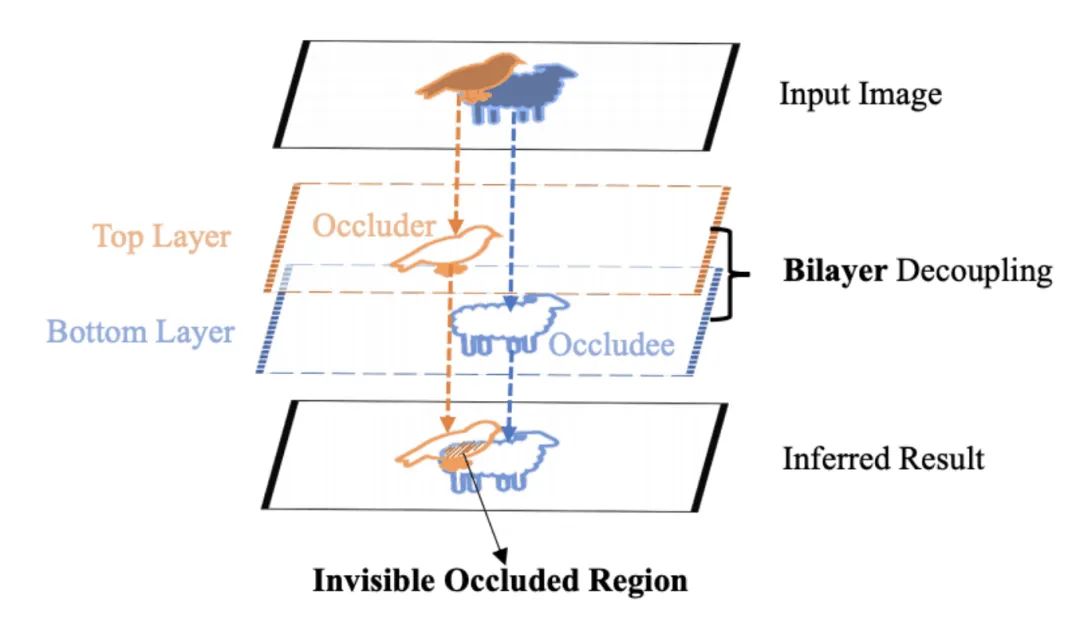

近日,香港科技大學(xué)聯(lián)合快手對圖像實例分割當(dāng)下性能瓶頸進(jìn)行了深入剖析,該研究通過將圖像中感興趣區(qū)域(RoI)建模為兩個重疊圖層(如圖2示),并提出遮擋感知下的雙圖層實例分割網(wǎng)絡(luò)BCNet,頂層GCN層檢測遮擋對象,底層GCN層推理被部分遮擋的目標(biāo)物體,通過顯式建模自然地將遮擋和被遮擋物體的邊界解耦,并在mask預(yù)測的同時考慮遮擋關(guān)系的相互影響,顯著改善了現(xiàn)有實例分割模型在處理復(fù)雜遮擋物體時的表現(xiàn),在COCO和KINS數(shù)據(jù)集上均取得領(lǐng)先性能。

圖2 遮擋物和被遮擋物的雙圖層分解示意簡圖

圖2 遮擋物和被遮擋物的雙圖層分解示意簡圖05 意義

物體互相遮擋在日常生活中普遍存在,嚴(yán)重的遮擋會帶來易混淆的遮擋邊界及非連續(xù)自然的物體形狀,從而導(dǎo)致當(dāng)前已有的檢測及分割等的算法的性能大幅下降。該研究系統(tǒng)提出了一個輕量級且能有效處理遮擋的實例分割算法,在工業(yè)界也具有極大意義。隨著短視頻作為主要信息傳播媒介不斷滲透進(jìn)日常生活,在實際的物體分割應(yīng)用場景中,分割的準(zhǔn)確性直接影響著用戶的使用體驗和產(chǎn)品觀感。因此,如何將實例分割技術(shù)應(yīng)用在復(fù)雜的日常應(yīng)用場景并保持高精度,此項研究給出了一個合理、有效的解決方案。

BCNet的結(jié)構(gòu)框架

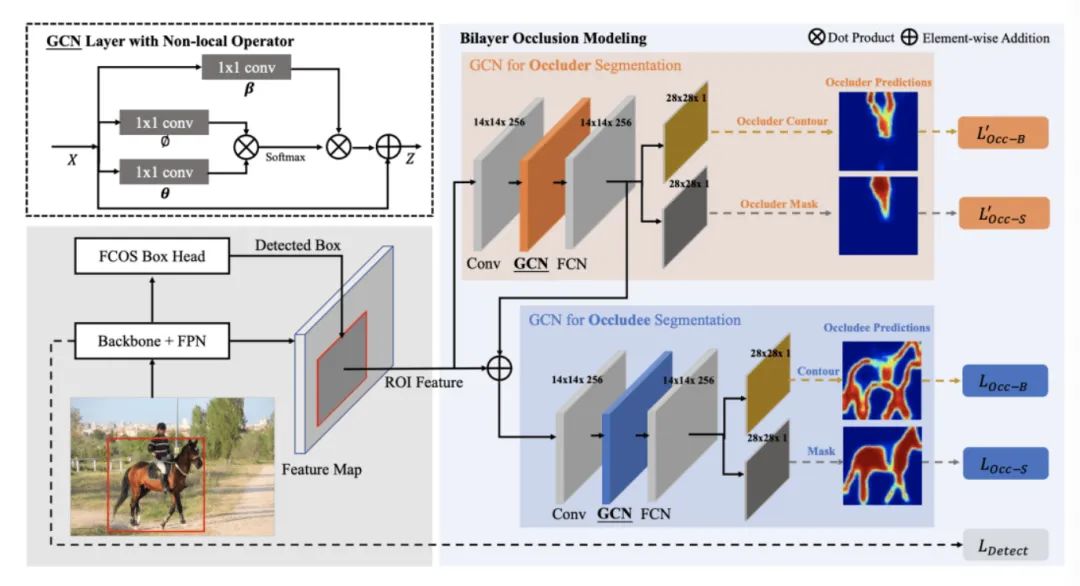

整個分割系統(tǒng)分為兩個部分,物體檢測部分和物體分割部分,算法流程如下圖:

圖3 BCNet的網(wǎng)絡(luò)結(jié)構(gòu)

輸入單張圖像,使用基于Faster R-CNN或者FCOS的物體檢測算法預(yù)測感興趣目標(biāo)區(qū)域(RoI)候選框坐標(biāo)(x,y,w,h),采用Resnet-50/101及特征金字塔作為基礎(chǔ)網(wǎng)絡(luò)(backbone)獲取整張輸入圖片的特征。

使用RoI Align算法根據(jù)物體檢測框位置,在整張圖片特征圖內(nèi)準(zhǔn)確摳取感興趣目標(biāo)區(qū)域的特征子圖,并將其作為雙圖卷積神經(jīng)網(wǎng)絡(luò)的輸入用于最終的物體分割。

實例分割網(wǎng)絡(luò)BCNet由級聯(lián)狀的雙圖層神經(jīng)網(wǎng)絡(luò)組成:

a.第一個圖層對感興趣目標(biāo)區(qū)域內(nèi)遮擋物體(Occluder)的形狀和外觀進(jìn)行顯式建模,該層圖卷積網(wǎng)絡(luò)包含四層,即卷積層(卷積核大小3x3)、圖卷積層(Non-local Layer)以及末尾的兩個卷積(卷積核大小3x3)。第一個圖卷積網(wǎng)絡(luò)輸入感興趣目標(biāo)區(qū)域特征,輸出感興趣目標(biāo)框中遮擋物體的邊界和掩膜。

b.第二個圖層結(jié)合第一個圖卷積網(wǎng)絡(luò)(用于對遮擋物體建模)已經(jīng)提取的遮擋物體信息(包括遮擋物的Boundary和Mask),具體做法是將步驟2中得到的感興趣目標(biāo)區(qū)域特征與經(jīng)過第一個圖卷積網(wǎng)絡(luò)中最后一層卷積后的特征3a相加,得到新的特征,并將其作為第二個圖卷積網(wǎng)絡(luò)(用于被遮擋物分割)的輸入。第二個圖卷積網(wǎng)絡(luò)與第一個圖卷積網(wǎng)絡(luò)結(jié)構(gòu)相同,構(gòu)成級聯(lián)網(wǎng)絡(luò)關(guān)系。該操作將遮擋與被遮擋關(guān)系同時考慮進(jìn)來,能有效地區(qū)分遮擋物與被遮擋物的相鄰物體邊界,最終輸出目標(biāo)區(qū)域被遮擋目標(biāo)物體(Occludee)的分割結(jié)果。

c.為了減少模型的參數(shù)量,我們使用非局部算子(Non-local Operator)操作進(jìn)行圖卷積層的實現(xiàn),具體實現(xiàn)位于結(jié)構(gòu)圖左上位置,包含三個卷積核大小為1x1的卷積層以及Softmax算子,其將圖像空間中像素點根據(jù)對應(yīng)特征向量的相似度有效關(guān)聯(lián)起來,實現(xiàn)輸入目標(biāo)區(qū)域特征的重新聚合,能較好解決同一個物體的像素點在空間上被遮擋截斷導(dǎo)致不連續(xù)的問題。

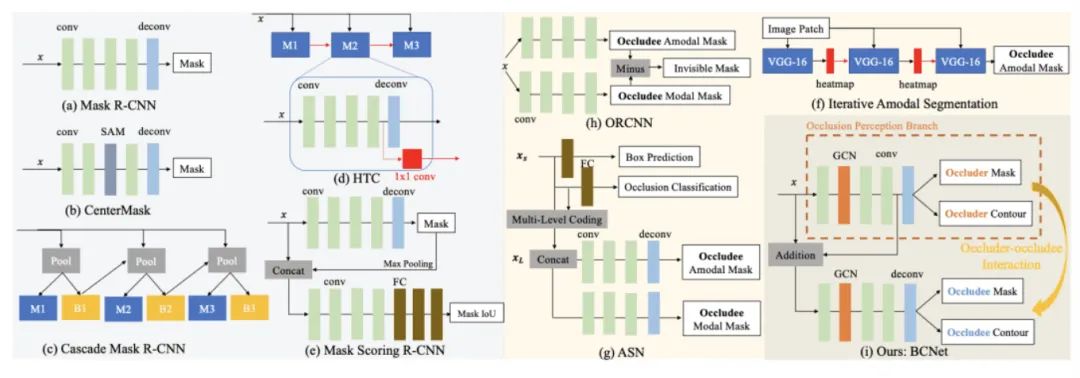

BCNet與其他經(jīng)典網(wǎng)絡(luò)結(jié)構(gòu)對比

我們的提出的復(fù)雜遮擋下的圖像分割算法,基于已有的雙階段分割模型,將傳統(tǒng)的單個的全卷積(Fully Convolution)掩膜預(yù)測分支網(wǎng)絡(luò)替換成由雙圖層級聯(lián)構(gòu)成的圖神經(jīng)網(wǎng)絡(luò)(Graph Convolutional Network)模型,在感興趣目標(biāo)區(qū)域(RoI)中,前圖層建模輸出遮擋物體(Occluder)的位置和形狀,后圖層在前圖層基礎(chǔ)上最終輸出相應(yīng)的被遮擋物體(Occludee)的Mask,從而讓實例分割算法在遮擋情況下仍然能夠保持高運行速度和服務(wù)器端的高速度。如下是BCNet與其它經(jīng)典網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計對比圖:

圖4 分割網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計對比

實驗和對比

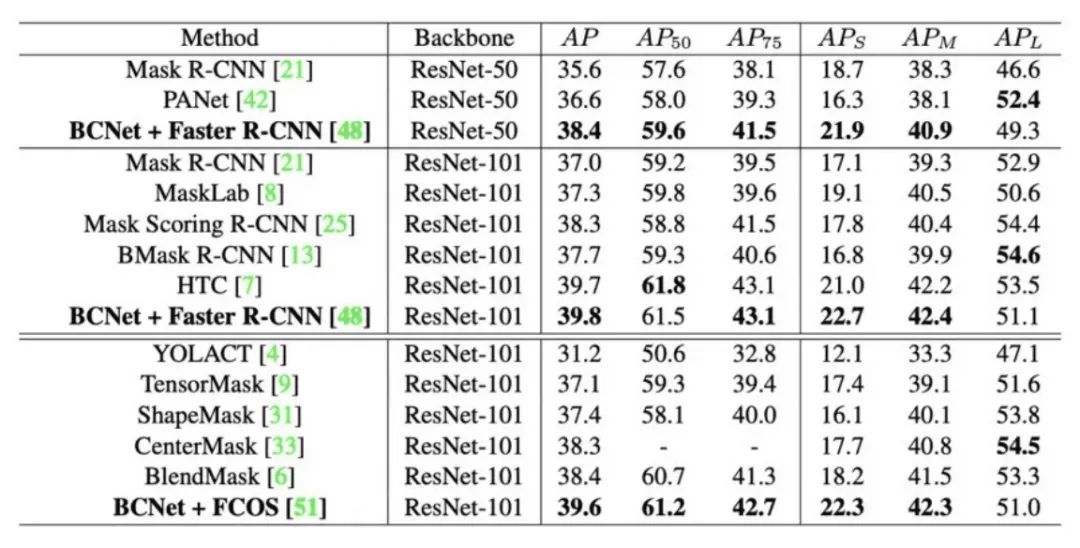

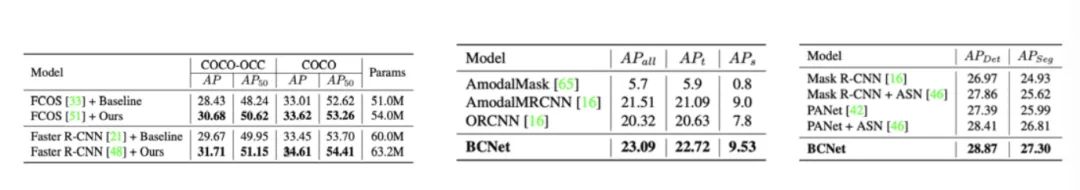

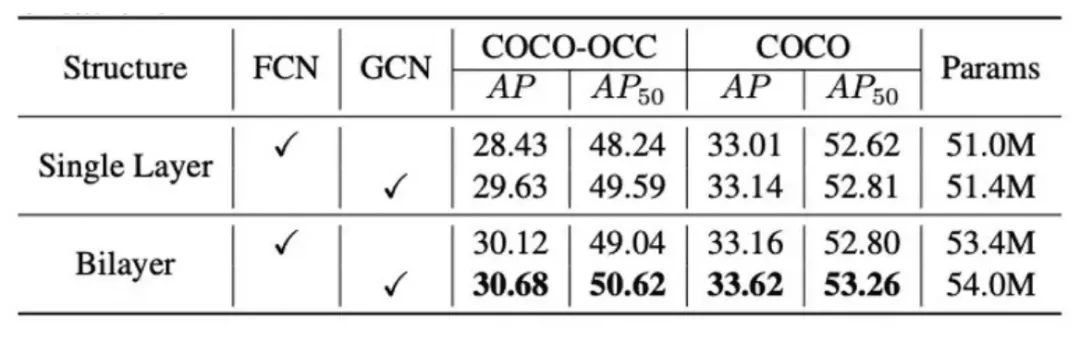

作者在三個數(shù)據(jù)集包括COCO、COCOA以及KINS上對算法進(jìn)行了驗證,大量的定量實驗結(jié)果(表1和表2,包含Modal Segmentation和Amodal Segmentation)表明BCNet在不過度增加網(wǎng)絡(luò)參數(shù)和預(yù)測耗時的基礎(chǔ)上,結(jié)合現(xiàn)有的One-stage和Two-stage物體檢測器上均能取得較大的性能提升,優(yōu)于CenterMask、BlendMask以及多階段Cascade的HTC等現(xiàn)有算法,尤其是對于存在遮擋的物體。同時,表3證明雙圖層結(jié)構(gòu)在兩個完全的全卷積網(wǎng)絡(luò)(pure FCN)圖層中依然有效。

表1 在COCO-test-dev上的對比結(jié)果,BCNet性能大幅優(yōu)于BlendMask、CenterMask等網(wǎng)絡(luò)

表2 在COCO-Val、COCOA和KINS數(shù)據(jù)集上的對比結(jié)果

表3 對雙圖層結(jié)構(gòu)(bilayer structure)的有效性驗證

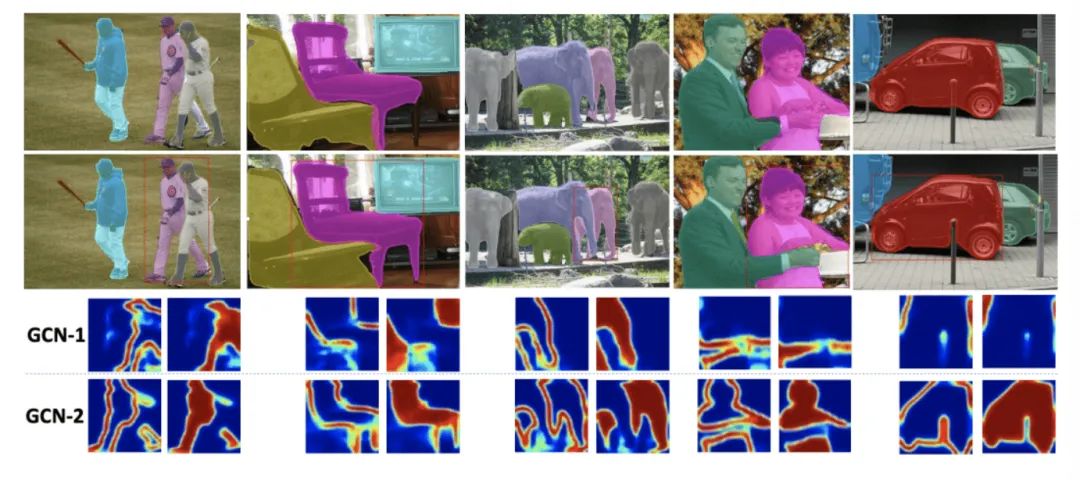

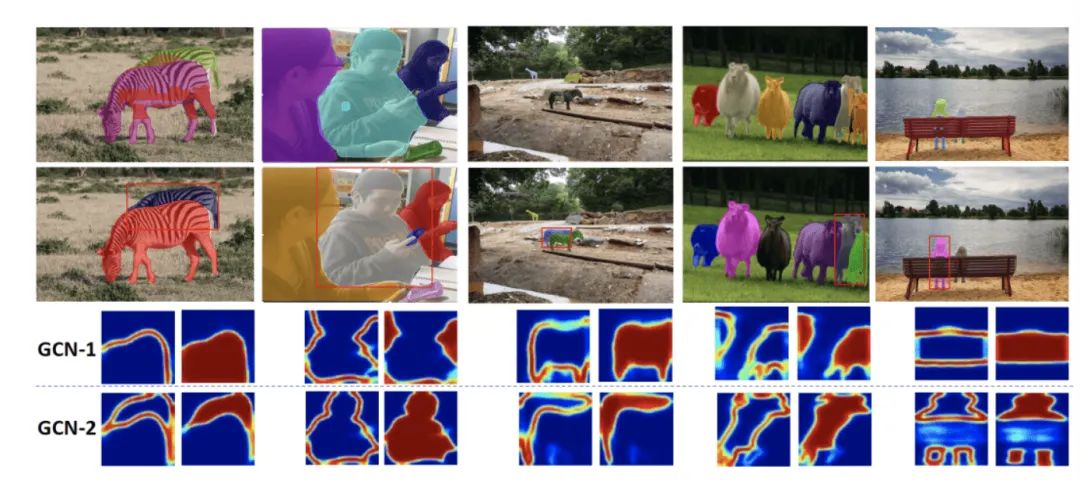

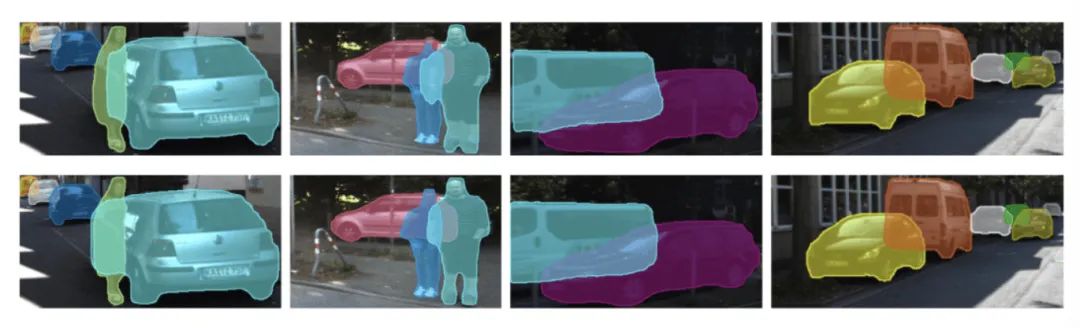

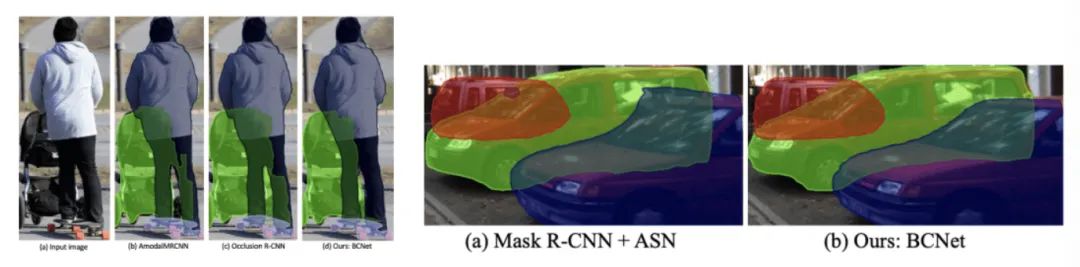

另外,作者也提供了不同數(shù)據(jù)集下的可視化對比結(jié)果。對于COCO數(shù)據(jù)集,在圖5和圖6中可以看到即使在復(fù)雜的遮擋情況下,BCNet也能給出較為魯棒的預(yù)測結(jié)果,而且通過分別可視化前圖層和后圖層對遮擋物和被遮擋物的Boundary和Mask的建模結(jié)果,使得BCNet的預(yù)測較以往算法具有更強的可解釋性。圖7和圖8提供了對于Amodal Segmentation下的KINS和COCOA數(shù)據(jù)集的實例分割效果對比。

圖5 基于FCOS檢測器,COCO上CenterMask(第一行)和BCNet(第二行)的可視化結(jié)果對比。最下面一行顯示了由兩個GCN圖層分別預(yù)測的遮擋物和被遮擋物的輪廓以及掩膜,從而使得BCNet的最終分割結(jié)果比以前的方法更具可解釋性。

圖6基于Faster R-CNN檢測器,COCO上Mask Scoring R-CNN(第一行)和BCNet(第二行)的可視化結(jié)果對比

圖7 KINS數(shù)據(jù)集上,ASN(第一行)和BCNet(第二行)的可視化結(jié)果(amodal)對比

圖8 COCOA(左)及KINS(右)上的更多結(jié)果(amodal)對比

更多BCNet的實現(xiàn)和實驗細(xì)節(jié)可參考論文和開源代碼,圖5到圖8可視化部分基于的對比算法來源如下:

[1] Lee, Youngwan, and Jongyoul Park. "Centermask: Real-time anchor-free instance segmentation." In CVPR, 2020.

[2] Huang Z, Huang L, Gong Y, et al. Mask scoring r-cnn. In CVPR, 2019.

[3] Qi L, Jiang L, Liu S, et al. Amodal instance segmentation with kins dataset. In CVPR, 2019.

[4] Follmann, Patrick, et al. "Learning to see the invisible: End-to-end trainable amodal instance segmentation." In WACV, 2019.

如果覺得有用,就請分享到朋友圈吧!

公眾號后臺回復(fù)“CNN綜述”獲取67頁綜述深度卷積神經(jīng)網(wǎng)絡(luò)架構(gòu)~

# CV技術(shù)社群邀請函 #

備注:姓名-學(xué)校/公司-研究方向-城市(如:小極-北大-目標(biāo)檢測-深圳)

即可申請加入極市目標(biāo)檢測/圖像分割/工業(yè)檢測/人臉/醫(yī)學(xué)影像/3D/SLAM/自動駕駛/超分辨率/姿態(tài)估計/ReID/GAN/圖像增強/OCR/視頻理解等技術(shù)交流群

每月大咖直播分享、真實項目需求對接、求職內(nèi)推、算法競賽、干貨資訊匯總、與 10000+來自港科大、北大、清華、中科院、CMU、騰訊、百度等名校名企視覺開發(fā)者互動交流~