關(guān)于Transformer中常遇到的問(wèn)題解答

來(lái)源:知乎

作者:紅豆君??中國(guó)科學(xué)院大學(xué)?計(jì)算機(jī)碩士

文章經(jīng)過(guò)作者同意轉(zhuǎn)載

1. Transformer如何解決梯度消失問(wèn)題的?

殘差

? ?2. 為何Transformer中使用LN而不用BN?

BatchNorm是對(duì)一個(gè)batch-size樣本內(nèi)的每個(gè)特征做歸一化,LayerNorm是對(duì)每個(gè)樣本的所有特征做歸一化。

形象點(diǎn)來(lái)說(shuō),假設(shè)有一個(gè)二維矩陣。行為batch-size,列為樣本特征。那么BN就是豎著歸一化,LN就是橫著歸一化。

它們的出發(fā)點(diǎn)都是讓該層參數(shù)穩(wěn)定下來(lái),避免梯度消失或者梯度爆炸,方便后續(xù)的學(xué)習(xí)。但是也有側(cè)重點(diǎn)。

一般來(lái)說(shuō),如果你的特征依賴于不同樣本間的統(tǒng)計(jì)參數(shù),那BN更有效。因?yàn)樗⒘瞬煌卣髦g的大小關(guān)系,但是保留了不同樣本間的大小關(guān)系。(CV領(lǐng)域)

而在NLP領(lǐng)域,LN就更加合適。因?yàn)樗⒘瞬煌瑯颖鹃g的大小關(guān)系,但是保留了一個(gè)樣本內(nèi)不同特征之間的大小關(guān)系。對(duì)于NLP或者序列任務(wù)來(lái)說(shuō),一條樣本的不同特征,其實(shí)就是時(shí)序上字符取值的變化,樣本內(nèi)的特征關(guān)系是非常緊密的。

3. LN的作用是什么?

允許使用更大的學(xué)習(xí)率,加速訓(xùn)練。有一定的抗過(guò)擬合作用,使訓(xùn)練過(guò)程更加平穩(wěn)

4. 多頭自注意力層中的“多頭”如何理解,有什么作用?

有點(diǎn)類似于CNN的多個(gè)卷積核。通過(guò)三個(gè)線性層的映射,不同頭中的Q、K、V是不一樣的,而這三個(gè)線性層的權(quán)重是先初始化后續(xù)通過(guò)學(xué)習(xí)得到的。不同的權(quán)重可以捕捉到序列中不同的相關(guān)性。

5. Transformer是自回歸模型還是自編碼模型?

自回歸模型。

所謂自回歸,即使用當(dāng)前自己預(yù)測(cè)的字符再去預(yù)測(cè)接下來(lái)的信息。Transformer在預(yù)測(cè)階段(機(jī)器翻譯任務(wù))會(huì)先預(yù)測(cè)第一個(gè)字,然后在第一個(gè)預(yù)測(cè)的字的基礎(chǔ)上接下來(lái)再去預(yù)測(cè)后面的字,是典型的自回歸模型。Bert中的Mask任務(wù)是典型的自編碼模型,即根據(jù)上下文字符來(lái)預(yù)測(cè)當(dāng)前信息。

6. 原論文中Q、K矩陣相乘為什么最后要除以√dk?

當(dāng)?√dk?特別小的時(shí)候,其實(shí)除不除無(wú)所謂。無(wú)論編碼器還是解碼器Q、K矩陣其實(shí)本質(zhì)是一個(gè)相同的矩陣。Q、K相乘其實(shí)相等于Q乘以Q的轉(zhuǎn)置,這樣造成結(jié)果會(huì)很大或者很小。小了還好說(shuō),大的話會(huì)使得后續(xù)做softmax繼續(xù)被放大造成梯度消失,不利于梯度反向傳播。

7. 原論中編碼器與解碼器的Embedding層的權(quán)重為什么要乘以√dmodel??

為了讓embedding層的權(quán)重值不至于過(guò)小,乘以?√dmodel??后與位置編碼的值差不多,可以保護(hù)原有向量空間不被破壞。

8. Transformer在訓(xùn)練與驗(yàn)證的時(shí)候有什么不同

Transformer在訓(xùn)練的時(shí)候是并行的,在驗(yàn)證的時(shí)候是串行的。這個(gè)問(wèn)題與Transformer是否是自回歸模型考察的是同一個(gè)知識(shí)點(diǎn)。

9. Transformer模型的計(jì)算復(fù)雜度是多少?

n2d

n是序列長(zhǎng)度,d是embedding的長(zhǎng)度。Transformer中最大的計(jì)算量就是多頭自注意力層,這里的計(jì)算量主要就是QK相乘再乘上V,即兩次矩陣相乘。

QK相乘是矩陣【n d】乘以【d n】,這個(gè)復(fù)雜度就是n2d。

10. Transformer中三個(gè)多頭自注意力層分別有什么意義與作用?

Transformer中有三個(gè)多頭自注意力層,編碼器中有一個(gè),解碼器中有兩個(gè)。

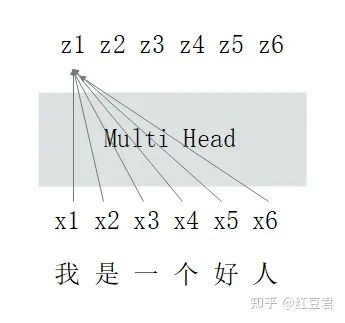

編碼器中的多頭自注意力層的作用是將原始文本序列信息做整合,轉(zhuǎn)換后的文本序列中每個(gè)字符都與整個(gè)文本序列的信息相關(guān)(這也是Transformer中最創(chuàng)新的思想,盡管根據(jù)最新的綜述研究表明,Transformer的效果非常好其實(shí)多頭自注意力層并不占據(jù)絕大貢獻(xiàn))。示意圖如下:

解碼器的第一個(gè)多頭自注意力層比較特殊,原論文給其起名叫Masked Multi-Head-Attention。其一方面也有上圖介紹的作用,即對(duì)輸入文本做整合(對(duì)與翻譯任務(wù)來(lái)說(shuō),編碼器的輸入是翻譯前的文本,解碼器的輸入是翻譯后的文本)。另一個(gè)任務(wù)是做掩碼,防止信息泄露。拓展解釋一下就是在做信息整合的時(shí)候,第一個(gè)字符其實(shí)不應(yīng)該看到后面的字符,第二個(gè)字符也只能看到第一個(gè)、第二個(gè)字符的信息,以此類推。

解碼器的第二個(gè)多頭自注意力層與編碼器的第一個(gè)多頭自注意力層功能是完全一樣的。不過(guò)輸入需要額外強(qiáng)調(diào)下,我們都知道多頭自注意力層是通過(guò)計(jì)算QKV三個(gè)矩陣最后完成信息整合的。在這里,Q是解碼器整合后的信息,KV兩個(gè)矩陣是編碼器整合后的信息,是兩個(gè)完全相同的矩陣。QKV矩陣相乘后,翻譯前與翻譯后的文本也做了充分的交互整合。至此最終得到的向量矩陣用來(lái)做后續(xù)下游工作。

11. Transformer中的mask機(jī)制有什么作用

有兩個(gè)作用。

對(duì)不等長(zhǎng)的序列做padding補(bǔ)齊

掩碼防止信息泄露

12. mask機(jī)制分別用在了哪里?

結(jié)合第十一問(wèn)。

mask機(jī)制的作用1在三個(gè)多頭自注意力層中都用了,作用2只用在了解碼器的第一個(gè)多頭自注意力層。

to be contiune

看大家點(diǎn)贊量啦!

推薦閱讀

為何Transformer在計(jì)算機(jī)視覺中如此受歡迎?

如何看待swin transformer成為ICCV2021的 best paper?

熬了一晚上,我從零實(shí)現(xiàn)了Transformer模型,把代碼講給你聽