【論文解讀】IPM2020 | 長(zhǎng)短期興趣建模的圖神經(jīng)網(wǎng)絡(luò)新聞推薦系統(tǒng)

論文解讀者:北郵 GAMMA Lab 碩士生 李晨

題目: Graph Neural News Recommendation with Long-term and Short-term Interest Modeling

期刊: Information Processing & Management (Volume 57, Issue 2)

論文鏈接:

https://arxiv.org/pdf/1910.14025.pdf

1 引言

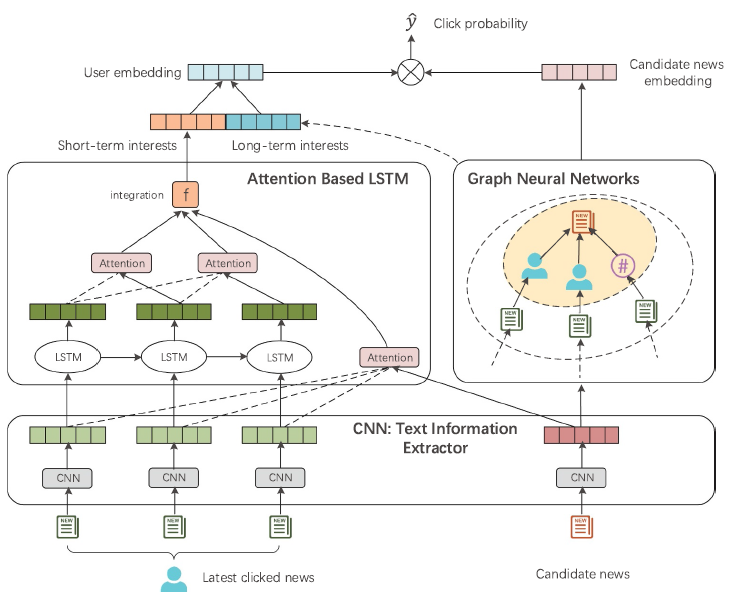

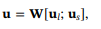

2 模型介紹

2.1 文本信息提取器

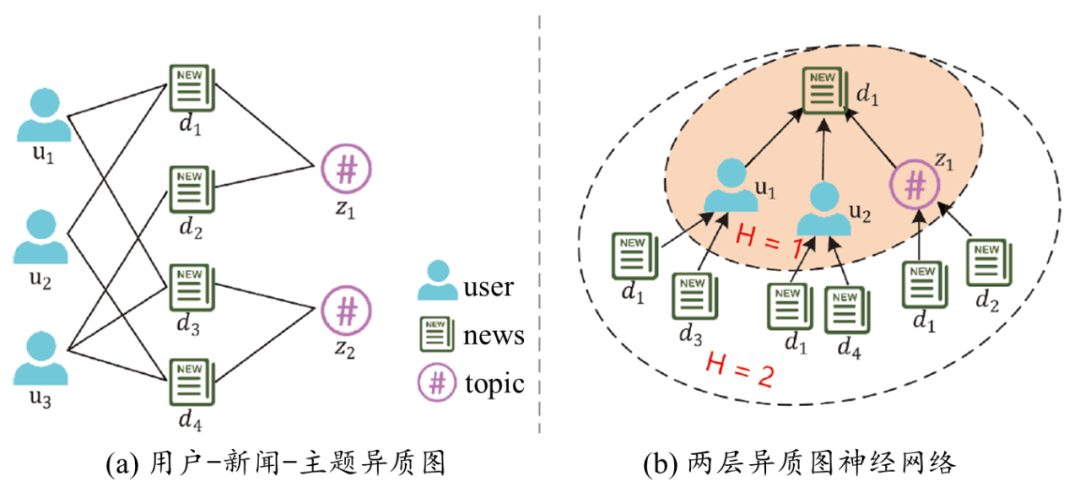

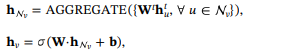

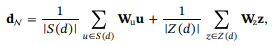

2.2 用戶長(zhǎng)期興趣建模與新聞建模

2.3 用戶短期興趣建模

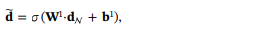

(1)內(nèi)容上的注意力機(jī)制

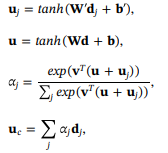

(2)時(shí)序上的注意力機(jī)制

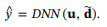

2.4 預(yù)測(cè)與模型優(yōu)化

3 實(shí)驗(yàn)

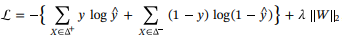

3.1 性能實(shí)驗(yàn)

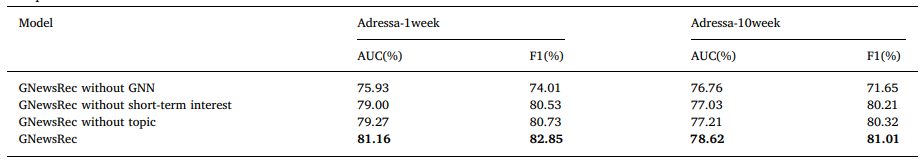

3.2 消融實(shí)驗(yàn)

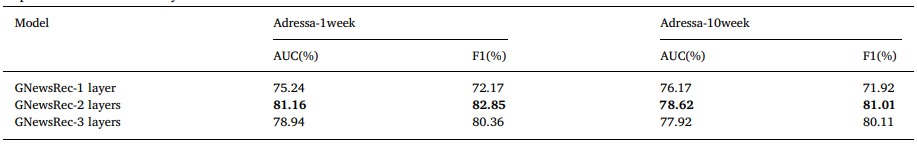

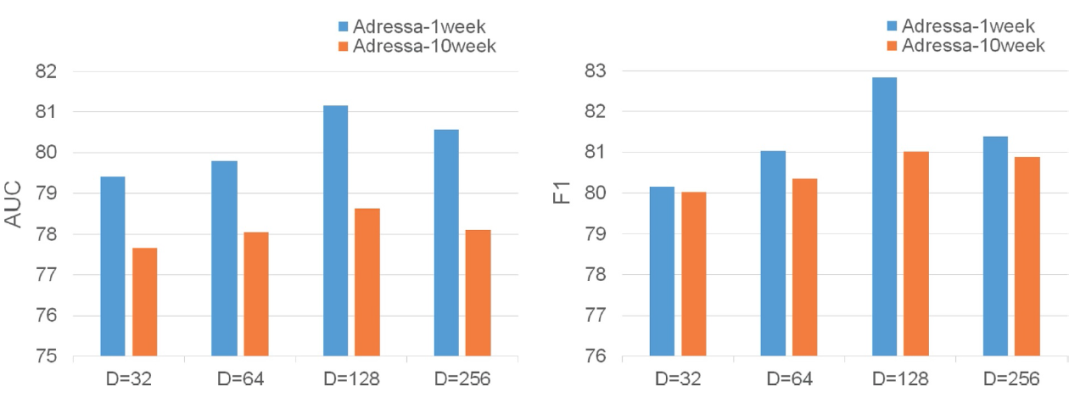

3.3 參數(shù)實(shí)驗(yàn)

4 總結(jié)

往期精彩回顧

本站qq群851320808,加入微信群請(qǐng)掃碼:

評(píng)論

圖片

表情