深度學(xué)習(xí)中的噪聲數(shù)據(jù)

點(diǎn)擊上方“AI算法與圖像處理”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

作者:蔣路

來(lái)源:https://www.zhihu.com/people/roadjiang/posts

孔子云:“性能不夠,數(shù)據(jù)來(lái)湊”。可是如果數(shù)據(jù)中有噪聲標(biāo)簽(Noisy Labels)怎么辦?本文借鑒Google AI的最新工作[1]來(lái)回答這個(gè)問(wèn)題。

以下我們盡量避免使用專業(yè)術(shù)語(yǔ),希望對(duì)非專業(yè)的讀者也會(huì)有所幫助。

深度神經(jīng)網(wǎng)絡(luò)的成功依賴于高質(zhì)量標(biāo)記的訓(xùn)練數(shù)據(jù)。訓(xùn)練數(shù)據(jù)中存在標(biāo)記錯(cuò)誤(標(biāo)記噪聲,即Noisy Labels)會(huì)大大降低[2]模型在干凈測(cè)試數(shù)據(jù)上的準(zhǔn)確性[3]。不幸的是,大型數(shù)據(jù)集幾乎總是包含帶有不正確或不準(zhǔn)確的標(biāo)簽。這導(dǎo)致了一個(gè)悖論:一方面,大型數(shù)據(jù)集對(duì)于深度網(wǎng)絡(luò)的訓(xùn)練是非常必要的,而另一方面,深度網(wǎng)絡(luò)往往會(huì)記住訓(xùn)練標(biāo)簽噪聲,從而在實(shí)踐中導(dǎo)致較差的模型性能。

學(xué)界已經(jīng)意識(shí)到這個(gè)問(wèn)題的重要性,一直在試圖理解理解標(biāo)簽噪聲,和發(fā)明新的魯棒學(xué)習(xí)方法來(lái)克服它們。在這個(gè)過(guò)程中,受控實(shí)驗(yàn)[4]扮演著至關(guān)重要的角色。好比研發(fā)一種新的藥物,我們需要受控實(shí)驗(yàn)來(lái)對(duì)影響實(shí)驗(yàn)結(jié)果的無(wú)關(guān)因素加以控制。在本問(wèn)題里,最重要的是研究不同的噪聲水平(即數(shù)據(jù)集中帶有錯(cuò)誤標(biāo)簽的樣本的百分比)對(duì)模型性能的影響。但是,當(dāng)前的受控實(shí)驗(yàn)僅局限在人工合成噪聲,而不是真實(shí)的噪聲。與實(shí)際經(jīng)驗(yàn)相比,人工合成噪音會(huì)導(dǎo)致研究結(jié)果大相徑庭。來(lái)看一個(gè)例子:“神經(jīng)網(wǎng)絡(luò)是否對(duì)于人工噪音數(shù)據(jù)敏感?”,前人給出了截然相反的答案:

”Deep neural networks easily fit random labels” (Zhang et al. 2017)

VS[1]

“Deep learning is robust to massive label noise” (Rolnick et al. 2017)

更重要的是,我們發(fā)現(xiàn):在人工噪聲上表現(xiàn)良好的方法,在現(xiàn)實(shí)世界的噪聲數(shù)據(jù)集上效果可能并不理想。

在ICML 2020上發(fā)布的“Beyond Synthetic Noise: Deep Learning on Controlled Noisy Labels”中,我們做出了三點(diǎn)貢獻(xiàn)。首先,我們建立了第一個(gè)受控的噪聲數(shù)據(jù)集,一個(gè)來(lái)自真實(shí)世界的標(biāo)簽噪聲(即Web標(biāo)簽噪聲)[2]。其次,我們提出了一種簡(jiǎn)單而有效的方法來(lái)克服真實(shí)和人工行合成的噪聲標(biāo)簽。最后,我們進(jìn)行了迄今為止最大的實(shí)驗(yàn),比較了人工和真實(shí)噪聲在各種訓(xùn)練環(huán)境下的區(qū)別。

人工合成標(biāo)簽噪聲與真實(shí)標(biāo)簽噪聲的區(qū)別:

人工噪聲與真實(shí)標(biāo)簽噪聲的分布之間存在許多差異,以圖像舉例:

首先,帶有真實(shí)標(biāo)簽噪聲的圖像在視覺(jué)或語(yǔ)義上與干凈的正樣本更加一致。

其次,人工標(biāo)簽噪聲處于類級(jí)別(即同一類中的所有樣本均同樣嘈雜),而現(xiàn)實(shí)世界中的標(biāo)簽噪聲處于實(shí)例級(jí)(與相關(guān)類無(wú)關(guān),某些圖片會(huì)比其他圖片更有可能被錯(cuò)誤標(biāo)注)。例如,“本田思域”和“本田雅閣”的側(cè)面圖片會(huì)比正面拍攝的圖片更容易混淆。

第三,帶有真實(shí)標(biāo)簽噪聲的圖像來(lái)自開(kāi)放的詞匯,這些詞匯可能不會(huì)與特定數(shù)據(jù)集的類詞匯重疊。例如,“ ladybug”的噪聲圖像包括諸如“ fly”之類的圖片,然而”fly"很可能是一個(gè)background class,也就是并不是我們訓(xùn)練集合定義的class的一部分。

基于以上原因,一個(gè)受控標(biāo)簽噪聲的數(shù)據(jù)集將有助于更好地定量研究人工合成和實(shí)際標(biāo)簽噪聲之間的差異。

人工合成標(biāo)簽噪音和Web標(biāo)簽噪音的比較。從左到右的列是Mini-ImageNet或Stanford Cars數(shù)據(jù)集中的真實(shí)睜眼本,帶有人工合噪聲的圖像,以及帶有錯(cuò)誤Web標(biāo)簽的圖像(在本文中收集)。

為了區(qū)分,我們用紅色噪聲來(lái)指代Web標(biāo)簽噪聲,而用藍(lán)色噪聲來(lái)指代人工合成標(biāo)簽噪聲 (見(jiàn)黑客帝國(guó)中的紅色和藍(lán)色藥丸)

Web上受控標(biāo)簽噪聲

“如果選擇藍(lán)色藥丸– 故事就此結(jié)束,你在自己床上醒來(lái),繼續(xù)相信你愿意相信的一切。如果你吃下紅色藥丸– 你將留在奇境,我會(huì)讓你看看兔子洞究竟有多深。” (黑客帝國(guó) 1999)

我們提出的Web噪聲數(shù)據(jù)集合建立在兩個(gè)公共數(shù)據(jù)集上:Mini-ImageNet(用于粗粒度圖像分類)和Stanford Cars(用于細(xì)粒度圖像分類)。遵循人工合成數(shù)據(jù)集的構(gòu)建方法,我們逐漸將這些數(shù)據(jù)集中的干凈圖像替換為從網(wǎng)絡(luò)上收集的標(biāo)簽錯(cuò)誤的圖像。

為此,我們使用類名(例如“ ladybug”)作為關(guān)鍵字從網(wǎng)絡(luò)上收集圖像,這是一種自動(dòng)方法來(lái)收集Web上帶有噪聲標(biāo)簽的圖像,完全無(wú)需人工注釋。然后,我們使用Google Cloud Labeling Service的標(biāo)注人員檢查每個(gè)檢索到的圖像,這些標(biāo)注人員將識(shí)別給定的Web標(biāo)簽是否正確。我們使用帶有錯(cuò)誤標(biāo)簽的Web圖像來(lái)替換原始Mini-ImageNet和Stanford Cars數(shù)據(jù)集中的一定比例的干凈訓(xùn)練圖像。我們創(chuàng)建了10個(gè)不同的數(shù)據(jù)集,它們的標(biāo)簽噪聲逐漸升高(從0%的完全干凈數(shù)據(jù),到80%的帶有錯(cuò)誤標(biāo)簽的數(shù)據(jù))。數(shù)據(jù)集已在我們的“ 受控噪聲網(wǎng)絡(luò)標(biāo)簽”網(wǎng)站上開(kāi)源。

MentorMix:一種簡(jiǎn)單的魯棒學(xué)習(xí)方法

給定一個(gè)含有未知噪聲的數(shù)據(jù)集,我們的目標(biāo)是訓(xùn)練一個(gè)魯棒的模型,該模型可以很好地推廣到干凈的測(cè)試數(shù)據(jù)上。我們介紹了一種簡(jiǎn)單有效的方法來(lái)處理噪聲標(biāo)簽,稱為MentorMix,該方法是在本文提出的數(shù)據(jù)集上開(kāi)發(fā)得到的。

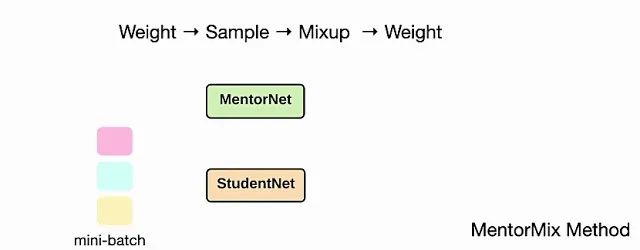

MentorMix是一種基于MentorNet和Mixup兩種現(xiàn)有技術(shù)的迭代方法,包括四個(gè)步驟:加權(quán),抽樣,混合和再加權(quán)。第一步,通過(guò)MentorNet網(wǎng)絡(luò)在mini-batch中為每個(gè)樣本計(jì)算權(quán)重,并將權(quán)重normalize為分布。在此處的示例中,MentorNet使用StudentNet訓(xùn)練loss來(lái)確定分布中的權(quán)重。

MentorMix方法的四個(gè)步驟的圖示:加權(quán),采樣,混合和再加權(quán)。

接下來(lái),對(duì)于每個(gè)樣本,我們使用重要性采樣根據(jù)分布在同一個(gè)mini-batch中選擇另一個(gè)樣本。由于權(quán)重較高的樣本往往帶有正確的標(biāo)簽,因此在采樣過(guò)程中會(huì)受到青睞。然后,我們使用Mixup混合原始樣本和采樣得到的樣本,以便模型在兩者之間進(jìn)行插值,并避免過(guò)度擬合噪聲。最后,我們可以為混合的樣本計(jì)算一個(gè)新的權(quán)重,來(lái)計(jì)算最終的example loss。對(duì)于高噪聲水平,上述二次加權(quán)的影響變得更加明顯。

上面的動(dòng)畫(huà)演示了MentorMix中的四個(gè)關(guān)鍵步驟,其中StudentNet是要在噪聲標(biāo)簽數(shù)據(jù)上進(jìn)行訓(xùn)練的模型。正如Jiang等人所述,我們采用了非常簡(jiǎn)單的MentorNet版本,以計(jì)算每個(gè)樣本的權(quán)重。

模型性能

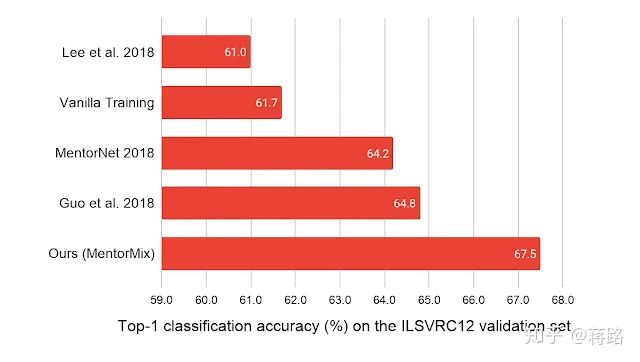

我們?cè)谖鍌€(gè)數(shù)據(jù)集上驗(yàn)證了MentorMix的有效性。其中WebVision 1.0是一個(gè)包含有現(xiàn)實(shí)噪聲標(biāo)簽的220萬(wàn)張圖像的大型數(shù)據(jù)集。MentorMix在WebVision數(shù)據(jù)集上獲得最佳的結(jié)果,就ImageNet ILSVRC12驗(yàn)證集的top-1分類準(zhǔn)確性而言,將以前的最佳方法提高了約3%。

Web噪聲標(biāo)簽的新發(fā)現(xiàn)

這項(xiàng)工作代表了迄今為止最大的研究,目的是了解在噪聲標(biāo)簽上訓(xùn)練的深度神經(jīng)網(wǎng)絡(luò)。我們提出了三個(gè)有關(guān)Web標(biāo)簽噪聲的新發(fā)現(xiàn):

深度神經(jīng)網(wǎng)絡(luò)可以更好地泛化在Web標(biāo)簽噪聲

在神經(jīng)網(wǎng)絡(luò)標(biāo)簽噪聲上,深度神經(jīng)網(wǎng)絡(luò)可能不會(huì)率先學(xué)習(xí)模式 (Learning the early patterns first)

當(dāng)神經(jīng)網(wǎng)絡(luò)在噪聲數(shù)據(jù)上微調(diào)時(shí),更先進(jìn)的ImageNet架構(gòu)會(huì)在帶有噪聲的訓(xùn)練數(shù)據(jù)集上表現(xiàn)的更好。

基于我們的發(fā)現(xiàn),我們有以下針對(duì)在噪聲數(shù)據(jù)上訓(xùn)練深度神經(jīng)網(wǎng)絡(luò)的實(shí)用建議:

處理噪聲標(biāo)簽的一種簡(jiǎn)單方法是fine-tune在干凈的數(shù)據(jù)集(如ImageNet)上預(yù)訓(xùn)練的模型。預(yù)訓(xùn)練的模型越好,則可以更好地推廣到下游含有噪聲的訓(xùn)練任務(wù)上。

提前停止 (Early Stopping)可能對(duì)網(wǎng)絡(luò)上的實(shí)際的標(biāo)簽噪音無(wú)效。

在人工噪聲上表現(xiàn)良好的方法,在現(xiàn)實(shí)世界的噪聲數(shù)據(jù)集上效果可能并不理想

Web標(biāo)簽噪聲似乎危害較小,但是對(duì)于我們當(dāng)前的robust Learning的學(xué)習(xí)方法而言,解決起來(lái)卻更加困難。這個(gè)發(fā)現(xiàn)鼓勵(lì)更多的未來(lái)研究。

建議的MentorMix可以更好地克服人工合成和現(xiàn)實(shí)噪音標(biāo)簽。

MentorMix的代碼可在GitHub上獲得,數(shù)據(jù)集在我們的數(shù)據(jù)集網(wǎng)站上。

GitHub:https://github.com/google-research/google-research/tree/master/mentormix數(shù)據(jù)集:https://google.github.io/controlled-noisy-web-labels/index.html

更多資源:

http://www.lujiang.info/cnlw.html

參考

^這兩種觀點(diǎn)或許都是對(duì)的。不同的結(jié)論來(lái)自于不同的人工噪聲設(shè)置。

^以下我們以來(lái)自網(wǎng)絡(luò)的噪聲標(biāo)簽來(lái)舉例說(shuō)明真實(shí)標(biāo)簽噪聲。雖然真實(shí)噪聲不僅包含網(wǎng)絡(luò)標(biāo)簽,然而網(wǎng)絡(luò)標(biāo)簽是最常見(jiàn)的一種真實(shí)噪聲。

https://ai.googleblog.com/2020/08/understanding-deep-learning-on.html

https://openreview.net/forum?id=Sy8gdB9xx¬eId=Sy8gdB9xx

https://openreview.net/forum?id=Sy8gdB9xx¬eId=Sy8gdB9xx

https://link.zhihu.com/?target=https%3A//en.wikipedia.org/wiki/Scientific_control

下載1:動(dòng)手學(xué)深度學(xué)習(xí)

在「AI算法與圖像處理」公眾號(hào)后臺(tái)回復(fù):動(dòng)手學(xué)深度學(xué)習(xí),即可下載547頁(yè)《動(dòng)手學(xué)深度學(xué)習(xí)》電子書(shū)和源碼。該書(shū)是面向中文讀者的能運(yùn)行、可討論的深度學(xué)習(xí)教科書(shū),它將文字、公式、圖像、代碼和運(yùn)行結(jié)果結(jié)合在一起。本書(shū)將全面介紹深度學(xué)習(xí)從模型構(gòu)造到模型訓(xùn)練,以及它們?cè)谟?jì)算機(jī)視覺(jué)和自然語(yǔ)言處理中的應(yīng)用。

個(gè)人微信(如果沒(méi)有備注不拉群!) 請(qǐng)注明:地區(qū)+學(xué)校/企業(yè)+研究方向+昵稱