筆記|李宏毅老師機器學(xué)習(xí)課程,視頻19卷積神經(jīng)網(wǎng)絡(luò)

《學(xué)習(xí)筆記》專欄·第22篇

文 | MLer

1145字 | 4分鐘閱讀

【數(shù)據(jù)科學(xué)與人工智能】開通了機器學(xué)習(xí)群,大家可以相互學(xué)習(xí)和交流。請掃描下方二維碼,備注:姓名-ML,添加我為好友,誠邀你入群,一起進(jìn)步。

感謝李宏毅老師的分享,他的課程幫助我更好地學(xué)習(xí)、理解和應(yīng)用機器學(xué)習(xí)。李老師的網(wǎng)站:

http://speech.ee.ntu.edu.tw/~tlkagk/index.html。

這個學(xué)習(xí)筆記是根據(jù)李老師2017年秋季機器學(xué)習(xí)課程的視頻和講義做的記錄和總結(jié)。因為這個視頻是在Youtube上面,有些朋友可能無法觀看,我把它搬運下來放在云盤上面,大家點擊閱讀原文,就可以直接在手機隨時隨地觀看了。再次,感謝李老師的付出和貢獻(xiàn)。

這門課,共有36個視頻,每個視頻播放的時間不一。我按著視頻播放的順序,觀看,聆聽和學(xué)習(xí),并結(jié)合講義,做學(xué)習(xí)筆記。我做學(xué)習(xí)筆記目的有三:

1 幫助自己學(xué)習(xí)和理解機器學(xué)習(xí)

2 記錄機器學(xué)習(xí)的重要知識、方法、原理和思想

3 為傳播機器學(xué)習(xí)做點事情

視頻19:卷積神經(jīng)網(wǎng)絡(luò)

一、為什么CNN適合Image?

李老師說CNN,相對于DNN,全連接的網(wǎng)絡(luò),是一個更加簡單的模型,它基于先驗知識,去把原來全連接的layer里面的一些參數(shù)拿掉,就變成了CNN。為什么可以這樣做?

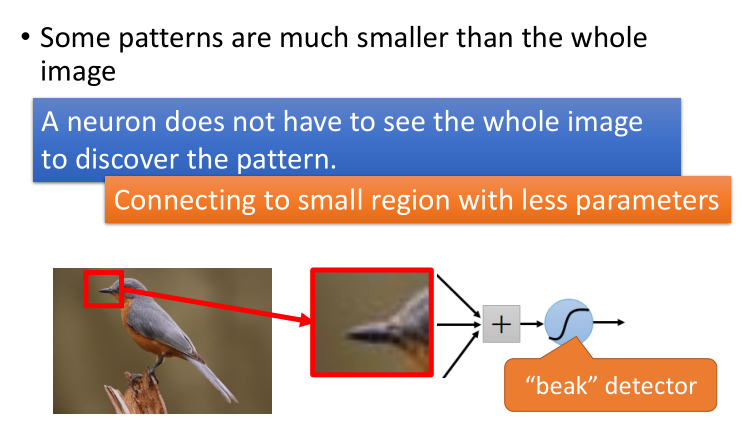

洞察一:一個Pattern只需要觀察一個小的區(qū)域,例如,識別鳥嘴。

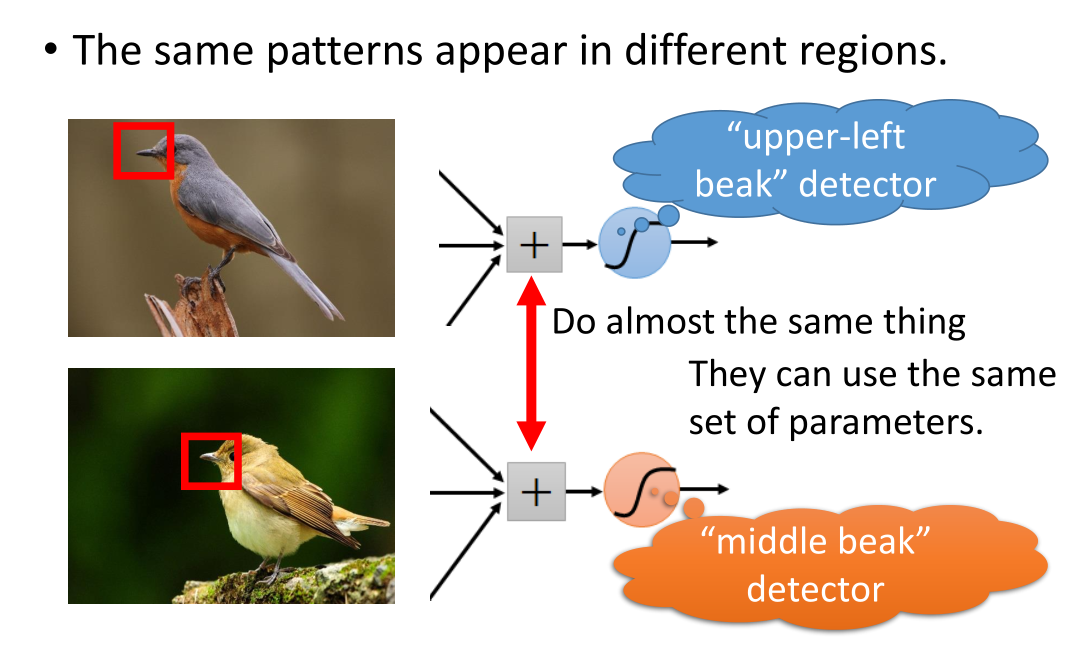

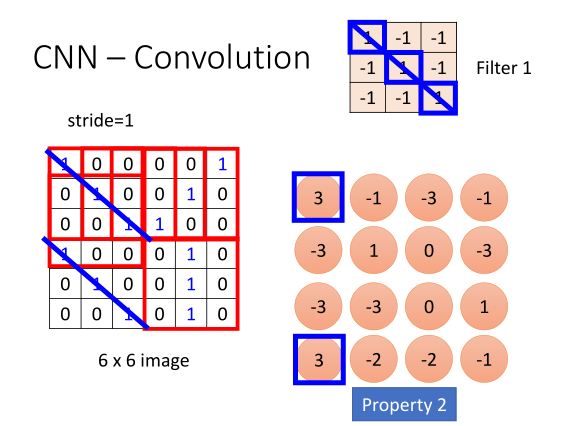

洞察二:同樣Pattern出現(xiàn)在不同區(qū)域時,可以用同一組參數(shù)來識別,即參數(shù)共享機制。

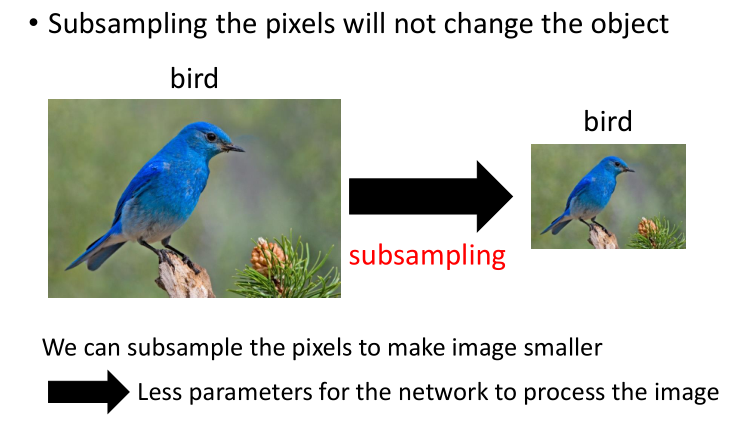

洞察三:對圖像做子抽樣,subsampling,不會影響圖像識別。如下圖:

同樣Pattern出現(xiàn)在不同區(qū)域時,可以用同一組參數(shù)來識別,即參數(shù)共享機制。

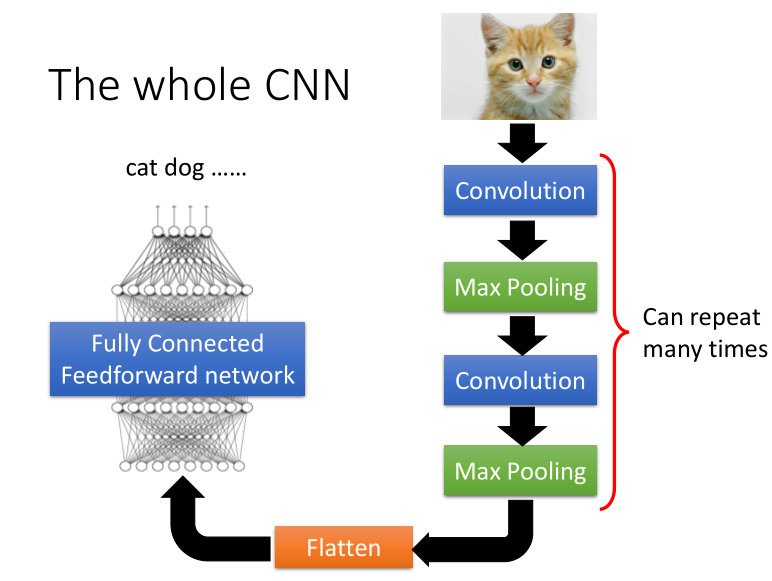

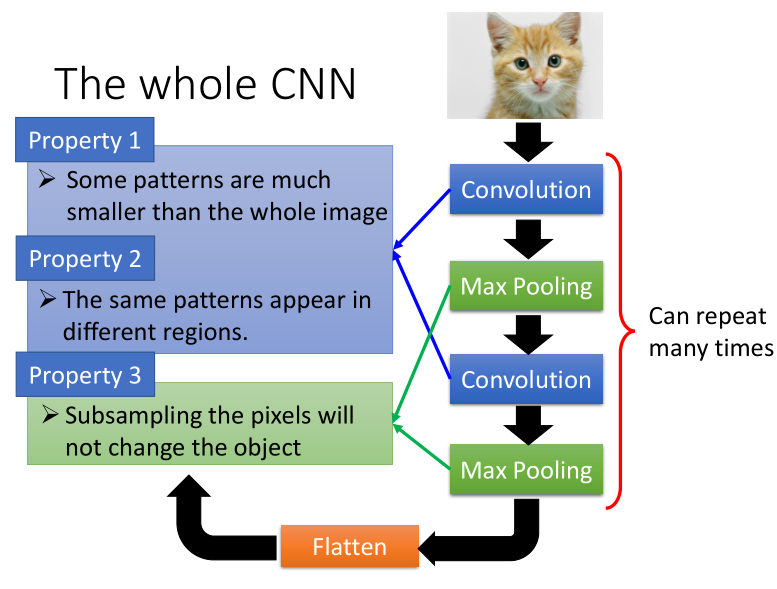

基于這個三個洞察,CNN的整體架構(gòu),如下圖:

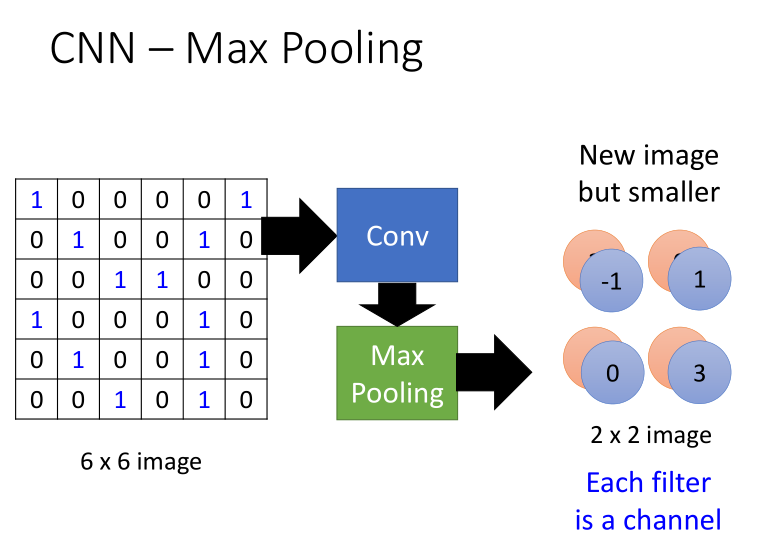

卷積層對應(yīng)于洞察一、二,而池化層對應(yīng)于洞察三。

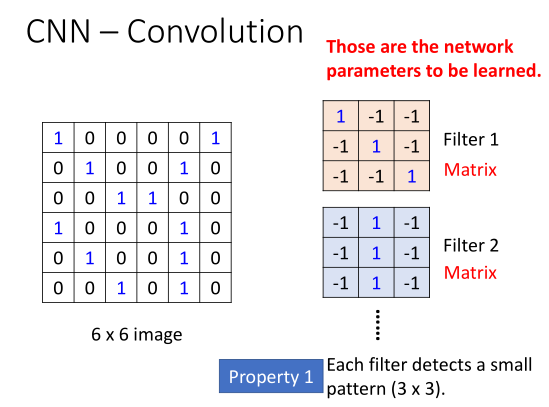

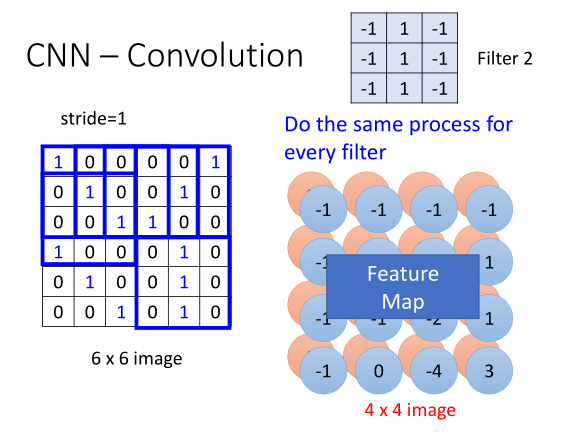

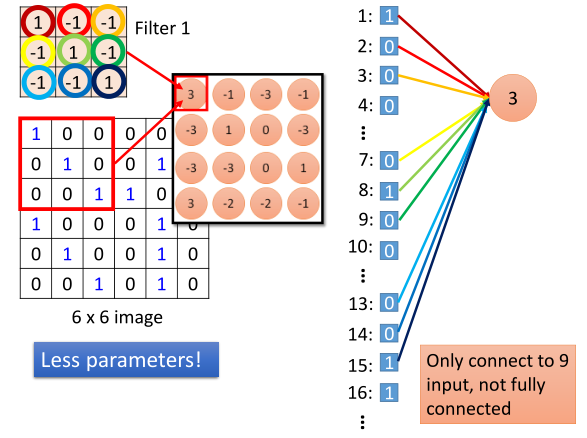

二、卷積層Convolution

李老師詳細(xì)介紹了卷積層的計算和處理邏輯,以及與洞察一和二的關(guān)系,原始數(shù)據(jù)、卷積核、卷積運算、步長(stride=1)、Feature Map,卷積層與全連接的關(guān)系,這些知識,在卷積層里面會用到。更詳細(xì)的內(nèi)容,請觀看視頻。

思考題:

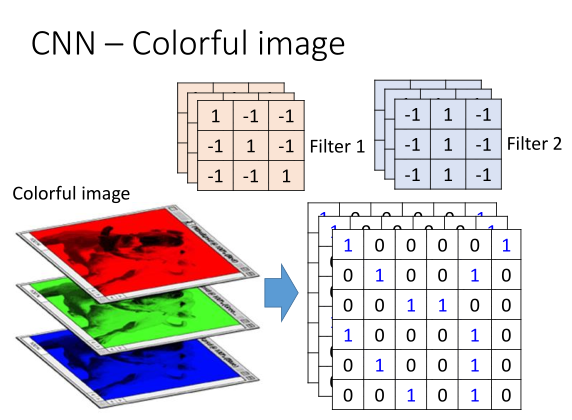

彩色圖像如何做卷積運算?(請留言)

卷積層與全連接的關(guān)系

利用先驗知識,用更少的參數(shù)來達(dá)成了學(xué)習(xí)的目的。

更少的參數(shù),決定了更少的神經(jīng)元個數(shù)和權(quán)重

三、池化層Max Pooling

池化層用于解決做洞察三的事情

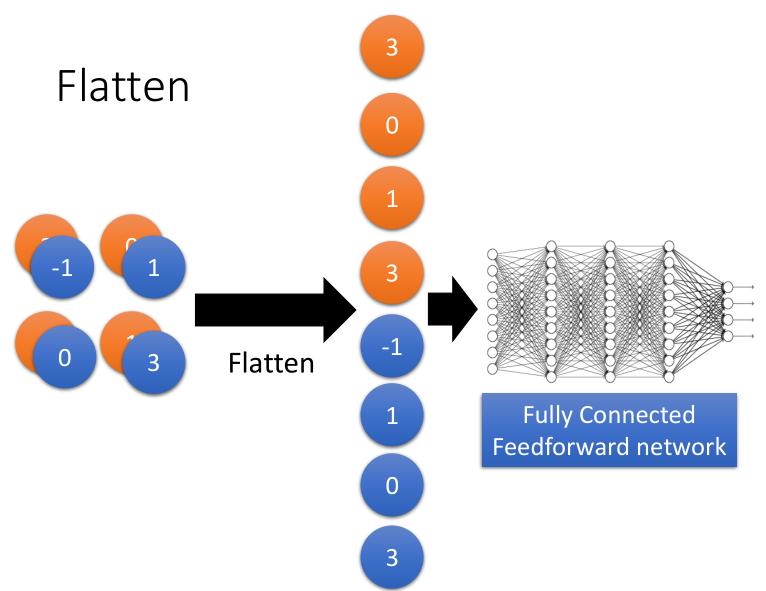

四、全連接層

用于把最后輸出的Feature Map拉直和拼接,構(gòu)建一個DNN。

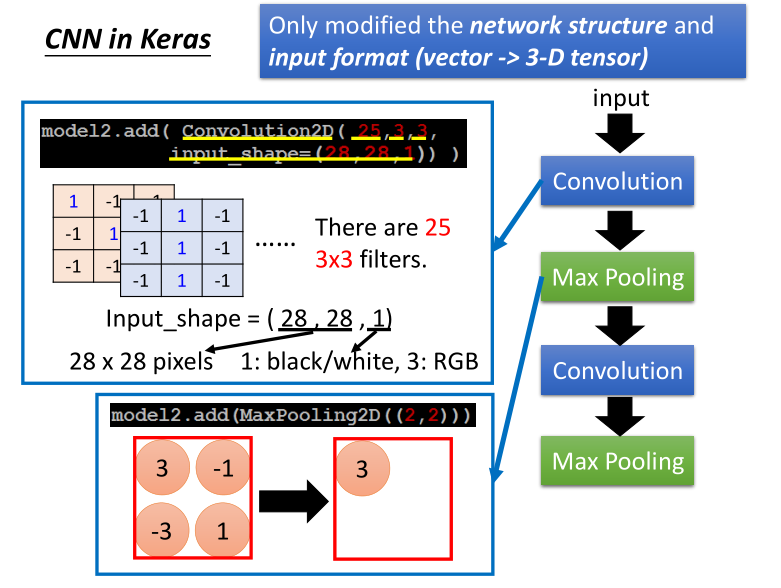

五、基于Keras實現(xiàn)CNN

李老師,以手寫數(shù)字識別為例子,介紹了CNN架構(gòu),如何在Keras上做設(shè)計和實現(xiàn)。

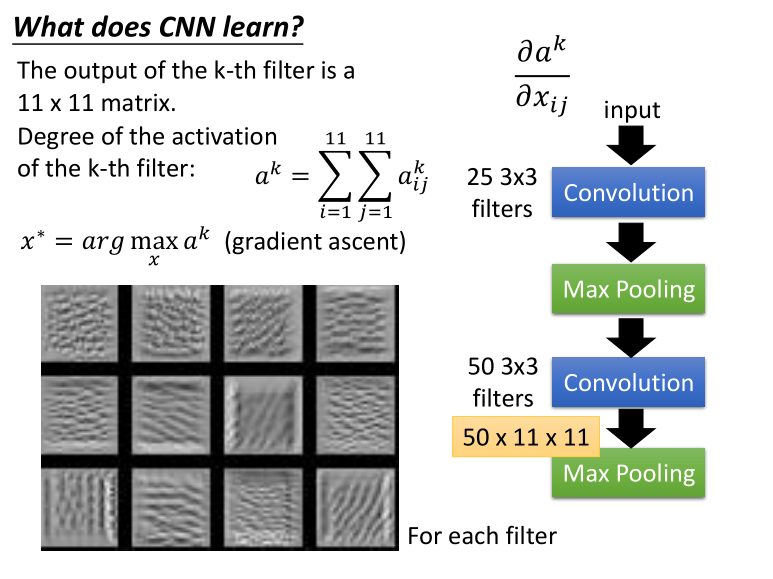

六、CNN為什么可以學(xué)習(xí)?

李老師對CNN這個網(wǎng)絡(luò)架構(gòu)為什么能夠?qū)W習(xí)做了深入淺出的解釋,推薦觀看視頻。

同時,李老師分享了兩個有趣的Deep現(xiàn)象,一個是Deep Dream,另一個是Deep Style。

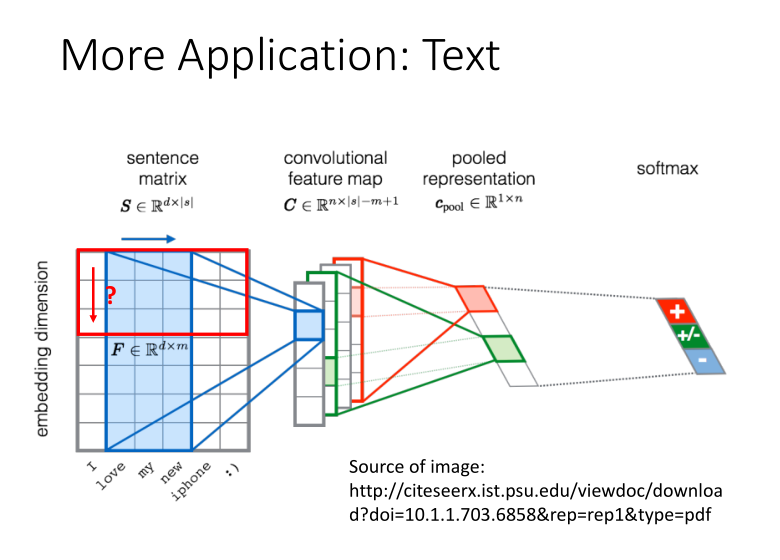

七、CNN的廣泛應(yīng)用

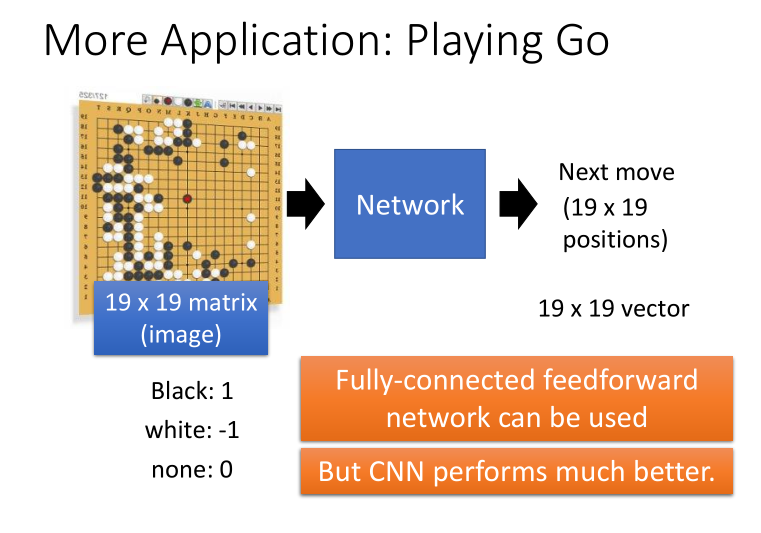

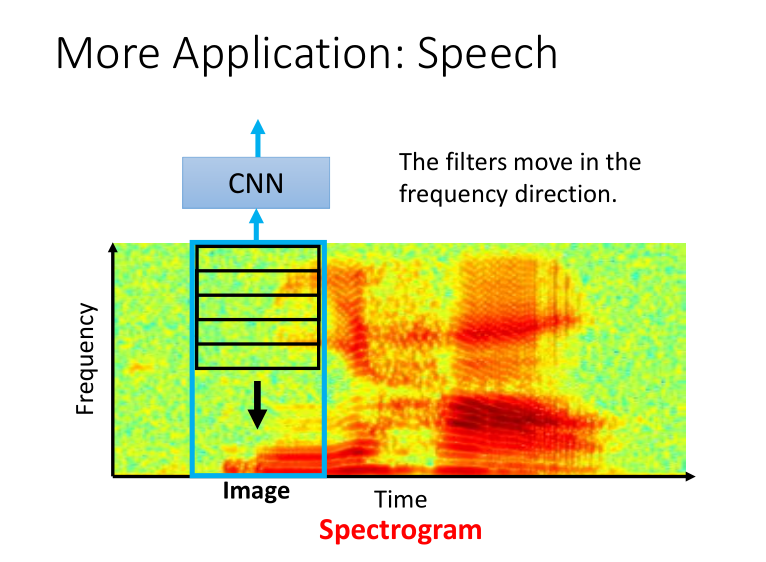

CNN有著廣泛地應(yīng)用,尤其是在圖像領(lǐng)域或者類似圖像的領(lǐng)域。

李老師分享了這些應(yīng)用實例。

1 圍棋比賽,Playing Go

2 語音領(lǐng)域

3 文本領(lǐng)域

詳細(xì)內(nèi)容,請觀看視頻。

朋友們,在學(xué)習(xí)中有什么問題或者想法,請加入機器學(xué)習(xí)群,大家一起討論,共同進(jìn)步。

什么是數(shù)據(jù)挖掘?你怎么看。

每周一書

課程視頻點擊

↓↓↓