目標(biāo)檢測(cè)的性能上界討論

點(diǎn)擊上方“小白學(xué)視覺”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

作者:ChenJoya

https://zhuanlan.zhihu.com/p/94990078

本文已由作者授權(quán),未經(jīng)允許,不得二次轉(zhuǎn)載

https://arxiv.org/abs/1911.12451

發(fā)現(xiàn)了最近 arxiv 上的一篇文章 《Empirical Upper-bound in Object Detection and More》,作者們?cè)诙鄠€(gè)數(shù)據(jù)集上探討了多種檢測(cè)器所能達(dá)到的性能上限,頗有當(dāng)年 Speed/accuracy trade-offs for modern convolutional object detectors 的風(fēng)采。“目標(biāo)檢測(cè)還有什么能做的?”這個(gè)問題確實(shí)很令人迷茫,但自己今后仍然會(huì)密切關(guān)注這個(gè)方向,希望能和這篇文章一樣,為大家?guī)硪恍﹩l(fā)。

Abstract

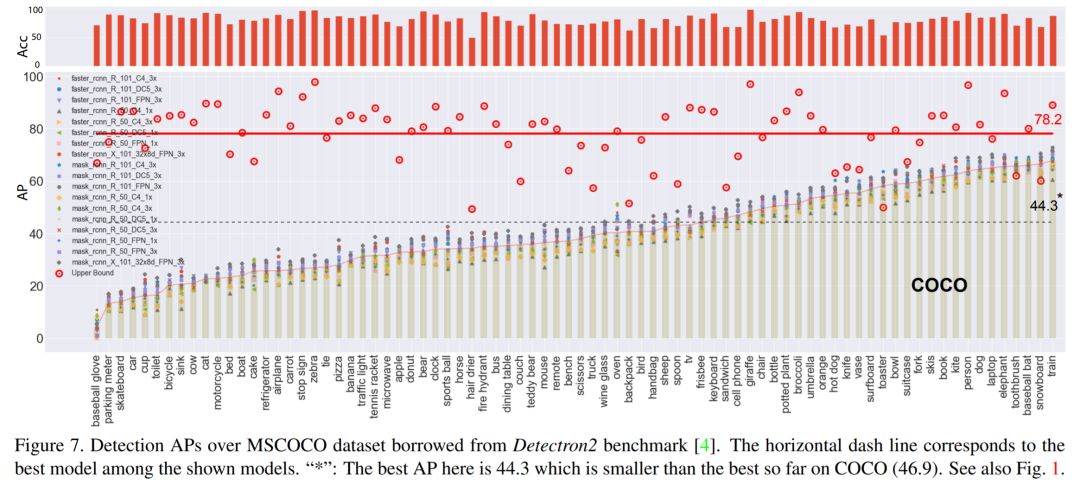

?(1)在作者的計(jì)算方式下,PASCAL VOC (test2007) 的上界可以達(dá)到 91.6%,COCO (val2017) 可以達(dá)到 78.2%, OpenImages V4 (val) 可以達(dá)到 58.9%,它們的上界離現(xiàn)在所能達(dá)到的最佳的性能仍有很大的差距;

(2)發(fā)現(xiàn)分類錯(cuò)誤(混淆/漏檢)比定位錯(cuò)誤和重復(fù)檢測(cè)錯(cuò)誤更加重要;

(3)分析了一些數(shù)據(jù)增強(qiáng)的措施對(duì)檢測(cè)器的影響。

分析 ?

1. 實(shí)驗(yàn)細(xì)節(jié)

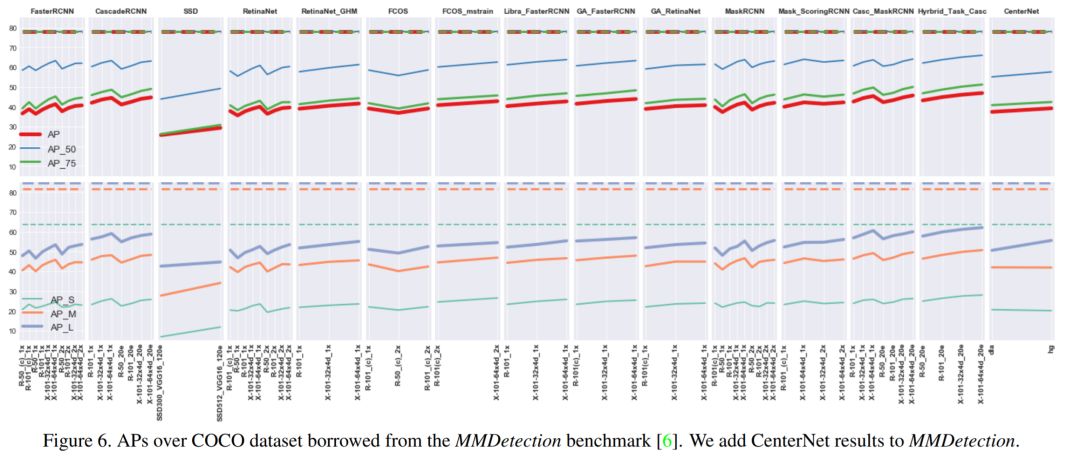

(1)平臺(tái):主流檢測(cè)框架 mmdetection,detectron2 ;

(2)模型:R-CNN 系列(FasterRCNN, MaskRCNN, GridRCNN, LibraRCNN, CascadeRCNN, MaskScoringRCNN, GAFasterRCNN, HTC),one-stage/anchor-free系列 (RetinaNet,SSD, FCOS, CenterNet [objects as points]);

(3)數(shù)據(jù)集:PASCAL VOC (訓(xùn)練 07+12, 測(cè)試 07test), MS COCO (訓(xùn)練 train2017, 測(cè)試 val2017), OpenImages V4 (as Kaggle Competition), Fashion dataset (作者自個(gè)的);

(4)評(píng)價(jià)標(biāo)準(zhǔn):COCO-style AP;

2. 如何估計(jì)性能上界

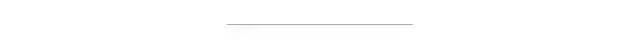

(1)假定性能上界是由 best object classifier 能達(dá)到的,即認(rèn)為定位問題已經(jīng)解決;

(2)探究實(shí)驗(yàn),利用大網(wǎng)絡(luò) ResNet152 對(duì)目標(biāo)進(jìn)行分類,能得到多少的準(zhǔn)確率(top-1 accuracy),發(fā)現(xiàn)將 object 單獨(dú)分離出來效果是最好的;

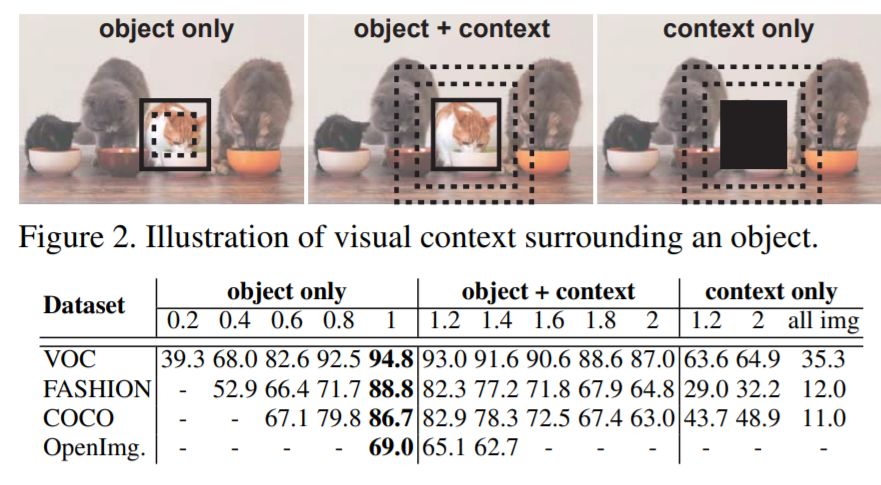

(3)準(zhǔn)備基于 recognition accuracy 來估計(jì) AP 上界。設(shè)計(jì)一種生成 candidate box 的機(jī)制,用于生成不同 IoU 的 bounding-boxes 來計(jì)算 AP,并且基于這些 bounding-boxes 重新訓(xùn)練 ResNet-152 分類器;

(4)對(duì)于每一個(gè) bounding-box 分配 ResNet-152 的 top-1 score 所對(duì)應(yīng)的 label;

3. 各數(shù)據(jù)集的上界

(1) PASCAL VOC

(2)COCO

(3)OpenImages V4

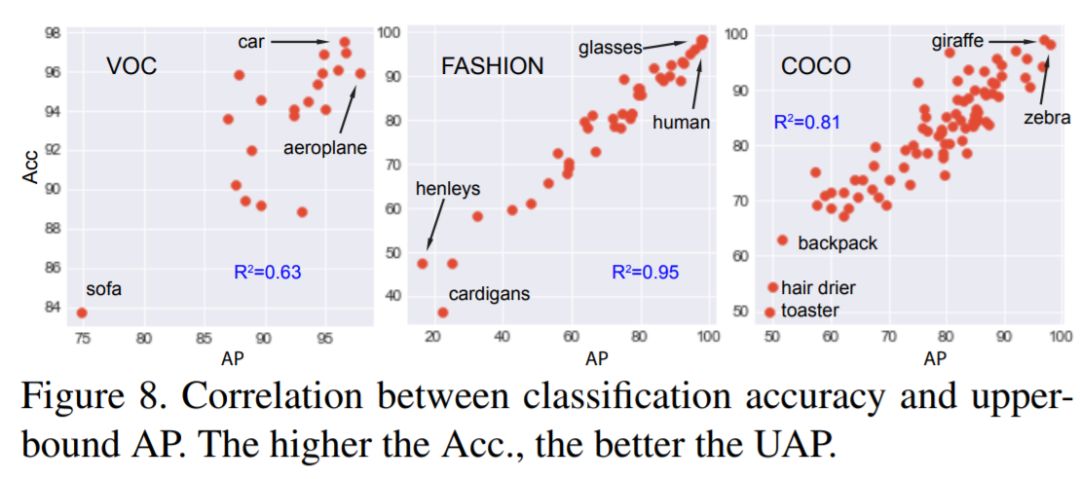

(4)AP 與識(shí)別 accuracy 的關(guān)聯(lián)

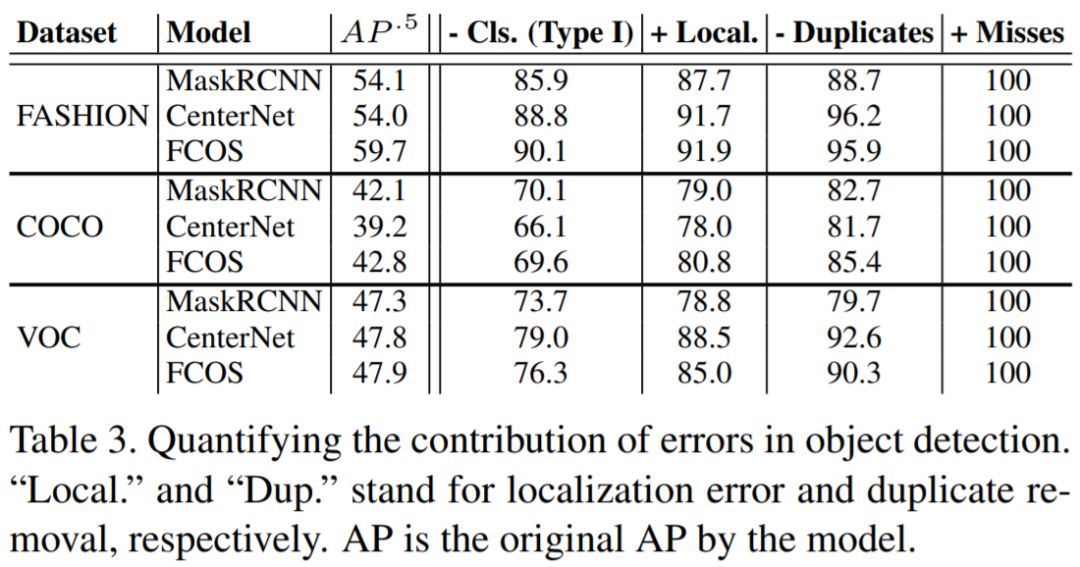

4. Error Diagnosis

(1)定義四種錯(cuò)誤類型:

(2)對(duì)于每種錯(cuò)誤,人為地消除后觀察其提升,沒有了分類方面的錯(cuò)誤后,性能提升最明顯:

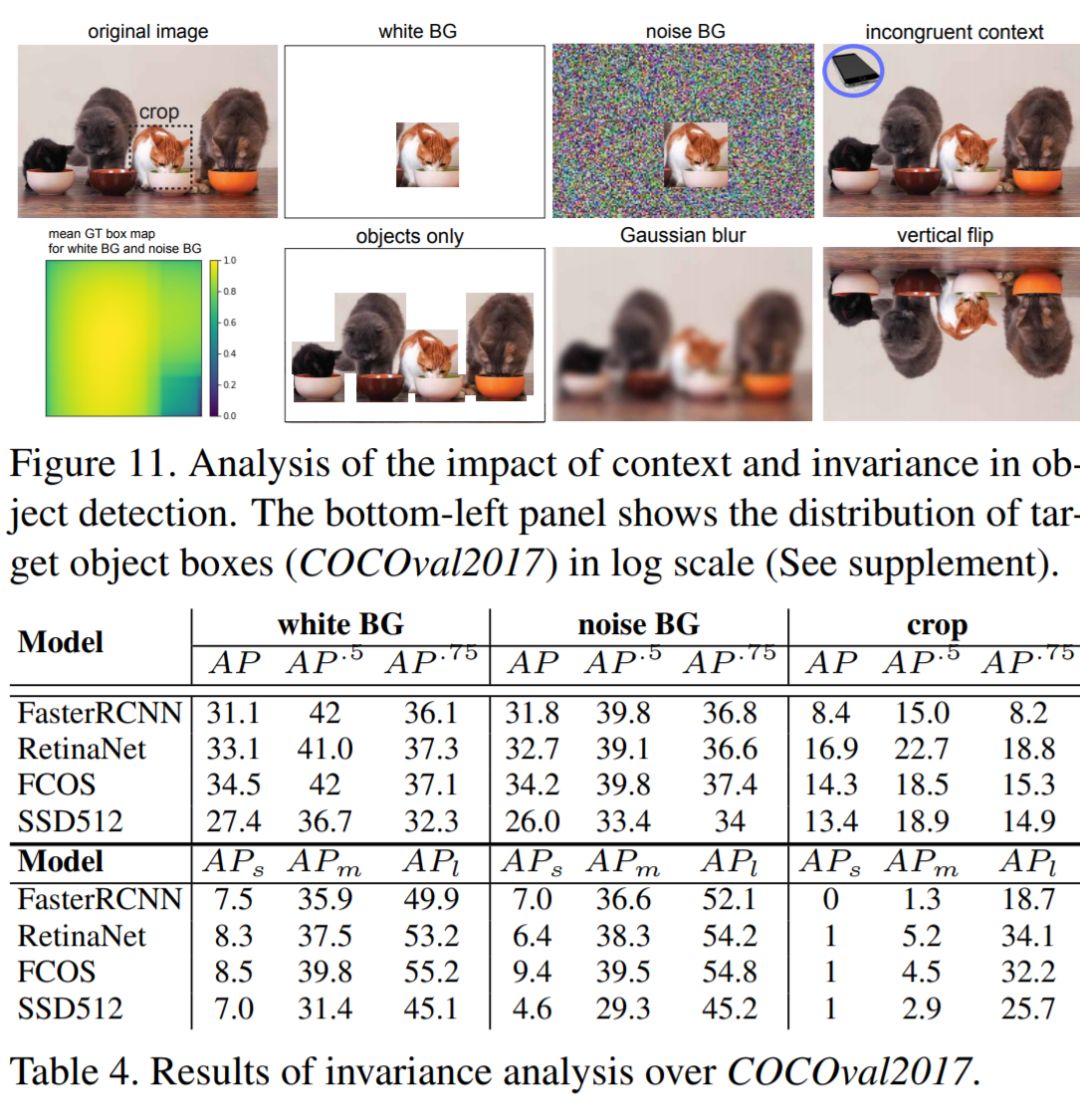

5. Invariance Analysis

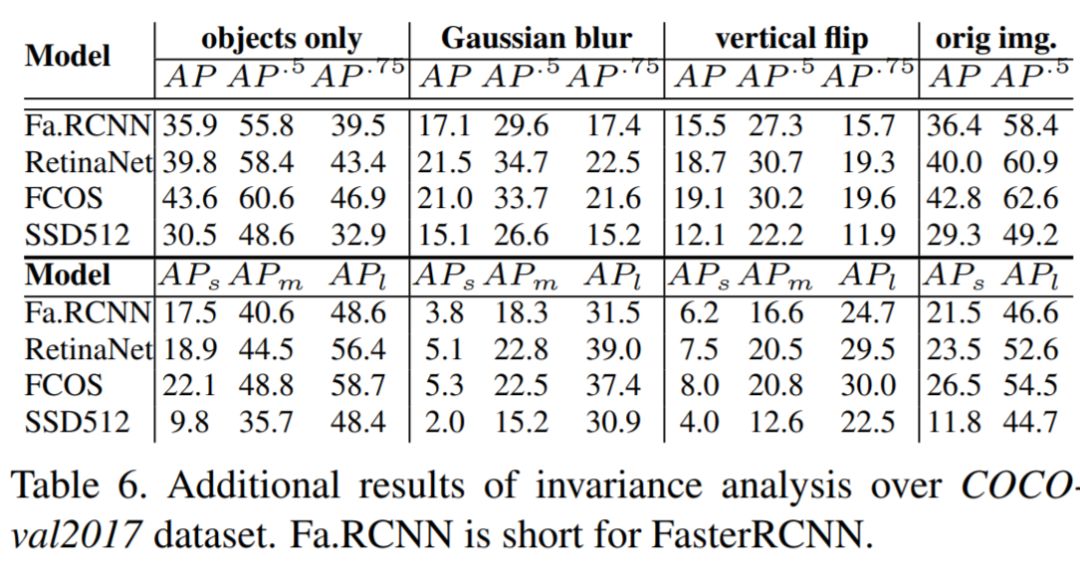

做各種數(shù)據(jù)處理,觀察性能變化。總的來說,F(xiàn)COS,RetinaNet 屬于最優(yōu)秀的那一檔。

結(jié)論 ?

(1)現(xiàn)在檢測(cè)器的性能還沒有離上界還有一定差距(但似乎在 [email protected] 時(shí)已經(jīng)十分接近上界了);

(2)檢測(cè)器的瓶頸在目標(biāo)識(shí)別(recognition)上;

(3)檢測(cè)器缺乏魯棒性;

(4)并沒有發(fā)現(xiàn)明顯的證據(jù)說明 context 對(duì)于分類目標(biāo)是有效的。

好消息!?

小白學(xué)視覺知識(shí)星球

開始面向外開放啦??????

下載1:OpenCV-Contrib擴(kuò)展模塊中文版教程 在「小白學(xué)視覺」公眾號(hào)后臺(tái)回復(fù):擴(kuò)展模塊中文教程,即可下載全網(wǎng)第一份OpenCV擴(kuò)展模塊教程中文版,涵蓋擴(kuò)展模塊安裝、SFM算法、立體視覺、目標(biāo)跟蹤、生物視覺、超分辨率處理等二十多章內(nèi)容。 下載2:Python視覺實(shí)戰(zhàn)項(xiàng)目52講 在「小白學(xué)視覺」公眾號(hào)后臺(tái)回復(fù):Python視覺實(shí)戰(zhàn)項(xiàng)目,即可下載包括圖像分割、口罩檢測(cè)、車道線檢測(cè)、車輛計(jì)數(shù)、添加眼線、車牌識(shí)別、字符識(shí)別、情緒檢測(cè)、文本內(nèi)容提取、面部識(shí)別等31個(gè)視覺實(shí)戰(zhàn)項(xiàng)目,助力快速學(xué)校計(jì)算機(jī)視覺。 下載3:OpenCV實(shí)戰(zhàn)項(xiàng)目20講 在「小白學(xué)視覺」公眾號(hào)后臺(tái)回復(fù):OpenCV實(shí)戰(zhàn)項(xiàng)目20講,即可下載含有20個(gè)基于OpenCV實(shí)現(xiàn)20個(gè)實(shí)戰(zhàn)項(xiàng)目,實(shí)現(xiàn)OpenCV學(xué)習(xí)進(jìn)階。 交流群

歡迎加入公眾號(hào)讀者群一起和同行交流,目前有SLAM、三維視覺、傳感器、自動(dòng)駕駛、計(jì)算攝影、檢測(cè)、分割、識(shí)別、醫(yī)學(xué)影像、GAN、算法競(jìng)賽等微信群(以后會(huì)逐漸細(xì)分),請(qǐng)掃描下面微信號(hào)加群,備注:”昵稱+學(xué)校/公司+研究方向“,例如:”張三?+?上海交大?+?視覺SLAM“。請(qǐng)按照格式備注,否則不予通過。添加成功后會(huì)根據(jù)研究方向邀請(qǐng)進(jìn)入相關(guān)微信群。請(qǐng)勿在群內(nèi)發(fā)送廣告,否則會(huì)請(qǐng)出群,謝謝理解~