【CV】Python+OpenCV模板匹配實現(xiàn)機器視覺

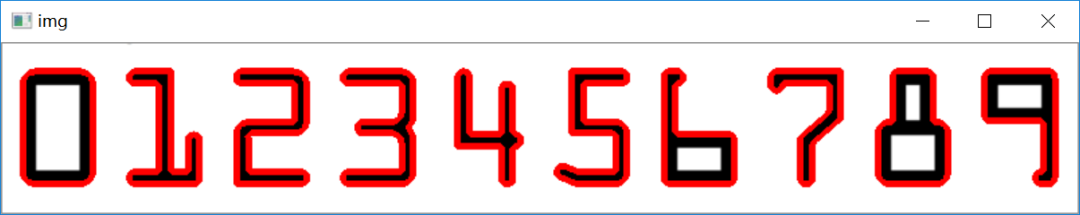

機器視覺系統(tǒng)是通過機器視覺產(chǎn)品(即圖像攝取裝置,分CMOS和CCD兩種)將被攝取目標轉換成圖像信號,傳送給專用的圖像處理系統(tǒng),得到被攝目標的形態(tài)信息,根據(jù)像素分布和亮度、顏色等信息,轉變成數(shù)字化信號;圖像系統(tǒng)對這些信號進行各種運算來抽取目標的特征,進而根據(jù)判別的結果來控制現(xiàn)場的設備動作。

模板匹配是一種最原始、最基本的模式識別方法,研究某一特定對象物的圖案位于圖像的什么地方,進而識別對象物,這就是一個匹配問題。它是圖像處理中最基本、最常用的匹配方法。模板匹配具有自身的局限性,主要表現(xiàn)在它只能進行平行移動,若原圖像中的匹配目標發(fā)生旋轉或大小變化,該算法無效。

簡單來說,模板匹配就是在整個圖像區(qū)域發(fā)現(xiàn)與給定子圖像匹配的小塊區(qū)域。

工作原理:在帶檢測圖像上,從左到右,從上向下計算模板圖像與重疊子圖像的匹配度,匹配程度越大,兩者相同的可能性越大。

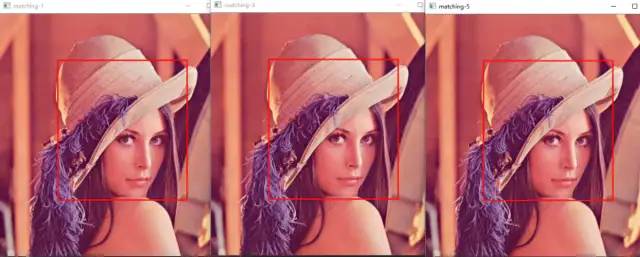

目標圖.jpg

模板圖.jpg

模板匹配.jpg

上一篇文章講了圖像糾偏:

糾偏之后如果在沒有OCR的條件下,就可以使用模板匹配進行自動識別。

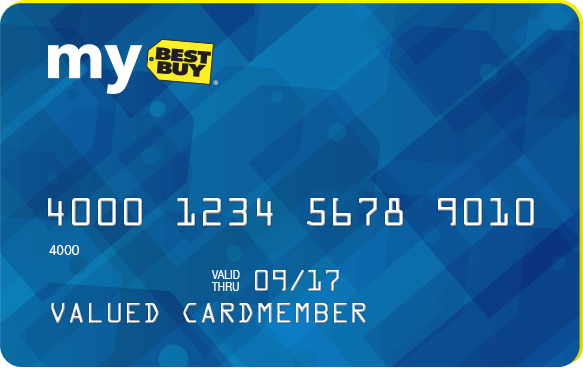

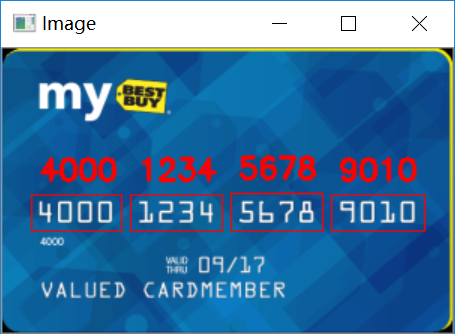

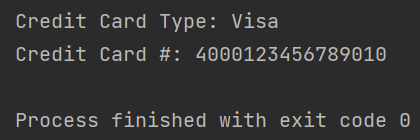

下面我們用模板識別的方法來自動提取信用卡的卡號。

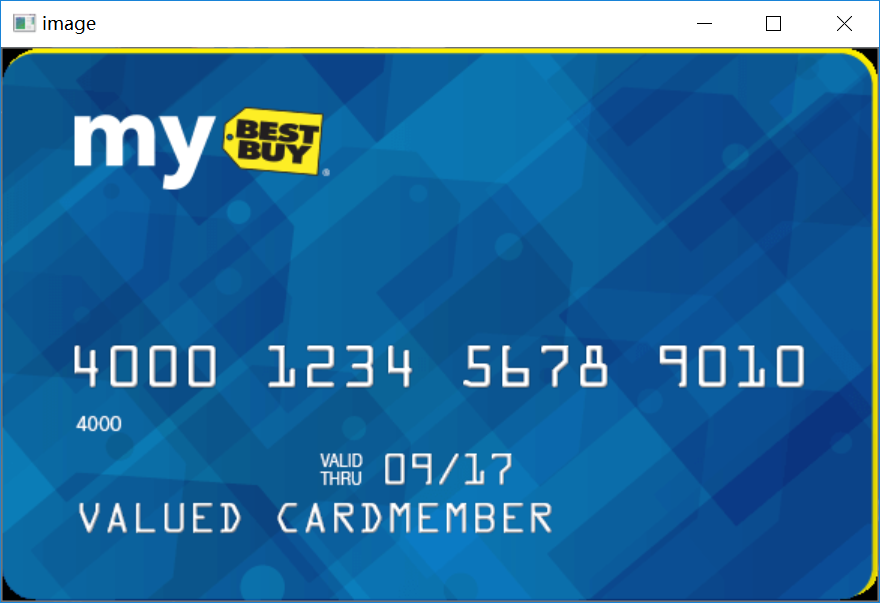

credit_card_01.png(目標圖)

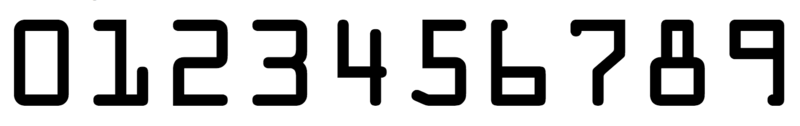

ocr_a_reference.png(模板圖)

No BB,show code:

# 導入工具包from imutils import contoursimport numpy as npimport argparseimport cv2import myutils

其中 myutils 是自己寫的工具包:

myutils?.py

import cv2def sort_contours(cnts, method="left-to-right"):reverse = Falsei = 0if method == "right-to-left" or method == "bottom-to-top":reverse = Trueif method == "top-to-bottom" or method == "bottom-to-top":i = 1boundingBoxes = [cv2.boundingRect(c) for c in cnts] #用一個最小的矩形,把找到的形狀包起來x,y,h,w(cnts, boundingBoxes) = zip(*sorted(zip(cnts, boundingBoxes),key=lambda b: b[1][i], reverse=reverse))return cnts, boundingBoxesdef resize(image, width=None, height=None, inter=cv2.INTER_AREA):dim = None(h, w) = image.shape[:2]if width is None and height is None:return imageif width is None:r = height / float(h)dim = (int(w * r), height)else:r = width / float(w)dim = (width, int(h * r))resized = cv2.resize(image, dim, interpolation=inter)return resized

# 設置參數(shù)ap = argparse.ArgumentParser()ap.add_argument("-i", "--image", required=True,help="path to input image")ap.add_argument("-t", "--template", required=True,help="path to template OCR-A image")args = vars(ap.parse_args())

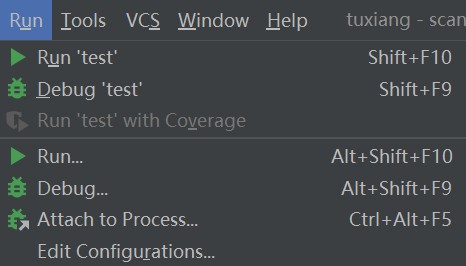

在運行時需要配置輸入的目標圖像和模板圖像,在pycharm中的Edit Configurations中進行配置。

配置代碼為:

--image

images/credit_card_01.png

--template

images/ocr_a_reference.png

#?利用信用卡第一的數(shù)字來指定信用卡類型FIRST_NUMBER = {"3": "American Express","4": "Visa","5": "MasterCard","6": "Discover Card"}

# 繪圖展示def cv_show(name,img):cv2.imshow(name, img)cv2.waitKey(0)cv2.destroyAllWindows()

在做好所有配置,寫好所有函數(shù)之后,開始我們模板匹配的操作:

首先處理模板,把每個數(shù)字的最小矩形框找到:

# 讀取一個模板圖像img = cv2.imread(args["template"])# 展示模板cv_show('img',img)

ref = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)cv_show('ref',ref)

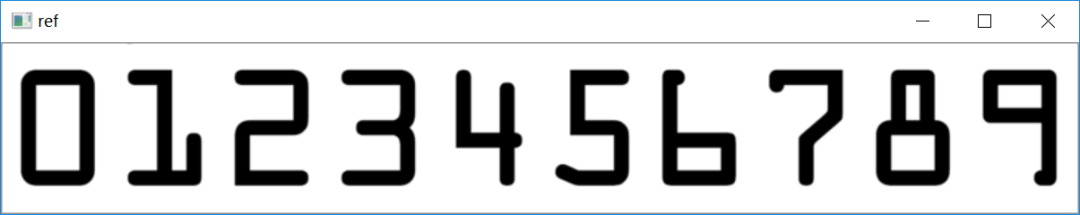

ref = cv2.threshold(ref, 10, 255, cv2.THRESH_BINARY_INV)[1]cv_show('ref',ref)

refCnts, hierarchy = cv2.findContours(ref.copy(), cv2.RETR_EXTERNAL,cv2.CHAIN_APPROX_SIMPLE)cv2.drawContours(img,refCnts,-1,(0,0,255),3)cv_show('img',img)

# 打印有多少個輪廓print (np.array(refCnts).shape)refCnts = myutils.sort_contours(refCnts, method="left-to-right")[0] #排序,從左到右,從上到下

對找到的每個矩形框按順序匹配上0-9的數(shù)字:

digits = {}# 遍歷每一個輪廓for (i, c) in enumerate(refCnts):# 計算外接矩形并且resize成合適大小y, w, h) = cv2.boundingRect(c)roi = ref[y:y + h, x:x + w]roi = cv2.resize(roi, (57, 88))# 每一個數(shù)字對應每一個模板=?roi

下面開始處理目標圖像,通過對目標圖片進行濾波、灰度、Sobel算子邊緣檢測、自適應閾值處理、閉運算、膨脹、腐蝕、輪廓檢測等一系列形態(tài)學操作。利用信用卡號的特定長寬比鎖定卡號位置并截取出來:

# 初始化卷積核rectKernel = cv2.getStructuringElement(cv2.MORPH_RECT, (9, 3))sqKernel = cv2.getStructuringElement(cv2.MORPH_RECT, (5, 5))#讀取輸入圖像,預處理image = cv2.imread(args["image"])cv_show('image',image)

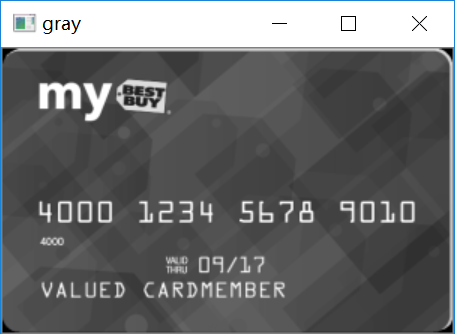

image = myutils.resize(image, width=300)#灰度圖gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)cv_show('gray',gray)

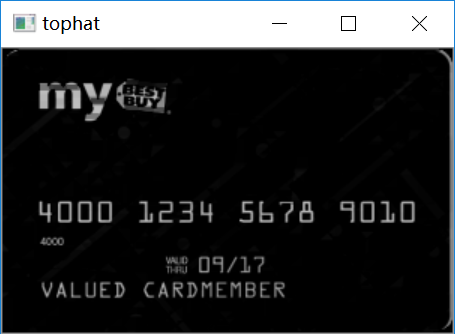

#禮帽操作,突出更明亮的區(qū)域tophat = cv2.morphologyEx(gray, cv2.MORPH_TOPHAT, rectKernel)cv_show('tophat',tophat)

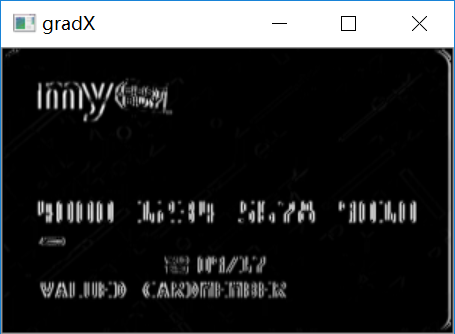

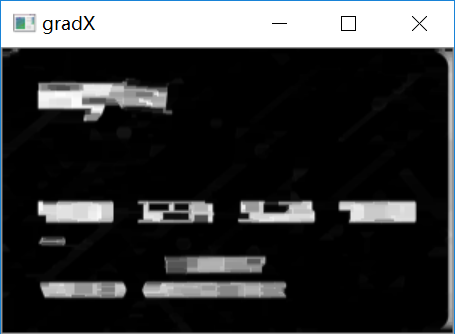

#sobel算子邊緣檢測gradX = cv2.Sobel(tophat, ddepth=cv2.CV_32F, dx=1, dy=0, #ksize=-1相當于用3*3的ksize=-1)gradX = np.absolute(gradX)(minVal, maxVal) = (np.min(gradX), np.max(gradX))#歸一化gradX = (255 * ((gradX - minVal) / (maxVal - minVal)))gradX = gradX.astype("uint8")print (np.array(gradX).shape)cv_show('gradX',gradX)

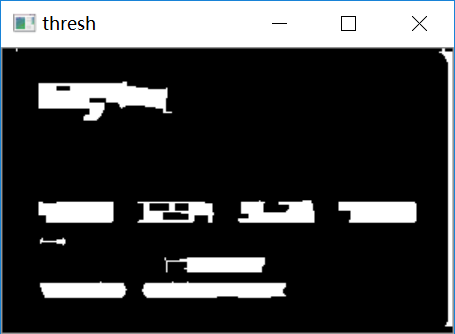

#通過閉操作(先膨脹,再腐蝕)將數(shù)字連在一起gradX = cv2.morphologyEx(gradX, cv2.MORPH_CLOSE, rectKernel)cv_show('gradX',gradX)#THRESH_OTSU會自動尋找合適的閾值,適合雙峰,需把閾值參數(shù)設置為0thresh = cv2.threshold(gradX, 0, 255,cv2.THRESH_BINARY | cv2.THRESH_OTSU)[1]cv_show('thresh',thresh)

#再來一個閉操作thresh = cv2.morphologyEx(thresh, cv2.MORPH_CLOSE, sqKernel) #再來一個閉操作cv_show('thresh',thresh)

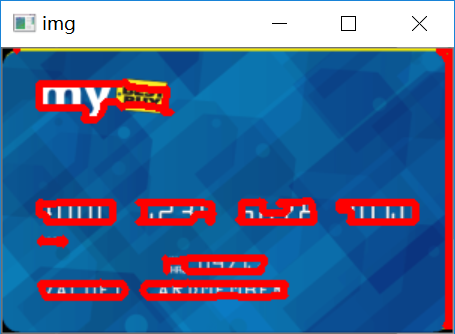

# 計算輪廓threshCnts, hierarchy = cv2.findContours(thresh.copy(), cv2.RETR_EXTERNAL,cv2.CHAIN_APPROX_SIMPLE)cnts = threshCntscur_img = image.copy()cv2.drawContours(cur_img,cnts,-1,(0,0,255),3)cv_show('img',cur_img)

最后一步,遍歷所有輪廓,以數(shù)字塊特有的長寬比鎖定數(shù)據(jù)區(qū)域,再跟模板做匹配,得到每一個數(shù)字塊的值,并在信用卡上顯示出來:

locs = []for (i, c) in enumerate(cnts):# 計算矩形(x, y, w, h) = cv2.boundingRect(c)ar = w / float(h)if ar > 2.5 and ar < 4.0:if (w > 40 and w < 55) and (h > 10 and h < 20):locs.append((x, y, w, h))locs = sorted(locs, key=lambda x:x[0])output = []for (i, (gX, gY, gW, gH)) in enumerate(locs):# initialize the list of group digitsgroupOutput = []group = gray[gY - 5:gY + gH + 5, gX - 5:gX + gW + 5]cv_show('group',group)group = cv2.threshold(group, 0, 255,cv2.THRESH_BINARY | cv2.THRESH_OTSU)[1]cv_show('group',group)digitCnts,hierarchy = cv2.findContours(group.copy(), cv2.RETR_EXTERNAL,cv2.CHAIN_APPROX_SIMPLE)digitCnts = contours.sort_contours(digitCnts,method="left-to-right")[0]for c in digitCnts:(x, y, w, h) = cv2.boundingRect(c)roi = group[y:y + h, x:x + w]roi = cv2.resize(roi, (57, 88))cv_show('roi',roi)scores = []for (digit, digitROI) in digits.items():result = cv2.matchTemplate(roi, digitROI,cv2.TM_CCOEFF)(_, score, _, _) = cv2.minMaxLoc(result)scores.append(score)groupOutput.append(str(np.argmax(scores)))cv2.rectangle(image, (gX - 5, gY - 5),(gX + gW + 5, gY + gH + 5), (0, 0, 255), 1)cv2.putText(image, "".join(groupOutput), (gX, gY - 15),cv2.FONT_HERSHEY_SIMPLEX, 0.65, (0, 0, 255), 2)output.extend(groupOutput)

最后把匹配出來的數(shù)字進行輸出,提交給用戶。

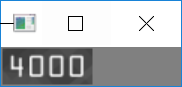

# 打印結果print("Credit Card Type: {}".format(FIRST_NUMBER[output[0]]))print("Credit Card #: {}".format("".join(output)))cv2.imshow("Image", image)cv2.waitKey(0)

本文為大家分享了機器視覺檢測與識別信用卡卡號的一種思路,首先如果照片拍得有噪聲,可以先對目標圖像進行常規(guī)的預處理像高斯濾波、中值濾波去除噪聲。接著利用需要識別目標本身特定的長寬比鎖定目標具體位置。而獲取圖像輪廓邊緣進而求得長寬比的方法多種多樣,本次分享利用Sobel算子進行邊緣檢測然后通過膨脹、腐蝕等形態(tài)學操作去除多余輪廓和毛刺。最后進行輪廓檢測,獲取每個輪廓的坐標信息。此時,我們可以利用坐標信息轉換為輪廓的長寬比信息。如此,從目標圖片截取需要識別圖片的問題就迎刃而解了。

成功截取圖片后我們的思路是:將每一個數(shù)字分割,單獨存放,為后續(xù)進行的模板匹配識別提供方便。可以仿照上面截取目標圖片的大致思路,經(jīng)過預處理和進一步形態(tài)學處理后檢測輪廓。同樣利用長寬比和檢測出來的坐標信息分割出單個字符并保存。

經(jīng)過上面兩步,我們已經(jīng)獲得了單個數(shù)字的圖片,此時我們利用已經(jīng)準備好的模板庫,與之進行特征值運算比較。與數(shù)字圖片相似度最高的模板標簽即為模板識別的輸出結果。按照相同的方法識別余下字符,并將他們打印出來,這就是本次項目所實現(xiàn)的效果,將目標圖片的信用卡號識別并打印出來。

這個思路同樣可以用于車牌的自動識別,電表讀數(shù)的自動識別。

完美。

往期精彩回顧

適合初學者入門人工智能的路線及資料下載 (圖文+視頻)機器學習入門系列下載 中國大學慕課《機器學習》(黃海廣主講) 機器學習及深度學習筆記等資料打印 《統(tǒng)計學習方法》的代碼復現(xiàn)專輯 機器學習交流qq群955171419,加入微信群請掃碼: