機(jī)器學(xué)習(xí)過擬合與欠擬合!

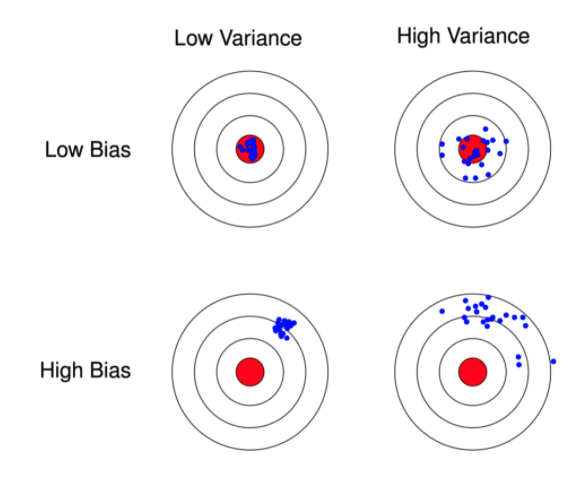

如何理解高方差與低偏差?

模型的預(yù)測誤差可以分解為三個部分: 偏差(bias), 方差(variance) 和噪聲(noise).

偏差

偏差度量了模型的期望預(yù)測與真實(shí)結(jié)果的偏離程度, 即刻畫了學(xué)習(xí)算法本身的擬合能力。偏差則表現(xiàn)為在特定分布上的適應(yīng)能力,偏差越大越偏離真實(shí)值。

方差

方差度量了同樣大小的訓(xùn)練集的變動所導(dǎo)致的學(xué)習(xí)性能的變化, 即刻畫了數(shù)據(jù)擾動所造成的影響。方差越大,說明數(shù)據(jù)分布越分散。

噪聲

噪聲表達(dá)了在當(dāng)前任務(wù)上任何模型所能達(dá)到的期望泛化誤差的下界, 即刻畫了學(xué)習(xí)問題本身的難度 。

下圖為偏差和方差示意圖。

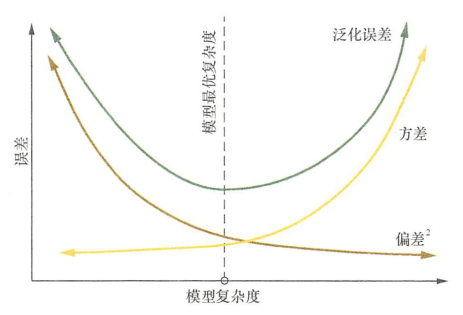

泛化誤差、偏差、方差和模型復(fù)雜度的關(guān)系(圖片來源百面機(jī)器學(xué)習(xí))

參考資料:https://blog.csdn.net/simple_the_best/article/details/71167786

Q2

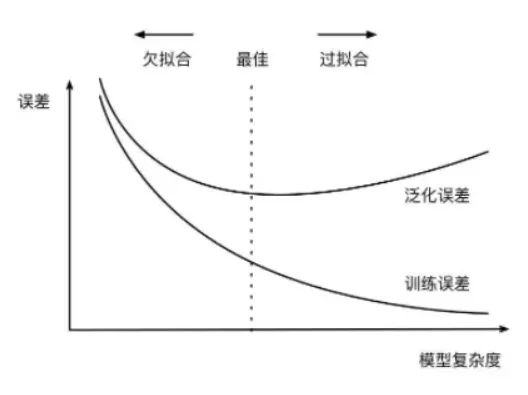

什么是過擬合和欠擬合,為什么會出現(xiàn)這個現(xiàn)象?

過擬合指的是在訓(xùn)練數(shù)據(jù)集上表現(xiàn)良好,而在未知數(shù)據(jù)上表現(xiàn)差。如圖所示:

欠擬合指的是模型沒有很好地學(xué)習(xí)到數(shù)據(jù)特征,不能夠很好地?cái)M合數(shù)據(jù),在訓(xùn)練數(shù)據(jù)和未知數(shù)據(jù)上表現(xiàn)都很差。

過擬合的原因在于:

參數(shù)太多,模型復(fù)雜度過高;

建模樣本選取有誤,導(dǎo)致選取的樣本數(shù)據(jù)不足以代表預(yù)定的分類規(guī)則; 樣本噪音干擾過大,使得機(jī)器將部分噪音認(rèn)為是特征從而擾亂了預(yù)設(shè)的分類規(guī)則; 假設(shè)的模型無法合理存在,或者說是假設(shè)成立的條件實(shí)際并不成立。

欠擬合的原因在于:

特征量過少;

模型復(fù)雜度過低。

Q3

怎么解決欠擬合?

增加新特征,可以考慮加入進(jìn)特征組合、高次特征,來增大假設(shè)空間; 添加多項(xiàng)式特征,這個在機(jī)器學(xué)習(xí)算法里面用的很普遍,例如將線性模型通過添加二次項(xiàng)或者三次項(xiàng)使模型泛化能力更強(qiáng); 減少正則化參數(shù),正則化的目的是用來防止過擬合的,但是模型出現(xiàn)了欠擬合,則需要減少正則化參數(shù); 使用非線性模型,比如核SVM 、決策樹、深度學(xué)習(xí)等模型; 調(diào)整模型的容量(capacity),通俗地,模型的容量是指其擬合各種函數(shù)的能力; 容量低的模型可能很難擬合訓(xùn)練集。

Q4

怎么解決過擬合?(重點(diǎn))

獲取和使用更多的數(shù)據(jù)(數(shù)據(jù)集增強(qiáng))——解決過擬合的根本性方法 特征降維:人工選擇保留特征的方法對特征進(jìn)行降維 加入正則化,控制模型的復(fù)雜度 Dropout Early stopping 交叉驗(yàn)證 增加噪聲

Q5

為什么參數(shù)越小代表模型越簡單?

因?yàn)閰?shù)的稀疏,在一定程度上實(shí)現(xiàn)了特征的選擇。

越復(fù)雜的模型,越是會嘗試對所有的樣本進(jìn)行擬合,甚至包括一些異常樣本點(diǎn),這就容易造成在較小的區(qū)間里預(yù)測值產(chǎn)生較大的波動,這種較大的波動也反映了在這個區(qū)間里的導(dǎo)數(shù)很大,而只有較大的參數(shù)值才能產(chǎn)生較大的導(dǎo)數(shù)。因此復(fù)雜的模型,其參數(shù)值會比較大。因此參數(shù)越少代表模型越簡單。

Q6

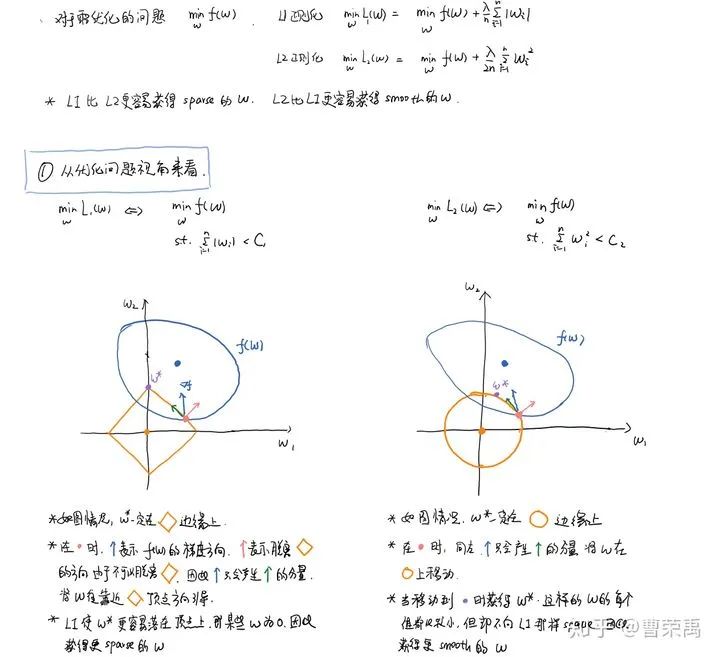

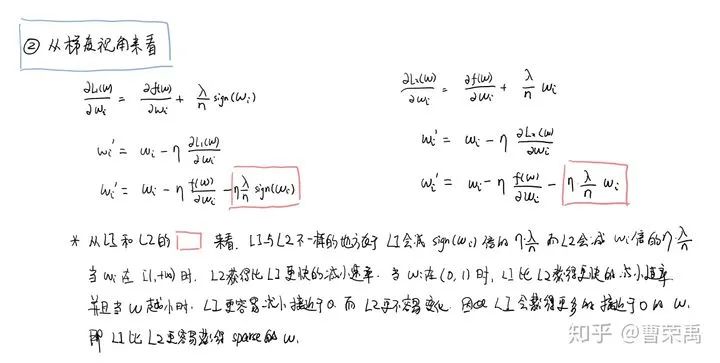

為什么L1比L2更容易獲得稀疏解?(重點(diǎn))

參考鏈接:https://www.zhihu.com/question/37096933/answer/475278057

Q7

Dropout為什么有助于過擬合?(重點(diǎn))

1. 取平均的作用

先回到標(biāo)準(zhǔn)的模型即沒有dropout,我們用相同的訓(xùn)練數(shù)據(jù)去訓(xùn)練5個不同的神經(jīng)網(wǎng)絡(luò),一般會得到5個不同的結(jié)果,此時(shí)我們可以采用 “5個結(jié)果取均值”或者“多數(shù)取勝的投票策略”去決定最終結(jié)果。例如3個網(wǎng)絡(luò)判斷結(jié)果為數(shù)字9,那么很有可能真正的結(jié)果就是數(shù)字9,其它兩個網(wǎng)絡(luò)給出了錯誤結(jié)果。

這種“綜合起來取平均”的策略通常可以有效防止過擬合問題。因?yàn)椴煌木W(wǎng)絡(luò)可能產(chǎn)生不同的過擬合,取平均則有可能讓一些“相反的”擬合互相抵消。dropout掉不同的隱藏神經(jīng)元就類似在訓(xùn)練不同的網(wǎng)絡(luò),隨機(jī)刪掉一半隱藏神經(jīng)元導(dǎo)致網(wǎng)絡(luò)結(jié)構(gòu)已經(jīng)不同,整個dropout過程就相當(dāng)于對很多個不同的神經(jīng)網(wǎng)絡(luò)取平均。而不同的網(wǎng)絡(luò)產(chǎn)生不同的過擬合,一些互為“反向”的擬合相互抵消就可以達(dá)到整體上減少過擬合。

2. 減少神經(jīng)元之間復(fù)雜的共適應(yīng)關(guān)系

因?yàn)閐ropout程序?qū)е聝蓚€神經(jīng)元不一定每次都在一個dropout網(wǎng)絡(luò)中出現(xiàn)。這樣權(quán)值的更新不再依賴于有固定關(guān)系的隱含節(jié)點(diǎn)的共同作用,阻止了某些特征僅僅在其它特定特征下才有效果的情況 。迫使網(wǎng)絡(luò)去學(xué)習(xí)更加魯棒的特征 ,這些特征在其它的神經(jīng)元的隨機(jī)子集中也存在。

換句話說,假如我們的神經(jīng)網(wǎng)絡(luò)是在做出某種預(yù)測,它不應(yīng)該對一些特定的線索片段太過敏感,即使丟失特定的線索,它也應(yīng)該可以從眾多其它線索中學(xué)習(xí)一些共同的特征。從這個角度看dropout就有點(diǎn)像L1,L2正則,減少權(quán)重使得網(wǎng)絡(luò)對丟失特定神經(jīng)元連接的魯棒性提高。

3. Dropout類似于性別在生物進(jìn)化中的角色

物種為了生存往往會傾向于適應(yīng)這種環(huán)境,環(huán)境突變則會導(dǎo)致物種難以做出及時(shí)反應(yīng),性別的出現(xiàn)可以繁衍出適應(yīng)新環(huán)境的變種,有效的阻止過擬合,即避免環(huán)境改變時(shí)物種可能面臨的滅絕。

參考鏈接:https://zhuanlan.zhihu.com/p/38200980

Q8

Dropout在訓(xùn)練和測試時(shí)都需要嗎?

Dropout在訓(xùn)練時(shí)采用,是為了減少神經(jīng)元對部分上層神經(jīng)元的依賴,類似將多個不同網(wǎng)絡(luò)結(jié)構(gòu)的模型集成起來,減少過擬合的風(fēng)險(xiǎn)。而在測試時(shí),應(yīng)該用整個訓(xùn)練好的模型,因此不需要dropout。

Q9

Dropout如何平衡訓(xùn)練和測試時(shí)的差異呢?

Dropout 在訓(xùn)練時(shí)以一定的概率使神經(jīng)元失活,實(shí)際上就是讓對應(yīng)神經(jīng)元的輸出為0。假設(shè)失活概率為 p ,就是這一層中的每個神經(jīng)元都有p的概率失活。

例如在三層網(wǎng)絡(luò)結(jié)構(gòu)中,如果失活概率為0.5,則平均每一次訓(xùn)練有3個神經(jīng)元失活,所以輸出層每個神經(jīng)元只有3個輸入,而實(shí)際測試時(shí)是不會有dropout的,輸出層每個神經(jīng)元都有6個輸入。

因此在訓(xùn)練時(shí)還要對第二層的輸出數(shù)據(jù)除以(1-p)之后再傳給輸出層神經(jīng)元,作為神經(jīng)元失活的補(bǔ)償,以使得在訓(xùn)練時(shí)和測試時(shí)每一層輸入有大致相同的期望。

Q10

BN和Dropout共同使用時(shí)會出現(xiàn)的問題是什么?

BN和Dropout單獨(dú)使用都能減少過擬合并加速訓(xùn)練速度,但如果一起使用的話并不會產(chǎn)生1+1>2的效果,相反可能會得到比單獨(dú)使用更差的效果。

參考鏈接:https://www.zhihu.com/tardis/sogou/art/61725100

Q11

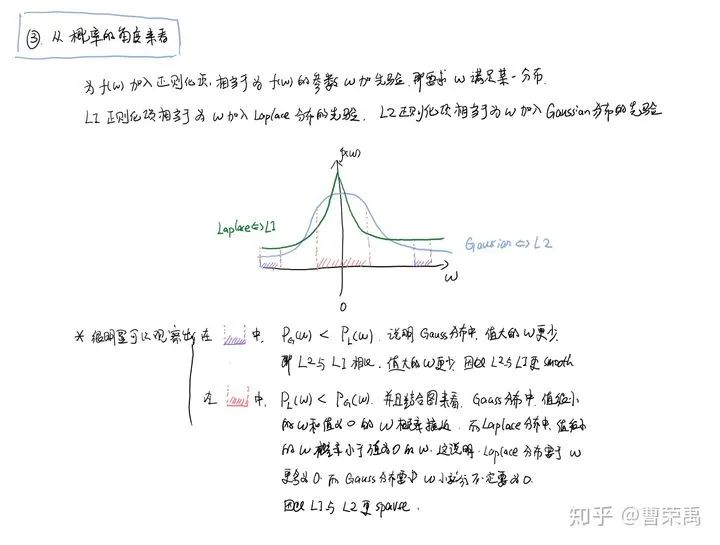

L1 和 L2 正則先驗(yàn)分別服從什么分布?

先驗(yàn)就是優(yōu)化的起跑線, 有先驗(yàn)的好處就是可以在較小的數(shù)據(jù)集中有良好的泛化性能,當(dāng)然這是在先驗(yàn)分布是接近真實(shí)分布的情況下得到的了,從信息論的角度看,向系統(tǒng)加入了正確先驗(yàn)這個信息,肯定會提高系統(tǒng)的性能。

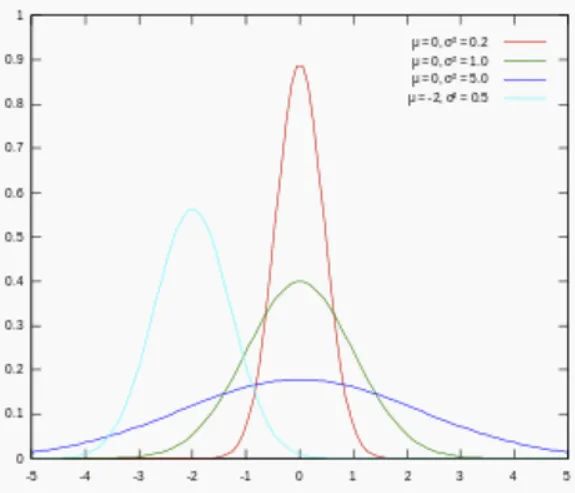

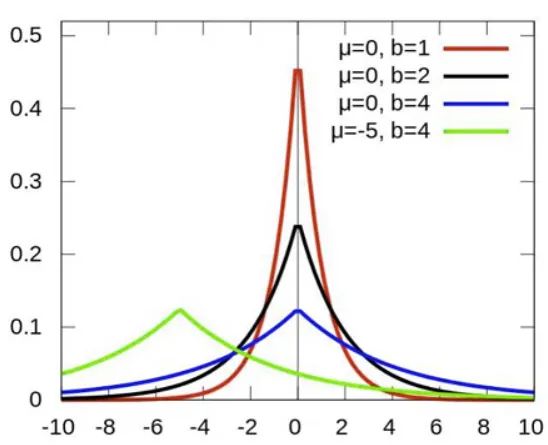

L1 正則先驗(yàn)分布是 Laplace 分布,L2 正則先驗(yàn)分布是 Gaussian 分布。

Laplace 分布公式為:

Gaussian 分布公式為:

對參數(shù)引入高斯正態(tài)先驗(yàn)分布相當(dāng)于L2正則化:

對參數(shù)引入拉普拉斯先驗(yàn)等價(jià)于 L1正則化:

從上面兩圖可以看出, L2先驗(yàn)趨向零周圍, L1先驗(yàn)趨向零本身。

參考鏈接:https://blog.csdn.net/akenseren/article/details/80427471

本文來自Datawhale面經(jīng)項(xiàng)目,致力做一份小而美、及時(shí)更新的大廠面經(jīng)。開源地址:

https://github.com/datawhalechina/Daily-interview

長按關(guān)注Datawhale,更多開源內(nèi)容一起學(xué)習(xí)成長↓