點(diǎn)擊下方卡片,關(guān)注“新機(jī)器視覺”公眾號(hào)

視覺/圖像重磅干貨,第一時(shí)間送達(dá)

本文來源:韋心雕龍

/ 導(dǎo)讀 /

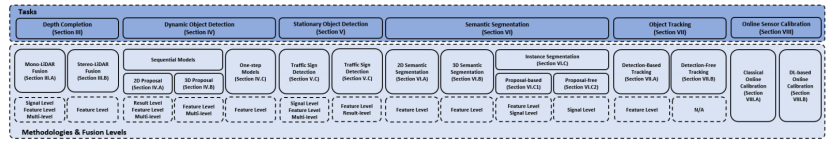

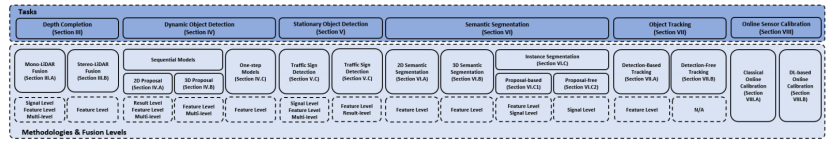

這篇文章總結(jié)了基于圖像和點(diǎn)云基于深度學(xué)習(xí)的數(shù)據(jù)融合方法,包括深度估計(jì)、目標(biāo)檢測(cè)、語義分割、目標(biāo)分割、傳感器在線標(biāo)定等方面的應(yīng)用。這里就來學(xué)習(xí)一下相關(guān)的知識(shí)點(diǎn),下圖就是基于圖像和點(diǎn)云融合的感知任務(wù)及其相關(guān)部分一攬表。

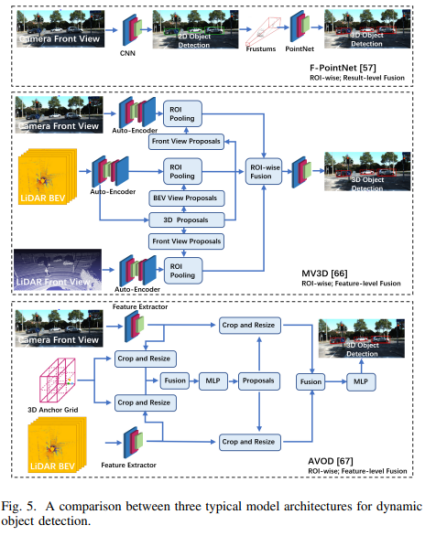

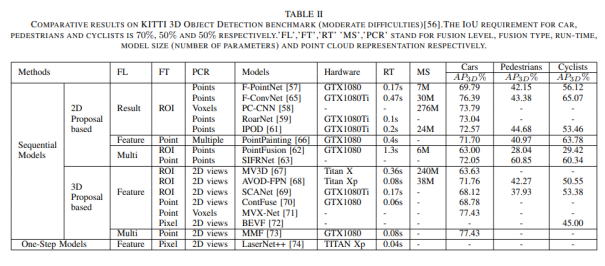

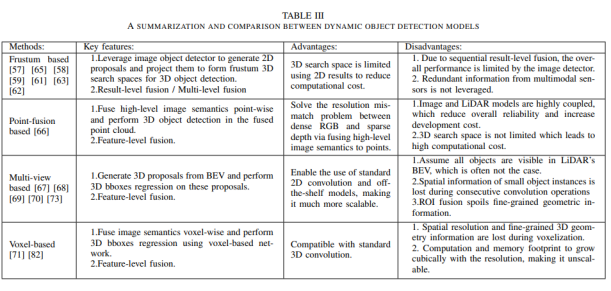

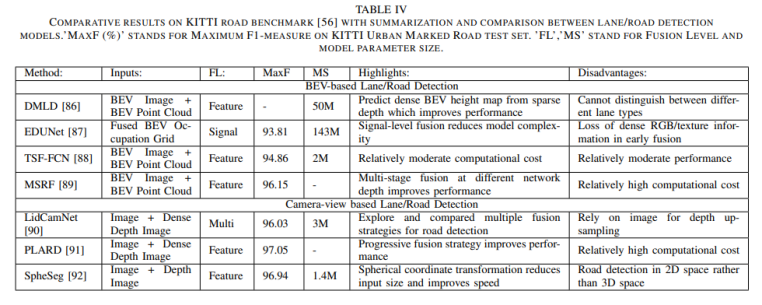

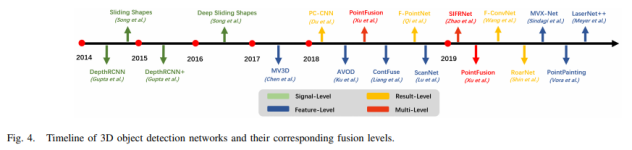

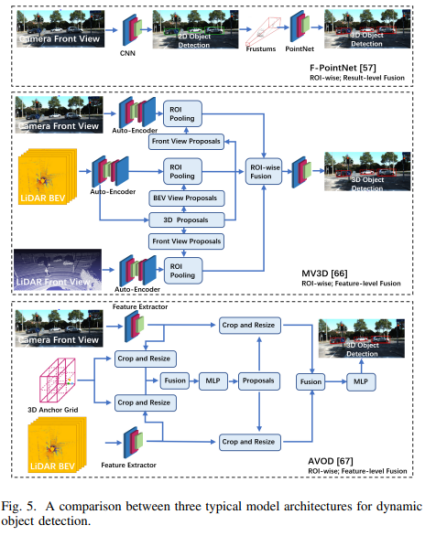

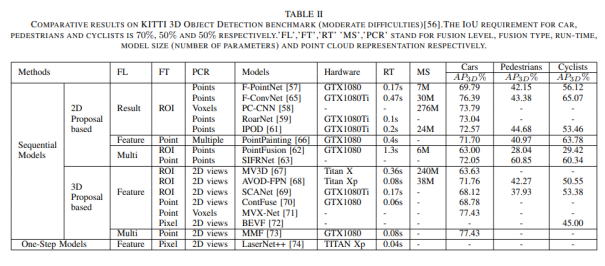

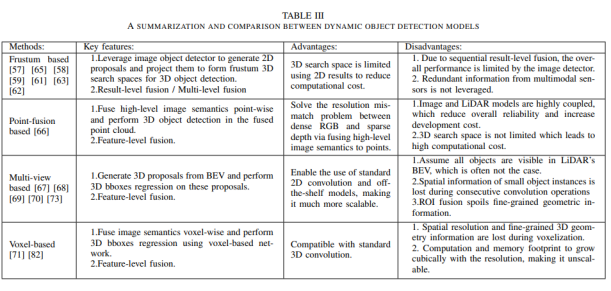

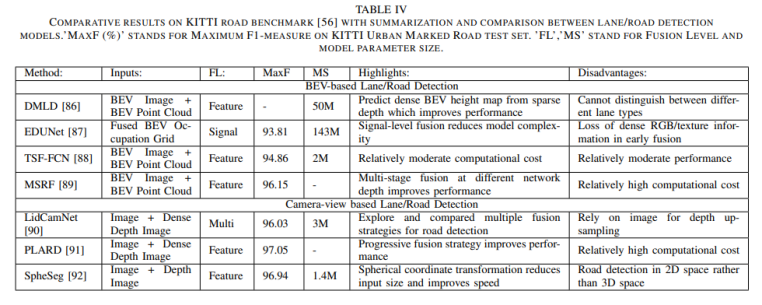

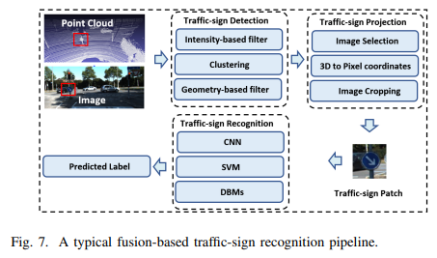

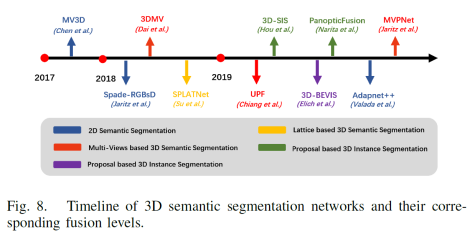

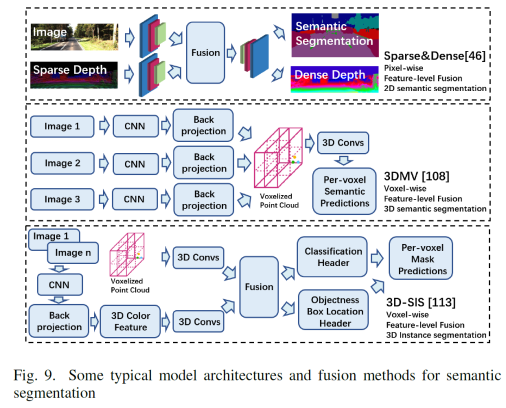

深度學(xué)習(xí)

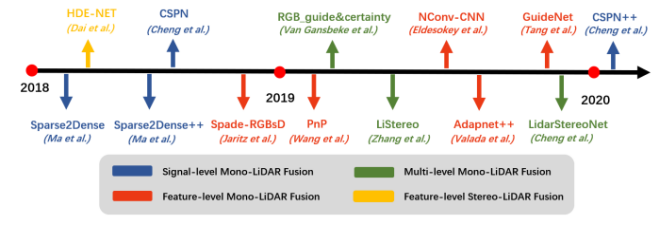

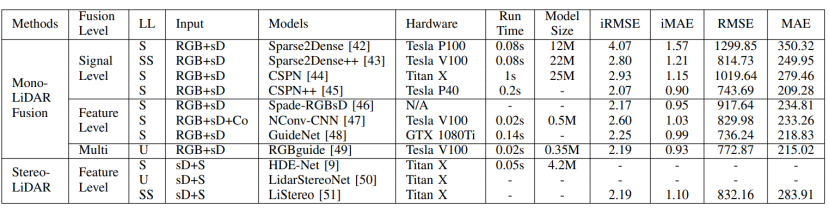

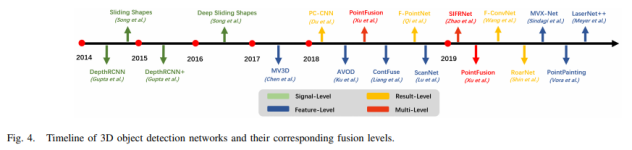

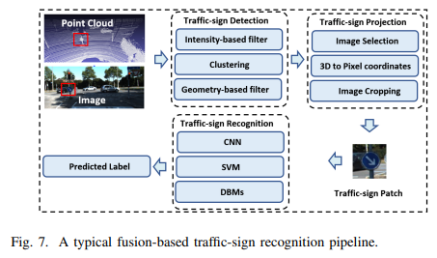

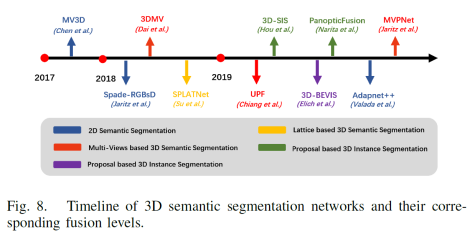

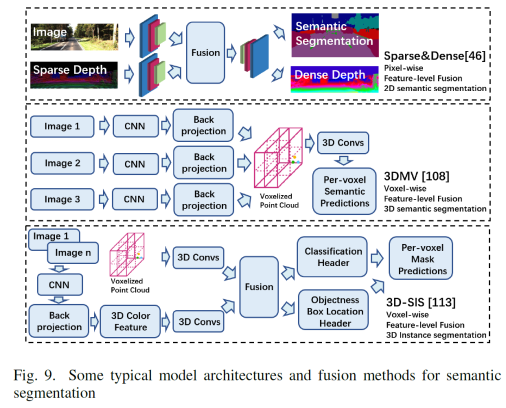

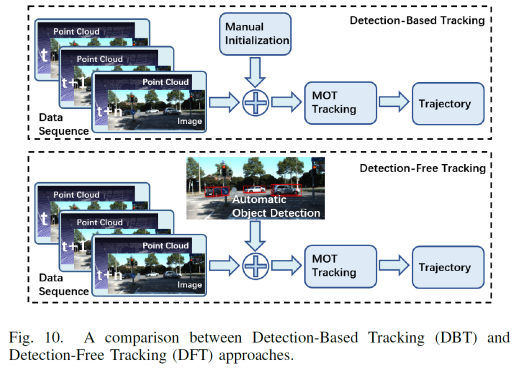

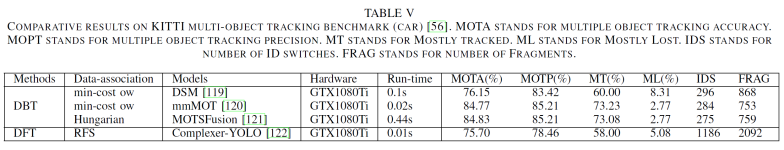

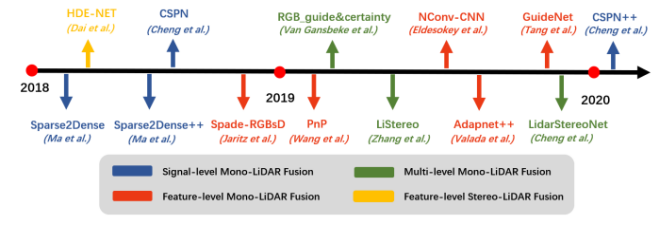

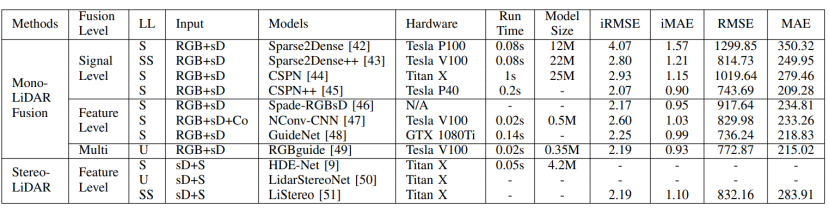

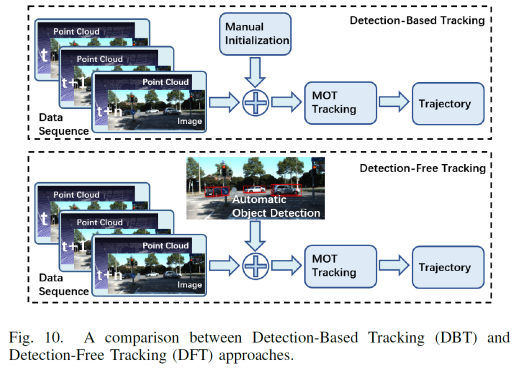

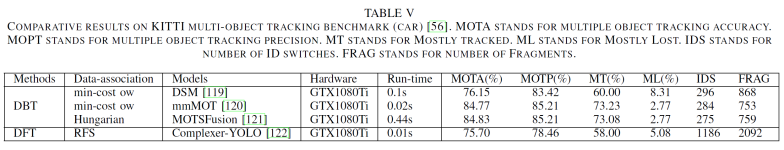

卷積神經(jīng)網(wǎng)絡(luò)(CNNs)是目前(2020年,因?yàn)?021年VIT大火)對(duì)圖像理解和處理的最有效的模型之一。與MLP相比,CNN具有平移不變性,利用較少的權(quán)重和層次模式(卷積層、BN層、relu層、pooling層),可以以抽象的層次和學(xué)習(xí)能力完成對(duì)圖像特征的提取和高階語義的學(xué)習(xí)。b)基于點(diǎn)云的深度學(xué)習(xí)方法對(duì)于點(diǎn)云的方法,有很多種類型,如b1)Volumetric representation based,即將點(diǎn)云按照固定的分辨率組成三維網(wǎng)格,每個(gè)網(wǎng)格的特征都是學(xué)出來的;這種方法可以很輕松的獲取到網(wǎng)格內(nèi)部結(jié)構(gòu),但在體素化過程中,失去了空間分辨率和細(xì)粒度的三維幾何形狀;b2)Index/Tree representation based,是將點(diǎn)云劃分為一系列不平衡的樹,可以根據(jù)區(qū)域的點(diǎn)密度進(jìn)行分區(qū),對(duì)于點(diǎn)密度較低的區(qū)域具有較低的分辨率,從而減少不必要的內(nèi)存和計(jì)算資源;b3)2D views representation based,這種方式比較好理解,就是將點(diǎn)云按照不同的視圖投影成深度圖,然后利用CNN對(duì)圖像進(jìn)行檢測(cè);b4)Graph representation based,這種就是將點(diǎn)云表示為圖,在空間或者光譜域上實(shí)現(xiàn)卷積操作。(這種吧,不太好評(píng)價(jià))b5)Point representation based,這種直接適用點(diǎn)云,而不是將其轉(zhuǎn)換為中間數(shù)據(jù)進(jìn)行表示。這個(gè)也是目前點(diǎn)云深度學(xué)習(xí)的最流行的方式。如點(diǎn)網(wǎng)方法(PointNet,PointNet++,RandLA-Net等),點(diǎn)卷積是直接表征點(diǎn)之間的空間關(guān)系,其目的是將標(biāo)準(zhǔn)的二維離散卷積推廣到三維連續(xù)空間中,即用連續(xù)權(quán)重函數(shù)替代離散權(quán)重函數(shù),如PointConv、KPConv等。所謂深度估計(jì),就是將稀疏的點(diǎn)云通過上采樣方法生成稠密有規(guī)則地深度信息,這樣生成的點(diǎn)云方便后續(xù)感知模塊的應(yīng)用,也能夠改善激光雷達(dá)掃描得到點(diǎn)云的不均勻分布。直接給出最近的深度估計(jì)發(fā)展歷程和相關(guān)方法:不管哪種方法,其核心就是將圖像的RGB信息與點(diǎn)云的3D幾何信息相結(jié)合,從而使得圖像RGB信息包含相關(guān)的3D幾何信息。所以,圖像可以作為深度采樣的參考信息。從上面的方法可以看出,其包含Mono-Lidar融合方法和Stereo-Lidar融合方法。Mono Camera and LiDAR fusionMono-Lidar包含信號(hào)級(jí)、特征級(jí)、以及多層次融合:其中信號(hào)級(jí)就是將點(diǎn)云深度圖與圖像結(jié)合,形成RGBD圖像,然后將RGBD圖像送入網(wǎng)絡(luò)中。這種適配的網(wǎng)絡(luò)有很多種,如Sparse-to-dense(基于ResNet的自動(dòng)編碼網(wǎng)絡(luò),但是真值比較難獲取)、Self-supervised sparse-to-dense(Sparse-to-dense的改進(jìn),但只對(duì)靜止物體有效,且輸出的深度模糊)、CSPN(卷積空間網(wǎng)絡(luò),可以直接提取與圖像相關(guān)的affinity 矩陣)、 CSPN++(CSPN改進(jìn)版,可以動(dòng)態(tài)調(diào)整卷積核大小)。特征級(jí)融合就是分別將稀疏深度圖和點(diǎn)云送入網(wǎng)絡(luò)中,完成特征的提取,如:《Depth completion and semantic segmentation》(就是將圖像和稀疏深度圖先由NASNet進(jìn)行編碼處理,然后融合到共享解碼器中,獲得良好的深度效果)、Plug-and-Play(利用Pnp從稀疏深度圖中計(jì)算梯度并更新現(xiàn)有深度圖信息)、《Confidence propagation through cnns for guided sparse depth regression》(并行處理圖像與稀疏深度映射,并歸一化卷積來處理高度稀疏的深度和置信度)、《Self-supervised model adaptation for multimodal semantic segmentation》(將前面提到的單節(jié)段擴(kuò)展到網(wǎng)絡(luò)不同深度的多階段)、GuideNet(將圖像特征與不同層次的稀疏深度特征在編碼其中進(jìn)行融合,缺乏有效的gt)。多層次融合就是把前兩個(gè)做了一個(gè)融合。《“Sparse and noisy lidar completion with rgb guidance and uncertainty》(對(duì)RGBD數(shù)據(jù)和深度數(shù)據(jù)同時(shí)進(jìn)行處理,然后根據(jù)置信圖進(jìn)行融合)。Stereo Cameras and LiDAR fusion這種方法相對(duì)于Mono,就是利用stereo相機(jī)之間的視差獲取圖像的深度值,然后結(jié)合稀疏的點(diǎn)云深度信息產(chǎn)生更精確的密集深度。如《“High-precision depth estimation using uncalibrated lidar and stereo fusion》(兩階段CNN,第一階段采用激光雷達(dá)與Stereo的視差獲取融合視差,第二階段將融合視差與左RGB圖像融合在特征空間中,以預(yù)測(cè)最終的高精度視差,然后再進(jìn)行三維重建)、《Noise-aware unsupervised deep lidar-stereo fusion》(不需要gt,直接適用圖像、點(diǎn)云自身的損失進(jìn)行端到端訓(xùn)練,好處就是不太關(guān)注于點(diǎn)云與圖像之間的對(duì)齊信息)、類似的還有《Listereo: Generate dense depth maps from lidar and stereo imagery 》,但是不管哪種,由于stereo本身的局限性(基線、遮擋、紋理等),所以不太考慮用在自動(dòng)駕駛中。目標(biāo)檢測(cè)(3D)的目標(biāo)是在三維空間中定位、分類和估計(jì)有方向的邊界框。自動(dòng)駕駛動(dòng)態(tài)目標(biāo)檢測(cè),類別包括常見的動(dòng)態(tài)道路對(duì)象(汽車、行人、騎車人等),方法主要有兩種:順序檢測(cè)和單步檢測(cè)。基于序列的模型按時(shí)間順序由預(yù)測(cè)階段和三維邊界框(bbox)回歸階段組成。在預(yù)測(cè)階段,提出可能包含感興趣對(duì)象的區(qū)域。在bbox回歸階段,基于從三維幾何中提取的區(qū)域特征對(duì)這些建議進(jìn)行分類。然而,序列融合的性能受到各個(gè)階段的限制。另一方面,一步模型由一個(gè)階段組成,其中二維和三維數(shù)據(jù)以并行方式處理。下面兩幅圖,給出了3D檢測(cè)網(wǎng)絡(luò)的時(shí)間線和經(jīng)典網(wǎng)絡(luò)架構(gòu)圖。下面兩張表給出了在KITTI上3D檢測(cè)的對(duì)比結(jié)果以及動(dòng)態(tài)檢測(cè)模型。所謂基于2D的序列模型,就是首先對(duì)圖片進(jìn)行2D檢測(cè)/分割,生成ROI區(qū)域,然后將ROI投影到3D空間中(將圖像上的邊界框投影到點(diǎn)云上,形成三維ROI空間;將點(diǎn)云投影到圖像平面上,形成帶有點(diǎn)向的2D語義點(diǎn)云)。結(jié)果級(jí):就是將2D的ROI來限制點(diǎn)云的搜索空間,這樣可以顯著減少計(jì)算量,提高運(yùn)行時(shí)間。如FPointNes《Frustum pointnets for 3d object detection from rgb-d data》(將圖像生成的2D邊界框投影到3D空間中,然后將產(chǎn)生的投影送入到PointNet中進(jìn)行3D檢測(cè))、《A general pipeline for 3d detection of vehicles》(利用基于模型擬合的方法過濾掉不必要的背景點(diǎn),然后將過濾后的點(diǎn)送入網(wǎng)絡(luò)中進(jìn)行回歸)、RoarNet(利用《3d bounding box estimation using deep learning and geometry》將每個(gè)2Dbbox生成多個(gè)3D圓柱,然后利用PointNet的head去進(jìn)行處理,并最終細(xì)化)。上述方法都需要假設(shè)每個(gè)ROI區(qū)域內(nèi)只包含一個(gè)感興趣的對(duì)象,對(duì)于擁擠的場(chǎng)景或者行人等不太適用。所以需要有改進(jìn)版。解決方案就是用二維語義分割和region-wise seed proposal with point-wise seed proposals替代2D檢測(cè)器,如IPOD就是類似的方法,首先采用二維語義分割來過濾出背景點(diǎn),留下的前景點(diǎn)云保留了上下文信息和細(xì)粒度的位置,然后送入到PointNet++中用于特征提取和bbox的預(yù)測(cè),這里提出了PointsIoU來加速訓(xùn)練和推理。特征融合:最直觀的就是將點(diǎn)云投影到圖像上,然后利用圖像處理方法進(jìn)行特征提取,但輸出也是圖像級(jí),對(duì)于3D空間的定位不是很準(zhǔn)確。如DepthRCNN就是一種基于RCNN的二維對(duì)象檢測(cè)、實(shí)例和語義分割架構(gòu)。《Cross modal distillation for supervision transfer》則是在圖像數(shù)據(jù)和深度圖像之間做遷移,當(dāng)然還有其他,這一塊后續(xù)會(huì)專門介紹。多級(jí)融合,這個(gè)其實(shí)是結(jié)果級(jí)融合與特征級(jí)融合的結(jié)合,主要工作可以歸結(jié)為點(diǎn)融合(Pointfusion),點(diǎn)融合首先利用現(xiàn)有的2D檢測(cè)模型生成2D bbox,然后用于通過向圖像平面的投影點(diǎn)來定位通過方框的點(diǎn),最后采用一個(gè)ResNet和一個(gè)PointNet結(jié)合的網(wǎng)絡(luò)將點(diǎn)云與圖像特征結(jié)合來估計(jì)3D目標(biāo)。類似的方案還很多,如SIFRNet、Pointsift。略(個(gè)人對(duì)這一塊很感興趣,會(huì)專門對(duì)提到的文章進(jìn)行閱讀,見諒)。Stationary Road Object Detection靜止物體檢測(cè),其實(shí)對(duì)在線校準(zhǔn)起到很大的作用。固定的道路物體包括路面、道路標(biāo)記、交通標(biāo)識(shí)牌等。道路/車道檢測(cè),有很多方法,這里專門介紹一下基于深度學(xué)習(xí)的融合策略。可以分為基于BEV的方法或者基于前視圖的方法。《Deep multi-sensor lane detection》利用CNN從點(diǎn)云中預(yù)測(cè)密集的BEV高度估計(jì),然后與BEV圖像融合,以進(jìn)行精確的車道檢測(cè),但這種方法無法區(qū)分不同的車道類型。類似的還有《A novel approach for detecting road based on two-stream fusion fully convolutional network》。另外還有一種多階段融合策略(MSRF)方法, 結(jié)合了不同網(wǎng)絡(luò)層次的圖像深度特征,顯著提高了其性能,但也增加了計(jì)算成本。《Early fusion of camera and lidar for robust road detection based on u-net fcn》使用信號(hào)級(jí)融合生成一個(gè)融合的BEV特征,并基于UNet來進(jìn)行道路分割,但這種方法容易導(dǎo)致密集紋理信息的丟失。基于前視圖的方法主要講激光雷達(dá)深度投影到前視圖平面上,以提取路面,這類方法在3D投影2D時(shí)存在精度損失,方法有:《Lidarcamera fusion for road detection using fully convolutional neural networks》、《Progressive lidar adaptation for road detection》、《Fast road detection by cnn-based camera-lidar fusion and spherical coordinate transformation》。交通標(biāo)志牌檢測(cè),這種方法太多了,主要是因?yàn)榻煌?biāo)識(shí)牌具有較高的反射特性,但缺乏密集的紋理,而圖像則可以很好的對(duì)其進(jìn)行分類,所以都是講相機(jī)與點(diǎn)云進(jìn)行結(jié)合,即利用了圖像的紋理信息,也利用了標(biāo)識(shí)牌對(duì)點(diǎn)云的高反射特性,形成一個(gè)帶有色彩的點(diǎn)云。前面已經(jīng)有了基于檢測(cè)的融合方法,這里還有基于分割的融合方法,旨在預(yù)測(cè)每個(gè)像素與每個(gè)點(diǎn)的類標(biāo)簽。下面兩幅圖給出了3D語義分割和典型模型架構(gòu)的時(shí)間線。2D語義分割方法有很多種,大多是將點(diǎn)云深度圖和圖像進(jìn)行特征提取,然后利用圖像與深度的2D語義分割和深度完成,如《Sparse and dense data with cnns : Depth completion and semantic segmentation》。當(dāng)然也有不同的方法進(jìn)行特征提取和融合,如《Self-supervised model adaptation for multi modal semantic segmentation》采用了不同深度的多階段特征級(jí)融合,以促進(jìn)語義分割。《Lidarcamera fusion for road detection using fully convolutional neural networks》則是利用上采樣的深度圖像和圖像進(jìn)行2D語義分割。《Pedestrian detection combining rgb and dense lidar data》則是對(duì)rgb和稠密點(diǎn)云進(jìn)行上采樣并分別進(jìn)行CNN特征提取,在最終的卷積層融合兩個(gè)特征圖。3D語義分割,根據(jù)對(duì)點(diǎn)云的處理方法,可以分為不同的方法,如:基于點(diǎn)云體素的3DMV(從多個(gè)對(duì)齊的圖像中提取2D特征,然后投影到3D空間內(nèi),并與3D幾何圖像融合,并最終輸入到3DCNN中進(jìn)行語義預(yù)測(cè)),為了減輕點(diǎn)云體素化引起的問題,還有UPF(該方法利用語義分割網(wǎng)絡(luò)提取渲染的多視圖圖像的特征,并投影到三維空間進(jìn)行點(diǎn)特征融合,其中點(diǎn)云由兩個(gè)基于PointNet++的編碼器進(jìn)行處理,提取局部和全局特征,然后進(jìn)行點(diǎn)的語義標(biāo)簽預(yù)測(cè))、MVPNet(可以理解為融合了多視圖圖像語義和三維幾何圖形來預(yù)測(cè)每點(diǎn)的語義標(biāo)簽)等。SPLATNet是一種多模態(tài)數(shù)據(jù)融合的方法,主要采用稀疏雙邊卷積來實(shí)現(xiàn)空間感知表示學(xué)習(xí)和多模態(tài)(圖像和點(diǎn)云)推理。(個(gè)人覺得這篇文章的思路比較獨(dú)特,后面會(huì)專門解讀)。實(shí)例分割本質(zhì)上是語義分割和目標(biāo)檢測(cè)的聯(lián)合。用于區(qū)分類中的單個(gè)實(shí)例來擴(kuò)展語義分割任務(wù)。實(shí)例分割包括Proposal-based和Proposal-free-based兩種。Proposal-based包括3D-SIS(基于ENet對(duì)多視圖提取特征,和下采樣,實(shí)現(xiàn)解決高分辨率圖像特征與低分辨率像素化點(diǎn)云特征圖不匹配問題的RGB-D體素實(shí)例分割的3DCNN網(wǎng)絡(luò))和Panoptic-fusion(以RGB和深度圖作為輸入,然后通過關(guān)聯(lián)和積分方法跟蹤幀之間的標(biāo)簽,并適用CRF來進(jìn)行深度和語義分割,但這種方法不適合動(dòng)態(tài)場(chǎng)景)。Proposal-free-based代表性的為3DBEVIS,該方法主要是適用2D語義信息點(diǎn)在聚類方法上聯(lián)合執(zhí)行3D語義和實(shí)例分割任務(wù)。具體如下圖:談到融合,不得不提跟蹤,而目標(biāo)跟蹤,是基于歷史幀數(shù)據(jù)信息對(duì)目標(biāo)障礙物的長(zhǎng)期監(jiān)測(cè)。在實(shí)際應(yīng)用中,MOT是很常見的場(chǎng)景,而MOT算法又可以分為基于檢測(cè)的跟蹤(DBT)和不基于檢測(cè)的跟蹤(DFT)。DBT:其實(shí)就是逐幀進(jìn)行檢測(cè),然后通過數(shù)據(jù)關(guān)聯(lián)或者多個(gè)假設(shè)來進(jìn)行對(duì)象跟蹤。這種類型的算法也是目前最流行,最容易出成果的。主要包括兩部分:檢測(cè)目標(biāo),將目標(biāo)進(jìn)行關(guān)聯(lián)。比較常用的方法包括《End-to-end learning of multi-sensor 3d tracking by detection》(該方法同時(shí)檢測(cè)圖像和點(diǎn)云,然后通過深度結(jié)構(gòu)化模型DSM對(duì)連續(xù)幀的目標(biāo)進(jìn)行匹配和優(yōu)化),《Robust multi-modality multi-object tracking》(該方法包括檢測(cè)、相鄰幀估計(jì)以及在線優(yōu)化等,在檢測(cè)階段使用VGG16和PointNet進(jìn)行圖像和點(diǎn)云的特征提取,然后使用(A模型+多模態(tài))魯棒融合模塊進(jìn)行融合,然后通過adjacent matrix learning 將adjacency estimation擴(kuò)展到多模態(tài),并求min-cost flow,從而計(jì)算出一個(gè)最優(yōu)的路徑。另外,跟蹤和三維重建也可以同時(shí)進(jìn)行。《Track to reconstruct and reconstruct to track》就是這么一種方法,其利用三維重建來進(jìn)行跟蹤,使跟蹤對(duì)遮擋有很好的魯棒性。當(dāng)然,MOTSFusion也可以將lidar、mono和stereo depth進(jìn)行融合。DFT:主要是基于 finite-setstatistics(FISST,這個(gè)在NLP或者情感分析中用的比較多)進(jìn)行狀態(tài)估計(jì),常見的方法包括多目標(biāo)多伯努利(MeMBer)濾波器和概率假設(shè)密度(PHD)濾波器。比較經(jīng)典的如Complexer-yolo就是將圖像和點(diǎn)云數(shù)據(jù)進(jìn)行解耦,然后進(jìn)行3D檢測(cè)和跟蹤的實(shí)時(shí)框架,該方法采用了尺度-旋轉(zhuǎn)-轉(zhuǎn)換分?jǐn)?shù)(SRTS)的度量來取代IOU,并評(píng)估bbox位置的3個(gè)自由度。當(dāng)然,該方法最終通過帶有標(biāo)記的伯努利隨機(jī)有限集濾波器(LMBRFS)來實(shí)現(xiàn)推理過程。Online Cross-Sensor Calibration所謂的在線cross-sensor calibration,就是將激光雷達(dá)與相機(jī)之間進(jìn)行在線校準(zhǔn),也就是所謂的空間同步,由于機(jī)械本身的振動(dòng),傳感器之間的外參不斷地變化,這會(huì)導(dǎo)致融合算法的性能和可靠性。所以online cross-sensor calibration的意義重大。經(jīng)典的在線校正,更多的是利用自然環(huán)境進(jìn)行校準(zhǔn)。如《Cross-calibration of push-broom 2d lidars and cameras in natural scenes》、《Automatic calibration of lidar and camera images using normalized mutual information》、《Automatic extrinsic calibration of vision and lidar by maximizing mutual information》、《Hybrid online mobile laser scanner calibration through image alignment by mutual information》是基于最大化不同模式之間的相互信息(原始強(qiáng)度值或邊緣強(qiáng)度)發(fā)現(xiàn)外在的信息,但基于Mi的方法對(duì)紋理變化、傳感器抖動(dòng)不是很友好。而《Visual odometry driven online calibration for monocular lidar-camera systems》采用相機(jī)的自身運(yùn)動(dòng)估計(jì)來評(píng)估相機(jī)與激光雷達(dá)的外參,這話方法計(jì)算量較大,無法實(shí)時(shí)運(yùn)行。基于DL的在線校準(zhǔn),主要是為了解決傳統(tǒng)方法實(shí)時(shí)性不好的情況,RegNet就是一個(gè)實(shí)時(shí)的用于估計(jì)外參的網(wǎng)絡(luò),它是在兩個(gè)平行分支中提取圖像和深度特征,然后將它們連接起來生成融合特征圖,然后將該特征圖送入到一個(gè)NiN加2個(gè)FC的網(wǎng)絡(luò)中,進(jìn)行特征匹配和全局回歸。但RegNet對(duì)傳感器的固有參數(shù)敏感,如果內(nèi)參發(fā)生了變化,就需要重新訓(xùn)練。為了是模型對(duì)傳感器不內(nèi)參不敏感,Calibnet采用幾何自監(jiān)督的方法,將點(diǎn)云與單目圖像以及相機(jī)外參矩陣K輸入到網(wǎng)絡(luò)中,然后實(shí)現(xiàn)3D點(diǎn)云與2D圖像之間6自由度剛體轉(zhuǎn)換,有效的降低了校準(zhǔn)的工作量。但基于深度學(xué)習(xí)的校驗(yàn)方法,計(jì)算量比較大,計(jì)算資源消耗較多。目前已經(jīng)有越來越多的研究在關(guān)注于關(guān)于點(diǎn)云和圖像的融合,除了融合方法外,也需要考慮激光雷達(dá)與相機(jī)之間的時(shí)空同步,尤其是兩者之間的rotation的變化。而且不光要考慮點(diǎn)云和圖像之間的關(guān)系,還需要加入IMU信息或者HD信息,來更準(zhǔn)確的檢測(cè)所關(guān)注的障礙物。另外,文章中的某些論文或章節(jié),個(gè)人比較感興趣,會(huì)詳細(xì)閱讀和整理。所以這里沒有貼出來。—版權(quán)聲明—

僅用于學(xué)術(shù)分享,版權(quán)屬于原作者。

若有侵權(quán),請(qǐng)聯(lián)系微信號(hào):yiyang-sy 刪除或修改!

下載APP

下載APP