綜述 | 激光與視覺融合SLAM

點(diǎn)擊上方“小白學(xué)視覺”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時(shí)間送達(dá)

激光雷達(dá)和視覺SLAM系統(tǒng) 說到激光雷達(dá)和視覺SLAM系統(tǒng),必不可少的是兩者之間的標(biāo)定工作。

多傳感器校準(zhǔn)

Camera&IMU:Kalibr[1]是一個(gè)工具箱,解決了以下幾種傳感器的校準(zhǔn):

多攝像機(jī)校準(zhǔn)。

視覺慣性校準(zhǔn)(Camera IMU)。

卷簾快門式攝像機(jī)校準(zhǔn)。

Vins融合了視覺與IMU,具有在線空間校準(zhǔn)和在線時(shí)間校準(zhǔn)的功能。

MSCKF-VIO具有攝像機(jī)和IMU的校準(zhǔn)功能。

mc-VINS[2]可以校準(zhǔn)所有多個(gè)攝像機(jī)和IMU之間的外部參數(shù)和時(shí)間偏移。

IMU-TK[3][4]還可以對IMU的內(nèi)部參數(shù)進(jìn)行校準(zhǔn)。

論文[5]提出了一種用于單目VIO的端到端網(wǎng)絡(luò),融合了來自攝像機(jī)和IMU的數(shù)據(jù)。

單目與深度相機(jī)

BAD SLAM[6]提出了一個(gè)使用同步全局快門RGB和深度相機(jī)的校準(zhǔn)基準(zhǔn)。

?相機(jī)和相機(jī):mcptam[7]是一個(gè)使用多攝像機(jī)的SLAM系統(tǒng)。它還可以校準(zhǔn)內(nèi)、外參數(shù)。

MultiCol SLAM[8]是一個(gè)multifisheye相機(jī)SLAM。此外,最新版本的SVO還可以支持多個(gè)攝像頭。

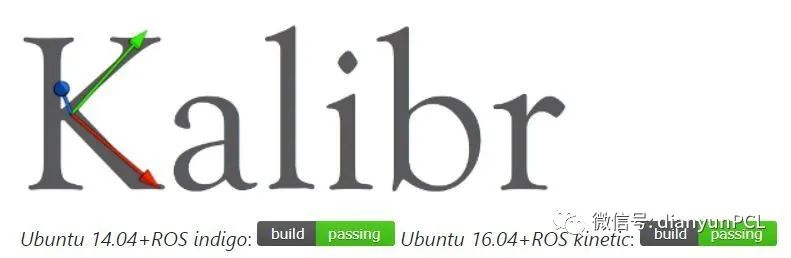

?Lidar& IMU: LIO-mapping [9]引入了一種緊密耦合的Lidar-IMU融合方法。激光雷達(dá)與IMU的對準(zhǔn)是一種在三維空間中激光雷達(dá)和六自由度姿態(tài)傳感器之間尋找外部校準(zhǔn)的方法。激光雷達(dá)的外部定標(biāo)見[10][11]。博士論文[12]闡述了激光雷達(dá)校準(zhǔn)的工作。

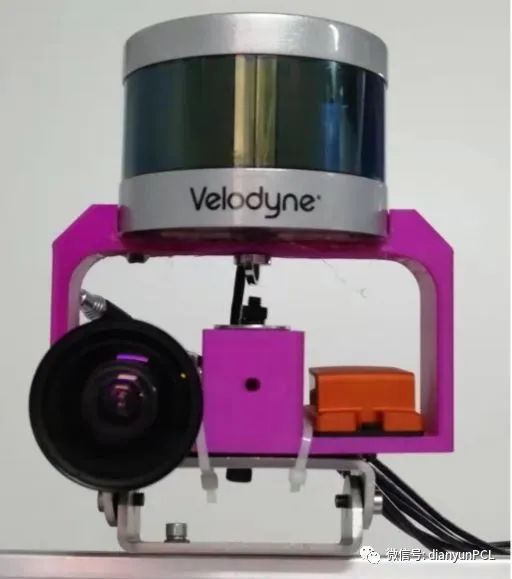

?Camera&Lidar:論文[13]介紹了一種概率監(jiān)測算法和一個(gè)連續(xù)校準(zhǔn)優(yōu)化器,使攝像機(jī)和激光雷達(dá)的校準(zhǔn)能夠在線、自動地進(jìn)行。

Lidar-Camera [14]提出了一種新的流程和實(shí)驗(yàn)裝置,用于尋找精確的剛體變換,以利用3D-3D點(diǎn)對應(yīng)對來Lidar和相機(jī)進(jìn)行外部校準(zhǔn)。

RegNet[15]是第一個(gè)利用掃描激光雷達(dá)和單目相機(jī)推斷多模態(tài)傳感器之間6自由度(DOF)外部校準(zhǔn)的深卷積神經(jīng)網(wǎng)絡(luò)(CNN)。

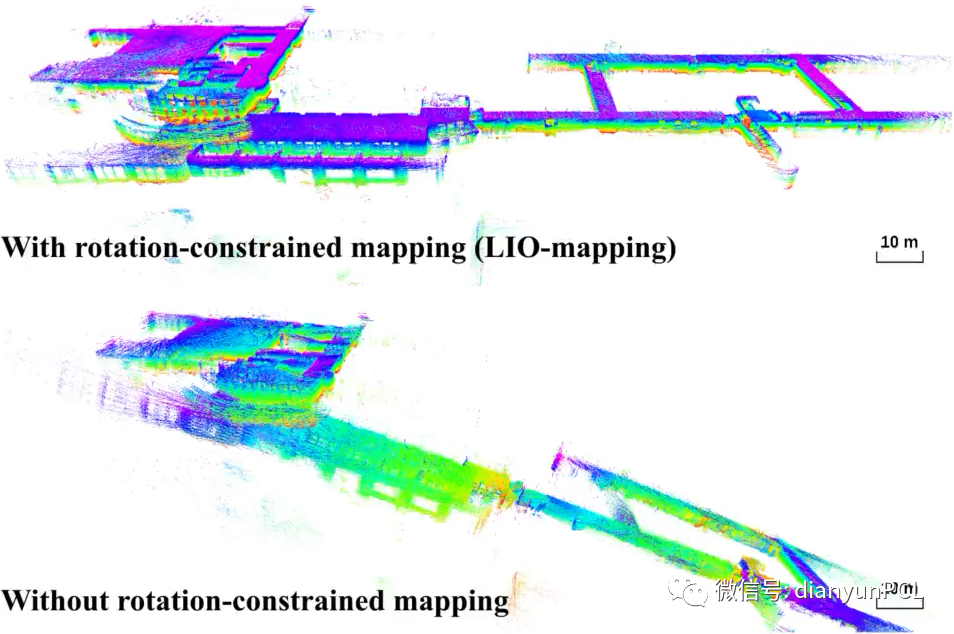

LIMO[16]提出了一種基于LIDAR測量的深度提取算法,用于攝像機(jī)特征軌跡的提取和運(yùn)動估計(jì)。CalibNet[17]是一個(gè)自監(jiān)督的深網(wǎng)絡(luò),能夠?qū)崟r(shí)自動估計(jì)三維激光雷達(dá)和二維相機(jī)之間的六自由度剛體變換。Autoware也可以用于激光雷達(dá)和攝像機(jī)的校準(zhǔn)工作。

激光雷達(dá)與視覺融合

硬件層:比如Pandora是一款集40線激光雷達(dá)、相機(jī)和識別算法于一體的軟硬件解決方案。集成的解決方案可以使開發(fā)人員從時(shí)間同步中得到舒適的體驗(yàn)。專心于算法的開發(fā)。

數(shù)據(jù)層:激光雷達(dá)具有稀疏、高精度的深度數(shù)據(jù),相機(jī)具有密集但低精度的深度數(shù)據(jù),兩者的融合可以完成對圖像中像素的深度值得修復(fù).論文[18]僅依賴基本圖像處理操作完成了稀疏激光雷達(dá)深度數(shù)據(jù)與圖像的融合。隨著深度學(xué)習(xí)的深入,[19]提出使用單一的深度回歸網(wǎng)絡(luò)直接從RGB-D原始數(shù)據(jù)中學(xué)習(xí),并探索深度樣本數(shù)量的影響。[20]考慮CNN在稀疏輸入上運(yùn)行,并應(yīng)用稀疏激光掃描數(shù)據(jù)完成深度估計(jì)。

DFuseNet[21]提出了一種CNN,該CNN被設(shè)計(jì)用于基于從高分辨率強(qiáng)度圖像中收集到的上下文線索對一系列稀疏距離測量進(jìn)行上采樣。

LICFusion[22]融合了IMU測量值、稀疏視覺特征和提取的LiDAR點(diǎn)云數(shù)據(jù)。

任務(wù)層:論文[23]是一種基于立體相機(jī)和激光雷達(dá)融合的感知方案。

[24]融合了毫米波雷達(dá)、激光雷達(dá)和相機(jī),以檢測和分類移動物體。

論文[25]通過深度相機(jī)提供的深度信息或者與相機(jī)相關(guān)聯(lián)的激光雷達(dá)深度信息來增強(qiáng)VO。

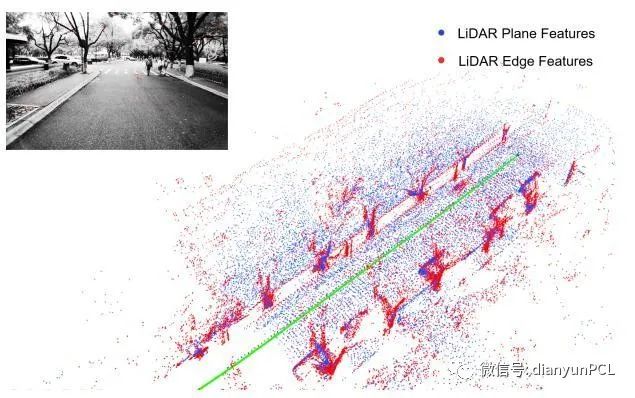

V-Loam[26]提出了視覺里程計(jì)和激光雷達(dá)里程計(jì)相結(jié)合的總體框架。從視覺里程計(jì)和基于掃描匹配的激光雷達(dá)里程計(jì)兩個(gè)方面入手,同時(shí)改進(jìn)了實(shí)時(shí)的運(yùn)動估計(jì)和點(diǎn)云配準(zhǔn)算法性能。

VI-SLAM該系統(tǒng)將精確的激光里程估計(jì)器與使用視覺實(shí)現(xiàn)環(huán)路檢測的位置識別算法相結(jié)合。[27]針對SLAM的跟蹤部分,采用RGB-D相機(jī)和二維低成本激光雷達(dá),通過模式切換和數(shù)據(jù)融合,構(gòu)建穩(wěn)健的室內(nèi)SLAM系統(tǒng)。

VIL-SLAM[28]將緊密耦合的立體聲VIO與激光雷達(dá)映射和激光雷達(dá)增強(qiáng)的視覺環(huán)路閉合結(jié)合在一起。[29]將單目攝像機(jī)圖像與激光距離測量相結(jié)合,以允許視覺沖擊,而不會因尺度不確定性增加而產(chǎn)生誤差。在深度學(xué)習(xí)中,許多方法可以檢測和識別來自攝像機(jī)和激光雷達(dá)的融合數(shù)據(jù),如點(diǎn)融合[30]、RoarNet[31]、AVOD[32]、FuseNet[33]。[34]利用激光雷達(dá)和攝像機(jī),以端到端可學(xué)習(xí)的架構(gòu)完成了非常精確的定位。

融合SLAM的挑戰(zhàn)與未來

數(shù)據(jù)關(guān)聯(lián):未來的SLAM必須是集成多個(gè)傳感器的。但不同的傳感器有不同的數(shù)據(jù)類型、時(shí)間戳和坐標(biāo)系表達(dá)式,需要統(tǒng)一處理。此外,還應(yīng)考慮多傳感器之間的物理模型建立、狀態(tài)估計(jì)和優(yōu)化。

硬件集成:目前還沒有合適的芯片和集成硬件使SLAM技術(shù)更容易成為產(chǎn)品。另一方面,如果傳感器的精度因故障、非標(biāo)稱條件或老化而降低,則傳感器測量的質(zhì)量(例如噪聲、偏差)與噪聲模型不匹配。應(yīng)遵循硬件的穩(wěn)定性和集成性。前端傳感器應(yīng)具備數(shù)據(jù)處理能力,從硬件層到算法層,再到功能層到SDK,再到應(yīng)用層進(jìn)行創(chuàng)新。

眾包:分散式視覺SLAM是一個(gè)強(qiáng)大的工具,用于在絕對定位系統(tǒng)不可用的環(huán)境中的多機(jī)器人應(yīng)用。協(xié)同優(yōu)化視覺多機(jī)器人SLAM需要分散的數(shù)據(jù)和優(yōu)化,稱為眾包。分散數(shù)據(jù)處理過程中的隱私問題應(yīng)引起重視。

高精地圖:高精地圖對機(jī)器人至關(guān)重要。但是哪種類型的地圖最適合機(jī)器人呢?密集地圖或稀疏地圖可以導(dǎo)航、定位和路徑規(guī)劃嗎?對于長期地圖,一個(gè)相關(guān)的開放性問題是多久更新一次地圖中包含的信息,以及如何確定該信息何時(shí)過時(shí)并可以丟棄。

適應(yīng)性、健壯性、可延展性:眾所周知,現(xiàn)在沒有一個(gè)SLAM系統(tǒng)可以覆蓋所有場景。為了在給定的場景中正常工作,其中大部分都需要大量的參數(shù)調(diào)整。為了使機(jī)器人感知為人類,基于外觀而不是基于特征的方法是首選的,這將有助于在晝夜序列之間或不同季節(jié)之間形成與語義信息集成的閉環(huán)。

抗風(fēng)險(xiǎn)和約束能力:完善的SLAM系統(tǒng)應(yīng)具有故障安全性和故障意識。這不是關(guān)于重定位或循環(huán)閉包的問題。SLAM系統(tǒng)必須具有應(yīng)對風(fēng)險(xiǎn)或故障的能力。同時(shí),一個(gè)理想的SLAM解決方案應(yīng)該能夠在不同的平臺上運(yùn)行,而不管平臺的計(jì)算約束是什么。如何在精確性、穩(wěn)定性和有限的資源之間取得平衡是一個(gè)具有挑戰(zhàn)性的問題。

應(yīng)用:SLAM技術(shù)有著廣泛的應(yīng)用,如:大規(guī)模定位、導(dǎo)航和三維或語義地圖構(gòu)建、環(huán)境識別與理解、地面機(jī)器人、無人機(jī)、VR/AR/MR、AGV(自動引導(dǎo)車)、自動駕駛、虛擬室內(nèi)裝飾、虛擬試衣間、沉浸式網(wǎng)絡(luò)游戲等,抗震救災(zāi)、視頻分割與編輯。

參考文獻(xiàn)

好消息!

小白學(xué)視覺知識星球

開始面向外開放啦??????

下載1:OpenCV-Contrib擴(kuò)展模塊中文版教程 在「小白學(xué)視覺」公眾號后臺回復(fù):擴(kuò)展模塊中文教程,即可下載全網(wǎng)第一份OpenCV擴(kuò)展模塊教程中文版,涵蓋擴(kuò)展模塊安裝、SFM算法、立體視覺、目標(biāo)跟蹤、生物視覺、超分辨率處理等二十多章內(nèi)容。 下載2:Python視覺實(shí)戰(zhàn)項(xiàng)目52講 在「小白學(xué)視覺」公眾號后臺回復(fù):Python視覺實(shí)戰(zhàn)項(xiàng)目,即可下載包括圖像分割、口罩檢測、車道線檢測、車輛計(jì)數(shù)、添加眼線、車牌識別、字符識別、情緒檢測、文本內(nèi)容提取、面部識別等31個(gè)視覺實(shí)戰(zhàn)項(xiàng)目,助力快速學(xué)校計(jì)算機(jī)視覺。 下載3:OpenCV實(shí)戰(zhàn)項(xiàng)目20講 在「小白學(xué)視覺」公眾號后臺回復(fù):OpenCV實(shí)戰(zhàn)項(xiàng)目20講,即可下載含有20個(gè)基于OpenCV實(shí)現(xiàn)20個(gè)實(shí)戰(zhàn)項(xiàng)目,實(shí)現(xiàn)OpenCV學(xué)習(xí)進(jìn)階。 交流群

歡迎加入公眾號讀者群一起和同行交流,目前有SLAM、三維視覺、傳感器、自動駕駛、計(jì)算攝影、檢測、分割、識別、醫(yī)學(xué)影像、GAN、算法競賽等微信群(以后會逐漸細(xì)分),請掃描下面微信號加群,備注:”昵稱+學(xué)校/公司+研究方向“,例如:”張三 + 上海交大 + 視覺SLAM“。請按照格式備注,否則不予通過。添加成功后會根據(jù)研究方向邀請進(jìn)入相關(guān)微信群。請勿在群內(nèi)發(fā)送廣告,否則會請出群,謝謝理解~