(附代碼)將目標(biāo)檢測(cè)絕對(duì)精度提升 5%,不犧牲推理速度

目標(biāo)檢測(cè)無(wú)疑是計(jì)算機(jī)視覺領(lǐng)域最前沿的應(yīng)用之一,吸引了各個(gè)領(lǐng)域諸多研究者的目光。最前沿的檢測(cè)器,包括類似 RCNN 的單(SSD 或 YOLO)或多階神經(jīng)網(wǎng)絡(luò)都是基于圖像分類骨干網(wǎng)絡(luò),如 VGG、ResNet、Inception 或 MobileNet 系列。

然而,由于模型容量和訓(xùn)練復(fù)雜度相對(duì)較高,目標(biāo)檢測(cè)受到的關(guān)注相對(duì)較少,從最近的訓(xùn)練微調(diào)研究中獲益也較少。更糟糕的是,不同的檢測(cè)網(wǎng)絡(luò)在沒有明確的初始化、數(shù)據(jù)預(yù)處理及優(yōu)化分析的情況下就開始挑選自己的訓(xùn)練流程,導(dǎo)致在采用最新的技術(shù)改進(jìn)圖像分類任務(wù)時(shí)出現(xiàn)了大量的混亂。

本文的研究者致力于探索能夠在不造成額外計(jì)算成本的情況下有效提升流行的目標(biāo)檢測(cè)網(wǎng)絡(luò)性能的方法。他們首先在目標(biāo)檢測(cè)上探索了一種混合技術(shù)。與《mixup: Beyond Empirical Risk Minimization》不同,本文的研究者認(rèn)識(shí)到了多目標(biāo)檢測(cè)任務(wù)的特殊性質(zhì)有利于實(shí)現(xiàn)空間不變的變換,因此提出了一種用于目標(biāo)檢測(cè)任務(wù)的視覺相干(visually coherent)圖像混合方法。接下來(lái),他們探討了詳細(xì)的訓(xùn)練流程,包括學(xué)習(xí)率調(diào)度、權(quán)重衰減和同步 BatchNorm。最后,他們探索了其訓(xùn)練微調(diào)的有效性,方法是逐漸將這些微調(diào)疊加,以訓(xùn)練單或多階段目標(biāo)檢測(cè)網(wǎng)絡(luò)。

本文的主要貢獻(xiàn)如下:

首次系統(tǒng)地評(píng)估了不同目標(biāo)檢測(cè)流程中應(yīng)用的多種訓(xùn)練啟發(fā)式方法,為未來(lái)的研究提供了有價(jià)值的實(shí)踐指導(dǎo)。

提出了一種為訓(xùn)練目標(biāo)檢測(cè)網(wǎng)絡(luò)而設(shè)計(jì)的視覺相干圖像混合方法,而且證明該方法可以有效提升模型的泛化能力。

在不修改網(wǎng)絡(luò)架構(gòu)和損失函數(shù)的情況下,在現(xiàn)有模型的基礎(chǔ)上實(shí)現(xiàn)了 5% 的絕對(duì)精度性能提升。而且這些提升都是「免費(fèi)的午餐」,無(wú)需額外的推理成本。

擴(kuò)展了目標(biāo)檢測(cè)數(shù)據(jù)增強(qiáng)領(lǐng)域的研究深度,顯著增強(qiáng)了模型的泛化能力,減少了過擬合問題。這些實(shí)驗(yàn)還揭示了可以在不同網(wǎng)絡(luò)架構(gòu)中一致提高目標(biāo)檢測(cè)性能的良好技術(shù)。

所有相關(guān)代碼都是開源的,模型的預(yù)訓(xùn)練權(quán)重可以在 GluonCV Toolkit 中獲取。

Gluon CV Toolkit 鏈接:https://github.com/dmlc/gluon-cv

圖 1:Bag of Freebies 在不犧牲推理速度的前提下,顯著提高了目標(biāo)檢測(cè)器的性能。

論文:Bag of Freebies for Training Object Detection Neural Networks

論文鏈接:https://arxiv.org/pdf/1902.04103.pdf

摘要:與針對(duì)更好的圖像分類模型所取得的巨大研究成就相比,訓(xùn)練目標(biāo)檢測(cè)器的努力在普及性和普遍性方面都存在不足。由于網(wǎng)絡(luò)結(jié)構(gòu)和優(yōu)化目標(biāo)要復(fù)雜得多,針對(duì)特定檢測(cè)算法專門設(shè)計(jì)了不同的訓(xùn)練策略和流程。在本文中,我們探索了通用的微調(diào),這些微調(diào)有助于在不犧牲推理速度的前提下將當(dāng)前最佳的目標(biāo)檢測(cè)模型提高到一個(gè)新水平。我們的實(shí)驗(yàn)表明,這些「freebies」可以提高 5% 的絕對(duì)精度。

3. 技術(shù)細(xì)節(jié)

我們提出了一個(gè)用于目標(biāo)檢測(cè)的視覺相干圖像混合方法,還介紹了為系統(tǒng)提升目標(biāo)檢測(cè)模型性能而設(shè)計(jì)的數(shù)據(jù)處理和訓(xùn)練調(diào)度器。

3.1 用于目標(biāo)檢測(cè)的視覺相干圖像混合

Zhang 等人在《mixup: Beyond Empirical Risk Minimization》中引入的混合概念被證明在分類網(wǎng)絡(luò)中減少對(duì)抗干擾方面非常成功。他們提出的混合算法中混合比例的分布來(lái)自β分布(a = 0.2, b = 0.2)。大多數(shù)的混合幾乎都是這種β分布的噪聲。受到 Rosenfeld 等人啟發(fā)式實(shí)驗(yàn)的激勵(lì),我們關(guān)注自然共現(xiàn)的目標(biāo)呈現(xiàn),這種呈現(xiàn)在目標(biāo)檢測(cè)中扮演重要角色。半對(duì)抗目標(biāo)補(bǔ)丁移植方法不是傳統(tǒng)的攻擊方法。通過應(yīng)用更復(fù)雜的空間變換,我們引入了遮擋,即在自然圖像呈現(xiàn)中常見的空間信號(hào)干擾。

我們的實(shí)驗(yàn)中繼續(xù)增加了 mixup 中使用的混合比例,由此產(chǎn)生的幀中的目標(biāo)更有活力,也更符合自然表現(xiàn),類似于低 FPS 電影中常見的過渡幀。圖像分類和此類高比例 mixup 的視覺對(duì)比如圖 2 和圖 3 中所示。我們還使用了保留幾何形狀的對(duì)齊方式來(lái)進(jìn)行圖像混合,以避免在初始步驟中扭曲圖像。我們還選擇了視覺相干性更強(qiáng)的β分布,a >= 1 和 b >= 1,而不是按照?qǐng)D 4 所示的圖像分類中相同的做法。

我們還通過實(shí)驗(yàn)利用 YOLOv3 網(wǎng)絡(luò)在 Pascal VOC 數(shù)據(jù)集上測(cè)試了經(jīng)驗(yàn)混合比分布。表 1 顯示了采用檢測(cè)混合方法的實(shí)際改進(jìn)情況。α和β都等于 1.5 的β分布略優(yōu)于 1.0(相當(dāng)于均勻分布),也優(yōu)于固定均勻混合。

表 1:在 Pascal VOC 2007 測(cè)試集上用 YOLOv3 驗(yàn)證多種混合方法的有效性。加權(quán)損失表示總體損失是多個(gè)比例為 0 比 1 的目標(biāo)的損失之和,該比例是基于它們?cè)谠加?xùn)練圖像中所屬的圖像混合比例算出的。

4. 實(shí)驗(yàn)

為了對(duì)比所有微調(diào)方法對(duì)目標(biāo)檢測(cè)結(jié)果的改進(jìn),我們分別使用 YOLOv3 和 Faster-RCNN 作為單或多階段 pipeline 的代表。為了適應(yīng)大規(guī)模訓(xùn)練任務(wù),我們使用 Pascal VOC 對(duì)精調(diào)技巧做評(píng)估,使用 COCO 數(shù)據(jù)集對(duì)總體性能提升和泛化能力做驗(yàn)證。

圖 7:在 COCO 2017 驗(yàn)證集上利用 BoF 得到的檢測(cè)結(jié)果示例。

圖 8:YOLOv3 在 COCO 數(shù)據(jù)集 80 個(gè)類別上的 AP 分析。紅線表示使用 BoF 的性能提升,藍(lán)線表示性能下降。

圖 9:Faster-RCNN resnet 50 在 C0C0 數(shù)據(jù)集 80 個(gè)類別上的 AP 分析。紅線表示使用 BoF 的性能提升,藍(lán)線表示性能下降。

表 2:對(duì) YOLOv3 的訓(xùn)練精調(diào),在 Pascal VOC 2007 測(cè)試集 416×416 圖像上評(píng)估。

表 3:對(duì) Faster-RCNN 的訓(xùn)練精調(diào),在 Pascal VOC 2007 測(cè)試集 600 × 1000 圖像上評(píng)估。

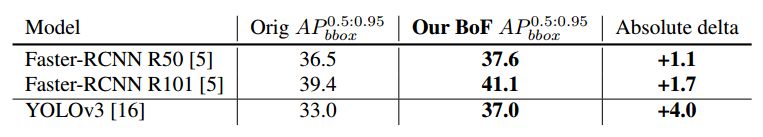

表 4:利用 bag of freebies(BoF) 方法取得的進(jìn)步,在 MS COCO 2017 驗(yàn)證集上評(píng)估。

表 5:預(yù)訓(xùn)練圖像分類和檢測(cè)網(wǎng)絡(luò)混合方法影響的組合分析。

表 6:預(yù)訓(xùn)練圖像分類和檢測(cè)網(wǎng)絡(luò)混合方法影響的組合分析。

雙一流高校研究生團(tuán)隊(duì)創(chuàng)建 ↓

專注于目標(biāo)檢測(cè)原創(chuàng)并分享相關(guān)知識(shí) ?

整理不易,點(diǎn)贊三連!