浙大宋明黎等最新《深度學(xué)習(xí)低樣本目標(biāo)檢測(cè)》綜述

極市導(dǎo)讀

?最新低樣本目標(biāo)檢測(cè)綜述?>>加入極市CV技術(shù)交流群,走在計(jì)算機(jī)視覺的最前沿

目標(biāo)檢測(cè)是計(jì)算機(jī)視覺和圖像處理中的一項(xiàng)基本任務(wù)。目前,基于深度學(xué)習(xí)的目標(biāo)檢測(cè)器已經(jīng)成功地獲得了大量的標(biāo)記數(shù)據(jù)。但在現(xiàn)實(shí)生活中,并不能保證每個(gè)對(duì)象類別都有足夠的標(biāo)記樣本進(jìn)行訓(xùn)練。這些大型目標(biāo)檢測(cè)器在訓(xùn)練數(shù)據(jù)有限的情況下容易出現(xiàn)過擬合。因此,有必要將少樣本學(xué)習(xí)和零樣本學(xué)習(xí)引入目標(biāo)檢測(cè)中,兩者可以統(tǒng)稱為低樣本目標(biāo)檢測(cè)。低樣本目標(biāo)檢測(cè)(Low-Shot Object Detection, LSOD)旨在從少量甚至零標(biāo)記數(shù)據(jù)中檢測(cè)目標(biāo),可分為少樣本目標(biāo)檢測(cè)(few-shot Object Detection, FSOD)和零樣本目標(biāo)檢測(cè)(zero-shot Object Detection, ZSD)。本文對(duì)基于FSOD和ZSD的深度學(xué)習(xí)進(jìn)行了全面的研究。首先,本綜述將FSOD和ZSD的方法分為不同的類別,并討論了它們的優(yōu)缺點(diǎn)。其次,本綜述回顧了FSOD和ZSD的數(shù)據(jù)集設(shè)置和評(píng)估指標(biāo),然后分析了不同方法在這些基準(zhǔn)上的性能。最后,本綜述討論了FSOD和ZSD未來面臨的挑戰(zhàn)和發(fā)展方向。

論文鏈接:https://arxiv.org/abs/2112.02814

引言

目標(biāo)檢測(cè)是計(jì)算機(jī)視覺中一項(xiàng)基礎(chǔ)而又具有挑戰(zhàn)性的任務(wù),它的目標(biāo)是在圖像中定位特定類別的目標(biāo)。目標(biāo)檢測(cè)已廣泛應(yīng)用于許多計(jì)算機(jī)視覺任務(wù)中,如目標(biāo)跟蹤[88]、圖像標(biāo)注[67]、場(chǎng)景圖生成[72]等。目標(biāo)檢測(cè)的一般過程是為一組包圍框(圖像中參考的假想矩形)預(yù)測(cè)類別。大多數(shù)傳統(tǒng)方法通過在整個(gè)圖像中滑動(dòng)一個(gè)窗口來生成這些邊界框。Viola-Jones (VJ)檢測(cè)器[74]首次采用積分圖像、特征選擇和檢測(cè)級(jí)聯(lián)三種加速技術(shù)實(shí)現(xiàn)了人臉的實(shí)時(shí)檢測(cè)。隨后提出了直方圖定向梯度(histogram of oriented gradient, HOG)[12],并被許多目標(biāo)檢測(cè)器用于特征描述。在這些方法中,基于變形部件的模型[16]是一種典型的方法。DPM將一個(gè)對(duì)象檢測(cè)任務(wù)劃分為多個(gè)細(xì)粒度的檢測(cè)任務(wù),然后使用多個(gè)部分過濾器檢測(cè)對(duì)象部件,并將其聚合起來進(jìn)行最終預(yù)測(cè)。雖然人們已經(jīng)做了很多改進(jìn),但傳統(tǒng)的方法受到速度慢、精度低的限制。

與傳統(tǒng)方法相比,深度方法能夠以更有效的圖像特征實(shí)現(xiàn)更強(qiáng)的性能。R-CNN[21]是基于深度學(xué)習(xí)方法的最具代表性的工作之一。它使用選擇性搜索獲得區(qū)域建議(即圖像中更可能包含目標(biāo)的區(qū)域),然后使用預(yù)訓(xùn)練好的CNN模型提取其特征,進(jìn)行進(jìn)一步的分類和定位。快速R-CNN[20]通過使用感興趣區(qū)域(RoI)池化層來從圖像的整個(gè)特征圖生成區(qū)域建議的特征圖來改進(jìn)R-CNN。Faster R-CNN[64]進(jìn)一步提出了一種區(qū)域提議網(wǎng)絡(luò)(region proposal network, RPN),取代了傳統(tǒng)的通過錨點(diǎn)(即預(yù)定義的一定高度和寬度的包圍盒)從整個(gè)圖像特征地圖生成區(qū)域提議的方法。R-CNN、Fast R-CNN和Faster R-CNN分為兩個(gè)階段模型,首先生成區(qū)域建議,然后進(jìn)行預(yù)測(cè)。為了進(jìn)一步加速,單階段模型將這兩個(gè)過程結(jié)合在一起。YOLOstyle目標(biāo)檢測(cè)器[63][3][19]是單級(jí)檢測(cè)框架的代表模型。根據(jù)從原始圖像中提取的特征圖,yolo風(fēng)格的檢測(cè)器直接在圖像的所有位置上預(yù)定義多個(gè)尺度的錨點(diǎn),并預(yù)測(cè)每個(gè)錨點(diǎn)的類別概率、位置偏移量和目標(biāo)置信度。單級(jí)檢波器的性能一般不如兩級(jí)檢波器,一些方法如焦損耗[47]被提出以減小單級(jí)和兩級(jí)檢波器之間的性能差距。最近,一種基于transformer的檢測(cè)器被提出,命名為DETR[4]。DETR直接將固定數(shù)量的目標(biāo)查詢轉(zhuǎn)發(fā)到transformer中,并對(duì)它們進(jìn)行預(yù)測(cè)。DETR實(shí)現(xiàn)端到端檢測(cè),具有與許多經(jīng)典探測(cè)器相當(dāng)?shù)男阅堋榱司徑鈾z測(cè)器收斂緩慢的問題,變形檢測(cè)器[103]提出了一個(gè)變形注意模塊,它只訪問一個(gè)參考點(diǎn)周圍的一小組關(guān)鍵采樣點(diǎn),而UP-DETR[11]提出了一個(gè)名為隨機(jī)查詢補(bǔ)丁檢測(cè)的非監(jiān)督任務(wù)來預(yù)訓(xùn)練檢測(cè)器。

然而,這些目標(biāo)檢測(cè)器依賴于大量的訓(xùn)練數(shù)據(jù)。在訓(xùn)練數(shù)據(jù)不足的情況下,現(xiàn)有的目標(biāo)檢測(cè)器容易過擬合,不能泛化到測(cè)試數(shù)據(jù)。在現(xiàn)實(shí)生活中,由于某些目標(biāo)類別的稀缺或特殊的標(biāo)簽成本,很難收集到足夠的標(biāo)簽數(shù)據(jù)。因此,現(xiàn)代目標(biāo)檢測(cè)器需要具備從少量甚至零標(biāo)記數(shù)據(jù)中檢測(cè)目標(biāo)的能力,并將少樣本和零樣本學(xué)習(xí)引入到目標(biāo)檢測(cè)中。少樣本學(xué)習(xí)的目的是從少量標(biāo)記樣本中學(xué)習(xí)泛化模型。在過去的幾年里,針對(duì)少樣本學(xué)習(xí)提出了很多方法,大致可以分為數(shù)據(jù)增強(qiáng)方法、元學(xué)習(xí)方法和遷移學(xué)習(xí)方法。數(shù)據(jù)增強(qiáng)方法通過使用傳統(tǒng)的圖像變換方法或基于深度學(xué)習(xí)的方法(如GAN)生成新樣本,直接解決了數(shù)據(jù)稀缺問題。元學(xué)習(xí)方法采用學(xué)習(xí)到學(xué)習(xí)的機(jī)制,在另一個(gè)數(shù)據(jù)豐富的數(shù)據(jù)集上定義多個(gè)少次任務(wù)來訓(xùn)練模型,使模型能夠快速適應(yīng)當(dāng)前的少次任務(wù)。與在元學(xué)習(xí)中使用多個(gè)片段進(jìn)行訓(xùn)練不同,遷移學(xué)習(xí)方法的目標(biāo)是直接學(xué)習(xí)另一個(gè)數(shù)據(jù)集上的良好圖像表示,并將它們轉(zhuǎn)移到當(dāng)前數(shù)據(jù)集。Work[73]研究了一些用于少量圖像分類的基線遷移學(xué)習(xí)方法,實(shí)驗(yàn)證明它們優(yōu)于許多經(jīng)典的元學(xué)習(xí)方法。

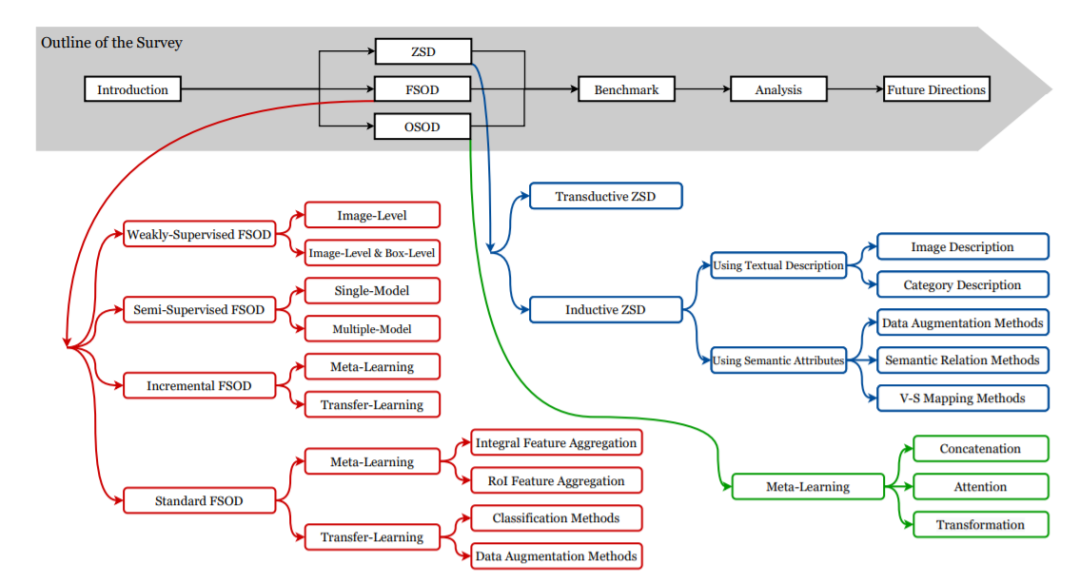

圖1. 本次綜述的概述。本文對(duì)低樣本目標(biāo)檢測(cè)進(jìn)行了全面的介紹,并將低樣本目標(biāo)檢測(cè)分為單樣本目標(biāo)檢測(cè)、少樣本目標(biāo)檢測(cè)和零樣本目標(biāo)檢測(cè)三個(gè)領(lǐng)域。圖中還用三種顏色演示了這三個(gè)域的更細(xì)粒度的分類,后面的小節(jié)將詳細(xì)討論這些分類。然后總結(jié)了OSOD、FS和ZSD的基準(zhǔn),并比較分析了不同LSOD方法在這些基準(zhǔn)上的性能。最后對(duì)LSOD的發(fā)展方向進(jìn)行了展望。

以往的少樣本學(xué)習(xí)方法主要是針對(duì)圖像分類的任務(wù)進(jìn)行探索。由于目標(biāo)檢測(cè)需要額外的任務(wù)來定位目標(biāo),因此,少樣本目標(biāo)檢測(cè)比少樣本圖像分類更具挑戰(zhàn)性。但是FSOD方法繼承了FSL方法的主要思想,F(xiàn)SL方法也可以分為兩種主流方法:元學(xué)習(xí)方法和遷移學(xué)習(xí)方法。早期的FSOD方法遵循少樣本學(xué)習(xí)的元學(xué)習(xí)方法,主要關(guān)注如何結(jié)合支持圖像和查詢圖像的特性。這些元學(xué)習(xí)方法可以分為特征向量聚合方法和特征地圖聚合方法。將遷移學(xué)習(xí)方法引入到少樣本目標(biāo)檢測(cè)中,在另一個(gè)數(shù)據(jù)集中對(duì)檢測(cè)器進(jìn)行預(yù)訓(xùn)練,然后在當(dāng)前的少樣本數(shù)據(jù)集中對(duì)檢測(cè)器進(jìn)行微調(diào)。在遷移學(xué)習(xí)方法中引入了對(duì)比學(xué)習(xí)、度量學(xué)習(xí)、正則化等方法。除了原有的標(biāo)準(zhǔn)FSOD設(shè)置外,研究者還探索了半監(jiān)督FSOD、弱監(jiān)督FSOD和增量FSOD等其他設(shè)置。還有一個(gè)更有挑戰(zhàn)性的設(shè)置,即每個(gè)少數(shù)樣本類都有零標(biāo)記樣本,這被稱為零樣本學(xué)習(xí)(ZSD)。在零概率學(xué)習(xí)中,每個(gè)類都有其語義屬性作為補(bǔ)償。實(shí)際上,F(xiàn)SOD和ZSD可以考慮在一個(gè)條件下,一些方法[60][33]提出了一個(gè)組合模型,同時(shí)處理FSOD和ZSD。因此,本次綜述將FSOD和ZSD表示為低樣本目標(biāo)檢測(cè)(LSD)。低樣本目標(biāo)檢測(cè)的層次結(jié)構(gòu)分類法如圖1所示。

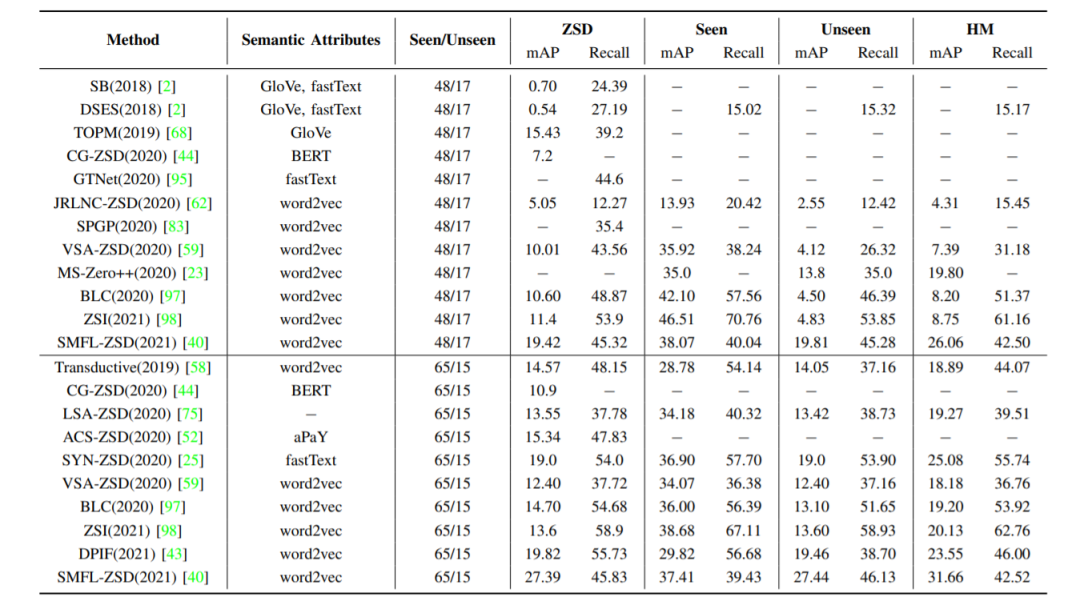

本文對(duì)現(xiàn)有的少樣本和零樣本目標(biāo)檢測(cè)算法進(jìn)行了全面的回顧和分析。本文總結(jié)了現(xiàn)有的少樣本和零樣本目標(biāo)檢測(cè)算法的性能。本文討論了少樣本和零樣本目標(biāo)檢測(cè)的主要挑戰(zhàn)和未來的發(fā)展方向。本文綜述的其余部分組織如下。第二節(jié)描述了對(duì)少樣本和零樣本目標(biāo)檢測(cè)算法進(jìn)行更細(xì)粒度的分類和分析。第八節(jié)描述了常用的少樣本和零樣本目標(biāo)檢測(cè)數(shù)據(jù)集和評(píng)價(jià)標(biāo)準(zhǔn)。第九節(jié)總結(jié)了現(xiàn)有的少樣本和零樣本目標(biāo)檢測(cè)算法的性能。最后,第十一節(jié)總結(jié)了本次綜述的內(nèi)容,然后討論了當(dāng)前方法面臨的主要挑戰(zhàn)和未來的發(fā)展方向的少樣本和零樣本目標(biāo)檢測(cè)。

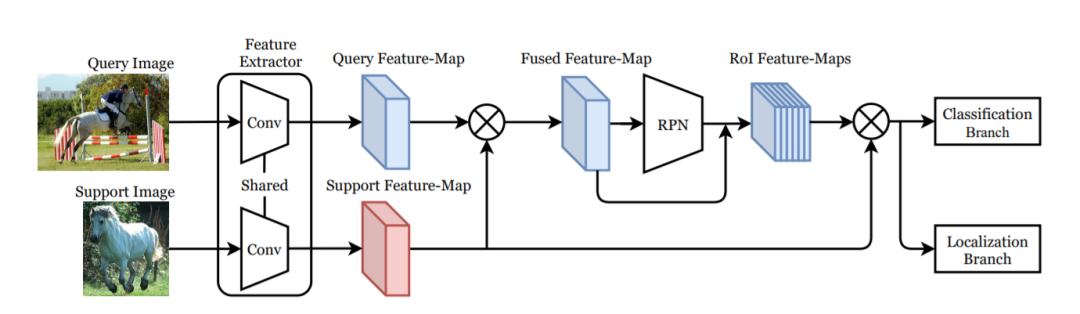

整體框架的單樣本目標(biāo)檢測(cè)方法,其中基于Faster R-CNN框架。該模型以查詢圖像和支持圖像為輸入,使用連體卷積特征提取器提取查詢特征圖和支持特征圖。然后利用整體特征聚合將兩個(gè)特征圖聚合成一個(gè)融合的特征圖,并將其轉(zhuǎn)發(fā)到RPN和RoI層,分別生成區(qū)域建議和RoI特征。在不同的OSOD方法中,聚合方式的實(shí)現(xiàn)是不同的。最后將RoI特征用于分類任務(wù)和定位任務(wù)。一些方法還應(yīng)用RoI特征聚合來聚合RoI特征和支持特征。

本文對(duì)低樣本目標(biāo)檢測(cè)進(jìn)行了深入的研究,根據(jù)每個(gè)新類是否使用少量標(biāo)記樣本或語義屬性,將低樣本目標(biāo)檢測(cè)分為少樣本目標(biāo)檢測(cè)(FSOD)和零樣本目標(biāo)檢測(cè)(ZSD)。首先對(duì)低目標(biāo)檢測(cè)方法進(jìn)行了概括介紹,然后對(duì)FSOD和ZSD方法進(jìn)行了分類和分析。總結(jié)了FSOD和ZSD的主要基準(zhǔn),并對(duì)不同方法的性能進(jìn)行了比較。最后討論了FSOD和ZSD的發(fā)展方向。

如果覺得有用,就請(qǐng)分享到朋友圈吧!

公眾號(hào)后臺(tái)回復(fù)“浙大綜述”獲取最新《深度學(xué)習(xí)低樣本目標(biāo)檢測(cè)綜述》下載~

#?CV技術(shù)社群邀請(qǐng)函?#

備注:姓名-學(xué)校/公司-研究方向-城市(如:小極-北大-目標(biāo)檢測(cè)-深圳)

即可申請(qǐng)加入極市目標(biāo)檢測(cè)/圖像分割/工業(yè)檢測(cè)/人臉/醫(yī)學(xué)影像/3D/SLAM/自動(dòng)駕駛/超分辨率/姿態(tài)估計(jì)/ReID/GAN/圖像增強(qiáng)/OCR/視頻理解等技術(shù)交流群

每月大咖直播分享、真實(shí)項(xiàng)目需求對(duì)接、求職內(nèi)推、算法競(jìng)賽、干貨資訊匯總、與?10000+來自港科大、北大、清華、中科院、CMU、騰訊、百度等名校名企視覺開發(fā)者互動(dòng)交流~