【機(jī)器學(xué)習(xí)】推薦一個開源機(jī)器學(xué)習(xí)可解釋倉庫-AutoX-Interpreter

機(jī)器學(xué)習(xí)在金融、零售、工業(yè)預(yù)測性維護(hù)等眾多場景已得到較為普遍的應(yīng)用。然而,在具體業(yè)務(wù)場景中,機(jī)器學(xué)習(xí)仍然常被視為一個“黑盒”,如果不對模型進(jìn)行合理的解釋,業(yè)務(wù)人員就無法完全信任和理解模型的決策,使得模型的使用受到限制。

可解釋機(jī)器學(xué)習(xí)的目的就在于讓用戶理解并信任我們的模型。在建模階段,可解釋能力可以輔助開發(fā)人員理解模型,進(jìn)行模型的對比選擇、優(yōu)化和調(diào)整。在模型上線運(yùn)行后,可解釋能力可以用于向業(yè)務(wù)人員解釋模型的內(nèi)部機(jī)制,對模型的預(yù)測結(jié)果進(jìn)行解釋。

第四范式開源了一個自動機(jī)器學(xué)習(xí)的代碼庫AutoX,其中AutoX-Interpreter內(nèi)置了豐富的機(jī)器學(xué)習(xí)可解釋算法以及對應(yīng)的使用案例。

主要功能包括:

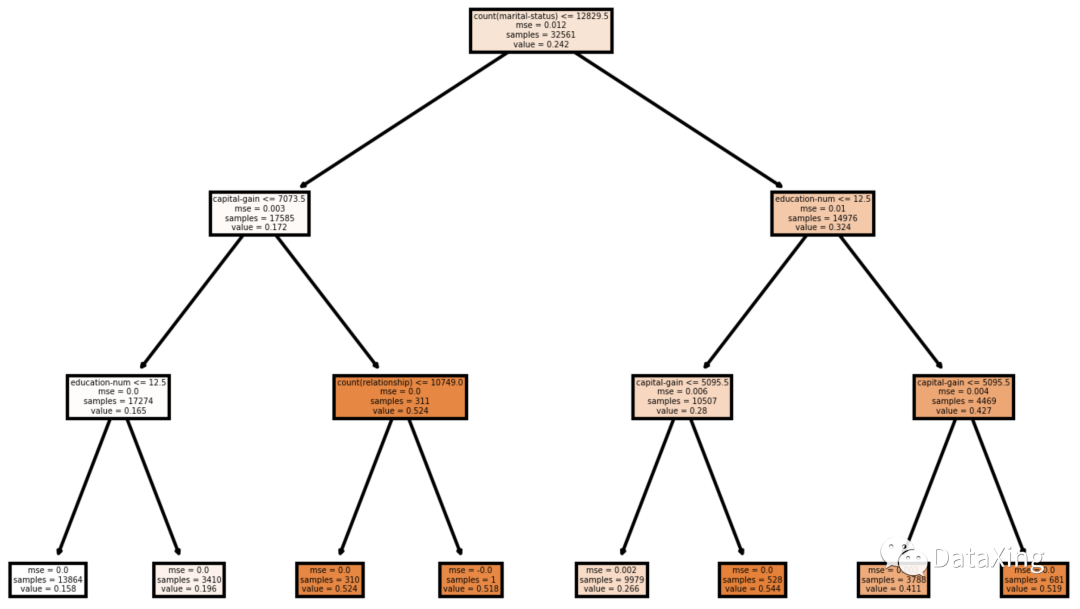

全局代理模型

用一個相對容易解釋的模型擬合原模型,用擬合出來的模型來解釋原模型的全貌。

- 樹模型

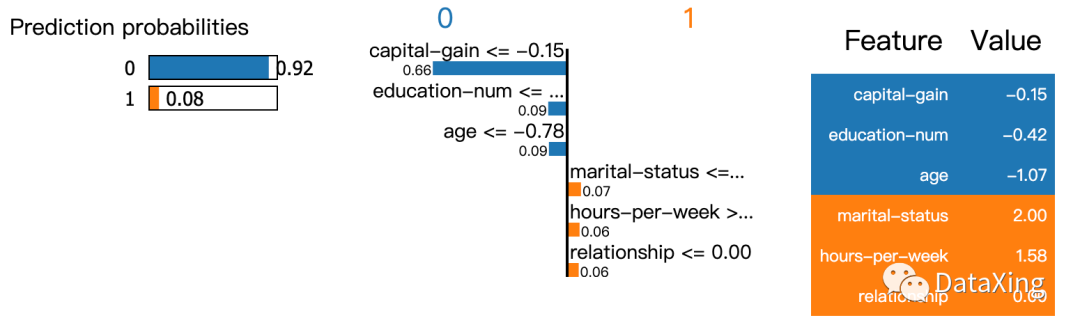

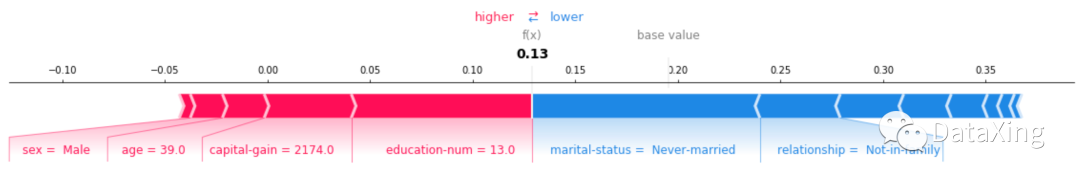

局部代理模型

解釋在局部樣本點(diǎn)上,模型是基于哪些特征做出的預(yù)測結(jié)果。

LIME,Local interpretable model-agnostic explanations,一種與模型無關(guān)的可解釋方法。

SHAP,Shapley Additive Explanation,核心是計算其中每個特征變量對模型預(yù)測值的邊際貢獻(xiàn)。

影響力樣本

找出在模型訓(xùn)練過程中對訓(xùn)練結(jié)果有影響力的樣本。核心在于如果刪除某些樣本進(jìn)行訓(xùn)練,模型參數(shù)或預(yù)測結(jié)果變化較大。

- nn

基于ICML'17,Understanding black-box predictions via influence functions的方法。

-?nn_sgd

基于NeurIPS'19,Data Cleansing for Models Trained with SGD的方法。

代表性樣本和非代表性樣本

- MMD-critic

找到全體樣本中有代表性的樣本。

-?ProtoDash algorithm

給定局部樣本點(diǎn)和模型,在預(yù)測結(jié)果一致(或相近)的樣本中,找到模型決策因素一致(或相近)的樣本點(diǎn)。

項(xiàng)目地址

https://github.com/4paradigm/AutoX/tree/master/autox/interpreter