即插即用模塊 | CompConv卷積讓模型不丟精度還可以提速(附論文下載)

為了降低CNN的計(jì)算成本,本文提出了一種新的卷積設(shè)計(jì):CompConv。它利用分治法策略來簡化特征圖的轉(zhuǎn)換。即插即用!可直接替換普通卷積,幾乎不犧牲性能,極致壓縮CNN結(jié)構(gòu)!

作者單位:浙江大學(xué), 香港中文大學(xué)

1簡介

卷積神經(jīng)網(wǎng)絡(luò)(CNN)在各種計(jì)算機(jī)視覺任務(wù)中取得了顯著的成功,但其也依賴于巨大的計(jì)算成本。為了解決這個(gè)問題,現(xiàn)有的方法要么壓縮訓(xùn)練大規(guī)模模型,要么學(xué)習(xí)具有精心設(shè)計(jì)的網(wǎng)絡(luò)結(jié)構(gòu)的輕量級模型。在這項(xiàng)工作中,作者仔細(xì)研究了卷積算子以減少其計(jì)算負(fù)載。特別是,本文提出了一個(gè)緊湊的卷積模塊,稱為CompConv,以促進(jìn)高效的特征學(xué)習(xí)。通過分治法的策略,CompConv能夠節(jié)省大量的計(jì)算和參數(shù)來生成特定維度的特征圖。

此外,CompConv將輸入特征集成到輸出中以有效地繼承輸入信息。更重要的是CompConv是一個(gè)即插即用模塊,可以直接應(yīng)用于CNN結(jié)構(gòu),無需進(jìn)一步設(shè)計(jì)即可替換普通卷積層。大量的實(shí)驗(yàn)結(jié)果表明,CompConv可以充分壓縮baseline CNN結(jié)構(gòu),同時(shí)幾乎不犧牲性能。

本文主要貢獻(xiàn)

-

提出了一種緊湊的卷積模塊CompConv,它利用了分治法策略和精心設(shè)計(jì)的相同映射大大降低了CNN的計(jì)算代價(jià)。 -

通過研究遞歸計(jì)算對學(xué)習(xí)能力的影響,對所提出的CompConv進(jìn)行了詳盡的分析。進(jìn)一步提出了一個(gè)切實(shí)可行的壓縮率控制方案。 -

作為傳統(tǒng)卷積層的方便替代作者將CompConv應(yīng)用于各種benchmark。結(jié)果表明,CompConv可以大幅節(jié)省計(jì)算負(fù)載,但幾乎不犧牲模型在分類和檢測任務(wù)上的性能的情況下,CompConv方法優(yōu)于現(xiàn)有的方法。

2本文方法

2.1 動(dòng)機(jī)何在?

卷積可以被視為一種將特征從一個(gè)空間映射到另一個(gè)空間的操作。在某種程度上,這個(gè)過程類似于離散傅里葉變換(DFT),將信號(hào)序列從時(shí)域映射到頻域。快速傅里葉變換(FFT)被廣泛用于提高DFT的計(jì)算速度。所以本文通過分治策略來壓縮普通的卷積模塊:CompConv。

回顧一下FFT的公式。在時(shí)域?qū)?span style="cursor:pointer;"> 個(gè)信號(hào)序列 進(jìn)行DFT時(shí),F(xiàn)FT提出將其分割成2個(gè) 個(gè)子序列,分別記為 和 ,并對每個(gè)子序列進(jìn)行DFT。這里 和 分別代表“偶”和“奇”。據(jù)此,由中間變換結(jié)果 和 得到頻域的最終結(jié)果 :

其中 是一個(gè)乘數(shù)。在此基礎(chǔ)上,可將分解后的結(jié)果 和 進(jìn)一步劃分為更小的分組,形成遞歸計(jì)算的方式。

2.2 CompConv核心單元

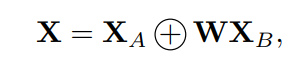

在FFT的啟發(fā)下,作者將分治策略引入到卷積模塊中以提高其計(jì)算效率。通過類比,將由CNN生成的中間特征映射視為通道軸的序列。更具體地說,要開發(fā)帶有C通道的特性映射 ,可以選擇開發(fā)2個(gè)特性映射 和 ,每個(gè)特性映射都使用 個(gè)通道,然后將它們組合在一起:

其中+表示沿通道軸的拼接操作,W是用于變換特征映射的可學(xué)習(xí)參數(shù)。

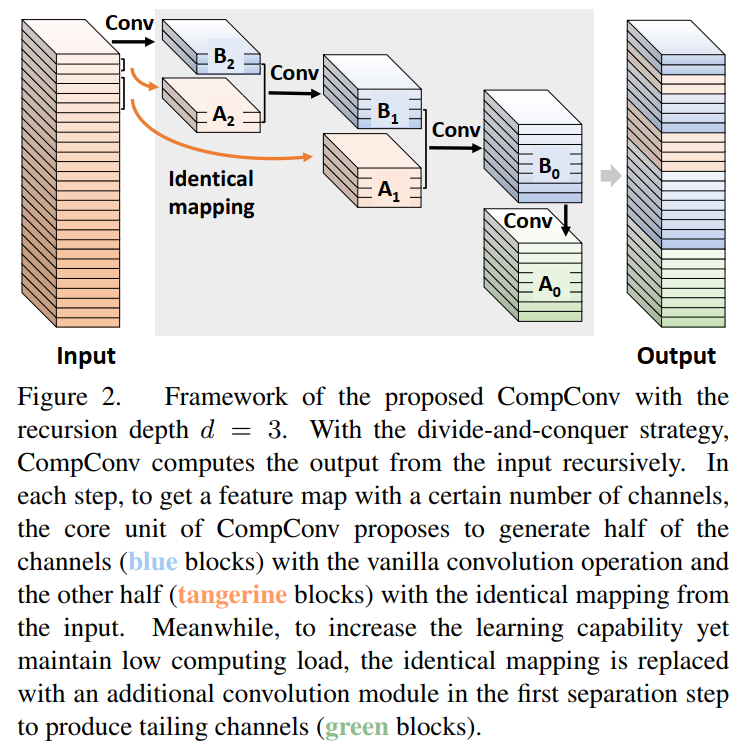

上式體現(xiàn)了CompConv的核心思想。具體來說,CompConv的核心單元由2部分實(shí)現(xiàn),如圖2所示。其中一個(gè)部分(即 )從輸入通道的子集完全映射過來,它能夠輕松地從輸入中繼承信息。另一部分(即 )通過卷積模塊從輸入特征轉(zhuǎn)化而來。

2.3 遞歸計(jì)算

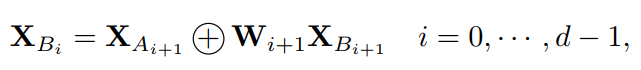

根據(jù)式(2)中的公式,將 進(jìn)一步分解為2部分,可遞歸計(jì)算出CompConv:

其中d為遞歸深度。

Tailing Channels

將第1個(gè)分離步驟 與其他步驟區(qū)別對待,如圖2所示。具體來說, 不是直接從輸入中來的,而是從 轉(zhuǎn)化而來的。

這樣做主要有2個(gè)原因:

-

一方面,在所有相同的部件 中, 的通道最多。如果直接將一些輸入通道復(fù)制為 ,那么輸入特征映射和輸出特征映射之間會(huì)有過多的冗余,嚴(yán)重限制了該模塊的學(xué)習(xí)能力。

-

另一方面,除了從 轉(zhuǎn)換之外,還有一些其他方法可以獲得 ,例如從整個(gè)輸入特征映射或構(gòu)建另一個(gè)遞歸。其中,從 開發(fā) 是計(jì)算成本最低的一種方法。同時(shí), 的推導(dǎo)已經(jīng)從輸入特征中收集了足夠的信息,因此學(xué)習(xí)能力也可以保證。

整合遞歸結(jié)果

為了更好地利用遞歸過程中的計(jì)算,最終的輸出不僅通過分組兩個(gè)最大的子特征得到 ,并綜合了所有中間結(jié)果,如圖2所示。這樣就可以充分利用所有的計(jì)算操作來產(chǎn)生最終的輸出。此外,在這些特征映射的連接之后會(huì)添加一個(gè)shuffle block。

2.4 Adaptive Separation策略

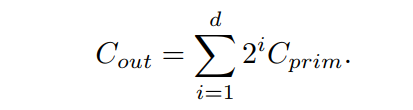

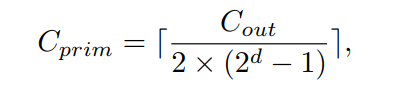

CompConv采用分治策略進(jìn)行高效的特征學(xué)習(xí)。因此,如何對通道進(jìn)行遞歸分割是影響通道計(jì)算效率和學(xué)習(xí)能力的關(guān)鍵。這里分別用 和 表示輸入通道數(shù)和輸出通道數(shù)。 為圖2中d=3時(shí)最小計(jì)算單元的通道數(shù),如 。考慮到遞歸計(jì)算過程中通道數(shù)的指數(shù)增長,可以預(yù)期:

可以很容易得到以下結(jié)果:

其中[]表示使 為整數(shù)的上限函數(shù)。如果所有單元的通道之和大于 ,就簡單地放入最后一些通道 以確保輸出特征具有適當(dāng)?shù)某叽纭?/p>

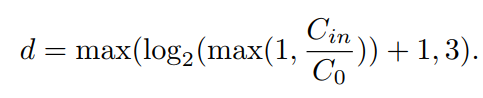

遞歸計(jì)算深度的選擇

由式(5)可知 高度依賴于遞歸深度d,這是CompConv模塊中的一個(gè)超參數(shù)。較大的d對應(yīng)較高的壓縮率,其中d=0表示沒有壓縮。針對現(xiàn)代神經(jīng)網(wǎng)絡(luò)不同的結(jié)構(gòu)和不同的模型尺度,作者提出了一種自適應(yīng)的深度選擇策略:

在這里, 是一個(gè)特定于模型的設(shè)計(jì)選擇,由目標(biāo)壓縮率和模型大小決定([32;64;128;256;512;···])。從直覺上看, 越大,d越小,壓縮越輕。從這個(gè)角度來看, 可以用來控制計(jì)算效率和學(xué)習(xí)能力之間的權(quán)衡。

值得注意的是,遞歸深度d與Eq.(6)中輸入通道的數(shù)量 有關(guān),這意味著自適應(yīng)策略會(huì)在不同層動(dòng)態(tài)調(diào)整計(jì)算深度。同時(shí),為了保證最小單元有足夠的學(xué)習(xí)能力,要給它分配了足夠的通道。換句話說, 不能太小。從Eq.(5)可以看出,當(dāng)d=3時(shí), 只占輸出通道的約8%。因此,作者將深度d限定為最大值3。

推薦配置

對于最受歡迎的CNN網(wǎng)絡(luò),如VGG和ResNet,建議設(shè)置 =128。作者將此配置表示為CompConv128。

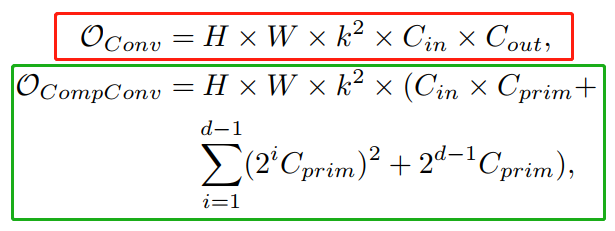

2.5 復(fù)雜度分析

假設(shè)輸入和輸出特征圖的分辨率都是H×W,那么普通卷積和CompConv的計(jì)算復(fù)雜度分別是:

其中k為卷積核的大小。

在 和d=3的配置下,與傳統(tǒng)卷積相比,CompConv只需要約20%的計(jì)算資源就可以開發(fā)具有相同通道數(shù)的輸出特征。

3實(shí)驗(yàn)

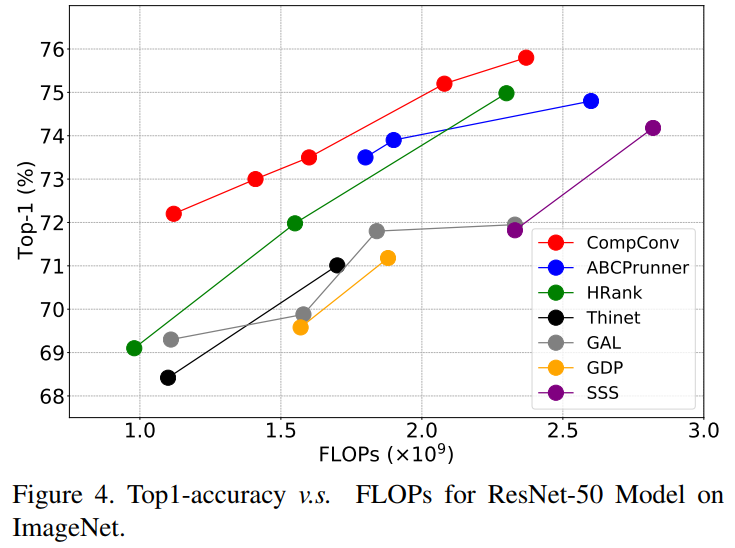

3.1 ImageNet分類

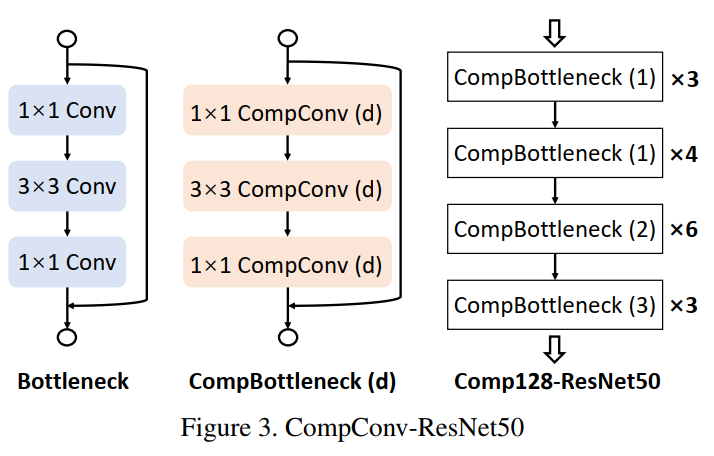

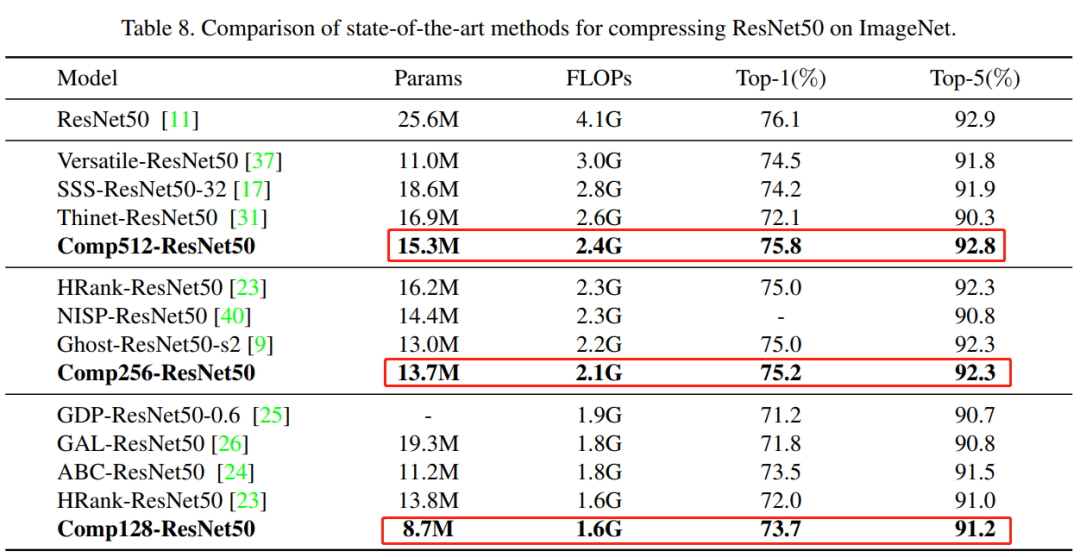

模型結(jié)構(gòu)為使用CompConv替換普通CNN的ResNet50模型,實(shí)驗(yàn)結(jié)果如下:

可以看出,性價(jià)比很高的!!!

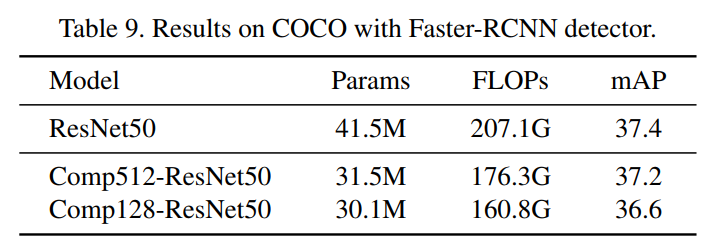

3.2 COCO目標(biāo)檢測

4參考

[1].CompConv: A Compact Convolution Module for Efficient Feature Learning

5推薦閱讀

詳細(xì)解讀Google新作 | 教你How to train自己的Transfomer模型?

CVPR2021 GAN詳細(xì)解讀 | AdaConv自適應(yīng)卷積讓你的GAN比AdaIN更看重細(xì)節(jié)(附論文下載)

全新激活函數(shù) | 詳細(xì)解讀:HP-x激活函數(shù)(附論文下載)

本文論文原文獲取方式,掃描下方二維碼

回復(fù)【CompConv】即可獲取論文

長按掃描下方二維碼添加小助手。

可以一起討論遇到的問題

聲明:轉(zhuǎn)載請說明出處

掃描下方二維碼關(guān)注【集智書童】公眾號(hào),獲取更多實(shí)踐項(xiàng)目源碼和論文解讀,非常期待你我的相遇,讓我們以夢為馬,砥礪前行!