干貨 | 循環(huán)神經(jīng)網(wǎng)絡(luò)LSTM的數(shù)學(xué)過程

擊上方“小白學(xué)視覺”,選擇加"星標(biāo)"或“置頂”

重磅干貨,第一時間送達(dá)

本文轉(zhuǎn)自 | OpenCV學(xué)堂

引言

長短時記憶(long short term memory,LSTM)是一種有效的鏈?zhǔn)窖h(huán)神經(jīng)網(wǎng)絡(luò)(recurrent neural network,R2 NN1),被廣泛用于語言模型、機(jī)器翻譯、語音識別等領(lǐng)域。[1]本文具體就LSTM的具體實(shí)現(xiàn)做出推導(dǎo)。

LSTM模型描述

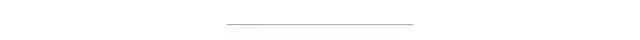

因?yàn)閭鹘y(tǒng)的RNN在間隔不斷增大的同時,會喪失學(xué)習(xí)到連接如此遠(yuǎn)的信息的能力。這個問題簡稱長期依賴問題,為了解決這個問題,LSTM通過刻意的設(shè)計來避免長期依賴問題。以下就是LSTM的結(jié)構(gòu)圖:

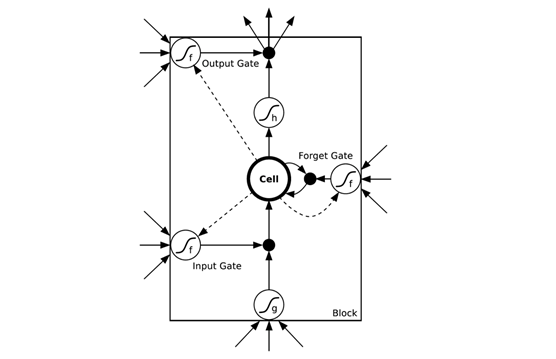

展開以后變成:

它與RNN的簡單模型不一樣的地方在于:

它是由記憶細(xì)胞、遺忘門、輸入門、輸出門組成。記憶細(xì)胞負(fù)責(zé)存儲歷史信息, 通過一個狀態(tài)參數(shù)來記錄和更新歷史信息;三個門結(jié)構(gòu)則通過Sigmoid函數(shù)決定信息的取舍, 從而作用于記憶細(xì)胞。[2]

遺忘門用來選擇性忘記多余或次要的記憶

輸入門決定我們需要更新什么值

輸出門決定細(xì)胞狀態(tài)的哪個部分輸出出去

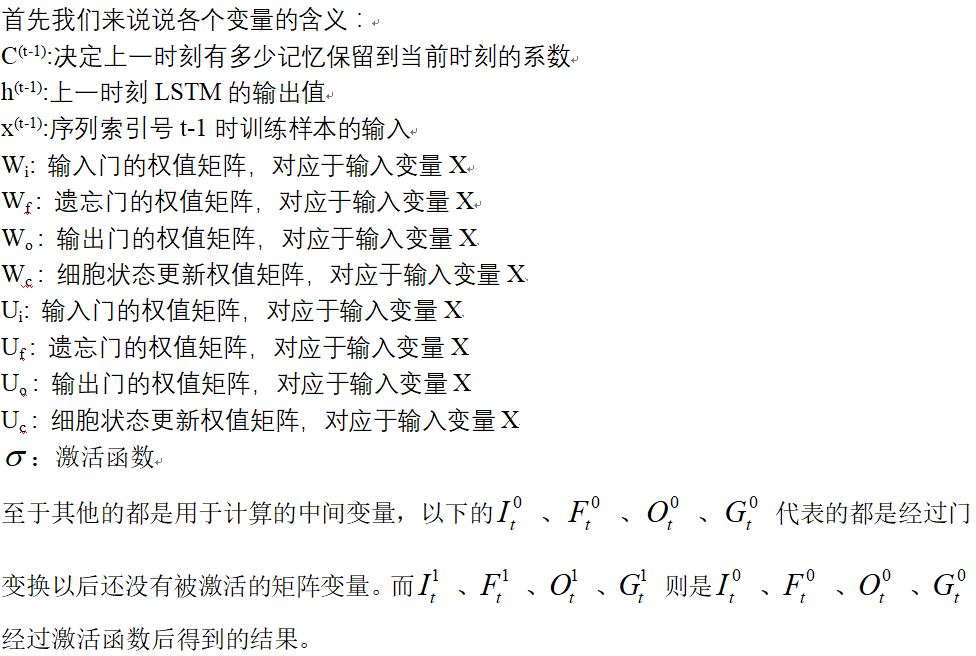

模型抽象和數(shù)學(xué)符號的說明

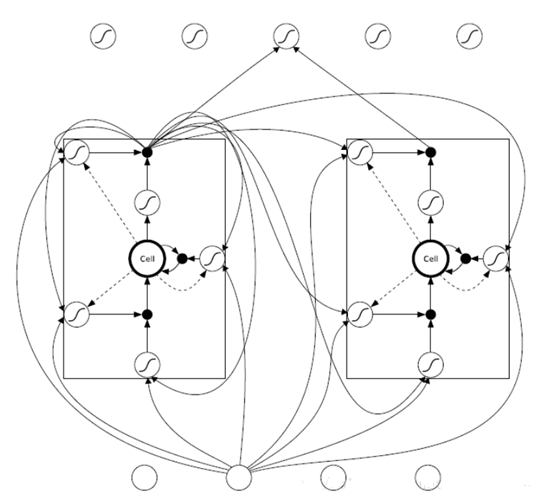

為了方便數(shù)學(xué)原理的推導(dǎo),這里我們用下面的簡略圖代替:

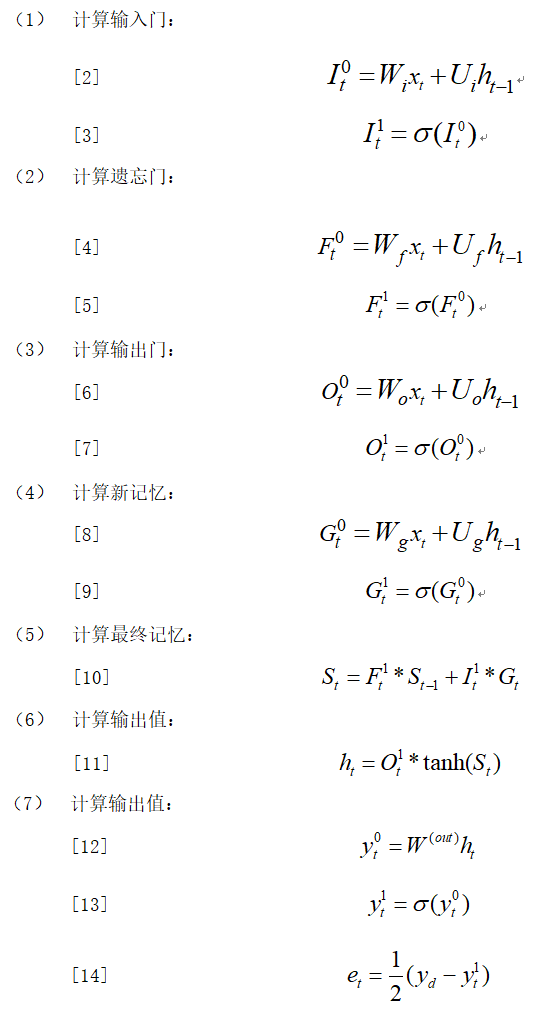

前向傳播算法

前向傳播總體上就是對三個門進(jìn)行計算,然后通過這三個門決定當(dāng)前細(xì)胞的隱藏狀態(tài),更新當(dāng)前記憶和過去的記憶,最終再計算出輸出值傳入下一次前向網(wǎng)絡(luò)中:因?yàn)槿齻€門的情況不僅取決于輸入向量Xt,還取決于ht-1

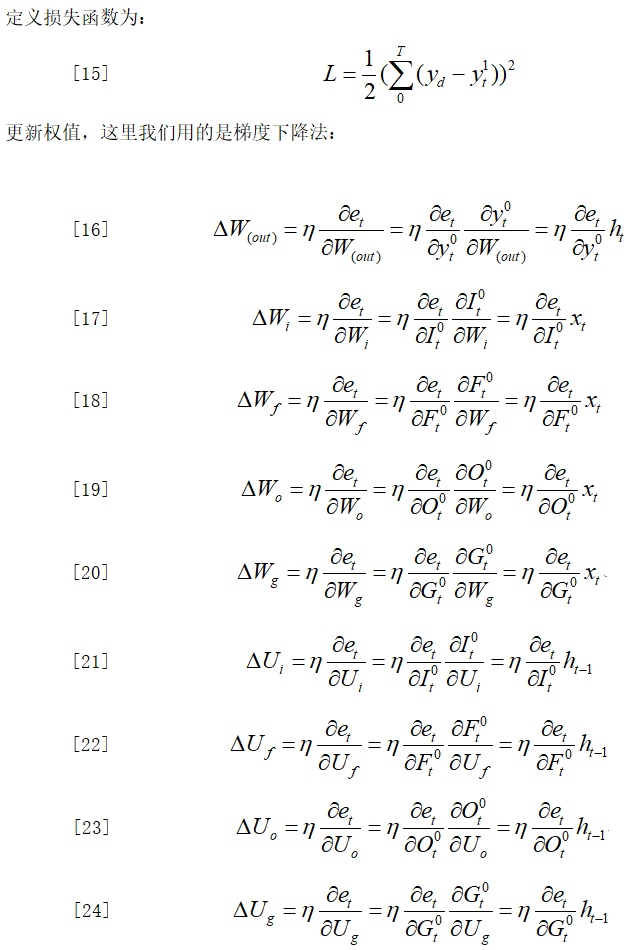

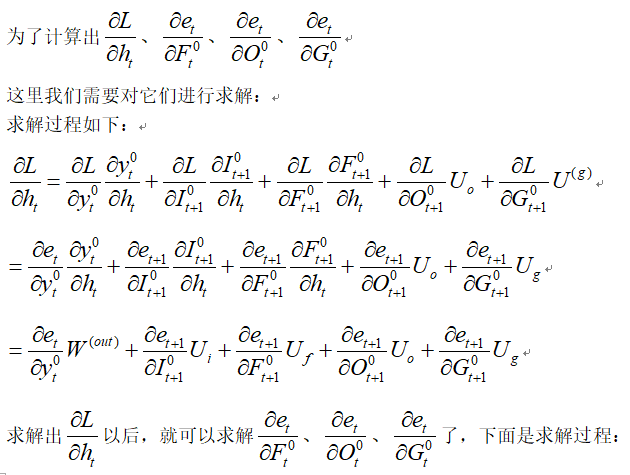

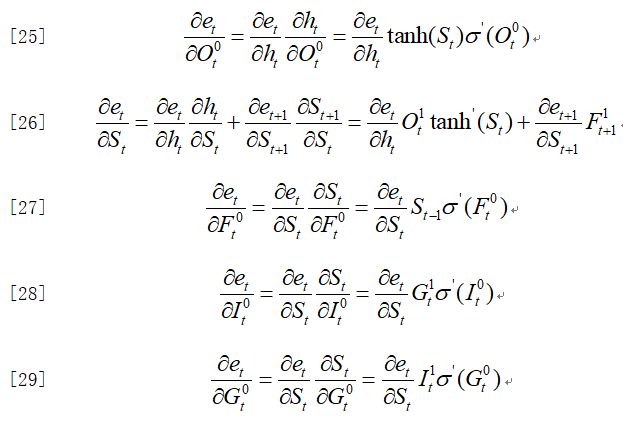

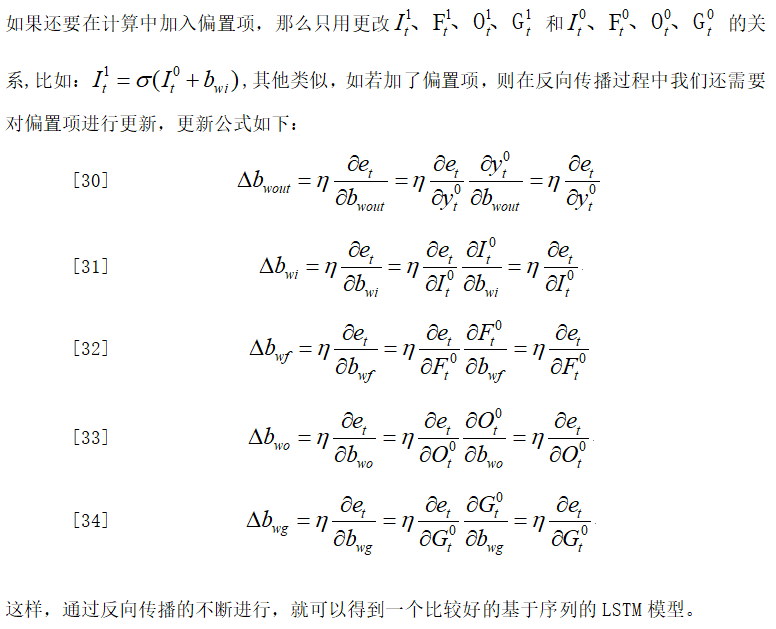

反向傳播算法

交流群

歡迎加入公眾號讀者群一起和同行交流,目前有SLAM、三維視覺、傳感器、自動駕駛、計算攝影、檢測、分割、識別、醫(yī)學(xué)影像、GAN、算法競賽等微信群(以后會逐漸細(xì)分),請掃描下面微信號加群,備注:”昵稱+學(xué)校/公司+研究方向“,例如:”張三 + 上海交大 + 視覺SLAM“。請按照格式備注,否則不予通過。添加成功后會根據(jù)研究方向邀請進(jìn)入相關(guān)微信群。請勿在群內(nèi)發(fā)送廣告,否則會請出群,謝謝理解~